正在加载图片...

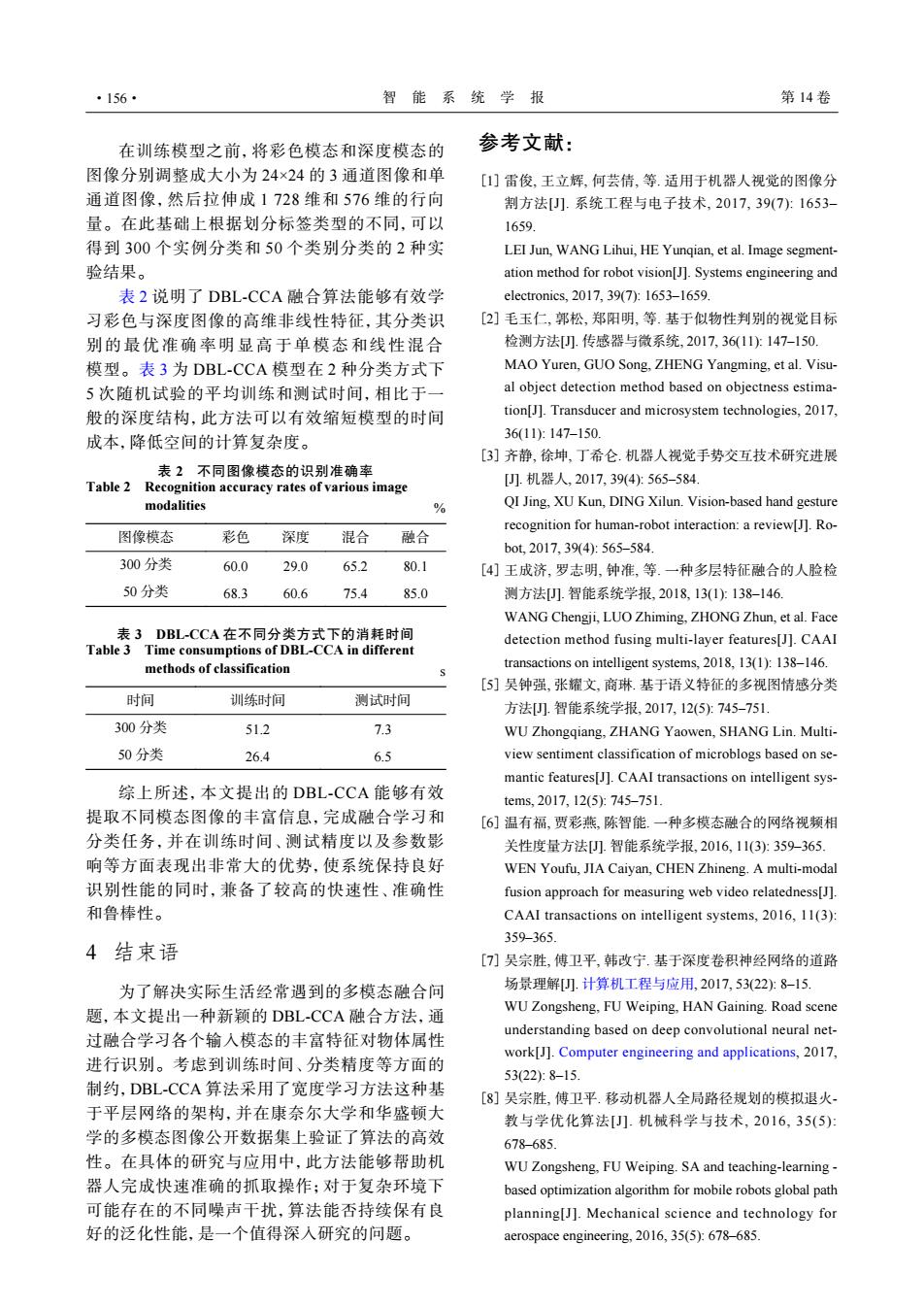

·156· 智能系统学 报 第14卷 在训练模型之前,将彩色模态和深度模态的 参考文献: 图像分别调整成大小为24×24的3通道图像和单 [1]雷俊,王立辉,何芸倩,等.适用于机器人视觉的图像分 通道图像,然后拉伸成1728维和576维的行向 割方法[.系统工程与电子技术,2017,39(7):1653- 量。在此基础上根据划分标签类型的不同,可以 1659 得到300个实例分类和50个类别分类的2种实 LEI Jun,WANG Lihui,HE Yungian,et al.Image segment- 验结果。 ation method for robot vision[J].Systems engineering and 表2说明了DBL-CCA融合算法能够有效学 electronics,2017,39(7):1653-1659. 习彩色与深度图像的高维非线性特征,其分类识 [2]毛玉仁,郭松,郑阳明,等.基于似物性判别的视觉目标 别的最优准确率明显高于单模态和线性混合 检测方法U.传感器与微系统,2017,36(11)147-150. 模型。表3为DBL-CCA模型在2种分类方式下 MAO Yuren,GUO Song,ZHENG Yangming,et al.Visu- 5次随机试验的平均训练和测试时间,相比于一 al object detection method based on objectness estima- 般的深度结构,此方法可以有效缩短模型的时间 tion[J].Transducer and microsystem technologies,2017, 成本,降低空间的计算复杂度。 36(11:147-150. [3]齐静,徐坤,丁希仑.机器人视觉手势交互技术研究进展 表2不同图像模态的识别准确率 Table 2 Recognition accuracy rates of various image [.机器人,2017,394):565-584 modalities % QI Jing,XU Kun,DING Xilun.Vision-based hand gesture recognition for human-robot interaction:a review[J].Ro- 图像模态 彩色 深度 混合 融合 bot,2017,394):565-584. 300分类 60.0 29.0 65.2 80.1 [4]王成济,罗志明,钟准,等.一种多层特征融合的人脸检 50分类 68.3 60.6 75.4 85.0 测方法☐.智能系统学报,2018,13(1)138-146 WANG Chengji,LUO Zhiming,ZHONG Zhun,et al.Face 表3DBL-CCA在不同分类方式下的消耗时间 detection method fusing multi-layer features[J].CAAI Table 3 Time consumptions of DBL-CCA in different methods of classification transactions on intelligent systems,2018,13(1):138-146. [5]吴钟强,张耀文,商琳基于语义特征的多视图情感分类 时间 训练时间 测试时间 方法.智能系统学报,2017,12(5:745-751. 300分类 51.2 7.3 WU Zhongqiang,ZHANG Yaowen,SHANG Lin.Multi- 50分类 26.4 6.5 view sentiment classification of microblogs based on se- mantic features[J].CAAI transactions on intelligent sys- 综上所述,本文提出的DBL-CCA能够有效 tems.2017,12(5:745-751. 提取不同模态图像的丰富信息,完成融合学习和 [6]温有福,贾彩燕,陈智能.一种多模态融合的网络视频相 分类任务,并在训练时间、测试精度以及参数影 关性度量方法).智能系统学报,2016,11(3):359-365. 响等方面表现出非常大的优势,使系统保持良好 WEN Youfu,JIA Caiyan,CHEN Zhineng.A multi-modal 识别性能的同时,兼备了较高的快速性、准确性 fusion approach for measuring web video relatedness[J]. 和鲁棒性。 CAAlI transactions on intelligent systems,2016,11(3): 359-365. 4结束语 [7]吴宗胜,傅卫平,韩改宁.基于深度卷积神经网络的道路 为了解决实际生活经常遇到的多模态融合问 场景理解).计算机工程与应用,2017,53(22:8-15. 题,本文提出一种新颖的DBL-CCA融合方法,通 WU Zongsheng,FU Weiping,HAN Gaining.Road scene 过融合学习各个输入模态的丰富特征对物体属性 understanding based on deep convolutional neural net- work[J].Computer engineering and applications,2017, 进行识别。考虑到训练时间、分类精度等方面的 53(22):8-15. 制约,DBL-CCA算法采用了宽度学习方法这种基 [8]吴宗胜,傅卫平.移动机器人全局路径规划的模拟退火 于平层网络的架构,并在康奈尔大学和华盛顿大 教与学优化算法[).机械科学与技术,2016,35(5) 学的多模态图像公开数据集上验证了算法的高效 678-685 性。在具体的研究与应用中,此方法能够帮助机 WU Zongsheng.FU Weiping.SA and teaching-learning- 器人完成快速准确的抓取操作:对于复杂环境下 based optimization algorithm for mobile robots global path 可能存在的不同噪声干扰,算法能否持续保有良 planning[J].Mechanical science and technology for 好的泛化性能,是一个值得深人研究的问题。 aerospace engineering,2016,35(5):678-685.在训练模型之前,将彩色模态和深度模态的 图像分别调整成大小为 24×24 的 3 通道图像和单 通道图像,然后拉伸成 1 728 维和 576 维的行向 量。在此基础上根据划分标签类型的不同,可以 得到 300 个实例分类和 50 个类别分类的 2 种实 验结果。 表 2 说明了 DBL-CCA 融合算法能够有效学 习彩色与深度图像的高维非线性特征,其分类识 别的最优准确率明显高于单模态和线性混合 模型。表 3 为 DBL-CCA 模型在 2 种分类方式下 5 次随机试验的平均训练和测试时间,相比于一 般的深度结构,此方法可以有效缩短模型的时间 成本,降低空间的计算复杂度。 表 2 不同图像模态的识别准确率 Table 2 Recognition accuracy rates of various image modalities % 图像模态 彩色 深度 混合 融合 300 分类 60.0 29.0 65.2 80.1 50 分类 68.3 60.6 75.4 85.0 表 3 DBL-CCA 在不同分类方式下的消耗时间 Table 3 Time consumptions of DBL-CCA in different methods of classification s 时间 训练时间 测试时间 300 分类 51.2 7.3 50 分类 26.4 6.5 综上所述,本文提出的 DBL-CCA 能够有效 提取不同模态图像的丰富信息,完成融合学习和 分类任务,并在训练时间、测试精度以及参数影 响等方面表现出非常大的优势,使系统保持良好 识别性能的同时,兼备了较高的快速性、准确性 和鲁棒性。 4 结束语 为了解决实际生活经常遇到的多模态融合问 题,本文提出一种新颖的 DBL-CCA 融合方法,通 过融合学习各个输入模态的丰富特征对物体属性 进行识别。考虑到训练时间、分类精度等方面的 制约,DBL-CCA 算法采用了宽度学习方法这种基 于平层网络的架构,并在康奈尔大学和华盛顿大 学的多模态图像公开数据集上验证了算法的高效 性。在具体的研究与应用中,此方法能够帮助机 器人完成快速准确的抓取操作;对于复杂环境下 可能存在的不同噪声干扰,算法能否持续保有良 好的泛化性能,是一个值得深入研究的问题。 参考文献: 雷俊, 王立辉, 何芸倩, 等. 适用于机器人视觉的图像分 割方法[J]. 系统工程与电子技术, 2017, 39(7): 1653– 1659. LEI Jun, WANG Lihui, HE Yunqian, et al. Image segmentation method for robot vision[J]. Systems engineering and electronics, 2017, 39(7): 1653–1659. [1] 毛玉仁, 郭松, 郑阳明, 等. 基于似物性判别的视觉目标 检测方法[J]. 传感器与微系统, 2017, 36(11): 147–150. MAO Yuren, GUO Song, ZHENG Yangming, et al. Visual object detection method based on objectness estimation[J]. Transducer and microsystem technologies, 2017, 36(11): 147–150. [2] 齐静, 徐坤, 丁希仑. 机器人视觉手势交互技术研究进展 [J]. 机器人, 2017, 39(4): 565–584. QI Jing, XU Kun, DING Xilun. Vision-based hand gesture recognition for human-robot interaction: a review[J]. Robot, 2017, 39(4): 565–584. [3] 王成济, 罗志明, 钟准, 等. 一种多层特征融合的人脸检 测方法[J]. 智能系统学报, 2018, 13(1): 138–146. WANG Chengji, LUO Zhiming, ZHONG Zhun, et al. Face detection method fusing multi-layer features[J]. CAAI transactions on intelligent systems, 2018, 13(1): 138–146. [4] 吴钟强, 张耀文, 商琳. 基于语义特征的多视图情感分类 方法[J]. 智能系统学报, 2017, 12(5): 745–751. WU Zhongqiang, ZHANG Yaowen, SHANG Lin. Multiview sentiment classification of microblogs based on semantic features[J]. CAAI transactions on intelligent systems, 2017, 12(5): 745–751. [5] 温有福, 贾彩燕, 陈智能. 一种多模态融合的网络视频相 关性度量方法[J]. 智能系统学报, 2016, 11(3): 359–365. WEN Youfu, JIA Caiyan, CHEN Zhineng. A multi-modal fusion approach for measuring web video relatedness[J]. CAAI transactions on intelligent systems, 2016, 11(3): 359–365. [6] 吴宗胜, 傅卫平, 韩改宁. 基于深度卷积神经网络的道路 场景理解[J]. 计算机工程与应用, 2017, 53(22): 8–15. WU Zongsheng, FU Weiping, HAN Gaining. Road scene understanding based on deep convolutional neural network[J]. Computer engineering and applications, 2017, 53(22): 8–15. [7] 吴宗胜, 傅卫平. 移动机器人全局路径规划的模拟退火- 教与学优化算法[J]. 机械科学与技术, 2016, 35(5): 678–685. WU Zongsheng, FU Weiping. SA and teaching-learning - based optimization algorithm for mobile robots global path planning[J]. Mechanical science and technology for aerospace engineering, 2016, 35(5): 678–685. [8] ·156· 智 能 系 统 学 报 第 14 卷