正在加载图片...

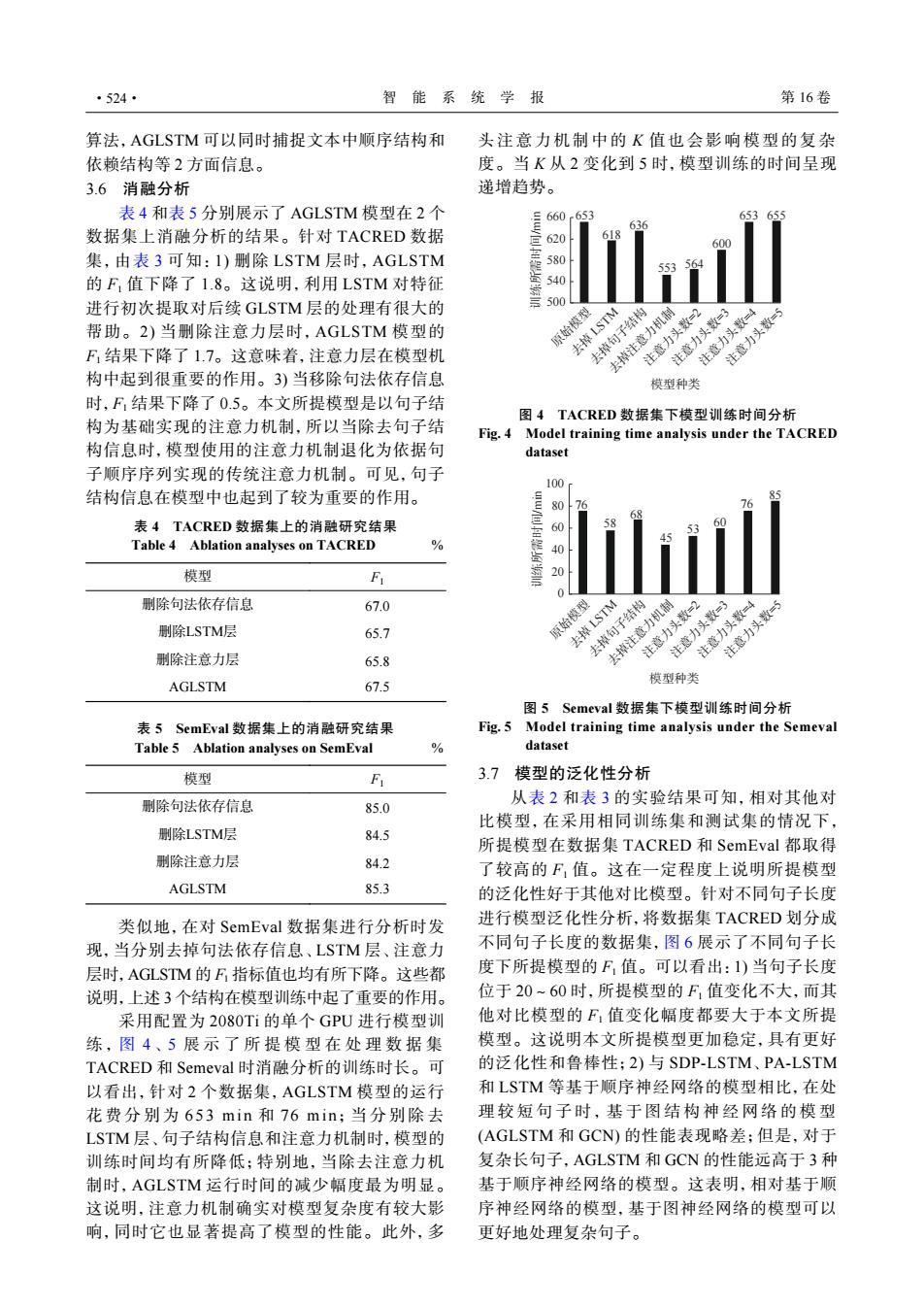

·524· 智能系统学报 第16卷 算法,AGLSTM可以同时捕捉文本中顺序结构和 头注意力机制中的K值也会影响模型的复杂 依赖结构等2方面信息。 度。当K从2变化到5时,模型训练的时间呈现 3.6消融分析 递增趋势。 表4和表5分别展示了AGLSTM模型在2个 660 65 数据集上消融分析的结果。针对TACRED数据 620 集,由表3可知:1)删除LSTM层时,AGLSTM 580 553 的F值下降了1.8。这说明,利用LSTM对特征 540 进行初次提取对后续GLSTM层的处理有很大的 500 帮助。2)当删除注意力层时,AGLSTM模型的 原始模型 去掉注意力机制 去掉句子结构 去掉LSTM F结果下降了1.7。这意味着,注意力层在模型机 注意力头数=2 注意力头数=4 注意力头数=3 注意力头数=S 构中起到很重要的作用。3)当移除句法依存信息 模型种类 时,F:结果下降了0.5。本文所提模型是以句子结 图4 TACRED数据集下模型训练时间分析 构为基础实现的注意力机制,所以当除去句子结 Fig.4 Model training time analysis under the TACRED 构信息时,模型使用的注意力机制退化为依据句 dataset 子顺序序列实现的传统注意力机制。可见,句子 100 结构信息在模型中也起到了较为重要的作用。 80 16 表4 TACRED数据集上的消融研究结果 60 Table 4 Ablation analyses on TACRED 40 模型 20 FL 0 删除句法依存信息 67.0 删除LSTM层 65.7 原始模型 删除注意力层 去掉注意力机制 去掉句子结构 去掉LSTM 注意力头数=3 注意力头数=2 注意力头数=4 注意力头数=5 65.8 AGLSTM 模型种类 67.5 图5 Semeval数据集下模型训练时间分析 表5 SemEval数据集上的消融研究结果 Fig.5 Model training time analysis under the Semeval Table 5 Ablation analyses on SemEval oo dataset 模型 F 3.7模型的泛化性分析 删除句法依存信息 从表2和表3的实验结果可知,相对其他对 85.0 比模型,在采用相同训练集和测试集的情况下, 删除LSTM层 84.5 所提模型在数据集TACRED和SemEval都取得 删除注意力层 84.2 了较高的F,值。这在一定程度上说明所提模型 AGLSTM 85.3 的泛化性好于其他对比模型。针对不同句子长度 类似地,在对SemEval数据集进行分析时发 进行模型泛化性分析,将数据集TACRED划分成 现,当分别去掉句法依存信息、LSTM层、注意力 不同句子长度的数据集,图6展示了不同句子长 层时,AGLSTM的F指标值也均有所下降。这些都 度下所提模型的F,值。可以看出:1)当句子长度 说明,上述3个结构在模型训练中起了重要的作用。 位于20~60时,所提模型的F,值变化不大,而其 采用配置为2080Ti的单个GPU进行模型训 他对比模型的F:值变化幅度都要大于本文所提 练,图4、5展示了所提模型在处理数据集 模型。这说明本文所提模型更加稳定,具有更好 TACRED和Semeval时消融分析的训练时长。可 的泛化性和鲁棒性;2)与SDP-LSTM、PA-LSTM 以看出,针对2个数据集,AGLSTM模型的运行 和LSTM等基于顺序神经网络的模型相比,在处 花费分别为653min和76min;当分别除去 理较短句子时,基于图结构神经网络的模型 LSTM层、句子结构信息和注意力机制时,模型的 (AGLSTM和GCN)的性能表现略差;但是,对于 训练时间均有所降低:特别地,当除去注意力机 复杂长句子,AGLSTM和GCN的性能远高于3种 制时,AGLSTM运行时间的减少幅度最为明显。 基于顺序神经网络的模型。这表明,相对基于顺 这说明,注意力机制确实对模型复杂度有较大影 序神经网络的模型,基于图神经网络的模型可以 响,同时它也显著提高了模型的性能。此外,多 更好地处理复杂句子。算法,AGLSTM 可以同时捕捉文本中顺序结构和 依赖结构等 2 方面信息。 3.6 消融分析 表 4 和表 5 分别展示了 AGLSTM 模型在 2 个 数据集上消融分析的结果。针对 TACRED 数据 集,由表 3 可知:1) 删除 LSTM 层时,AGLSTM 的 F1 值下降了 1.8。这说明,利用 LSTM 对特征 进行初次提取对后续 GLSTM 层的处理有很大的 帮助。2) 当删除注意力层时,AGLSTM 模型的 F1 结果下降了 1.7。这意味着,注意力层在模型机 构中起到很重要的作用。3) 当移除句法依存信息 时,F1 结果下降了 0.5。本文所提模型是以句子结 构为基础实现的注意力机制,所以当除去句子结 构信息时,模型使用的注意力机制退化为依据句 子顺序序列实现的传统注意力机制。可见,句子 结构信息在模型中也起到了较为重要的作用。 表 4 TACRED 数据集上的消融研究结果 Table 4 Ablation analyses on TACRED % 模型 F1 删除句法依存信息 67.0 删除LSTM层 65.7 删除注意力层 65.8 AGLSTM 67.5 表 5 SemEval 数据集上的消融研究结果 Table 5 Ablation analyses on SemEval % 模型 F1 删除句法依存信息 85.0 删除LSTM层 84.5 删除注意力层 84.2 AGLSTM 85.3 类似地,在对 SemEval 数据集进行分析时发 现,当分别去掉句法依存信息、LSTM 层、注意力 层时,AGLSTM 的 F1 指标值也均有所下降。这些都 说明,上述 3 个结构在模型训练中起了重要的作用。 采用配置为 2080Ti 的单个 GPU 进行模型训 练 , 图 4 、 5 展示了所提模型在处理数据 集 TACRED 和 Semeval 时消融分析的训练时长。可 以看出,针对 2 个数据集,AGLSTM 模型的运行 花费分别 为 653 mi n 和 76 min;当分别除 去 LSTM 层、句子结构信息和注意力机制时,模型的 训练时间均有所降低;特别地,当除去注意力机 制时,AGLSTM 运行时间的减少幅度最为明显。 这说明,注意力机制确实对模型复杂度有较大影 响,同时它也显著提高了模型的性能。此外,多 头注意力机制中的 K 值也会影响模型的复杂 度。当 K 从 2 变化到 5 时,模型训练的时间呈现 递增趋势。 653 618 636 553 564 600 653 655 500 540 580 620 660 原始模型 去掉 LSTM 去掉句子结构 去掉注意力机制 注意力头数=2 注意力头数=3 注意力头数=4 注意力头数=5 训练所需时间/min 模型种类 图 4 TACRED 数据集下模型训练时间分析 Fig. 4 Model training time analysis under the TACRED dataset 58 68 45 53 60 76 85 0 20 40 60 80 100 原始模型 去掉 LSTM 去掉句子结构 去掉注意力机制 注意力头数=2 注意力头数=3 注意力头数=4 注意力头数=5 训练所需时间/min 模型种类 76 图 5 Semeval 数据集下模型训练时间分析 Fig. 5 Model training time analysis under the Semeval dataset 3.7 模型的泛化性分析 从表 2 和表 3 的实验结果可知,相对其他对 比模型,在采用相同训练集和测试集的情况下, 所提模型在数据集 TACRED 和 SemEval 都取得 了较高的 F1 值。这在一定程度上说明所提模型 的泛化性好于其他对比模型。针对不同句子长度 进行模型泛化性分析,将数据集 TACRED 划分成 不同句子长度的数据集,图 6 展示了不同句子长 度下所提模型的 F1 值。可以看出:1) 当句子长度 位于 20~60 时,所提模型的 F1 值变化不大,而其 他对比模型的 F1 值变化幅度都要大于本文所提 模型。这说明本文所提模型更加稳定,具有更好 的泛化性和鲁棒性;2) 与 SDP-LSTM、PA-LSTM 和 LSTM 等基于顺序神经网络的模型相比,在处 理较短句子时,基于图结构神经网络的模 型 (AGLSTM 和 GCN) 的性能表现略差;但是,对于 复杂长句子,AGLSTM 和 GCN 的性能远高于 3 种 基于顺序神经网络的模型。这表明,相对基于顺 序神经网络的模型,基于图神经网络的模型可以 更好地处理复杂句子。 ·524· 智 能 系 统 学 报 第 16 卷