正在加载图片...

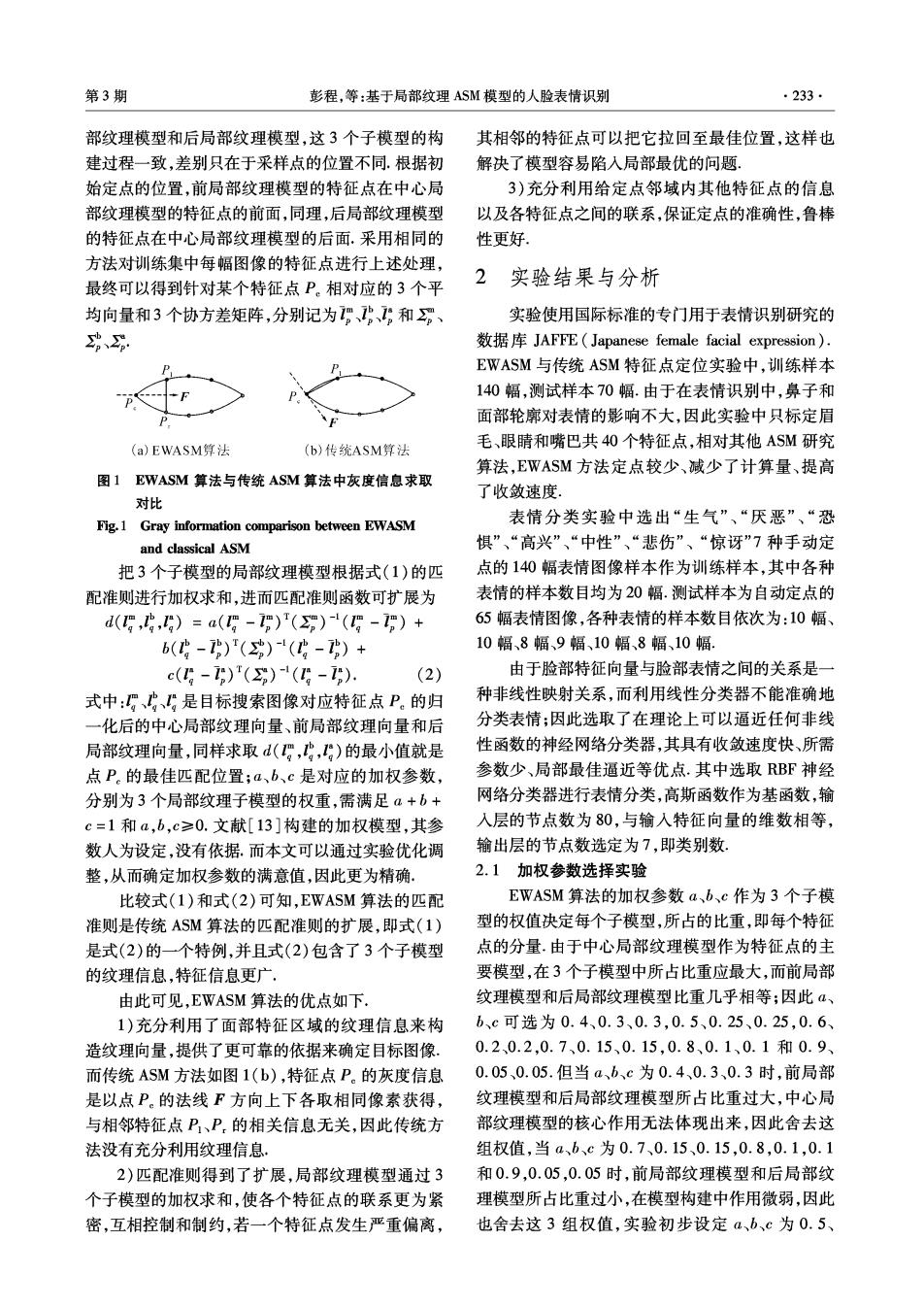

第3期 彭程,等:基于局部纹理ASM模型的人脸表情识别 ·233· 部纹理模型和后局部纹理模型,这3个子模型的构 其相邻的特征点可以把它拉回至最佳位置,这样也 建过程一致,差别只在于采样点的位置不同.根据初 解决了模型容易陷入局部最优的问题、 始定点的位置,前局部纹理模型的特征点在中心局 3)充分利用给定点邻域内其他特征点的信息 部纹理模型的特征点的前面,同理,后局部纹理模型 以及各特征点之间的联系,保证定点的准确性,鲁棒 的特征点在中心局部纹理模型的后面.采用相同的 性更好 方法对训练集中每幅图像的特征点进行上述处理, 2 最终可以得到针对某个特征点P。相对应的3个平 实验结果与分析 均向量和3个协方差矩阵,分别记为、、:和分 实验使用国际标准的专门用于表情识别研究的 功、 数据库JAFFE(Japanese female facial expression), EWASM与传统ASM特征点定位实验中,训练样本 140幅,测试样本70幅.由于在表情识别中,鼻子和 面部轮廓对表情的影响不大,因此实验中只标定眉 (a)EWASM算法 (b)传统ASM算法 毛、眼晴和嘴巴共40个特征点,相对其他ASM研究 算法,EWASM方法定点较少、减少了计算量、提高 图1 EWASM算法与传统ASM算法中灰度信息求取 了收敛速度, 对比 表情分类实验中选出“生气”、“厌恶”、“恐 Fig.1 Gray information comparison between EWASM and classical ASM 惧”、“高兴”、“中性”、“悲伤”、“惊讶”7种手动定 把3个子模型的局部纹理模型根据式(1)的匹 点的140幅表情图像样本作为训练样本,其中各种 配准则进行加权求和,进而匹配准则函数可扩展为 表情的样本数目均为20幅.测试样本为自动定点的 d(g,,g)=a(g-)()-(-)+ 65幅表情图像,各种表情的样本数目依次为:10幅、 6(中-)()4(功-)+ 10幅、8幅、9幅、10幅、8幅、10幅. c(g-1)()(g-T) (2) 由于脸部特征向量与脸部表情之间的关系是一 式中:、、是目标搜索图像对应特征点P。的归 种非线性映射关系,而利用线性分类器不能准确地 一化后的中心局部纹理向量、前局部纹理向量和后 分类表情;因此选取了在理论上可以逼近任何非线 局部纹理向量,同样求取d(,,)的最小值就是 性函数的神经网络分类器,其具有收敛速度快、所需 点P。的最佳匹配位置;a、b、c是对应的加权参数, 参数少、局部最佳逼近等优点.其中选取RBF神经 分别为3个局部纹理子模型的权重,需满足a+b+ 网络分类器进行表情分类,高斯函数作为基函数,输 c=1和a,b,c≥0.文献[13]构建的加权模型,其参 入层的节点数为80,与输入特征向量的维数相等, 数人为设定,没有依据.而本文可以通过实验优化调 输出层的节点数选定为7,即类别数 整,从而确定加权参数的满意值,因此更为精确。 2.1加权参数选择实验 比较式(1)和式(2)可知,EWASM算法的匹配 EWASM算法的加权参数a、b、c作为3个子模 准则是传统ASM算法的匹配准则的扩展,即式(1) 型的权值决定每个子模型,所占的比重,即每个特征 是式(2)的一个特例,并且式(2)包含了3个子模型 点的分量.由于中心局部纹理模型作为特征点的主 的纹理信息,特征信息更广 要模型,在3个子模型中所占比重应最大,而前局部 由此可见,EWASM算法的优点如下. 纹理模型和后局部纹理模型比重几乎相等;因此α、 1)充分利用了面部特征区域的纹理信息来构 b、c可选为0.4、0.3、0.3,0.5、0.25、0.25,0.6、 造纹理向量,提供了更可靠的依据来确定目标图像. 0.2、0.2,0.7、0.15、0.15,0.8、0.1、0.1和0.9、 而传统ASM方法如图1(b),特征点P。的灰度信息 0.050.05.但当a、b、c为0.4、0.3、0.3时,前局部 是以点P。的法线F方向上下各取相同像素获得, 纹理模型和后局部纹理模型所占比重过大,中心局 与相邻特征点P、P.的相关信息无关,因此传统方 部纹理模型的核心作用无法体现出来,因此舍去这 法没有充分利用纹理信息. 组权值,当a、b、c为0.7、0.15、0.15,0.8,0.1,0.1 2)匹配准则得到了扩展,局部纹理模型通过3 和0.9,0.05,0.05时,前局部纹理模型和后局部纹 个子模型的加权求和,使各个特征点的联系更为紧 理模型所占比重过小,在模型构建中作用微弱,因此 密,互相控制和制约,若一个特征点发生严重偏离, 也舍去这3组权值,实验初步设定a、b、c为0.5