正在加载图片...

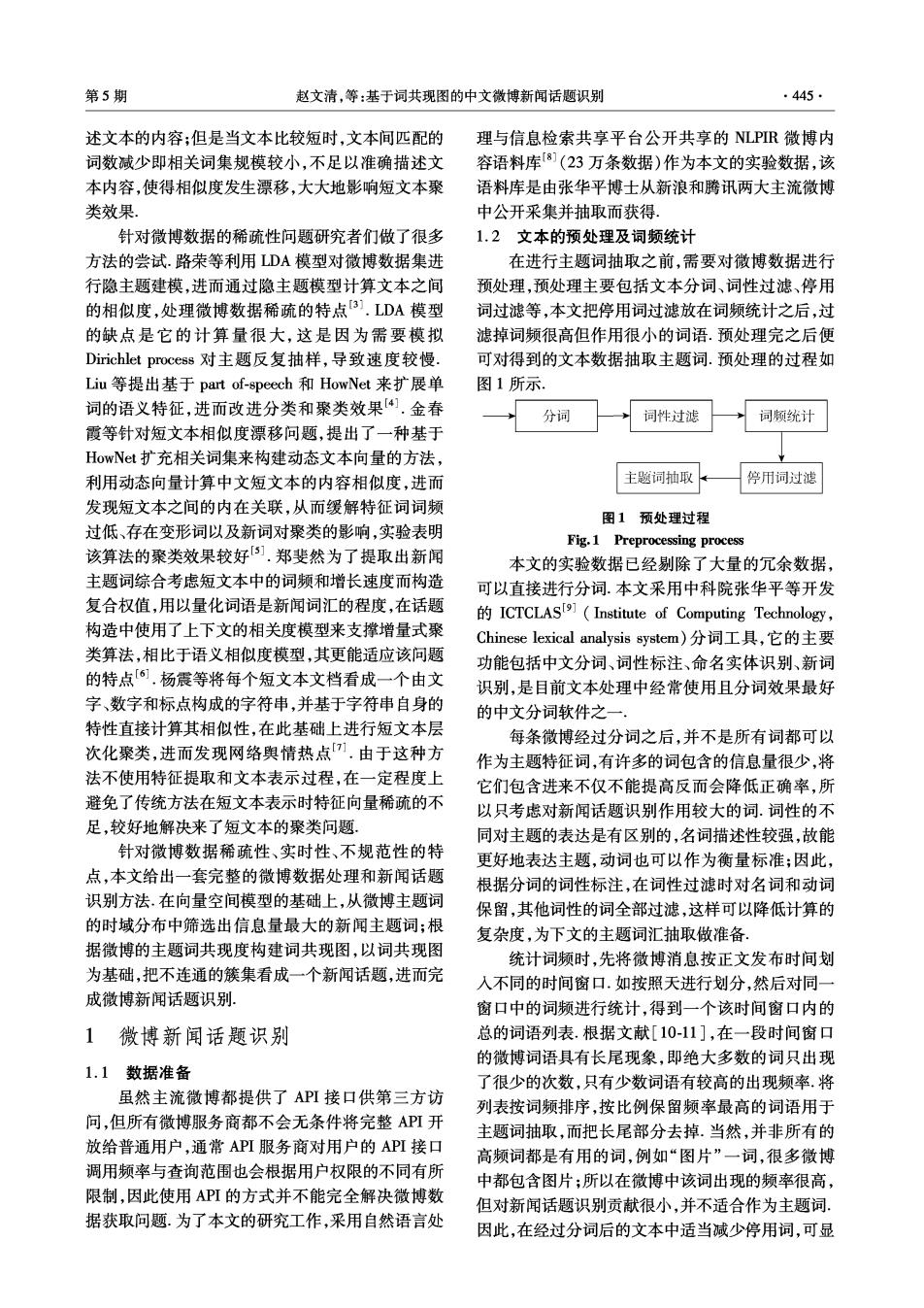

第5期 赵文清,等:基于词共现图的中文微博新闻话题识别 .445 述文本的内容;但是当文本比较短时,文本间匹配的 理与信息检索共享平台公开共享的NLPIR微博内 词数减少即相关词集规模较小,不足以准确描述文 容语料库[8](23万条数据)作为本文的实验数据,该 本内容,使得相似度发生漂移,大大地影响短文本聚 语料库是由张华平博士从新浪和腾讯两大主流微博 类效果。 中公开采集并抽取而获得. 针对微博数据的稀疏性问题研究者们做了很多 1.2文本的预处理及词频统计 方法的尝试.路荣等利用LDA模型对微博数据集进 在进行主题词抽取之前,需要对微博数据进行 行隐主题建模,进而通过隐主题模型计算文本之间 预处理,预处理主要包括文本分词、词性过滤、停用 的相似度,处理微博数据稀疏的特点3).LDA模型 词过滤等,本文把停用词过滤放在词频统计之后,过 的缺点是它的计算量很大,这是因为需要模拟 滤掉词频很高但作用很小的词语.预处理完之后便 Dirichlet process对主题反复抽样,导致速度较慢. 可对得到的文本数据抽取主题词.预处理的过程如 Liu等提出基于part of-speech和HowNet来扩展单 图1所示. 词的语义特征,进而改进分类和聚类效果.金春 分词 词性过滤 词频统计 霞等针对短文本相似度漂移问题,提出了一种基于 HowNet扩充相关词集来构建动态文本向量的方法, 利用动态向量计算中文短文本的内容相似度,进而 主题词抽取 停用词过滤 发现短文本之间的内在关联,从而缓解特征词词频 图1预处理过程 过低、存在变形词以及新词对聚类的影响,实验表明 Fig.1 Preprocessing process 该算法的聚类效果较好5].郑斐然为了提取出新闻 本文的实验数据已经剔除了大量的冗余数据, 主题词综合考虑短文本中的词频和增长速度而构造 可以直接进行分词.本文采用中科院张华平等开发 复合权值,用以量化词语是新闻词汇的程度,在话题 ICTCLASI](Institute of Computing Technology, 构造中使用了上下文的相关度模型来支撑增量式聚 Chinese lexical analysis system)分词工具,它的主要 类算法,相比于语义相似度模型,其更能适应该问题 功能包括中文分词、词性标注、命名实体识别、新词 的特点[6.杨震等将每个短文本文档看成一个由文 识别,是目前文本处理中经常使用且分词效果最好 字、数字和标点构成的字符串,并基于字符串自身的 的中文分词软件之一. 特性直接计算其相似性,在此基础上进行短文本层 每条微博经过分词之后,并不是所有词都可以 次化聚类,进而发现网络舆情热点[,由于这种方 作为主题特征词,有许多的词包含的信息量很少,将 法不使用特征提取和文本表示过程,在一定程度上 它们包含进来不仅不能提高反而会降低正确率,所 避免了传统方法在短文本表示时特征向量稀疏的不 以只考虑对新闻话题识别作用较大的词.词性的不 足,较好地解决来了短文本的聚类问题: 同对主题的表达是有区别的,名词描述性较强,故能 针对微博数据稀疏性、实时性、不规范性的特 更好地表达主题,动词也可以作为衡量标准;因此, 点,本文给出一套完整的微博数据处理和新闻话题 根据分词的词性标注,在词性过滤时对名词和动词 识别方法.在向量空间模型的基础上,从微博主题词 保留,其他词性的词全部过滤,这样可以降低计算的 的时域分布中筛选出信息量最大的新闻主题词;根 复杂度,为下文的主题词汇抽取做准备 据微博的主题词共现度构建词共现图,以词共现图 统计词频时,先将微博消息按正文发布时间划 为基础,把不连通的簇集看成一个新闻话题,进而完 入不同的时间窗口.如按照天进行划分,然后对同一 成微博新闻话题识别. 窗口中的词频进行统计,得到一个该时间窗口内的 1 微博新闻话题识别 总的词语列表.根据文献[10-11],在一段时间窗口 的微博词语具有长尾现象,即绝大多数的词只出现 1.1数据准备 了很少的次数,只有少数词语有较高的出现频率.将 虽然主流微博都提供了API接口供第三方访 列表按词频排序,按比例保留频率最高的词语用于 问,但所有微博服务商都不会无条件将完整API开 主题词抽取,而把长尾部分去掉.当然,并非所有的 放给普通用户,通常API服务商对用户的API接口 高频词都是有用的词,例如“图片”一词,很多微博 调用频率与查询范围也会根据用户权限的不同有所 中都包含图片;所以在微博中该词出现的频率很高, 限制,因此使用API的方式并不能完全解决微博数 但对新闻话题识别贡献很小,并不适合作为主题词, 据获取问题.为了本文的研究工作,采用自然语言处 因此,在经过分词后的文本中适当减少停用词,可显