正在加载图片...

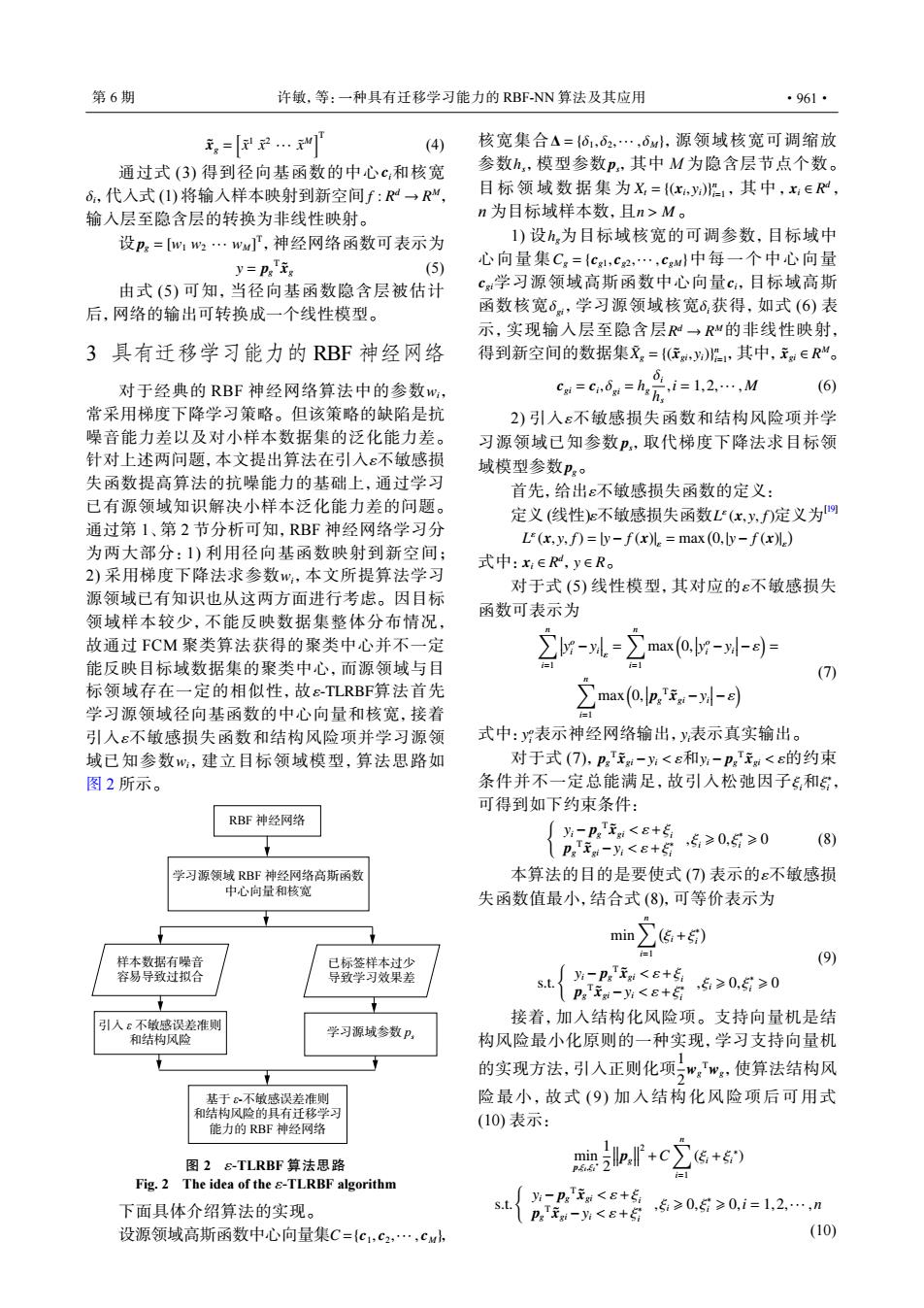

第6期 许敏,等:一种具有迁移学习能力的RBF-NN算法及其应用 ·961· 元,=… (4) 核宽集合△={61,62,…,6w,源领域核宽可调缩放 通过式(3)得到径向基函数的中心c:和核宽 参数h,模型参数p,其中M为隐含层节点个数。 6,代人式(I)将输人样本映射到新空间f:R→R“, 目标领域数据集为X={(x,y1,其中,x∈R, 输入层至隐含层的转换为非线性映射。 n为目标域样本数,且n>M。 设p。=w1w2…ww,神经网络函数可表示为 1)设h为目标域核宽的可调参数,目标域中 y=Ps is (5) 心向量集Cg={c,C2,…,cgM中每一个中心向量 由式(5)可知,当径向基函数隐含层被估计 c学习源领域高斯函数中心向量c,目标域高斯 后,网络的输出可转换成一个线性模型。 函数核宽6,学习源领域核宽6,获得,如式(6)表 示,实现输入层至隐含层R→RM的非线性映射, 3具有迁移学习能力的RBF神经网络 得到新空间的数据集又={(住,)1,其中,元a∈R“。 对于经典的RBF神经网络算法中的参数W, c=c0a=h,元,i=1,2…,M (6) 常采用梯度下降学习策略。但该策略的缺陷是抗 2)引入ε不敏感损失函数和结构风险项并学 噪音能力差以及对小样本数据集的泛化能力差。 习源领域已知参数P,取代梯度下降法求目标领 针对上述两问题,本文提出算法在引入ε不敏感损 域模型参数p。 失函数提高算法的抗噪能力的基础上,通过学习 首先,给出ε不敏感损失函数的定义: 已有源领域知识解决小样本泛化能力差的问题。 定义(饯性)不敏感损失函数LF(x,,)定义为网 通过第1、第2节分析可知,RBF神经网络学习分 L(x,y,f)=by-f(x儿=max(0,y-f(x儿) 为两大部分:)利用径向基函数映射到新空间; 式中:xeR,yeRo 2)采用梯度下降法求参数w,本文所提算法学习 对于式(5)线性模型,其对应的ε不敏感损失 源领域已有知识也从这两方面进行考虑。因目标 领域样本较少,不能反映数据集整体分布情况, 函数可表示为 故通过FCM聚类算法获得的聚类中心并不一定 2--立o-以- 能反映目标域数据集的聚类中心,而源领域与目 i=1 (7) 标领域存在一定的相似性,故εTLRBF算法首先 学习源领域径向基函数的中心向量和核宽,接着 立man, 引人ε不敏感损失函数和结构风险项并学习源领 式中:表示神经网络输出,y表示真实输出。 域已知参数,建立目标领域模型,算法思路如 对于式(7),p:T-为<和%-paTx<的约束 图2所示。 条件并不一定总能满足,故引入松弛因子,和, 可得到如下约束条件: RBF神经网络 为-PgT元<E+5 Ps ig-yi<8+ ,5≥0,5≥0 (8) 学习源领域RBF神经网络高斯函数 本算法的目的是要使式(7表示的ε不敏感损 中心向量和核宽 失函数值最小,结合式(8),可等价表示为 in∑(传:+号) 样本数据有噪音 已标签样本过少 (9) 容易导致过拟合 导致学习效果差 s.t. -PgTi<E+5 Pg元-<ε+金 ,5≥0,≥0 引入ε不敏感误差准则 接着,加入结构化风险项。支持向量机是结 和结构风险 学习源域参数P, 构风险最小化原则的一种实现,学习支持向量机 的实现方法,引人正则化项”,w,使算法结构风 基于8-不敏感误差准则 险最小,故式(9)加入结构化风险项后可用式 和结构风险的具有迁移学习 (10)表示: 能力的RBF神经网络 图2 &-TLRBF算法思路 mf+c∑+ Fig.2 The idea of the s-TLRBF algorithm 下面具体介绍算法的实现。 s.t. A8t60发≥01=12 设源领域高斯函数中心向量集C={c1,c2,…,cw, (10)x˜ g = [ x˜ 1 x˜ 2 ··· x˜ M ]T (4) ci δi f : R d → R M 通过式 (3) 得到径向基函数的中心 和核宽 ,代入式 (1) 将输入样本映射到新空间 , 输入层至隐含层的转换为非线性映射。 pg = [w1 w2 ··· wM] 设 T ,神经网络函数可表示为 y = pg T x˜ g (5) 由式 (5) 可知,当径向基函数隐含层被估计 后,网络的输出可转换成一个线性模型。 3 具有迁移学习能力的 RBF 神经网络 wi ε wi ε-TLRBF ε wi 对于经典的 RBF 神经网络算法中的参数 , 常采用梯度下降学习策略。但该策略的缺陷是抗 噪音能力差以及对小样本数据集的泛化能力差。 针对上述两问题,本文提出算法在引入 不敏感损 失函数提高算法的抗噪能力的基础上,通过学习 已有源领域知识解决小样本泛化能力差的问题。 通过第 1、第 2 节分析可知,RBF 神经网络学习分 为两大部分:1) 利用径向基函数映射到新空间; 2) 采用梯度下降法求参数 ,本文所提算法学习 源领域已有知识也从这两方面进行考虑。因目标 领域样本较少,不能反映数据集整体分布情况, 故通过 FCM 聚类算法获得的聚类中心并不一定 能反映目标域数据集的聚类中心,而源领域与目 标领域存在一定的相似性,故 算法首先 学习源领域径向基函数的中心向量和核宽,接着 引入 不敏感损失函数和结构风险项并学习源领 域已知参数 ,建立目标领域模型,算法思路如 图 2 所示。 RBF 神经网络 学习源领域 RBF 神经网络高斯函数 中心向量和核宽 样本数据有噪音 容易导致过拟合 已标签样本过少 导致学习效果差 引入 ε 不敏感误差准则 和结构风险 学习源域参数 ps 基于 ε-不敏感误差准则 和结构风险的具有迁移学习 能力的 RBF 神经网络 图 2 ε-TLRBF 算法思路 Fig. 2 The idea of the ε-TLRBF algorithm 下面具体介绍算法的实现。 设源领域高斯函数中心向量集 C={c1, c2,··· , cM}, ∆ = {δ1,δ2,··· ,δM} hs ps Xt = {(xi , yi)} n i=1 xi ∈ R d n > M 核宽集合 ,源领域核宽可调缩放 参数 ,模型参数 ,其中 M 为隐含层节点个数。 目标领域数据集为 ,其中, , n 为目标域样本数,且 。 hg Cg = {cg1, cg2,··· , cgM} cgi ci δgi δi R d → R M X˜ g = {(x˜ gi, yi)} n i=1 x˜ gi ∈ R M 1) 设 为目标域核宽的可调参数,目标域中 心向量集 中每一个中心向量 学习源领域高斯函数中心向量 ,目标域高斯 函数核宽 ,学习源领域核宽 获得,如式 (6) 表 示,实现输入层至隐含层 的非线性映射, 得到新空间的数据集 ,其中, 。 cgi = ci ,δgi = hg δi hs ,i = 1,2,··· , M (6) ε ps pg 2) 引入 不敏感损失函数和结构风险项并学 习源领域已知参数 ,取代梯度下降法求目标领 域模型参数 。 首先,给出ε不敏感损失函数的定义: ε L ε 定义 (线性) 不敏感损失函数 (x, y, f) 定义为[19] L ε (x, y, f) = |y− f (x)| ε = max( 0,|y− f (x)| ε ) xi ∈ R d 式中: ,y ∈ R。 对于式 (5) 线性模型,其对应的ε不敏感损失 函数可表示为 ∑n i=1

y o i −yi

ε = ∑n i=1 max( 0,

y o i −yi

−ε ) = ∑n i=1 max( 0,

pg T x˜ gi −yi

−ε ) (7) y o i 式中: 表示神经网络输出, yi表示真实输出。 pg T x˜ gi −yi < ε yi − pg T x˜ gi < ε ξi ξ ∗ i 对于式 (7), 和 的约束 条件并不一定总能满足,故引入松弛因子 和 , 可得到如下约束条件: { yi − pg T x˜ gi < ε+ξi pg T x˜ gi −yi < ε+ξ ∗ i , ξi ⩾ 0, ξ∗ i ⩾ 0 (8) 本算法的目的是要使式 (7) 表示的ε不敏感损 失函数值最小,结合式 (8),可等价表示为 min∑n i=1 ( ξi +ξ ∗ i ) s.t. { yi − pg T x˜ gi < ε+ξi pg T x˜ gi −yi < ε+ξ ∗ i , ξi ⩾ 0, ξ∗ i ⩾ 0 (9) 1 2 wg Twg 接着,加入结构化风险项。支持向量机是结 构风险最小化原则的一种实现,学习支持向量机 的实现方法,引入正则化项 ,使算法结构风 险最小,故式 (9) 加入结构化风险项后可用式 (10) 表示: min p,ξi,ξi ∗ 1 2 pg 2 +C ∑n i=1 (ξi +ξi ∗ ) s.t. { yi − pg T x˜ gi < ε+ξi pg T x˜ gi −yi < ε+ξ ∗ i , ξi ⩾ 0, ξ∗ i ⩾ 0,i = 1,2,··· ,n (10) 第 6 期 许敏,等:一种具有迁移学习能力的 RBF-NN 算法及其应用 ·961·