正在加载图片...

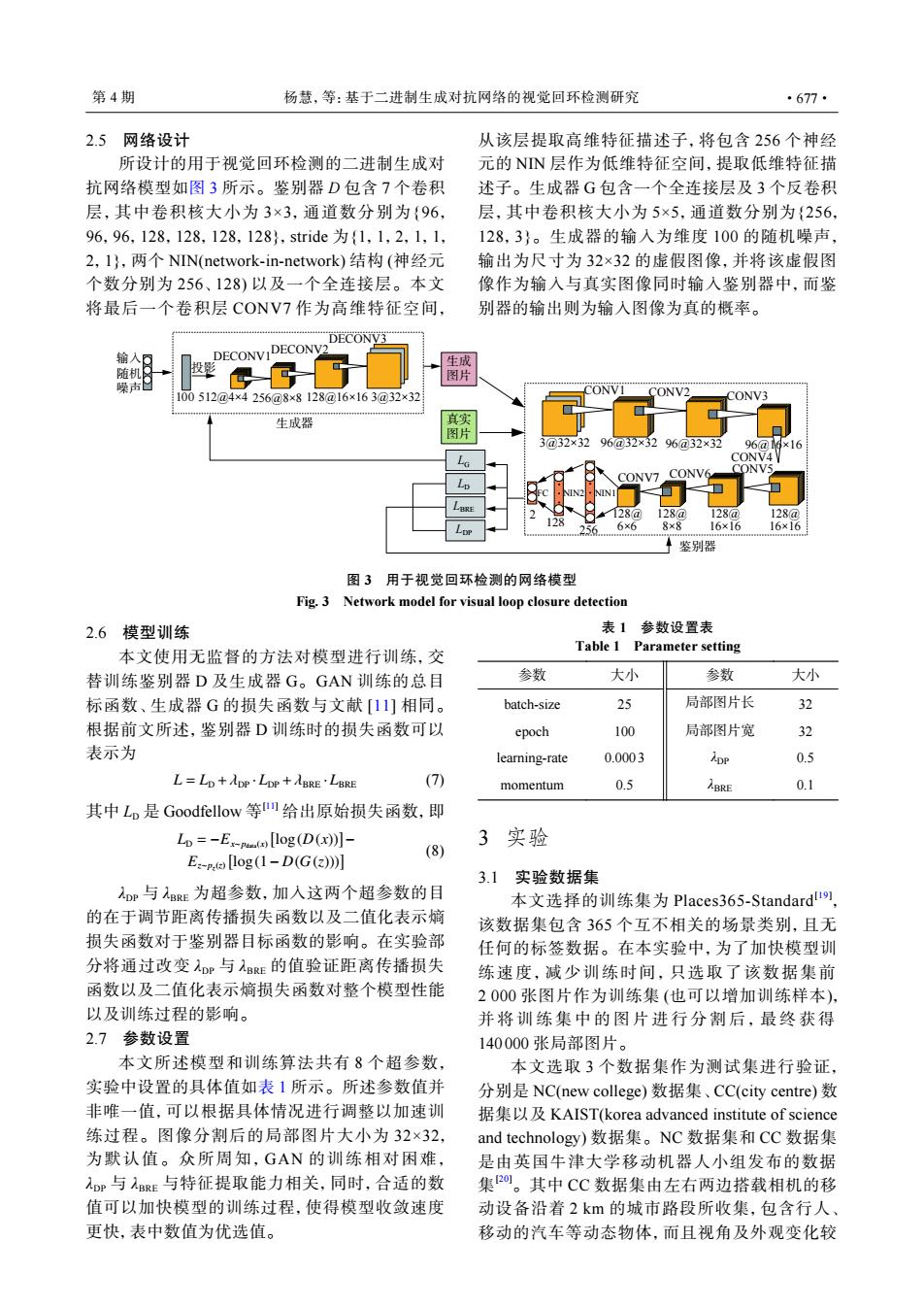

第4期 杨慧,等:基于二进制生成对抗网络的视觉回环检测研究 ·677· 2.5网络设计 从该层提取高维特征描述子,将包含256个神经 所设计的用于视觉回环检测的二进制生成对 元的NN层作为低维特征空间,提取低维特征描 抗网络模型如图3所示。鉴别器D包含7个卷积 述子。生成器G包含一个全连接层及3个反卷积 层,其中卷积核大小为3×3,通道数分别为{96, 层,其中卷积核大小为5×5,通道数分别为{256, 96,96,128,128,128,128},stride为{1,1,2,1,1, 128,3}。生成器的输入为维度100的随机噪声, 2,I},两个NN(network-in-network)结构(神经元 输出为尺寸为32×32的虚假图像,并将该虚假图 个数分别为256、128)以及一个全连接层。本文 像作为输入与真实图像同时输入鉴别器中,而鉴 将最后一个卷积层CONV7作为高维特征空间, 别器的输出则为输入图像为真的概率。 44444444444444=4444444444 ECONV3 输人可 DECONVIDECONV2 投 生成 随机 图片 噪声已 100512@4×4256@8×8128@16×163@32×32 ONVI CONV2 CONV3 生成器 真实 图片 3@32×3296@32×3296@32×32 g×16 CONV4 CONV CONV7 CONV6 N 128a 128a 128@ 128a 8×8 16×16 鉴别器 图3用于视觉回环检测的网络模型 Fig.3 Network model for visual loop closure detection 2.6模型训练 表1参数设置表 本文使用无监督的方法对模型进行训练,交 Table 1 Parameter setting 替训练鉴别器D及生成器G。GAN训练的总目 参数 大小 参数 大小 标函数、生成器G的损失函数与文献[11]相同。 batch-size 25 局部图片长 32 根据前文所述,鉴别器D训练时的损失函数可以 epoch 100 局部图片宽 32 表示为 learning-rate 0.0003 ApP 0.5 L=LD+dDP·LDP+BRE·LBRE (7) momentum 0.5 ABRE 0.1 其中Lp是Goodfellow等给出原始损失函数,即 Lo =-E-p(c[log(D(x))]- 3 实验 (8) E:-p.([log(1-D(G(2))] 3.1实验数据集 Dp与BRE为超参数,加入这两个超参数的目 本文选择的训练集为Places365-Standard 的在于调节距离传播损失函数以及二值化表示嫡 该数据集包含365个互不相关的场景类别,且无 损失函数对于鉴别器目标函数的影响。在实验部 任何的标签数据。在本实验中,为了加快模型训 分将通过改变D与BE的值验证距离传播损失 练速度,减少训练时间,只选取了该数据集前 函数以及二值化表示熵损失函数对整个模型性能 2000张图片作为训练集(也可以增加训练样本), 以及训练过程的影响。 并将训练集中的图片进行分割后,最终获得 2.7参数设置 140000张局部图片。 本文所述模型和训练算法共有8个超参数, 本文选取3个数据集作为测试集进行验证, 实验中设置的具体值如表1所示。所述参数值并 分别是NC(new college)数据集、CC(city centre)数 非唯一值,可以根据具体情况进行调整以加速训 据集以及KAIST(korea advanced institute of science 练过程。图像分割后的局部图片大小为32×32, and technology)数据集。NC数据集和CC数据集 为默认值。众所周知,GAN的训练相对困难, 是由英国牛津大学移动机器人小组发布的数据 Dp与BRE与特征提取能力相关,同时,合适的数 集2o。其中CC数据集由左右两边搭载相机的移 值可以加快模型的训练过程,使得模型收敛速度 动设备沿着2km的城市路段所收集,包含行人、 更快,表中数值为优选值。 移动的汽车等动态物体,而且视角及外观变化较2.5 网络设计 所设计的用于视觉回环检测的二进制生成对 抗网络模型如图 3 所示。鉴别器 D 包含 7 个卷积 层,其中卷积核大小为 3×3,通道数分别为{96, 96,96,128,128,128,128},stride 为{1,1,2,1,1, 2,1},两个 NIN(network-in-network) 结构 (神经元 个数分别为 256、128) 以及一个全连接层。本文 将最后一个卷积层 CONV7 作为高维特征空间, 从该层提取高维特征描述子,将包含 256 个神经 元的 NIN 层作为低维特征空间,提取低维特征描 述子。生成器 G 包含一个全连接层及 3 个反卷积 层,其中卷积核大小为 5×5,通道数分别为{256, 128,3}。生成器的输入为维度 100 的随机噪声, 输出为尺寸为 32×32 的虚假图像,并将该虚假图 像作为输入与真实图像同时输入鉴别器中,而鉴 别器的输出则为输入图像为真的概率。 . . . . . . 生成器 输入 随机 噪声 生成 图片 真实 图片 LG LD LBRE LDP 鉴别器 投影 100 512@4×4 256@8×8 128@16×16 3@32×32 3@32×32 96@32×32 128@ 6×6 128@ 8×8 128@ 16×16 128@ 16×16 96@32×32 96@16×16 DECONV1DECONV2 DECONV3 2 128 256 FC NIN2 NIN1 CONV1 CONV2 CONV3 CONV4 CONV5 CONV6 CONV7 图 3 用于视觉回环检测的网络模型 Fig. 3 Network model for visual loop closure detection 2.6 模型训练 本文使用无监督的方法对模型进行训练,交 替训练鉴别器 D 及生成器 G。GAN 训练的总目 标函数、生成器 G 的损失函数与文献 [11] 相同。 根据前文所述,鉴别器 D 训练时的损失函数可以 表示为 L = LD +λDP · LDP +λBRE · LBRE (7) 其中 LD 是 Goodfellow 等 [11] 给出原始损失函数,即 LD = −Ex∼pdata (x) [ log(D(x))] − Ez∼pz(z) [ log(1− D(G(z)))] (8) λDP 与 λBRE 为超参数,加入这两个超参数的目 的在于调节距离传播损失函数以及二值化表示熵 损失函数对于鉴别器目标函数的影响。在实验部 分将通过改变 λDP 与 λBRE 的值验证距离传播损失 函数以及二值化表示熵损失函数对整个模型性能 以及训练过程的影响。 2.7 参数设置 本文所述模型和训练算法共有 8 个超参数, 实验中设置的具体值如表 1 所示。所述参数值并 非唯一值,可以根据具体情况进行调整以加速训 练过程。图像分割后的局部图片大小为 32×32, 为默认值。众所周知,GAN 的训练相对困难, λDP 与 λBRE 与特征提取能力相关,同时,合适的数 值可以加快模型的训练过程,使得模型收敛速度 更快,表中数值为优选值。 表 1 参数设置表 Table 1 Parameter setting 参数 大小 参数 大小 batch-size 25 局部图片长 32 epoch 100 局部图片宽 32 learning-rate 0.0003 λDP 0.5 momentum 0.5 λBRE 0.1 3 实验 3.1 实验数据集 本文选择的训练集为 Places365-Standard[19] , 该数据集包含 365 个互不相关的场景类别,且无 任何的标签数据。在本实验中,为了加快模型训 练速度,减少训练时间,只选取了该数据集前 2 000 张图片作为训练集 (也可以增加训练样本), 并将训练集中的图片进行分割后,最终获得 140000 张局部图片。 本文选取 3 个数据集作为测试集进行验证, 分别是 NC(new college) 数据集、CC(city centre) 数 据集以及 KAIST(korea advanced institute of science and technology) 数据集。NC 数据集和 CC 数据集 是由英国牛津大学移动机器人小组发布的数据 集 [20]。其中 CC 数据集由左右两边搭载相机的移 动设备沿着 2 km 的城市路段所收集,包含行人、 移动的汽车等动态物体,而且视角及外观变化较 第 4 期 杨慧,等:基于二进制生成对抗网络的视觉回环检测研究 ·677·