正在加载图片...

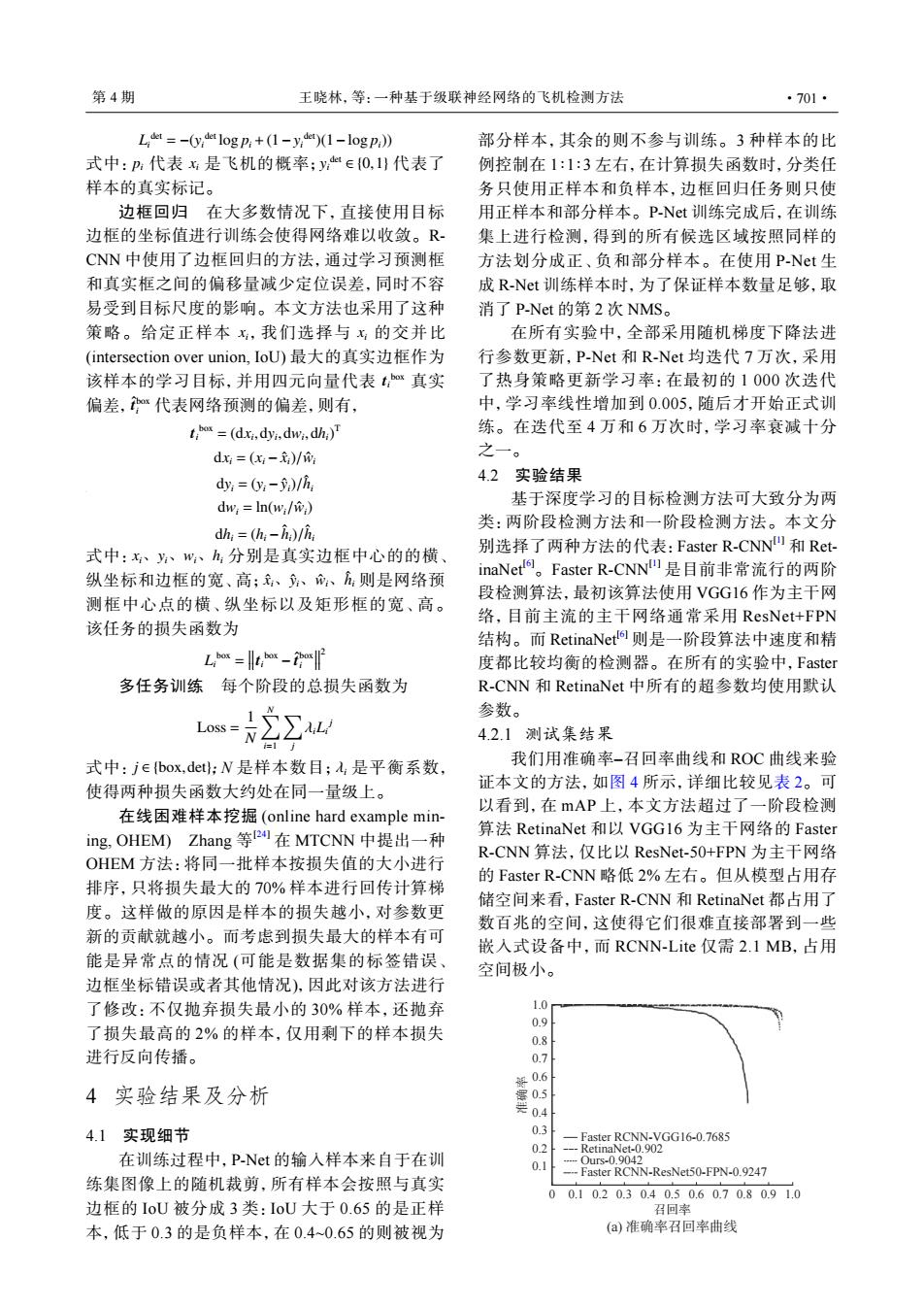

第4期 王晓林,等:一种基于级联神经网络的飞机检测方法 ·701· Loket =-(y,det log p;+(1-y,de (1-log p ) 部分样本,其余的则不参与训练。3种样本的比 式中:P:代表:是飞机的概率;y∈{0,1)代表了 例控制在1:1:3左右,在计算损失函数时,分类任 样本的真实标记。 务只使用正样本和负样本,边框回归任务则只使 边框回归在大多数情况下,直接使用目标 用正样本和部分样本。P-Nt训练完成后,在训练 边框的坐标值进行训练会使得网络难以收敛。R- 集上进行检测,得到的所有候选区域按照同样的 CNN中使用了边框回归的方法,通过学习预测框方法划分成正、负和部分样本。在使用PNt生 和真实框之间的偏移量减少定位误差,同时不容 成R-Net训练样本时,为了保证样本数量足够,取 易受到目标尺度的影响。本文方法也采用了这种 消了P-Net的第2次NMS。 策略。给定正样本x,我们选择与x的交并比 在所有实验中,全部采用随机梯度下降法进 (intersection over union,IoU)最大的真实边框作为 行参数更新,P-Net和R-Net均迭代7万次,采用 该样本的学习目标,并用四元向量代表tx真实 了热身策略更新学习率:在最初的1000次迭代 偏差,代表网络预测的偏差,则有, 中,学习率线性增加到0.005,随后才开始正式训 to=(dxi,dyi,dwi,dhi) 练。在迭代至4万和6万次时,学习率衰减十分 dx=(x:-)/m 之一。 dy,=0y,-)/h 4.2实验结果 dw;In(w:/w) 基于深度学习的目标检测方法可大致分为两 类:两阶段检测方法和一阶段检测方法。本文分 dh:=(hi-ha)/hi 式中:、、w、h,分别是真实边框中心的的横 别选择了两种方法的代表:Faster R-CNN)和Ret- 纵坐标和边框的宽、高;、、、则是网络预 inaNet。Faster R-CNN是目前非常流行的两阶 测框中心点的横、纵坐标以及矩形框的宽、高。 段检测算法,最初该算法使用VGG16作为主干网 络,目前主流的主干网络通常采用ResNet+FPN 该任务的损失函数为 结构。而RetinaNet则是一阶段算法中速度和精 Lo =t,oho 度都比较均衡的检测器。在所有的实验中,Faster 多任务训练每个阶段的总损失函数为 R-CNN和RetinaNet中所有的超参数均使用默认 2∑山 参数。 4.2.1测试集结果 1j 式中:je{box,deth:N是样本数目;是平衡系数, 我们用准确率-召回率曲线和ROC曲线来验 使得两种损失函数大约处在同一量级上。 证本文的方法,如图4所示,详细比较见表2。可 在线困难样本挖掘(online hard example min- 以看到,在mAP上,本文方法超过了一阶段检测 ing,OHEM)Zhang等2在MTCNN中提出一种 算法RetinaNet和以VGGl6为主千网络的Faster R-CNN算法,仅比以ResNet-.5O+FPN为主千网络 OHEM方法:将同一批样本按损失值的大小进行 的Faster R-CNN略低2%左右。但从模型占用存 排序,只将损失最大的70%样本进行回传计算梯 储空间来看,Faster R-CNN和RetinaNet都占用了 度。这样做的原因是样本的损失越小,对参数更 数百兆的空间,这使得它们很难直接部署到一些 新的贡献就越小。而考虑到损失最大的样本有可 嵌入式设备中,而RCNN-Lite仅需2.1MB,占用 能是异常点的情况(可能是数据集的标签错误、 空间极小。 边框坐标错误或者其他情况),因此对该方法进行 了修改:不仅抛弃损失最小的30%样本,还抛弃 1.0 0.9 了损失最高的2%的样本,仅用剩下的样本损失 0.8 进行反向传播。 0.7 解0.6 4实验结果及分析 器0.5 号0.4 4.1实现细节 03 Faster RCNN-VGG16-0.7685 0.2 RetinaNet-0.902 在训练过程中,P-Net的输入样本来自于在训 0.1 -0urs-0.9042 --Faster RCNN-ResNet50-FPN-0.9247 练集图像上的随机裁剪,所有样本会按照与真实 00.10.20.30.40.50.60.70.80.91.0 边框的IoU被分成3类:IoU大于0.65的是正样 召回率 本,低于0.3的是负样本,在0.4~0.65的则被视为 (a)准确率召回率曲线Li det = −(yi det log pi +(1−yi det)(1−log pi)) pi xi yi det 式中: 代表 是飞机的概率; ∈ {0,1} 代表了 样本的真实标记。 xi xi ti box tˆ box i 边框回归 在大多数情况下,直接使用目标 边框的坐标值进行训练会使得网络难以收敛。RCNN 中使用了边框回归的方法,通过学习预测框 和真实框之间的偏移量减少定位误差,同时不容 易受到目标尺度的影响。本文方法也采用了这种 策略。给定正样本 ,我们选择与 的交并比 (intersection over union, IoU) 最大的真实边框作为 该样本的学习目标,并用四元向量代表 真实 偏差, 代表网络预测的偏差,则有, ti box = (dxi ,dyi ,dwi ,dhi) T dxi = (xi − xˆi)/wˆi dyi = (yi −yˆi)/hˆ i dwi = ln(wi/wˆi) dhi = (hi −hˆ i)/hˆ i xi、yi、wi、hi xˆi、yˆi、wˆi、hˆ i 式中: 分别是真实边框中心的的横、 纵坐标和边框的宽、高; 则是网络预 测框中心点的横、纵坐标以及矩形框的宽、高。 该任务的损失函数为 Li box = ti box − tˆ box i 2 多任务训练 每个阶段的总损失函数为 Loss = 1 N ∑N i=1 ∑ j λiLi j 式中: j ∈ {box,det} ;N 是样本数目; λi 是平衡系数, 使得两种损失函数大约处在同一量级上。 在线困难样本挖掘 (online hard example mining, OHEM) Zhang 等 [24] 在 MTCNN 中提出一种 OHEM 方法:将同一批样本按损失值的大小进行 排序,只将损失最大的 70% 样本进行回传计算梯 度。这样做的原因是样本的损失越小,对参数更 新的贡献就越小。而考虑到损失最大的样本有可 能是异常点的情况 (可能是数据集的标签错误、 边框坐标错误或者其他情况),因此对该方法进行 了修改:不仅抛弃损失最小的 30% 样本,还抛弃 了损失最高的 2% 的样本,仅用剩下的样本损失 进行反向传播。 4 实验结果及分析 4.1 实现细节 在训练过程中,P-Net 的输入样本来自于在训 练集图像上的随机裁剪,所有样本会按照与真实 边框的 IoU 被分成 3 类:IoU 大于 0.65 的是正样 本,低于 0.3 的是负样本,在 0.4~0.65 的则被视为 部分样本,其余的则不参与训练。3 种样本的比 例控制在 1∶1∶3 左右,在计算损失函数时,分类任 务只使用正样本和负样本,边框回归任务则只使 用正样本和部分样本。P-Net 训练完成后,在训练 集上进行检测,得到的所有候选区域按照同样的 方法划分成正、负和部分样本。在使用 P-Net 生 成 R-Net 训练样本时,为了保证样本数量足够,取 消了 P-Net 的第 2 次 NMS。 在所有实验中,全部采用随机梯度下降法进 行参数更新,P-Net 和 R-Net 均迭代 7 万次,采用 了热身策略更新学习率:在最初的 1 000 次迭代 中,学习率线性增加到 0.005,随后才开始正式训 练。在迭代至 4 万和 6 万次时,学习率衰减十分 之一。 4.2 实验结果 基于深度学习的目标检测方法可大致分为两 类:两阶段检测方法和一阶段检测方法。本文分 别选择了两种方法的代表:Faster R-CNN[1] 和 RetinaNet[6]。Faster R-CNN[1] 是目前非常流行的两阶 段检测算法,最初该算法使用 VGG16 作为主干网 络,目前主流的主干网络通常采用 ResNet+FPN 结构。而 RetinaNet[6] 则是一阶段算法中速度和精 度都比较均衡的检测器。在所有的实验中,Faster R-CNN 和 RetinaNet 中所有的超参数均使用默认 参数。 4.2.1 测试集结果 我们用准确率–召回率曲线和 ROC 曲线来验 证本文的方法,如图 4 所示,详细比较见表 2。可 以看到,在 mAP 上,本文方法超过了一阶段检测 算法 RetinaNet 和以 VGG16 为主干网络的 Faster R-CNN 算法,仅比以 ResNet-50+FPN 为主干网络 的 Faster R-CNN 略低 2% 左右。但从模型占用存 储空间来看,Faster R-CNN 和 RetinaNet 都占用了 数百兆的空间,这使得它们很难直接部署到一些 嵌入式设备中,而 RCNN-Lite 仅需 2.1 MB,占用 空间极小。 0 0.1 0.2 0.3 0.4 召回率 准确率 0.5 0.6 0.7 0.8 0.9 1.0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1.0 Faster RCNN-VGG16-0.7685 Faster RCNN-ResNet50-FPN-0.9247 RetinaNet-0.902 Ours-0.9042 (a) 准确率召回率曲线 第 4 期 王晓林,等:一种基于级联神经网络的飞机检测方法 ·701·