正在加载图片...

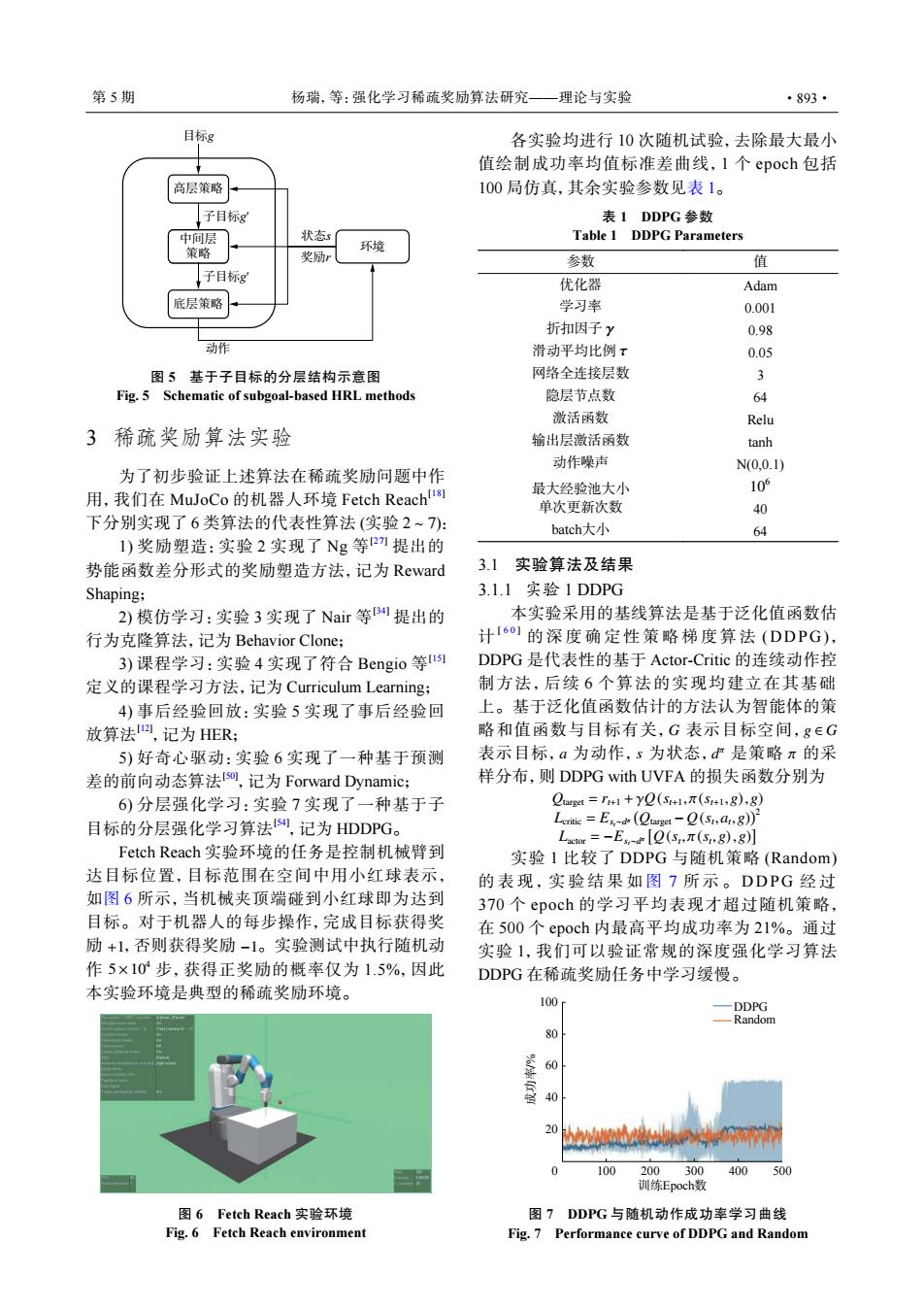

第5期 杨瑞,等:强化学习稀疏奖励算法研究—理论与实验 ·893· 目标g 各实验均进行10次随机试验,去除最大最小 值绘制成功率均值标准差曲线,I个epoch包括 高层策略 100局仿真,其余实验参数见表1。 子目标g 表1DDPG参数 中间层 状态 Table 1 DDPG Parameters 策略 环境 奖励r 参数 值 子目标g 优化器 Adam 底层策略 学习率 0.001 折扣因子y 0.98 动作 滑动平均比例τ 0.05 图5基于子目标的分层结构示意图 网络全连接层数 3 Fig.5 Schematic of subgoal-based HRL methods 隐层节点数 64 激活函数 Relu 3稀疏奖励算法实验 输出层激活函数 tanh 动作噪声 N0,0.1) 为了初步验证上述算法在稀疏奖励问题中作 最大经验池大小 10 用,我们在MuJoCo的机器人环境Fetch Reach!劉 单次更新次数 40 下分别实现了6类算法的代表性算法(实验2~7): batch大小 64 1)奖励塑造:实验2实现了Ng等2)提出的 势能函数差分形式的奖励塑造方法,记为Reward 31实验算法及结果 Shaping; 3.1.1实验1DDPG 2)模仿学习:实验3实现了Nair等B提出的 本实验采用的基线算法是基于泛化值函数估 行为克隆算法,记为Behavior Clone; 计I61的深度确定性策略梯度算法(DDPG), 3)课程学习:实验4实现了符合Bengio等 DDPG是代表性的基于Actor-Critic的连续动作控 定义的课程学习方法,记为Curriculum Learning; 制方法,后续6个算法的实现均建立在其基础 4)事后经验回放:实验5实现了事后经验回 上。基于泛化值函数估计的方法认为智能体的策 放算法回,记为HER: 略和值函数与目标有关,G表示目标空间,g∈G 5)好奇心驱动:实验6实现了一种基于预测 表示目标,a为动作,s为状态,d严是策略π的采 差的前向动态算法[so,记为Forward Dynamics; 样分布,则DDPG with UVFA的损失函数分别为 6)分层强化学习:实验7实现了一种基于子 Ourge=r+1+yQ(S+1,T(S+1,g),8) 目标的分层强化学习算法,记为HDDPG。 Leritic=Es-d (Qunget-Q(s1,ag)) Lor=-E-eQ(S,π(S,g),g)】 Fetch Reach实验环境的任务是控制机械臂到 实验1比较了DDPG与随机策略(Random) 达目标位置,目标范围在空间中用小红球表示, 的表现,实验结果如图7所示。DDPG经过 如图6所示,当机械夹顶端碰到小红球即为达到 370个epoch的学习平均表现才超过随机策略, 目标。对于机器人的每步操作,完成目标获得奖 在500个epoch内最高平均成功率为21%。通过 励+1,否则获得奖励-1。实验测试中执行随机动 实验1,我们可以验证常规的深度强化学习算法 作5×10步,获得正奖励的概率仅为1.5%,因此 DDPG在稀疏奖励任务中学习缓慢。 本实验环境是典型的稀疏奖励环境。 100 ·DDPG -Random 60 40 20L 100 200300 400 500 训练Epoch数 图6 Fetch Reach实验环境 图7DDPG与随机动作成功率学习曲线 Fig.6 Fetch Reach environment Fig.7 Performance curve of DDPG and Random高层策略 中间层 策略 底层策略 子目标g′ 动作 环境 状态s 目标g 奖励r 子目标g′ 图 5 基于子目标的分层结构示意图 Fig. 5 Schematic of subgoal-based HRL methods 3 稀疏奖励算法实验 为了初步验证上述算法在稀疏奖励问题中作 用,我们在 MuJoCo 的机器人环境 Fetch Reach[18] 下分别实现了 6 类算法的代表性算法 (实验 2~7): 1) 奖励塑造:实验 2 实现了 Ng 等 [27] 提出的 势能函数差分形式的奖励塑造方法,记为 Reward Shaping; 2) 模仿学习:实验 3 实现了 Nair 等 [34] 提出的 行为克隆算法,记为 Behavior Clone; 3) 课程学习:实验 4 实现了符合 Bengio 等 [15] 定义的课程学习方法,记为 Curriculum Learning; 4) 事后经验回放:实验 5 实现了事后经验回 放算法[12] ,记为 HER; 5) 好奇心驱动:实验 6 实现了一种基于预测 差的前向动态算法[50] ,记为 Forward Dynamic; 6) 分层强化学习:实验 7 实现了一种基于子 目标的分层强化学习算法[54] ,记为 HDDPG。 +1 −1 5×104 Fetch Reach 实验环境的任务是控制机械臂到 达目标位置,目标范围在空间中用小红球表示, 如图 6 所示,当机械夹顶端碰到小红球即为达到 目标。对于机器人的每步操作,完成目标获得奖 励 ,否则获得奖励 。实验测试中执行随机动 作 步,获得正奖励的概率仅为 1.5%,因此 本实验环境是典型的稀疏奖励环境。 图 6 Fetch Reach 实验环境 Fig. 6 Fetch Reach environment 各实验均进行 10 次随机试验,去除最大最小 值绘制成功率均值标准差曲线,1 个 epoch 包括 100 局仿真,其余实验参数见表 1。 表 1 DDPG 参数 Table 1 DDPG Parameters 参数 值 优化器 Adam 学习率 0.001 折扣因子 γ 0.98 滑动平均比例 τ 0.05 网络全连接层数 3 隐层节点数 64 激活函数 Relu 输出层激活函数 tanh 动作噪声 N(0,0.1) 最大经验池大小 106 单次更新次数 40 batch大小 64 3.1 实验算法及结果 3.1.1 实验 1 DDPG G g ∈ G a s d π π 本实验采用的基线算法是基于泛化值函数估 计 [ 6 0 ] 的深度确定性策略梯度算 法 (DDPG) , DDPG 是代表性的基于 Actor-Critic 的连续动作控 制方法,后续 6 个算法的实现均建立在其基础 上。基于泛化值函数估计的方法认为智能体的策 略和值函数与目标有关, 表示目标空间, 表示目标, 为动作, 为状态, 是策略 的采 样分布,则 DDPG with UVFA 的损失函数分别为 Qtarget = rt+1 +γQ(st+1, π(st+1,g),g) Lcritic = Est∼d π ( Qtarget − Q(st ,at ,g) )2 Lactor = −Est∼d π [ Q(st , π(st ,g),g) ] 实验 1 比较了 DDPG 与随机策略 (Random) 的表现,实验结果如 图 7 所示。 DDP G 经 过 370 个 epoch 的学习平均表现才超过随机策略, 在 500 个 epoch 内最高平均成功率为 21%。通过 实验 1,我们可以验证常规的深度强化学习算法 DDPG 在稀疏奖励任务中学习缓慢。 100 DDPG Random 80 60 40 20 0 100 200 300 训练Epoch数 成功率/% 400 500 图 7 DDPG 与随机动作成功率学习曲线 Fig. 7 Performance curve of DDPG and Random 第 5 期 杨瑞,等:强化学习稀疏奖励算法研究——理论与实验 ·893·