正在加载图片...

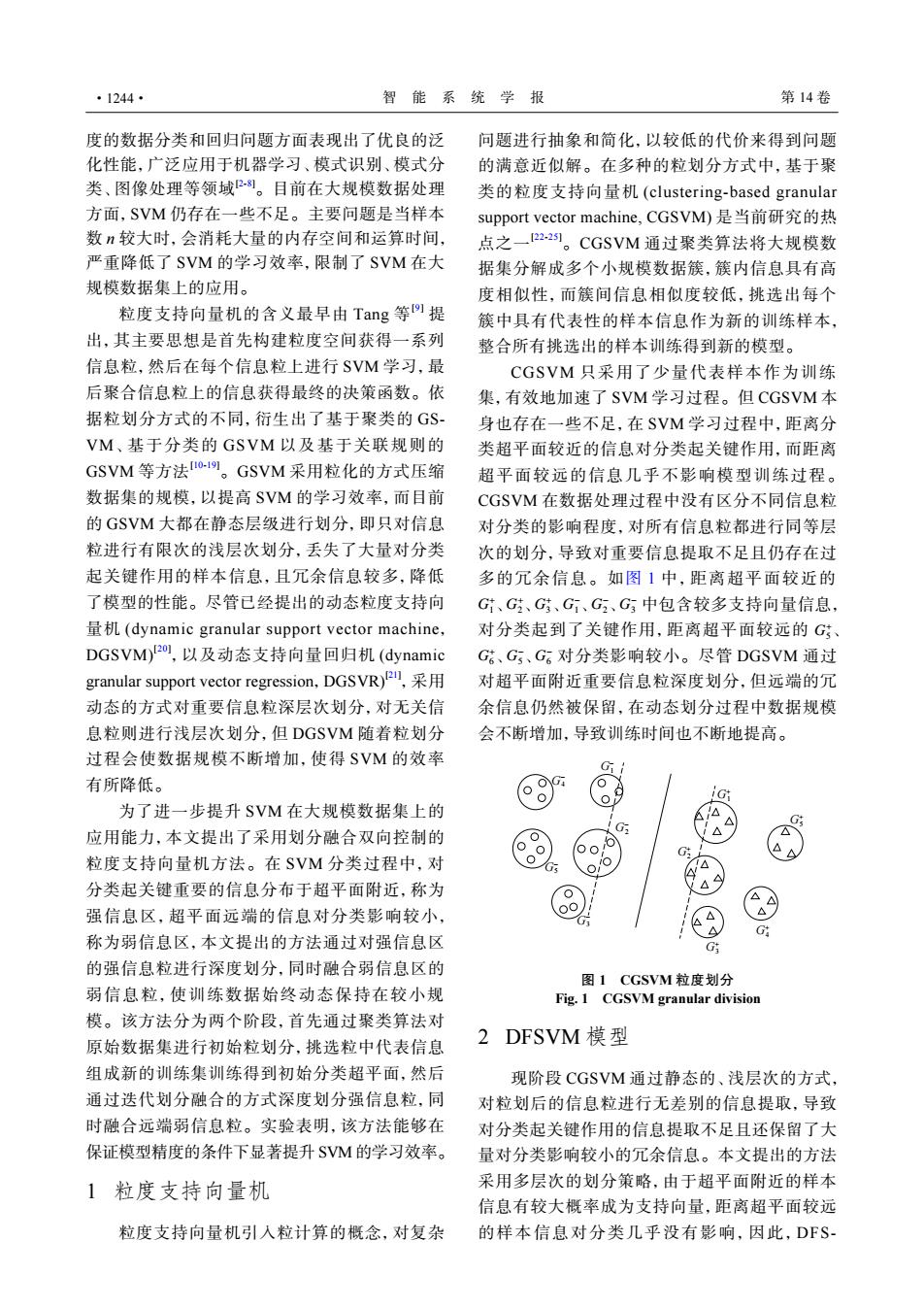

·1244· 智能系统学报 第14卷 度的数据分类和回归问题方面表现出了优良的泛 问题进行抽象和简化,以较低的代价来得到问题 化性能,广泛应用于机器学习、模式识别、模式分 的满意近似解。在多种的粒划分方式中,基于聚 类、图像处理等领域2。目前在大规模数据处理 类的粒度支持向量机(clustering-based granular 方面,SVM仍存在一些不足。主要问题是当样本 support vector machine,.CGSVM)是当前研究的热 数n较大时,会消耗大量的内存空间和运算时间, 点之一2-21。CGSVM通过聚类算法将大规模数 严重降低了SVM的学习效率,限制了SVM在大 据集分解成多个小规模数据簇,簇内信息具有高 规模数据集上的应用。 度相似性,而簇间信息相似度较低,挑选出每个 粒度支持向量机的含义最早由Tang等9提 簇中具有代表性的样本信息作为新的训练样本, 出,其主要思想是首先构建粒度空间获得一系列 整合所有挑选出的样本训练得到新的模型。 信息粒,然后在每个信息粒上进行SVM学习,最 CGSVM只采用了少量代表样本作为训练 后聚合信息粒上的信息获得最终的决策函数。依 集,有效地加速了SVM学习过程。但CGSVM本 据粒划分方式的不同,衍生出了基于聚类的GS- 身也存在一些不足,在SVM学习过程中,距离分 VM、基于分类的GSVM以及基于关联规则的 类超平面较近的信息对分类起关键作用,而距离 GSVM等方法o-19。GSVM采用粒化的方式压缩 超平面较远的信息几乎不影响模型训练过程。 数据集的规模,以提高SVM的学习效率,而目前 CGSVM在数据处理过程中没有区分不同信息粒 的GSVM大都在静态层级进行划分,即只对信息 对分类的影响程度,对所有信息粒都进行同等层 粒进行有限次的浅层次划分,丢失了大量对分类 次的划分,导致对重要信息提取不足且仍存在过 起关键作用的样本信息,且冗余信息较多,降低 多的冗余信息。如图1中,距离超平面较近的 了模型的性能。尽管已经提出的动态粒度支持向 G、G、G、G、G、G中包含较多支持向量信息, 量机(dynamic granular support vector machine, 对分类起到了关键作用,距离超平面较远的G、 DGSVM)2o,以及动态支持向量回归机(dynamic G;、G5、G6对分类影响较小。尽管DGSVM通过 granular support vector regression,DGSVR), 对超平面附近重要信息粒深度划分,但远端的冗 动态的方式对重要信息粒深层次划分,对无关信 余信息仍然被保留,在动态划分过程中数据规模 息粒则进行浅层次划分,但DGSVM随着粒划分 会不断增加,导致训练时间也不断地提高。 过程会使数据规模不断增加,使得SVM的效率 G 有所降低。 为了进一步提升SVM在大规模数据集上的 △ 应用能力,本文提出了采用划分融合双向控制的 △ 粒度支持向量机方法。在SVM分类过程中,对 A 分类起关键重要的信息分布于超平面附近,称为 强信息区,超平面远端的信息对分类影响较小, 00 G G 称为弱信息区,本文提出的方法通过对强信息区 G 的强信息粒进行深度划分,同时融合弱信息区的 图1 CGSVM粒度划分 弱信息粒,使训练数据始终动态保持在较小规 Fig.1 CGSVM granular division 模。该方法分为两个阶段,首先通过聚类算法对 2 原始数据集进行初始粒划分,挑选粒中代表信息 DFSVM模型 组成新的训练集训练得到初始分类超平面,然后 现阶段CGSVM通过静态的、浅层次的方式, 通过迭代划分融合的方式深度划分强信息粒,同 对粒划后的信息粒进行无差别的信息提取,导致 时融合远端弱信息粒。实验表明,该方法能够在 对分类起关键作用的信息提取不足且还保留了大 保证模型精度的条件下显著提升SVM的学习效率。 量对分类影响较小的冗余信息。本文提出的方法 1粒度支持向量机 采用多层次的划分策略,由于超平面附近的样本 信息有较大概率成为支持向量,距离超平面较远 粒度支持向量机引人粒计算的概念,对复杂 的样本信息对分类几乎没有影响,因此,DF$度的数据分类和回归问题方面表现出了优良的泛 化性能,广泛应用于机器学习、模式识别、模式分 类、图像处理等领域[2-8]。目前在大规模数据处理 方面,SVM 仍存在一些不足。主要问题是当样本 数 n 较大时,会消耗大量的内存空间和运算时间, 严重降低了 SVM 的学习效率,限制了 SVM 在大 规模数据集上的应用。 粒度支持向量机的含义最早由 Tang 等 [9] 提 出,其主要思想是首先构建粒度空间获得一系列 信息粒,然后在每个信息粒上进行 SVM 学习,最 后聚合信息粒上的信息获得最终的决策函数。依 据粒划分方式的不同,衍生出了基于聚类的 GSVM、基于分类的 GSVM 以及基于关联规则的 GSVM 等方法[10-19]。GSVM 采用粒化的方式压缩 数据集的规模,以提高 SVM 的学习效率,而目前 的 GSVM 大都在静态层级进行划分,即只对信息 粒进行有限次的浅层次划分,丢失了大量对分类 起关键作用的样本信息,且冗余信息较多,降低 了模型的性能。尽管已经提出的动态粒度支持向 量机 (dynamic granular support vector machine, DGSVM)[20] ,以及动态支持向量回归机 (dynamic granular support vector regression,DGSVR)[21] ,采用 动态的方式对重要信息粒深层次划分,对无关信 息粒则进行浅层次划分,但 DGSVM 随着粒划分 过程会使数据规模不断增加,使得 SVM 的效率 有所降低。 为了进一步提升 SVM 在大规模数据集上的 应用能力,本文提出了采用划分融合双向控制的 粒度支持向量机方法。在 SVM 分类过程中,对 分类起关键重要的信息分布于超平面附近,称为 强信息区,超平面远端的信息对分类影响较小, 称为弱信息区,本文提出的方法通过对强信息区 的强信息粒进行深度划分,同时融合弱信息区的 弱信息粒,使训练数据始终动态保持在较小规 模。该方法分为两个阶段,首先通过聚类算法对 原始数据集进行初始粒划分,挑选粒中代表信息 组成新的训练集训练得到初始分类超平面,然后 通过迭代划分融合的方式深度划分强信息粒,同 时融合远端弱信息粒。实验表明,该方法能够在 保证模型精度的条件下显著提升 SVM 的学习效率。 1 粒度支持向量机 粒度支持向量机引入粒计算的概念,对复杂 问题进行抽象和简化,以较低的代价来得到问题 的满意近似解。在多种的粒划分方式中,基于聚 类的粒度支持向量机 (clustering-based granular support vector machine, CGSVM) 是当前研究的热 点之一[22-25]。CGSVM 通过聚类算法将大规模数 据集分解成多个小规模数据簇,簇内信息具有高 度相似性,而簇间信息相似度较低,挑选出每个 簇中具有代表性的样本信息作为新的训练样本, 整合所有挑选出的样本训练得到新的模型。 G + 1 G + 2 G + 3 G − 1 G − 2 G − 3 G + 5 G + 6 G − 5 G − 6 CGSVM 只采用了少量代表样本作为训练 集,有效地加速了 SVM 学习过程。但 CGSVM 本 身也存在一些不足,在 SVM 学习过程中,距离分 类超平面较近的信息对分类起关键作用,而距离 超平面较远的信息几乎不影响模型训练过程。 CGSVM 在数据处理过程中没有区分不同信息粒 对分类的影响程度,对所有信息粒都进行同等层 次的划分,导致对重要信息提取不足且仍存在过 多的冗余信息。如图 1 中,距离超平面较近的 、 、 、 、 、 中包含较多支持向量信息, 对分类起到了关键作用,距离超平面较远的 、 、 、 对分类影响较小。尽管 DGSVM 通过 对超平面附近重要信息粒深度划分,但远端的冗 余信息仍然被保留,在动态划分过程中数据规模 会不断增加,导致训练时间也不断地提高。 G− 4 G− 1 G− 2 G− 5 G− 3 G+ 3 G+ 4 G+ 2 G+ 1 G+ 5 图 1 CGSVM 粒度划分 Fig. 1 CGSVM granular division 2 DFSVM 模型 现阶段 CGSVM 通过静态的、浅层次的方式, 对粒划后的信息粒进行无差别的信息提取,导致 对分类起关键作用的信息提取不足且还保留了大 量对分类影响较小的冗余信息。本文提出的方法 采用多层次的划分策略,由于超平面附近的样本 信息有较大概率成为支持向量,距离超平面较远 的样本信息对分类几乎没有影响,因此,DFS- ·1244· 智 能 系 统 学 报 第 14 卷