正在加载图片...

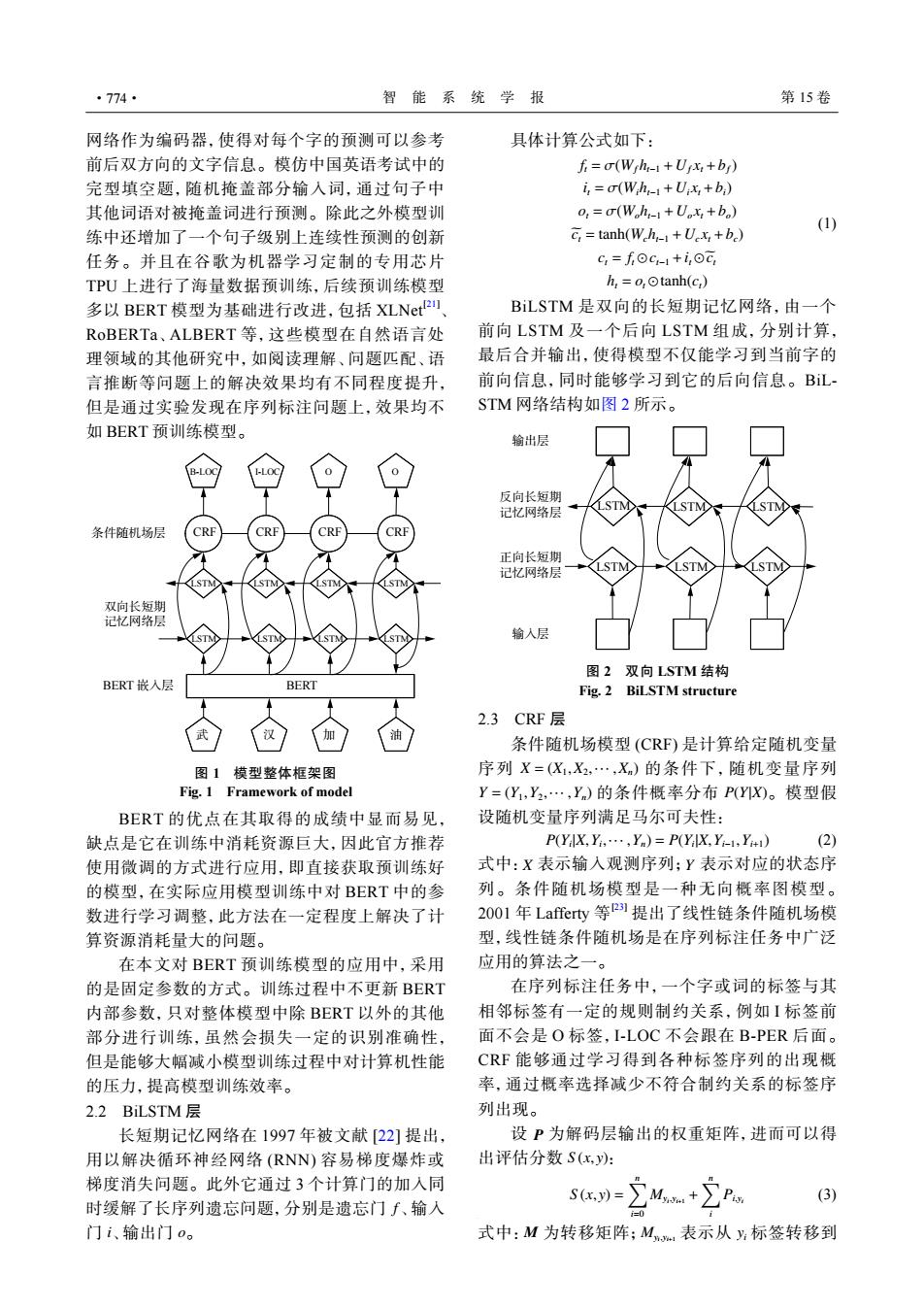

·774· 智能系统学报 第15卷 网络作为编码器,使得对每个字的预测可以参考 具体计算公式如下: 前后双方向的文字信息。模仿中国英语考试中的 fi=(Wjh-1+Uyx:+by) 完型填空题,随机掩盖部分输入词,通过句子中 i=(Wh1+Ux+b) 其他词语对被掩盖词进行预测。除此之外模型训 o,=o(Wh,-1+U。x,+b) C:tanh(Wh1+Ux:+be) (1) 练中还增加了一个句子级别上连续性预测的创新 任务。并且在谷歌为机器学习定制的专用芯片 c=foc-1+i,oc TPU上进行了海量数据预训练,后续预训练模型 h,=o,Otanh(c,) 多以BERT模型为基础进行改进,包括XLNet2 BiLSTM是双向的长短期记忆网络,由一个 RoBERTa、ALBERT等,这些模型在自然语言处 前向LSTM及一个后向LSTM组成,分别计算, 理领域的其他研究中,如阅读理解、问题匹配、语 最后合并输出,使得模型不仅能学习到当前字的 言推断等问题上的解决效果均有不同程度提升, 前向信息,同时能够学习到它的后向信息。BL 但是通过实验发现在序列标注问题上,效果均不 STM网络结构如图2所示。 如BERT预训练模型。 输出层 反向长短期 记忆网络层 条件随机场层 CRF 正向长短期 记忆网路层 双向长短期 记忆网络层 输人层 图2双向LSTM结构 BERT嵌入层 BERT Fig.2 BiLSTM structure 2.3CRF层 0 条件随机场模型(CRF)是计算给定随机变量 图1模型整体框架图 序列X=(X,X2,…,X)的条件下,随机变量序列 Fig.1 Framework of model Y=(Y,Y2,·,Y)的条件概率分布P(YX)。模型假 BERT的优点在其取得的成绩中显而易见, 设随机变量序列满足马尔可夫性: 缺点是它在训练中消耗资源巨大,因此官方推荐 P(YiX,Yi.....Y)=P(YilX.Yi1Yi) (2) 使用微调的方式进行应用,即直接获取预训练好 式中:X表示输人观测序列;Y表示对应的状态序 的模型,在实际应用模型训练中对BERT中的参 列。条件随机场模型是一种无向概率图模型。 数进行学习调整,此方法在一定程度上解决了计 2001年Lafferty等P提出了线性链条件随机场模 算资源消耗量大的问题。 型,线性链条件随机场是在序列标注任务中广泛 在本文对BERT预训练模型的应用中,采用 应用的算法之一。 的是固定参数的方式。训练过程中不更新BERT 在序列标注任务中,一个字或词的标签与其 内部参数,只对整体模型中除BERT以外的其他 相邻标签有一定的规则制约关系,例如I标签前 部分进行训练,虽然会损失一定的识别准确性, 面不会是O标签,I-LOC不会跟在B-PER后面。 但是能够大幅减小模型训练过程中对计算机性能 CRF能够通过学习得到各种标签序列的出现概 的压力,提高模型训练效率。 率,通过概率选择减少不符合制约关系的标签序 2.2 BiLSTM层 列出现。 长短期记忆网络在1997年被文献[22]提出, 设P为解码层输出的权重矩阵,进而可以得 用以解决循环神经网络(RNN)容易梯度爆炸或 出评估分数S(x,y): 梯度消失问题。此外它通过3个计算门的加入同 (3) 时缓解了长序列遗忘问题,分别是遗忘门∫、输入 Sx=∑M+∑P 门i、输出门o。 式中:M为转移矩阵;M,表示从标签转移到网络作为编码器,使得对每个字的预测可以参考 前后双方向的文字信息。模仿中国英语考试中的 完型填空题,随机掩盖部分输入词,通过句子中 其他词语对被掩盖词进行预测。除此之外模型训 练中还增加了一个句子级别上连续性预测的创新 任务。并且在谷歌为机器学习定制的专用芯片 TPU 上进行了海量数据预训练,后续预训练模型 多以 BERT 模型为基础进行改进,包括 XLNet[21] 、 RoBERTa、ALBERT 等,这些模型在自然语言处 理领域的其他研究中,如阅读理解、问题匹配、语 言推断等问题上的解决效果均有不同程度提升, 但是通过实验发现在序列标注问题上,效果均不 如 BERT 预训练模型。 LSTM LSTM 条件随机场层 双向长短期 记忆网络层 BERT 嵌入层 LSTM LSTM LSTM LSTM LSTM LSTM CRF CRF CRF CRF 武 汉 加 油 B-LOC I-LOC O O BERT 图 1 模型整体框架图 Fig. 1 Framework of model BERT 的优点在其取得的成绩中显而易见, 缺点是它在训练中消耗资源巨大,因此官方推荐 使用微调的方式进行应用,即直接获取预训练好 的模型,在实际应用模型训练中对 BERT 中的参 数进行学习调整,此方法在一定程度上解决了计 算资源消耗量大的问题。 在本文对 BERT 预训练模型的应用中,采用 的是固定参数的方式。训练过程中不更新 BERT 内部参数,只对整体模型中除 BERT 以外的其他 部分进行训练,虽然会损失一定的识别准确性, 但是能够大幅减小模型训练过程中对计算机性能 的压力,提高模型训练效率。 2.2 BiLSTM 层 f i o 长短期记忆网络在 1997 年被文献 [22] 提出, 用以解决循环神经网络 (RNN) 容易梯度爆炸或 梯度消失问题。此外它通过 3 个计算门的加入同 时缓解了长序列遗忘问题,分别是遗忘门 、输入 门 、输出门 。 具体计算公式如下: ft = σ(Wf ht−1 +Uf xt +bf) it = σ(Wiht−1 +Uixt +bi) ot = σ(Woht−1 +Uo xt +bo) cet = tanh(Wcht−1 +Uc xt +bc) ct = ft ⊙ct−1 +it ⊙ect ht = ot ⊙tanh(ct) (1) BiLSTM 是双向的长短期记忆网络,由一个 前向 LSTM 及一个后向 LSTM 组成,分别计算, 最后合并输出,使得模型不仅能学习到当前字的 前向信息,同时能够学习到它的后向信息。BiLSTM 网络结构如图 2 所示。 LSTM LSTM LSTM LSTM LSTM LSTM 输出层 反向长短期 记忆网络层 正向长短期 记忆网络层 输入层 图 2 双向 LSTM 结构 Fig. 2 BiLSTM structure 2.3 CRF 层 X = (X1,X2,··· ,Xn) Y = (Y1,Y2,··· ,Yn) P(Y|X) 条件随机场模型 (CRF) 是计算给定随机变量 序列 的条件下,随机变量序列 的条件概率分布 。模型假 设随机变量序列满足马尔可夫性: P(Yi |X,Yi ,··· ,Yn) = P(Yi |X,Yi−1,Yi+1) (2) 式中: X 表示输入观测序列; Y 表示对应的状态序 列。条件随机场模型是一种无向概率图模型。 2001 年 Lafferty 等 [23] 提出了线性链条件随机场模 型,线性链条件随机场是在序列标注任务中广泛 应用的算法之一。 在序列标注任务中,一个字或词的标签与其 相邻标签有一定的规则制约关系,例如 I 标签前 面不会是 O 标签,I-LOC 不会跟在 B-PER 后面。 CRF 能够通过学习得到各种标签序列的出现概 率,通过概率选择减少不符合制约关系的标签序 列出现。 P S (x, y) 设 为解码层输出的权重矩阵,进而可以得 出评估分数 : S (x, y) = ∑n i=0 Myi,yi+1 + ∑n i Pi,yi (3) M Myi,yi+1 式中: 为转移矩阵; 表示从 yi 标签转移到 ·774· 智 能 系 统 学 报 第 15 卷