正在加载图片...

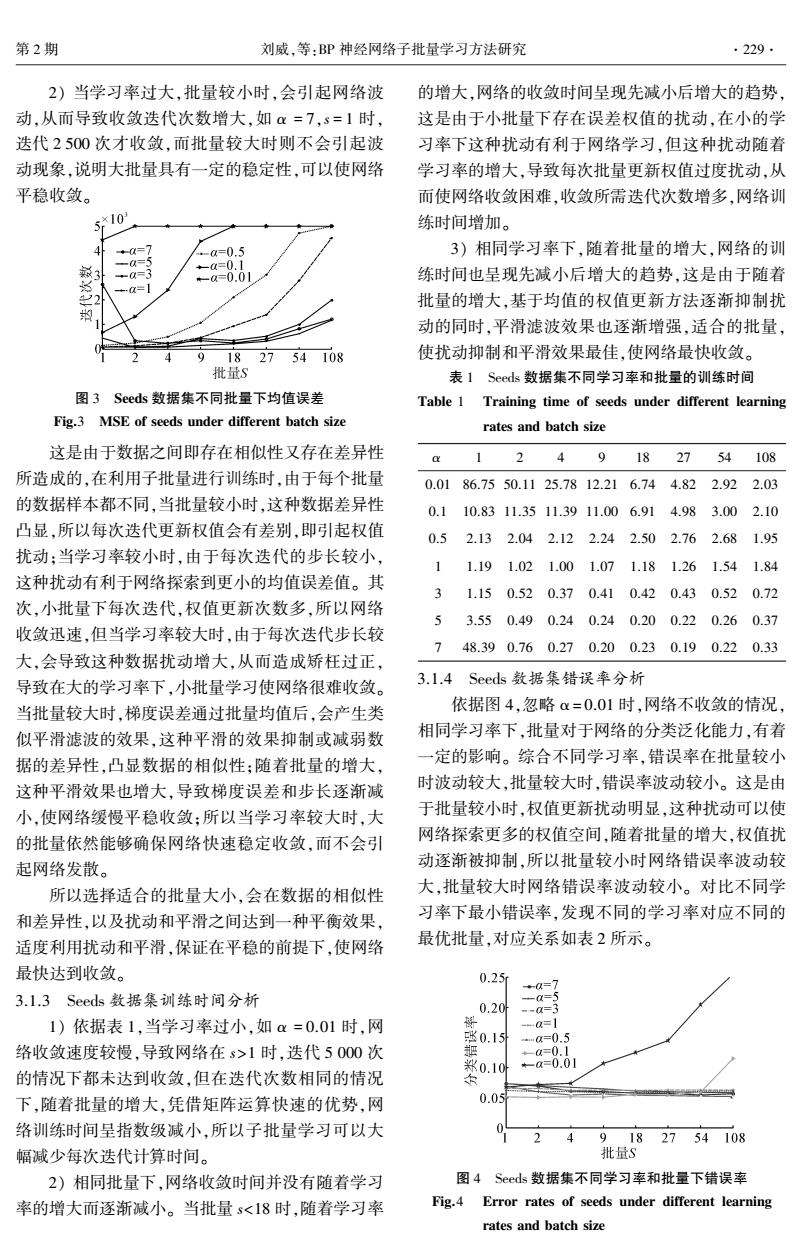

第2期 刘威,等:BP神经网络子批量学习方法研究 ·229. 2)当学习率过大,批量较小时,会引起网络波 的增大,网络的收敛时间呈现先减小后增大的趋势, 动,从而导致收敛迭代次数增大,如=7,s=1时, 这是由于小批量下存在误差权值的扰动,在小的学 迭代2500次才收敛,而批量较大时则不会引起波 习率下这种扰动有利于网络学习,但这种扰动随着 动现象,说明大批量具有一定的稳定性,可以使网络 学习率的增大,导致每次批量更新权值过度扰动,从 平稳收敛。 而使网络收敛困难,收敛所需迭代次数增多,网络训 ×10 练时间增加。 3)相同学习率下,随着批量的增大,网络的训 练时间也呈现先减小后增大的趋势,这是由于随着 批量的增大,基于均值的权值更新方法逐渐抑制扰 动的同时,平滑滤波效果也逐渐增强,适合的批量, 9182754108 使扰动抑制和平滑效果最佳,使网络最快收敛。 批量S 表1 Seeds数据集不同学习率和批量的训练时间 图3 Seeds数据集不同批量下均值误差 Table 1 Training time of seeds under different learning Fig.3 MSE of seeds under different batch size rates and batch size 这是由于数据之间即存在相似性又存在差异性 1 24 9182754108 所造成的,在利用子批量进行训练时,由于每个批量 0.0186.7550.1125.7812.216.744.822.922.03 的数据样本都不同,当批量较小时,这种数据差异性 0.1 10.8311.3511.3911.006.914.983.002.10 凸显,所以每次迭代更新权值会有差别,即引起权值 0.52.132.042.122.242.502.762.681.95 扰动:当学习率较小时,由于每次迭代的步长较小, 1.191.021.001.071.181.261.541.84 这种扰动有利于网络探索到更小的均值误差值。其 3 1.150.520.370.410.420.430.520.72 次,小批量下每次迭代,权值更新次数多,所以网络 5 3.550.490.240.240.200.220.260.37 收敛迅速,但当学习率较大时,由于每次迭代步长较 748.390.760.270.200.230.190.220.33 大,会导致这种数据扰动增大,从而造成矫枉过正, 导致在大的学习率下,小批量学习使网络很难收敛。 3.1.4 Seeds数据集错误率分析 当批量较大时,梯度误差通过批量均值后,会产生类 依据图4,忽略α=0.01时,网络不收敛的情况, 似平滑滤波的效果,这种平滑的效果抑制或减弱数 相同学习率下,批量对于网络的分类泛化能力,有着 据的差异性,凸显数据的相似性:随着批量的增大, 一定的影响。综合不同学习率,错误率在批量较小 这种平滑效果也增大,导致梯度误差和步长逐渐减 时波动较大,批量较大时,错误率波动较小。这是由 小,使网络缓慢平稳收敛:所以当学习率较大时,大 于批量较小时,权值更新扰动明显,这种扰动可以使 的批量依然能够确保网络快速稳定收敛,而不会引 网络探索更多的权值空间,随着批量的增大,权值扰 起网络发散。 动逐渐被抑制,所以批量较小时网络错误率波动较 所以选择适合的批量大小,会在数据的相似性 大,批量较大时网络错误率波动较小。对比不同学 和差异性,以及扰动和平滑之间达到一种平衡效果, 习率下最小错误率,发现不同的学习率对应不同的 适度利用扰动和平滑,保证在平稳的前提下,使网络 最优批量,对应关系如表2所示。 最快达到收敛。 0.25 3.1.3 Seeds数据集训练时间分析 0.20 a=3 1)依据表1,当学习率过小,如a=0.01时,网 张0.15 ma=0.5 络收敛速度较慢,导致网络在s>1时,迭代5000次 ◆-a=0.1 米0.10叶 +-a=0.01 的情况下都未达到收敛,但在迭代次数相同的情况 下,随着批量的增大,凭借矩阵运算快速的优势,网 0.05 络训练时间呈指数级减小,所以子批量学习可以大 24 9182754108 幅减少每次迭代计算时间。 批量S 2)相同批量下,网络收敛时间并没有随着学习 图4 Seeds数据集不同学习率和批量下错误率 率的增大而逐渐减小。当批量s<18时,随着学习率 Fig.4 Error rates of seeds under different learning rates and batch size2) 当学习率过大,批量较小时,会引起网络波 动,从而导致收敛迭代次数增大,如 α = 7,s = 1 时, 迭代 2 500 次才收敛,而批量较大时则不会引起波 动现象,说明大批量具有一定的稳定性,可以使网络 平稳收敛。 图 3 Seeds 数据集不同批量下均值误差 Fig.3 MSE of seeds under different batch size 这是由于数据之间即存在相似性又存在差异性 所造成的,在利用子批量进行训练时,由于每个批量 的数据样本都不同,当批量较小时,这种数据差异性 凸显,所以每次迭代更新权值会有差别,即引起权值 扰动;当学习率较小时,由于每次迭代的步长较小, 这种扰动有利于网络探索到更小的均值误差值。 其 次,小批量下每次迭代,权值更新次数多,所以网络 收敛迅速,但当学习率较大时,由于每次迭代步长较 大,会导致这种数据扰动增大,从而造成矫枉过正, 导致在大的学习率下,小批量学习使网络很难收敛。 当批量较大时,梯度误差通过批量均值后,会产生类 似平滑滤波的效果,这种平滑的效果抑制或减弱数 据的差异性,凸显数据的相似性;随着批量的增大, 这种平滑效果也增大,导致梯度误差和步长逐渐减 小,使网络缓慢平稳收敛;所以当学习率较大时,大 的批量依然能够确保网络快速稳定收敛,而不会引 起网络发散。 所以选择适合的批量大小,会在数据的相似性 和差异性,以及扰动和平滑之间达到一种平衡效果, 适度利用扰动和平滑,保证在平稳的前提下,使网络 最快达到收敛。 3.1.3 Seeds 数据集训练时间分析 1) 依据表 1,当学习率过小,如 α = 0.01 时,网 络收敛速度较慢,导致网络在 s>1 时,迭代 5 000 次 的情况下都未达到收敛,但在迭代次数相同的情况 下,随着批量的增大,凭借矩阵运算快速的优势,网 络训练时间呈指数级减小,所以子批量学习可以大 幅减少每次迭代计算时间。 2) 相同批量下,网络收敛时间并没有随着学习 率的增大而逐渐减小。 当批量 s<18 时,随着学习率 的增大,网络的收敛时间呈现先减小后增大的趋势, 这是由于小批量下存在误差权值的扰动,在小的学 习率下这种扰动有利于网络学习,但这种扰动随着 学习率的增大,导致每次批量更新权值过度扰动,从 而使网络收敛困难,收敛所需迭代次数增多,网络训 练时间增加。 3) 相同学习率下,随着批量的增大,网络的训 练时间也呈现先减小后增大的趋势,这是由于随着 批量的增大,基于均值的权值更新方法逐渐抑制扰 动的同时,平滑滤波效果也逐渐增强,适合的批量, 使扰动抑制和平滑效果最佳,使网络最快收敛。 表 1 Seeds 数据集不同学习率和批量的训练时间 Table 1 Training time of seeds under different learning rates and batch size α 1 2 4 9 18 27 54 108 0.01 86.75 50.11 25.78 12.21 6.74 4.82 2.92 2.03 0.1 10.83 11.35 11.39 11.00 6.91 4.98 3.00 2.10 0.5 2.13 2.04 2.12 2.24 2.50 2.76 2.68 1.95 1 1.19 1.02 1.00 1.07 1.18 1.26 1.54 1.84 3 1.15 0.52 0.37 0.41 0.42 0.43 0.52 0.72 5 3.55 0.49 0.24 0.24 0.20 0.22 0.26 0.37 7 48.39 0.76 0.27 0.20 0.23 0.19 0.22 0.33 3.1.4 Seeds 数据集错误率分析 依据图 4,忽略 α = 0.01 时,网络不收敛的情况, 相同学习率下,批量对于网络的分类泛化能力,有着 一定的影响。 综合不同学习率,错误率在批量较小 时波动较大,批量较大时,错误率波动较小。 这是由 于批量较小时,权值更新扰动明显,这种扰动可以使 网络探索更多的权值空间,随着批量的增大,权值扰 动逐渐被抑制,所以批量较小时网络错误率波动较 大,批量较大时网络错误率波动较小。 对比不同学 习率下最小错误率,发现不同的学习率对应不同的 最优批量,对应关系如表 2 所示。 图 4 Seeds 数据集不同学习率和批量下错误率 Fig.4 Error rates of seeds under different learning rates and batch size 第 2 期 刘威,等:BP 神经网络子批量学习方法研究 ·229·