正在加载图片...

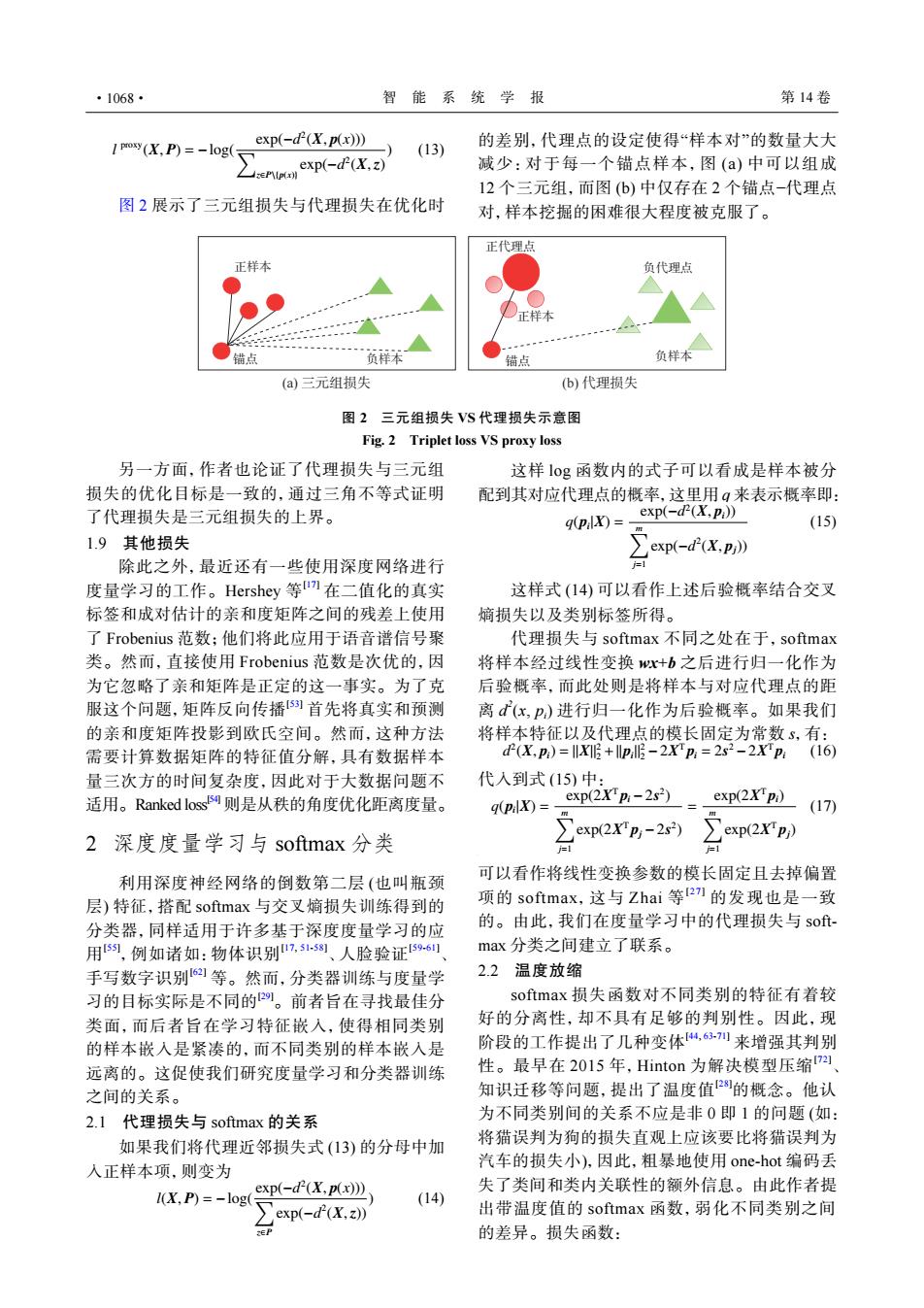

·1068· 智能系统学报 第14卷 1 PM(X.P)=-log( exp(-dP(X,px》 (13) 的差别,代理点的设定使得“样本对”的数量大大 ∑xp-fK,z 减少:对于每一个锚点样本,图(a)中可以组成 12个三元组,而图(b)中仅存在2个锚点-代理点 图2展示了三元组损失与代理损失在优化时 对,样本挖掘的困难很大程度被克服了。 正代理点 正样本 负代理点 D正样本 锚点 负样本 错点 负样本 (a)三元组损失 (b)代理损失 图2三元组损失VS代理损失示意图 Fig.2 Triplet loss VS proxy loss 另一方面,作者也论证了代理损失与三元组 这样10g函数内的式子可以看成是样本被分 损失的优化目标是一致的,通过三角不等式证明 配到其对应代理点的概率,这里用q来表示概率即: 了代理损失是三元组损失的上界。 g(pix)= exp(-d(X,Pi)) (15) 1.9其他损失 〉exp(-d(X,p) 除此之外,最近还有一些使用深度网络进行 度量学习的工作。Hershey等I在二值化的真实 这样式(14)可以看作上述后验概率结合交叉 标签和成对估计的亲和度矩阵之间的残差上使用 嫡损失以及类别标签所得。 了Frobenius范数;他们将此应用于语音谱信号聚 代理损失与softmax不同之处在于,softmax 类。然而,直接使用Frobenius范数是次优的,因 将样本经过线性变换wx+b之后进行归一化作为 为它忽略了亲和矩阵是正定的这一事实。为了克 后验概率,而此处则是将样本与对应代理点的距 服这个问题,矩阵反向传播5]首先将真实和预测 离d(x,p)进行归一化作为后验概率。如果我们 的亲和度矩阵投影到欧氏空间。然而,这种方法 将样本特征以及代理点的模长固定为常数s,有: 需要计算数据矩阵的特征值分解,具有数据样本 d(X.p)=+llpl-2Xp:=2s2-2Xp:(16) 量三次方的时间复杂度,因此对于大数据问题不 代入到式(15)中: 适用。Ranked loss则是从秩的角度优化距离度量。 9(pix)=- exp(2XTp:-2s2) exp(2X pi) (17) exp(2Xpj-2s2) 2深度度量学习与softmax分类 ∑exp2X'pD 利用深度神经网络的倒数第二层(也叫瓶颈 可以看作将线性变换参数的模长固定且去掉偏置 层)特征,搭配softmax与交叉熵损失训练得到的 项的softmax,这与Zhai等271的发现也是一致 分类器,同样适用于许多基于深度度量学习的应 的。由此,我们在度量学习中的代理损失与s0- 用s,例如诸如:物体识别7,ss、人脸验证596 max分类之间建立了联系。 手写数字识别61等。然而,分类器训练与度量学 2.2温度放缩 习的目标实际是不同的四。前者旨在寻找最佳分 softmax损失函数对不同类别的特征有着较 类面,而后者旨在学习特征嵌入,使得相同类别 好的分离性,却不具有足够的判别性。因此,现 的样本嵌入是紧凑的,而不同类别的样本嵌入是 阶段的工作提出了几种变体,63列来增强其判别 远离的。这促使我们研究度量学习和分类器训练 性。最早在2015年,Hinton为解决模型压缩7四 之间的关系。 知识迁移等问题,提出了温度值2的概念。他认 2.1代理损失与softmax的关系 为不同类别间的关系不应是非0即1的问题(如: 如果我们将代理近邻损失式(13)的分母中加 将猫误判为狗的损失直观上应该要比将猫误判为 入正样本项,则变为 汽车的损失小),因此,粗暴地使用one-hot编码丢 exp(-d(X.p(x))) 失了类间和类内关联性的额外信息。由此作者提 I(X,P)=-log (14) exp(-d(X.z)) 出带温度值的softmax函数,弱化不同类别之间 的差异。损失函数:l proxy(X, P) = −log( exp(−d 2 ∑ (X, p(x))) z∈P\{p(x)} exp(−d 2 (X,z) ) (13) 图 2 展示了三元组损失与代理损失在优化时 的差别,代理点的设定使得“样本对”的数量大大 减少:对于每一个锚点样本,图 (a) 中可以组成 12 个三元组,而图 (b) 中仅存在 2 个锚点−代理点 对,样本挖掘的困难很大程度被克服了。 锚点 锚点 正样本 正样本 正代理点 负样本 负样本 负代理点 (a) 三元组损失 (b) 代理损失 图 2 三元组损失 VS 代理损失示意图 Fig. 2 Triplet loss VS proxy loss 另一方面,作者也论证了代理损失与三元组 损失的优化目标是一致的,通过三角不等式证明 了代理损失是三元组损失的上界。 1.9 其他损失 除此之外,最近还有一些使用深度网络进行 度量学习的工作。Hershey 等 [17] 在二值化的真实 标签和成对估计的亲和度矩阵之间的残差上使用 了 Frobenius 范数;他们将此应用于语音谱信号聚 类。然而,直接使用 Frobenius 范数是次优的,因 为它忽略了亲和矩阵是正定的这一事实。为了克 服这个问题,矩阵反向传播[53] 首先将真实和预测 的亲和度矩阵投影到欧氏空间。然而,这种方法 需要计算数据矩阵的特征值分解,具有数据样本 量三次方的时间复杂度,因此对于大数据问题不 适用。Ranked loss[54] 则是从秩的角度优化距离度量。 2 深度度量学习与 softmax 分类 利用深度神经网络的倒数第二层 (也叫瓶颈 层) 特征,搭配 softmax 与交叉熵损失训练得到的 分类器,同样适用于许多基于深度度量学习的应 用 [55] ,例如诸如:物体识别[17, 51-58] 、人脸验证[59-61] 、 手写数字识别[62] 等。然而,分类器训练与度量学 习的目标实际是不同的[29]。前者旨在寻找最佳分 类面,而后者旨在学习特征嵌入,使得相同类别 的样本嵌入是紧凑的,而不同类别的样本嵌入是 远离的。这促使我们研究度量学习和分类器训练 之间的关系。 2.1 代理损失与 softmax 的关系 如果我们将代理近邻损失式 (13) 的分母中加 入正样本项,则变为 l(X, P) = −log( exp(−d 2 ∑ (X, p(x))) z∈P exp(−d 2 (X,z)) ) (14) 这样 log 函数内的式子可以看成是样本被分 配到其对应代理点的概率,这里用 q 来表示概率即: q(pi |X) = exp(−d 2 (X, pi)) ∑m j=1 exp(−d 2 (X, pj)) (15) 这样式 (14) 可以看作上述后验概率结合交叉 熵损失以及类别标签所得。 代理损失与 softmax 不同之处在于,softmax 将样本经过线性变换 wx+b 之后进行归一化作为 后验概率,而此处则是将样本与对应代理点的距 离 d 2 (x, pi ) 进行归一化作为后验概率。如果我们 将样本特征以及代理点的模长固定为常数 s,有: d 2 (X, pi) = ||X||2 2 +||pi ||2 2 −2X T pi = 2s 2 −2X T pi (16) 代入到式 (15) 中: q(pi |X) = exp(2X T pi −2s 2 ) ∑m j=1 exp(2X T pj −2s 2 ) = exp(2X T pi) ∑m j=1 exp(2X T pj) (17) 可以看作将线性变换参数的模长固定且去掉偏置 项的 softmax,这与 Zhai 等 [27] 的发现也是一致 的。由此,我们在度量学习中的代理损失与 softmax 分类之间建立了联系。 2.2 温度放缩 softmax 损失函数对不同类别的特征有着较 好的分离性,却不具有足够的判别性。因此,现 阶段的工作提出了几种变体[44, 63-71] 来增强其判别 性。最早在 2015 年,Hinton 为解决模型压缩[72] 、 知识迁移等问题,提出了温度值[28]的概念。他认 为不同类别间的关系不应是非 0 即 1 的问题 (如: 将猫误判为狗的损失直观上应该要比将猫误判为 汽车的损失小),因此,粗暴地使用 one-hot 编码丢 失了类间和类内关联性的额外信息。由此作者提 出带温度值的 softmax 函数,弱化不同类别之间 的差异。损失函数: ·1068· 智 能 系 统 学 报 第 14 卷