正在加载图片...

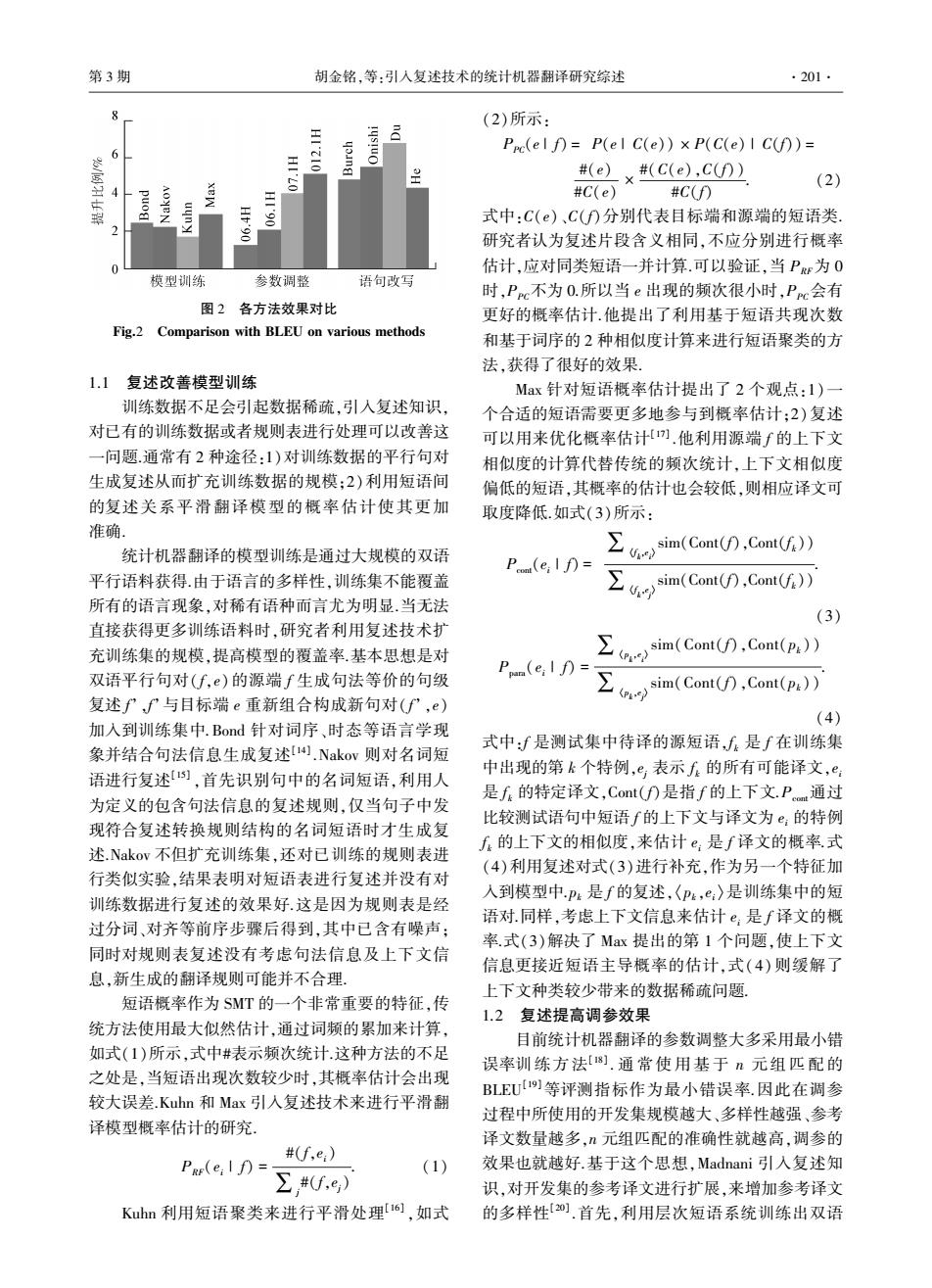

第3期 胡金铭,等:引入复述技术的统计机器翻译研究综述 ·201· (2)所示: 三 Pre(elf月=P(eIC(e))×P(C(e)ICf))= 6 三 #(e)x#(c(e),cD) (2) 尊 三 #C(e)#C(f) 式中:C(e)、C()分别代表目标端和源端的短语类 研究者认为复述片段含义相同,不应分别进行概率 0 估计,应对同类短语一并计算.可以验证,当P为0 模型训练 参数调整 语句改写 时,Ppc不为O.所以当e出现的频次很小时,Pc会有 图2各方法效果对比 更好的概率估计.他提出了利用基于短语共现次数 Fig.2 Comparison with BLEU on various methods 和基于词序的2种相似度计算来进行短语聚类的方 法,获得了很好的效果 1.1复述改善模型训练 Max针对短语概率估计提出了2个观点:1)一 训练数据不足会引起数据稀疏,引入复述知识, 个合适的短语需要更多地参与到概率估计:2)复述 对已有的训练数据或者规则表进行处理可以改善这 可以用来优化概率估计).他利用源端∫的上下文 一问题.通常有2种途径:1)对训练数据的平行句对 相似度的计算代替传统的频次统计,上下文相似度 生成复述从而扩充训练数据的规模:2)利用短语间 偏低的短语,其概率的估计也会较低,则相应译文可 的复述关系平滑翻译模型的概率估计使其更加 取度降低.如式(3)所示: 准确. 以 sim(Cont(f),Cont(f)) 统计机器翻译的模型训练是通过大规模的双语 Pom(e;I f)= 平行语料获得.由于语言的多样性,训练集不能覆盖 sim(Cont(f),Cont(f)) 所有的语言现象,对稀有语种而言尤为明显.当无法 (3) 直接获得更多训练语料时,研究者利用复述技术扩 充训练集的规模,提高模型的覆盖率.基本思想是对 w以 sim(Cont(f),Cont(p)) 双语平行句对(f,)的源端f生成句法等价的句级 P(e:I A= sim(Cont(f月,Cont(pk)) 复述fPP与目标端e重新组合构成新句对(fP,e) (4) 加入到训练集中.Bond针对词序、时态等语言学现 象并结合句法信息生成复述I4).Nakov则对名词短 式中:f是测试集中待译的源短语,f是∫在训练集 语进行复述,首先识别句中的名词短语,利用人 中出现的第k个特例,e,表示f的所有可能译文,e 是f的特定译文,Cont(f)是指f的上下文.P通过 为定义的包含句法信息的复述规则,仅当句子中发 比较测试语句中短语f的上下文与译文为e:的特例 现符合复述转换规则结构的名词短语时才生成复 f的上下文的相似度,来估计e:是f译文的概率.式 述.Nakov不但扩充训练集,还对已训练的规则表进 (4)利用复述对式(3)进行补充,作为另一个特征加 行类似实验,结果表明对短语表进行复述并没有对 训练数据进行复述的效果好.这是因为规则表是经 入到模型中p:是f的复述,〈P:,e:〉是训练集中的短 语对.同样,考虑上下文信息来估计e:是f译文的概 过分词、对齐等前序步骤后得到,其中已含有噪声; 率.式(3)解决了Max提出的第1个问题,使上下文 同时对规则表复述没有考虑句法信息及上下文信 信息更接近短语主导概率的估计,式(4)则缓解了 息,新生成的翻译规则可能并不合理。 上下文种类较少带来的数据稀疏问题, 短语概率作为SMT的一个非常重要的特征,传 1.2复述提高调参效果 统方法使用最大似然估计,通过词频的累加来计算, 目前统计机器翻译的参数调整大多采用最小错 如式(1)所示,式中#表示频次统计.这种方法的不足 误率训练方法[18].通常使用基于n元组匹配的 之处是,当短语出现次数较少时,其概率估计会出现 BLEU]等评测指标作为最小错误率.因此在调参 较大误差.Kuhn和Max引入复述技术来进行平滑翻 过程中所使用的开发集规模越大、多样性越强、参考 译模型概率估计的研究。 译文数量越多,n元组匹配的准确性就越高,调参的 #(f,e:) PRF(e:IA)=- (1) 效果也就越好.基于这个思想,Madnani引入复述知 ∑#(f,e) 识,对开发集的参考译文进行扩展,来增加参考译文 Kuhn利用短语聚类来进行平滑处理o],如式 的多样性2).首先,利用层次短语系统训练出双语图 2 各方法效果对比 Fig.2 Comparison with BLEU on various methods 1.1 复述改善模型训练 训练数据不足会引起数据稀疏,引入复述知识, 对已有的训练数据或者规则表进行处理可以改善这 一问题.通常有 2 种途径:1)对训练数据的平行句对 生成复述从而扩充训练数据的规模;2)利用短语间 的复述关系平滑翻译模型的概率估计使其更加 准确. 统计机器翻译的模型训练是通过大规模的双语 平行语料获得.由于语言的多样性,训练集不能覆盖 所有的语言现象,对稀有语种而言尤为明显.当无法 直接获得更多训练语料时,研究者利用复述技术扩 充训练集的规模,提高模型的覆盖率.基本思想是对 双语平行句对( f,e)的源端 f 生成句法等价的句级 复述 f’,f’与目标端 e 重新组合构成新句对( f’,e) 加入到训练集中.Bond 针对词序、时态等语言学现 象并结合句法信息生成复述[14] .Nakov 则对名词短 语进行复述[15] ,首先识别句中的名词短语,利用人 为定义的包含句法信息的复述规则,仅当句子中发 现符合复述转换规则结构的名词短语时才生成复 述.Nakov 不但扩充训练集,还对已训练的规则表进 行类似实验,结果表明对短语表进行复述并没有对 训练数据进行复述的效果好.这是因为规则表是经 过分词、对齐等前序步骤后得到,其中已含有噪声; 同时对规则表复述没有考虑句法信息及上下文信 息,新生成的翻译规则可能并不合理. 短语概率作为 SMT 的一个非常重要的特征,传 统方法使用最大似然估计,通过词频的累加来计算, 如式(1)所示,式中#表示频次统计.这种方法的不足 之处是,当短语出现次数较少时,其概率估计会出现 较大误差.Kuhn 和 Max 引入复述技术来进行平滑翻 译模型概率估计的研究. PRF(ei | f) = #(f,ei) ∑j #(f,ej) . (1) Kuhn 利用短语聚类来进行平滑处理[16] ,如式 (2)所示: PPC(e | f) = P(e | C(e)) × P(C(e) | C(f)) = #(e) #C(e) × #(C(e),C(f)) #C(f) . (2) 式中:C(e)、C(f)分别代表目标端和源端的短语类. 研究者认为复述片段含义相同,不应分别进行概率 估计,应对同类短语一并计算.可以验证,当 PRF为 0 时,PPC不为 0.所以当 e 出现的频次很小时,PPC会有 更好的概率估计.他提出了利用基于短语共现次数 和基于词序的 2 种相似度计算来进行短语聚类的方 法,获得了很好的效果. Max 针对短语概率估计提出了 2 个观点:1)一 个合适的短语需要更多地参与到概率估计;2)复述 可以用来优化概率估计[17] .他利用源端 f 的上下文 相似度的计算代替传统的频次统计,上下文相似度 偏低的短语,其概率的估计也会较低,则相应译文可 取度降低.如式(3)所示: Pcont(ei | f) = ∑〈f k ,e i 〉 sim(Cont(f),Cont(f k)) ∑〈f k ,e j 〉 sim(Cont(f),Cont(f k)) . (3) Ppara(ei | f) = ∑〈p k ,e i 〉 sim(Cont(f),Cont(pk)) ∑〈p k ,e j 〉 sim(Cont(f),Cont(pk)) . (4) 式中:f 是测试集中待译的源短语,f k 是 f 在训练集 中出现的第 k 个特例,ej 表示 f k 的所有可能译文,ei 是 f k 的特定译文,Cont(f)是指 f 的上下文.Pcont通过 比较测试语句中短语 f 的上下文与译文为 ei 的特例 f k 的上下文的相似度,来估计 ei 是 f 译文的概率.式 (4)利用复述对式(3)进行补充,作为另一个特征加 入到模型中.pk 是 f 的复述,〈pk,ei〉是训练集中的短 语对.同样,考虑上下文信息来估计 ei 是 f 译文的概 率.式(3)解决了 Max 提出的第 1 个问题,使上下文 信息更接近短语主导概率的估计,式(4) 则缓解了 上下文种类较少带来的数据稀疏问题. 1.2 复述提高调参效果 目前统计机器翻译的参数调整大多采用最小错 误率训练方 法[18] . 通 常 使 用 基 于 n 元 组 匹 配 的 BLEU [19]等评测指标作为最小错误率.因此在调参 过程中所使用的开发集规模越大、多样性越强、参考 译文数量越多,n 元组匹配的准确性就越高,调参的 效果也就越好.基于这个思想,Madnani 引入复述知 识,对开发集的参考译文进行扩展,来增加参考译文 的多样性[20] .首先,利用层次短语系统训练出双语 第 3 期 胡金铭,等:引入复述技术的统计机器翻译研究综述 ·201·