正在加载图片...

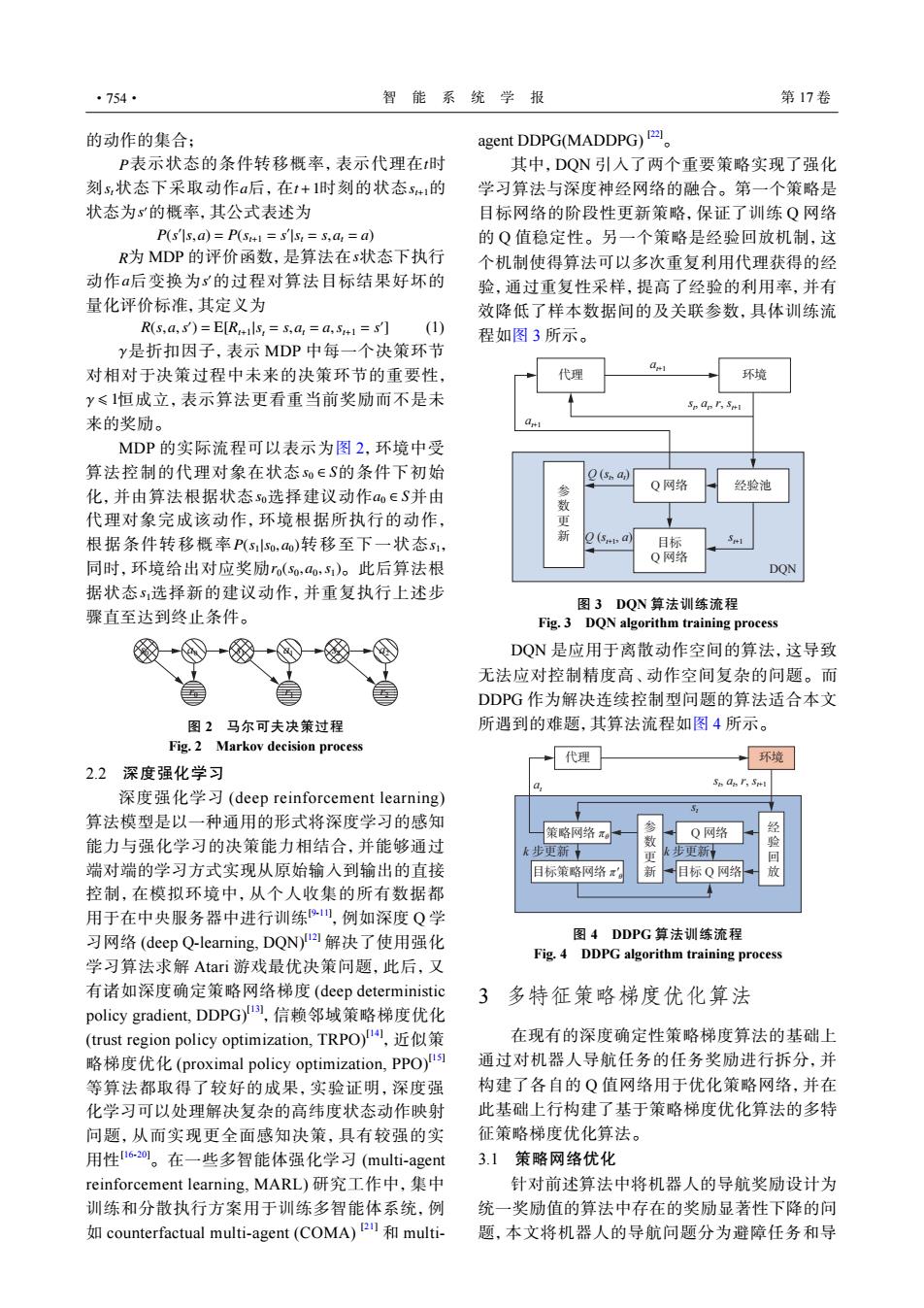

·754· 智能系统学报 第17卷 的动作的集合: agent DDPG(MADDPG)☒ P表示状态的条件转移概率,表示代理在t时 其中,DQN引入了两个重要策略实现了强化 刻s,状态下采取动作a后,在t+1时刻的状态s41的 学习算法与深度神经网络的融合。第一个策略是 状态为s的概率,其公式表述为 目标网络的阶段性更新策略,保证了训练Q网络 P(s'ls,a)=P(st=s'ls:=s,a=a) 的Q值稳定性。另一个策略是经验回放机制,这 R为MDP的评价函数,是算法在s状态下执行 个机制使得算法可以多次重复利用代理获得的经 动作a后变换为s的过程对算法目标结果好坏的 验,通过重复性采样,提高了经验的利用率,并有 量化评价标准,其定义为 效降低了样本数据间的及关联参数,具体训练流 R(s,a,)=E[R4is,=S,a,=a,S41=](I) 程如图3所示。 y是折扣因子,表示MDP中每一个决策环节 对相对于决策过程中未来的决策环节的重要性, 代理 环境 y≤1恒成立,表示算法更看重当前奖励而不是未 Sp an Sui 来的奖励。 MDP的实际流程可以表示为图2,环境中受 算法控制的代理对象在状态so∈S的条件下初始 O(s a) 经验池 化,并由算法根据状态so选择建议动作ao∈S并由 Q网络 数 代理对象完成该动作,环境根据所执行的动作, 更 根据条件转移概率P(slso,ao)转移至下一状态s1, () 目标 Q网络 同时,环境给出对应奖励ro(so,ao,s)。此后算法根 DQN 据状态5选择新的建议动作,并重复执行上述步 图3DQN算法训练流程 骤直至达到终止条件。 Fig.3 DQN algorithm training process DQN是应用于离散动作空间的算法,这导致 无法应对控制精度高、动作空间复杂的问题。而 DDPG作为解决连续控制型问题的算法适合本文 图2马尔可夫决策过程 所遇到的难题,其算法流程如图4所示。 Fig.2 Markov decision process 代理 环境 2.2深度强化学习 Sn an r,Sw 深度强化学习(deep reinforcement learning) 算法模型是以一种通用的形式将深度学习的感知 + 策略网络π口 Q网络 经 能力与强化学习的决策能力相结合,并能够通过 k步更新】 步更新 端对端的学习方式实现从原始输入到输出的直接 目标策略网络 新 目标Q网络 控制,在模拟环境中,从个人收集的所有数据都 用于在中央服务器中进行训练",例如深度Q学 习网络(deep Q-learning,DQN)2解决了使用强化 图4DDPG算法训练流程 Fig.4 DDPG algorithm training process 学习算法求解Atari游戏最优决策问题,此后,又 有诸如深度确定策略网络梯度(deep deterministic 3多特征策略梯度优化算法 policy gradient,.DDPG)l),信赖邻域策略梯度优化 (trust region policy optimization,TRPO)l,近似策 在现有的深度确定性策略梯度算法的基础上 略梯度优化(proximal policy optimization,PPO)l 通过对机器人导航任务的任务奖励进行拆分,并 等算法都取得了较好的成果,实验证明,深度强 构建了各自的Q值网络用于优化策略网络,并在 化学习可以处理解决复杂的高纬度状态动作映射 此基础上行构建了基于策略梯度优化算法的多特 问题,从而实现更全面感知决策,具有较强的实 征策略梯度优化算法。 用性i6-20。在一些多智能体强化学习(multi-agent 3.1策略网络优化 reinforcement learning,MARL)研究工作中,集中 针对前述算法中将机器人的导航奖励设计为 训练和分散执行方案用于训练多智能体系统,例 统一奖励值的算法中存在的奖励显著性下降的问 counterfactual multi-agent (COMA)multi- 题,本文将机器人的导航问题分为避障任务和导的动作的集合; P t st a t+1 st+1 s ′ 表示状态的条件转移概率,表示代理在 时 刻 状态下采取动作 后,在 时刻的状态 的 状态为 的概率,其公式表述为 P(s ′ |s,a) = P(st+1 = s ′ |st = s,at = a) R s a s ′ 为 MDP 的评价函数,是算法在 状态下执行 动作 后变换为 的过程对算法目标结果好坏的 量化评价标准,其定义为 R(s,a,s ′ ) = E[Rt+1 |st = s,at = a,st+1 = s ′ ] (1) γ γ ⩽ 1 是折扣因子,表示 MDP 中每一个决策环节 对相对于决策过程中未来的决策环节的重要性, 恒成立,表示算法更看重当前奖励而不是未 来的奖励。 s0 ∈ S s0 a0 ∈ S P(s1|s0,a0) s1 r0(s0,a0,s1) s1 MDP 的实际流程可以表示为图 2,环境中受 算法控制的代理对象在状态 的条件下初始 化,并由算法根据状态 选择建议动作 并由 代理对象完成该动作,环境根据所执行的动作, 根据条件转移概率 转移至下一状态 , 同时,环境给出对应奖励 。此后算法根 据状态 选择新的建议动作,并重复执行上述步 骤直至达到终止条件。 s0 a0 s1 a1 s2 r0 r1 r2 a2 图 2 马尔可夫决策过程 Fig. 2 Markov decision process 2.2 深度强化学习 深度强化学习 (deep reinforcement learning) 算法模型是以一种通用的形式将深度学习的感知 能力与强化学习的决策能力相结合,并能够通过 端对端的学习方式实现从原始输入到输出的直接 控制,在模拟环境中,从个人收集的所有数据都 用于在中央服务器中进行训练[9-11] ,例如深度 Q 学 习网络 (deep Q-learning, DQN)[12] 解决了使用强化 学习算法求解 Atari 游戏最优决策问题,此后,又 有诸如深度确定策略网络梯度 (deep deterministic policy gradient, DDPG)[13] ,信赖邻域策略梯度优化 (trust region policy optimization, TRPO)[14] ,近似策 略梯度优化 (proximal policy optimization, PPO)[15] 等算法都取得了较好的成果,实验证明,深度强 化学习可以处理解决复杂的高纬度状态动作映射 问题,从而实现更全面感知决策,具有较强的实 用性[16-20]。在一些多智能体强化学习 (multi-agent reinforcement learning, MARL) 研究工作中,集中 训练和分散执行方案用于训练多智能体系统,例 如 counterfactual multi-agent (COMA) [21] 和 multiagent DDPG(MADDPG) [22]。 其中,DQN 引入了两个重要策略实现了强化 学习算法与深度神经网络的融合。第一个策略是 目标网络的阶段性更新策略,保证了训练 Q 网络 的 Q 值稳定性。另一个策略是经验回放机制,这 个机制使得算法可以多次重复利用代理获得的经 验,通过重复性采样,提高了经验的利用率,并有 效降低了样本数据间的及关联参数,具体训练流 程如图 3 所示。 代理 环境 at+1 st+1 at+1 Q 网络 目标 Q 网络 参 经验池 数 更 新 DQN st , at , r, st+1 Q (st , at ) Q (st+1, a) 图 3 DQN 算法训练流程 Fig. 3 DQN algorithm training process DQN 是应用于离散动作空间的算法,这导致 无法应对控制精度高、动作空间复杂的问题。而 DDPG 作为解决连续控制型问题的算法适合本文 所遇到的难题,其算法流程如图 4 所示。 代理 环境 at st st , at , r, st+1 策略网络 πθ 目标策略网络 π'θ 参 数 更 新 经 验 回 放 Q 网络 目标 Q 网络 k 步更新 k 步更新 图 4 DDPG 算法训练流程 Fig. 4 DDPG algorithm training process 3 多特征策略梯度优化算法 在现有的深度确定性策略梯度算法的基础上 通过对机器人导航任务的任务奖励进行拆分,并 构建了各自的 Q 值网络用于优化策略网络,并在 此基础上行构建了基于策略梯度优化算法的多特 征策略梯度优化算法。 3.1 策略网络优化 针对前述算法中将机器人的导航奖励设计为 统一奖励值的算法中存在的奖励显著性下降的问 题,本文将机器人的导航问题分为避障任务和导 ·754· 智 能 系 统 学 报 第 17 卷