正在加载图片...

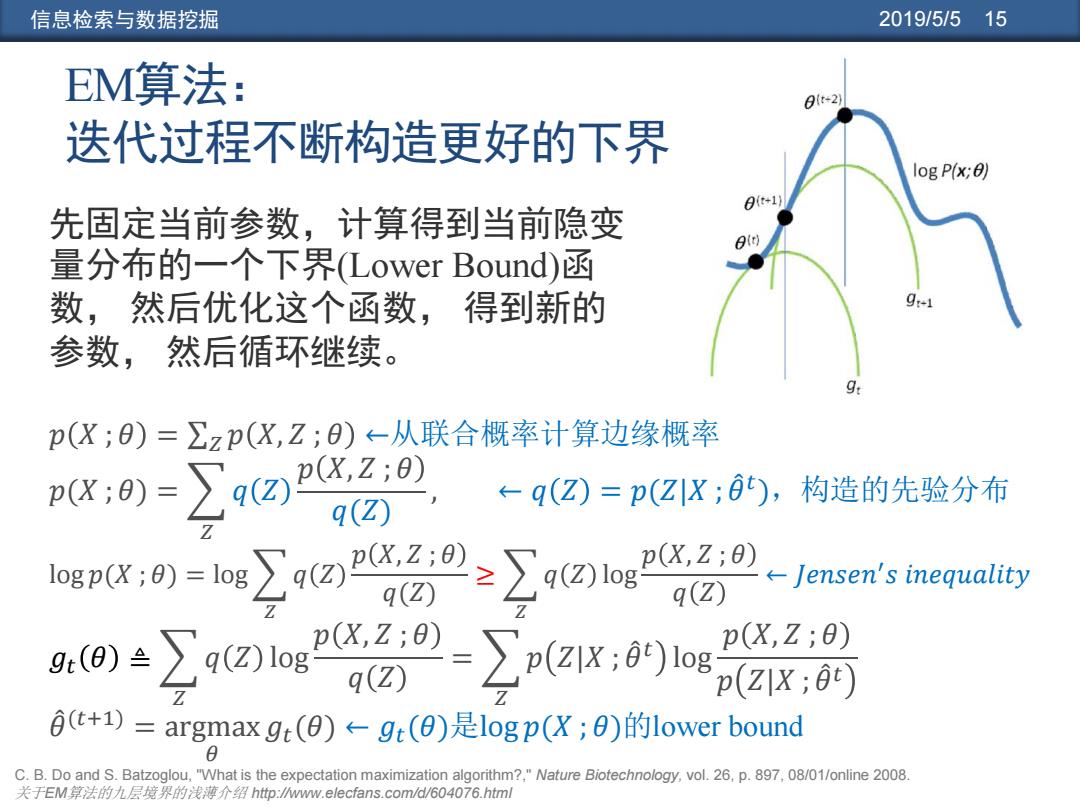

信息检索与数据挖掘 2019/5/515 EM算法: 01t-2) 迭代过程不断构造更好的下 log P(x;0) 先固定当前参数,计算得到当前隐变 量分布的一个下界(Lower Bound)函 数,然后优化这个函数,得到新的 参数,然后循环继续。 g: p(X;)=∑zp(X,Z;)-从联合概率计算边缘概率 pX;9)=∑q2 px2:0) ←- q(Z) q(Z)=p(ZX;0), 构造的先验分布 p(X,Z;8) -Jensen's inequality q (Z o÷∑4t☒iog2”29-∑pax6s p(X,Z;0) p(zx;0t) 0t+1)=argmax gt(0)←gt(0)是logp(X;0)的1 ower bound C.B.Do and S.Batzoglou,"What is the expectation maximization algorithm?,"Nature Biotechnology,vol.26,p.897,08/01/online 2008. 关于EM算法的九层境界的浅薄介绍htp:wwmw.elecfans.comd/604076.html信息检索与数据挖掘 2019/5/5 15 𝑝 𝑋 ; 𝜃 = σ𝑍 𝑝 𝑋, 𝑍 ; 𝜃 ←从联合概率计算边缘概率 𝑝(𝑋 ; 𝜃) = 𝑍 𝑞 𝑍 𝑝 𝑋, 𝑍 ; 𝜃 𝑞(𝑍) , ← 𝑞 𝑍 = 𝑝(𝑍|𝑋 ; 𝜃መ 𝑡 ),构造的先验分布 log 𝑝(𝑋 ; 𝜃) = log 𝑍 𝑞 𝑍 𝑝 𝑋, 𝑍 ; 𝜃 𝑞(𝑍) ≥ 𝑍 𝑞 𝑍 log 𝑝 𝑋, 𝑍 ; 𝜃 𝑞 𝑍 ← 𝐽𝑒𝑛𝑠𝑒𝑛 ′ 𝑠 𝑖𝑛𝑒𝑞𝑢𝑎𝑙𝑖𝑡𝑦 𝑔𝑡 𝜃 ≜ 𝑍 𝑞 𝑍 log 𝑝 𝑋, 𝑍 ; 𝜃 𝑞 𝑍 = 𝑍 𝑝 𝑍|𝑋 ; 𝜃መ 𝑡 log 𝑝 𝑋, 𝑍 ; 𝜃 𝑝 𝑍|𝑋 ; 𝜃መ 𝑡 𝜃መ (𝑡+1) = argmax 𝜃 𝑔𝑡(𝜃) ← 𝑔𝑡(𝜃)是log 𝑝(𝑋 ; 𝜃)的lower bound EM算法: 迭代过程不断构造更好的下界 先固定当前参数,计算得到当前隐变 量分布的一个下界(Lower Bound)函 数, 然后优化这个函数, 得到新的 参数, 然后循环继续。 C. B. Do and S. Batzoglou, "What is the expectation maximization algorithm?," Nature Biotechnology, vol. 26, p. 897, 08/01/online 2008. 关于EM算法的九层境界的浅薄介绍 http://www.elecfans.com/d/604076.html