正在加载图片...

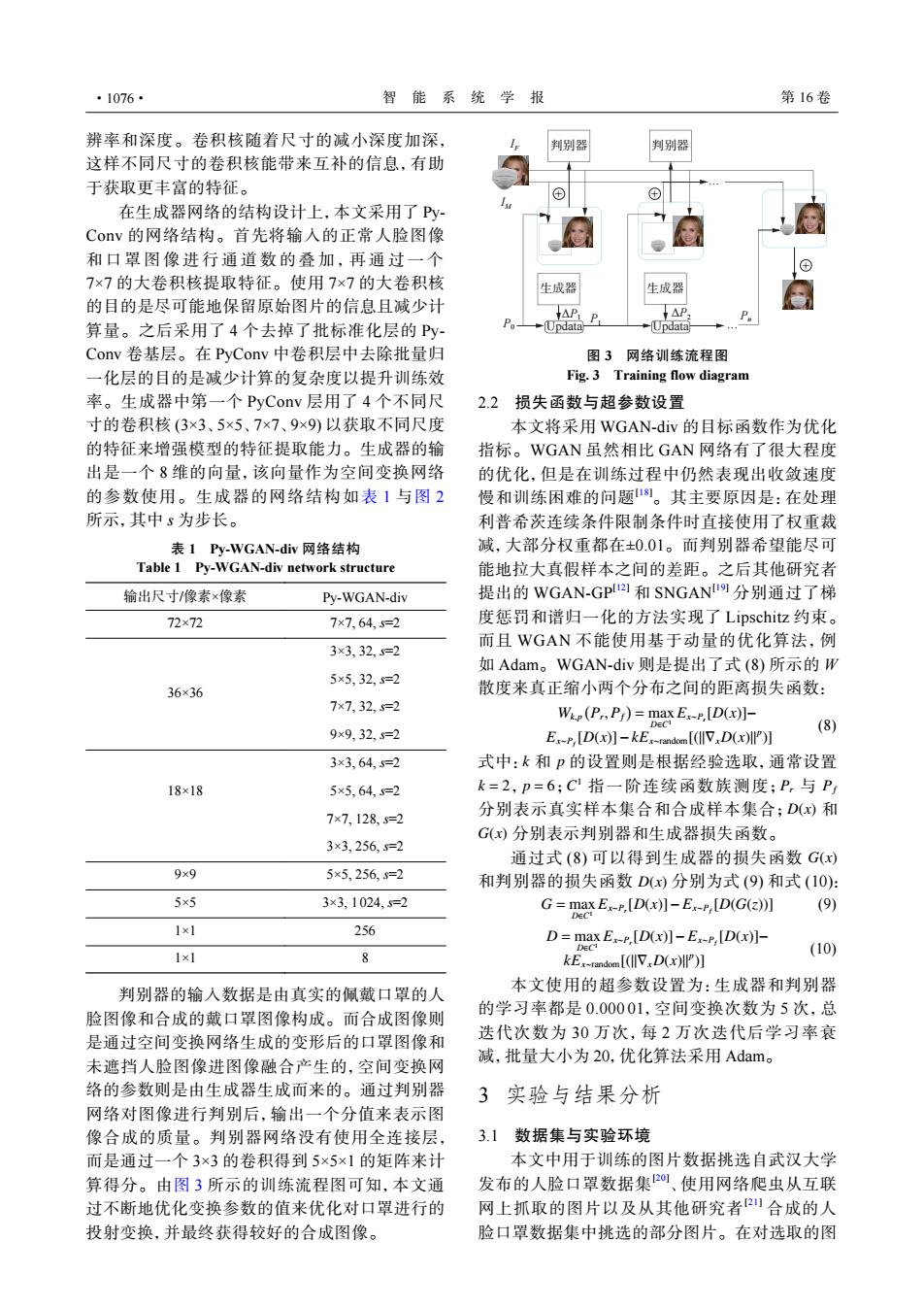

·1076· 智能系统学报 第16卷 辨率和深度。卷积核随着尺寸的减小深度加深, 判别器 判别器 这样不同尺寸的卷积核能带来互补的信息,有助 于获取更丰富的特征。 在生成器网络的结构设计上,本文采用了Py Conv的网络结构。首先将输入的正常人脸图像 和口罩图像进行通道数的叠加,再通过一个 7×7的大卷积核提取特征。使用7×7的大卷积核 生成器 生成器 的目的是尽可能地保留原始图片的信息且减少计 P AP 算量。之后采用了4个去掉了批标准化层的Py- -(Updata -Updata Conv卷基层。在PyConv中卷积层中去除批量归 图3网络训练流程图 一化层的目的是减少计算的复杂度以提升训练效 Fig.3 Training flow diagram 率。生成器中第一个PyConv层用了4个不同尺 2.2 损失函数与超参数设置 寸的卷积核(3×3、5×5、7×7、9×9)以获取不同尺度 本文将采用WGAN-div的目标函数作为优化 的特征来增强模型的特征提取能力。生成器的输 指标。WGAN虽然相比GAN网络有了很大程度 出是一个8维的向量,该向量作为空间变换网络 的优化,但是在训练过程中仍然表现出收敛速度 的参数使用。生成器的网络结构如表1与图2 慢和训练困难的问题。其主要原因是:在处理 所示,其中s为步长。 利普希茨连续条件限制条件时直接使用了权重裁 表1Py-WGAN-div网络结构 减,大部分权重都在0.01。而判别器希望能尽可 Table 1 Py-WGAN-div network structure 能地拉大真假样本之间的差距。之后其他研究者 输出尺寸/像素×像素 Py-WGAN-div 提出的WGAN-GPI和SNGANU9分别通过了梯 72×72 7×7,64,5=2 度惩罚和谱归一化的方法实现了Lipschitz约束。 而且WGAN不能使用基于动量的优化算法,例 3×3,32,5=2 如Adam。WGAN-div则是提出了式(8)所示的W 5×5,32s=2 36×36 散度来真正缩小两个分布之间的距离损失函数: 7×7,32,s=2 Wip(PP)=max E:-F,[D(x)]- 9×9,32,5=2 (8) E-F,[D(x)]-kEx-rdom [(lV,D(x)l)] 3×3,64,5=2 式中:k和p的设置则是根据经验选取,通常设置 18×18 5×5,64,5=2 k=2,p=6;C指一阶连续函数族测度;P,与P 7×7,128.s=2 分别表示真实样本集合和合成样本集合;D(x)和 G(x)分别表示判别器和生成器损失函数。 3×3,256,s=2 通过式(8)可以得到生成器的损失函数G(x) 9x9 5×5,256.s=2 和判别器的损失函数D()分别为式(9)和式(10): 5x5 3×3,1024,s=2 G=max ExP,[D(x)]-Ex-P,[D(G())] (9) 1×1 256 D=max E-,[D(x)]-Ex-r,[D(x)]- 0E 1×1 (10) 8 kE,-random [(IV,D(x)] 判别器的输入数据是由真实的佩戴口罩的人 本文使用的超参数设置为:生成器和判别器 脸图像和合成的戴口罩图像构成。而合成图像则 的学习率都是0.00001,空间变换次数为5次,总 是通过空间变换网络生成的变形后的口罩图像和 迭代次数为30万次,每2万次迭代后学习率衰 未遮挡人脸图像进图像融合产生的,空间变换网 减,批量大小为20,优化算法采用Adam。 络的参数则是由生成器生成而来的。通过判别器 3实验与结果分析 网络对图像进行判别后,输出一个分值来表示图 像合成的质量。判别器网络没有使用全连接层, 3.1数据集与实验环境 而是通过一个3×3的卷积得到5×5×1的矩阵来计 本文中用于训练的图片数据挑选自武汉大学 算得分。由图3所示的训练流程图可知,本文通 发布的人脸口罩数据集20、使用网络爬虫从互联 过不断地优化变换参数的值来优化对口罩进行的 网上抓取的图片以及从其他研究者训合成的人 投射变换,并最终获得较好的合成图像。 脸口罩数据集中挑选的部分图片。在对选取的图辨率和深度。卷积核随着尺寸的减小深度加深, 这样不同尺寸的卷积核能带来互补的信息,有助 于获取更丰富的特征。 在生成器网络的结构设计上,本文采用了 PyConv 的网络结构。首先将输入的正常人脸图像 和口罩图像进行通道数的叠加,再通过一 个 7×7 的大卷积核提取特征。使用 7×7 的大卷积核 的目的是尽可能地保留原始图片的信息且减少计 算量。之后采用了 4 个去掉了批标准化层的 PyConv 卷基层。在 PyConv 中卷积层中去除批量归 一化层的目的是减少计算的复杂度以提升训练效 率。生成器中第一个 PyConv 层用了 4 个不同尺 寸的卷积核 (3×3、5×5、7×7、9×9) 以获取不同尺度 的特征来增强模型的特征提取能力。生成器的输 出是一个 8 维的向量,该向量作为空间变换网络 的参数使用。生成器的网络结构如表 1 与图 2 所示,其中 s 为步长。 表 1 Py-WGAN-div 网络结构 Table 1 Py-WGAN-div network structure 输出尺寸/像素×像素 Py-WGAN-div 72×72 7×7, 64, s=2 36×36 3×3, 32, s=2 5×5, 32, s=2 7×7, 32, s=2 9×9, 32, s=2 18×18 3×3, 64, s=2 5×5, 64, s=2 7×7, 128, s=2 3×3, 256, s=2 9×9 5×5, 256, s=2 5×5 3×3, 1024, s=2 1×1 256 1×1 8 判别器的输入数据是由真实的佩戴口罩的人 脸图像和合成的戴口罩图像构成。而合成图像则 是通过空间变换网络生成的变形后的口罩图像和 未遮挡人脸图像进图像融合产生的,空间变换网 络的参数则是由生成器生成而来的。通过判别器 网络对图像进行判别后,输出一个分值来表示图 像合成的质量。判别器网络没有使用全连接层, 而是通过一个 3×3 的卷积得到 5×5×1 的矩阵来计 算得分。由图 3 所示的训练流程图可知,本文通 过不断地优化变换参数的值来优化对口罩进行的 投射变换,并最终获得较好的合成图像。 P0 IM IF Updata Updata 生成器 生成器 ΔP1 P1 Pn ΔP2 判别器 判别器 … … + + + 图 3 网络训练流程图 Fig. 3 Training flow diagram 2.2 损失函数与超参数设置 本文将采用 WGAN-div 的目标函数作为优化 指标。WGAN 虽然相比 GAN 网络有了很大程度 的优化,但是在训练过程中仍然表现出收敛速度 慢和训练困难的问题[18]。其主要原因是:在处理 利普希茨连续条件限制条件时直接使用了权重裁 减,大部分权重都在±0.01。而判别器希望能尽可 能地拉大真假样本之间的差距。之后其他研究者 提出的 WGAN-GP[12] 和 SNGAN[19] 分别通过了梯 度惩罚和谱归一化的方法实现了 Lipschitz 约束。 而且 WGAN 不能使用基于动量的优化算法,例 如 Adam。WGAN-div 则是提出了式 (8) 所示的 W 散度来真正缩小两个分布之间的距离损失函数: Wk,p ( Pr ,Pf ) = max D∈C1 Ex∼Pr [D(x)]− Ex∼Pf [D(x)]−kEx∼random[(∥∇xD(x)∥ p )] (8) k p k = 2 p = 6 C 1 Pr Pf D(x) G(x) 式中: 和 的设置则是根据经验选取,通常设置 , ; 指一阶连续函数族测度; 与 分别表示真实样本集合和合成样本集合; 和 分别表示判别器和生成器损失函数。 G(x) D(x) 通过式 (8) 可以得到生成器的损失函数 和判别器的损失函数 分别为式 (9) 和式 (10): G = max D∈C1 Ex∼Pr [D(x)]− Ex∼Pf [D(G(z))] (9) D = max D∈C1 Ex∼Pr [D(x)]− Ex∼Pf [D(x)]− kEx∼random[(∥∇xD(x)∥ p )] (10) 本文使用的超参数设置为:生成器和判别器 的学习率都是 0.000 01,空间变换次数为 5 次,总 迭代次数为 30 万次,每 2 万次迭代后学习率衰 减,批量大小为 20,优化算法采用 Adam。 3 实验与结果分析 3.1 数据集与实验环境 本文中用于训练的图片数据挑选自武汉大学 发布的人脸口罩数据集[20] 、使用网络爬虫从互联 网上抓取的图片以及从其他研究者[21] 合成的人 脸口罩数据集中挑选的部分图片。在对选取的图 ·1076· 智 能 系 统 学 报 第 16 卷