正在加载图片...

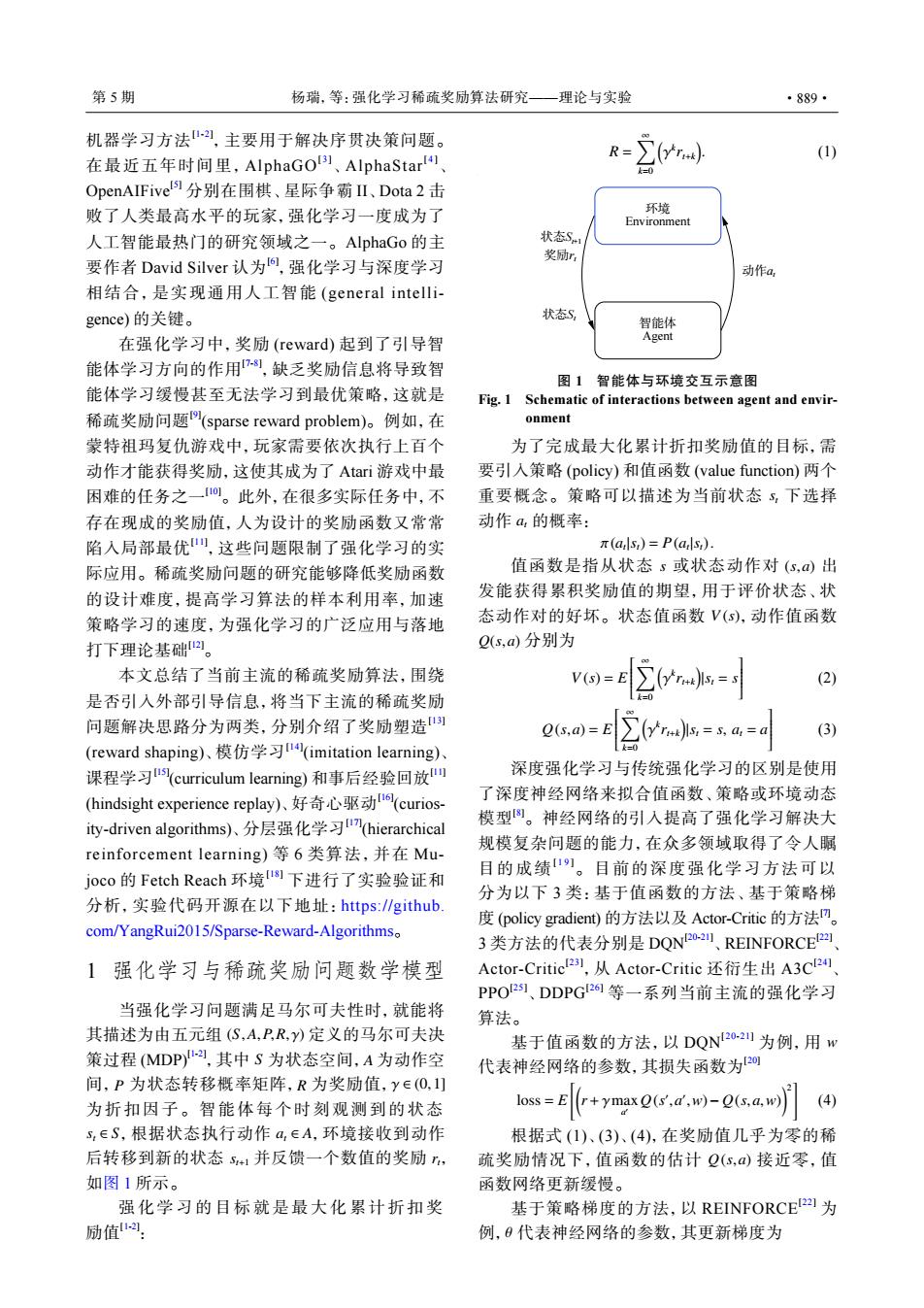

第5期 杨瑞,等:强化学习稀疏奖励算法研究—理论与实验 ·889· 机器学习方法,主要用于解决序贯决策问题。 R (1) 在最近五年时间里,AlphaGO!)3、AlphaStar!) OpenAIFivel分别在围棋、星际争霸Ⅱ、Dota2击 败了人类最高水平的玩家,强化学习一度成为了 环境 Environment 人工智能最热门的研究领域之一。AlphaGo的主 状态S 奖励r 要作者David Silver认为向,强化学习与深度学习 动作a 相结合,是实现通用人工智能(general intelli- gence)的关键。 状态S, 智能体 在强化学习中,奖励(reward)起到了引导智 Agent 能体学习方向的作用”,缺乏奖励信息将导致智 图1智能体与环境交互示意图 能体学习缓慢甚至无法学习到最优策略,这就是 Fig.1 Schematic of interactions between agent and envir- 稀疏奖励问题(sparse reward problem)。例如,在 onment 蒙特祖玛复仇游戏中,玩家需要依次执行上百个 为了完成最大化累计折扣奖励值的目标,需 动作才能获得奖励,这使其成为了Atari游戏中最 要引人策略(policy)和值函数(value function)两个 困难的任务之一0。此外,在很多实际任务中,不 重要概念。策略可以描述为当前状态,下选择 存在现成的奖励值,人为设计的奖励函数又常常 动作a的概率: 陷入局部最优,这些问题限制了强化学习的实 π(als)=P(als). 际应用。稀疏奖励问题的研究能够降低奖励函数 值函数是指从状态s或状态动作对(s,a)出 的设计难度,提高学习算法的样本利用率,加速 发能获得累积奖励值的期望,用于评价状态、状 策略学习的速度,为强化学习的广泛应用与落地 态动作对的好坏。状态值函数V(s),动作值函数 打下理论基础。 Q(s,a)分别为 本文总结了当前主流的稀疏奖励算法,围绕 V(s)= (2) 是否引入外部引导信息,将当下主流的稀疏奖励 问题解决思路分为两类,分别介绍了奖励塑造) Q(s,a)=E (reward shaping)、模仿学习l(imitation learning)、 .j.-x.a-o (3) 课程学习(curriculum learning)和事后经验回放 深度强化学习与传统强化学习的区别是使用 (hindsight experience replay)、好奇心驱动(curios-- 了深度神经网络来拟合值函数、策略或环境动态 ity-driven algorithms))、分层强化学习(hierarchical 模型。神经网络的引入提高了强化学习解决大 reinforcement learning)等6类算法,并在Mu- 规模复杂问题的能力,在众多领域取得了令人瞩 joco的Fetch Reach环境I下进行了实验验证和 目的成绩。目前的深度强化学习方法可以 分为以下3类:基于值函数的方法、基于策略梯 分析,实验代码开源在以下地址:https:/github. 度(policy gradient)的方法以及Actor-Critic的方法。 com/YangRui2015/Sparse-Reward-Algorithmso 3类方法的代表分别是DQN2-2、REINFORCE2a 1强化学习与稀疏奖励问题数学模型 Actor--Critic2,从Actor--Critie还衍生出A3Cl2 PPO21、DDPG2等一系列当前主流的强化学习 当强化学习问题满足马尔可夫性时,就能将 算法 其描述为由五元组(⑤,A,P,R,y)定义的马尔可夫决 基于值函数的方法,以DQN202为例,用w 策过程(MDP),其中S为状态空间,A为动作空 代表神经网络的参数,其损失函数为四 间,P为状态转移概率矩阵,R为奖励值,y∈(O, 为折扣因子。智能体每个时刻观测到的状态 loss-E(r+ymaxQ(.d.w)-Q(s.a.w (4) S,∈S,根据状态执行动作a,∈A,环境接收到动作 根据式(1)、(3)、(4),在奖励值几乎为零的稀 后转移到新的状态5+1并反馈一个数值的奖励, 疏奖励情况下,值函数的估计Q(s,a)接近零,值 如图1所示。 函数网络更新缓慢。 强化学习的目标就是最大化累计折扣奖 基于策略梯度的方法,以REINFORCE22为 励值-: 例,0代表神经网络的参数,其更新梯度为机器学习方法[1-2] ,主要用于解决序贯决策问题。 在最近五年时间里,AlphaGO[ 3 ] 、AlphaStar[ 4 ] 、 OpenAIFive[5] 分别在围棋、星际争霸 II、Dota 2 击 败了人类最高水平的玩家,强化学习一度成为了 人工智能最热门的研究领域之一。AlphaGo 的主 要作者 David Silver 认为[6] ,强化学习与深度学习 相结合,是实现通用人工智能 (general intelligence) 的关键。 在强化学习中,奖励 (reward) 起到了引导智 能体学习方向的作用[7-8] ,缺乏奖励信息将导致智 能体学习缓慢甚至无法学习到最优策略,这就是 稀疏奖励问题[9] (sparse reward problem)。例如,在 蒙特祖玛复仇游戏中,玩家需要依次执行上百个 动作才能获得奖励,这使其成为了 Atari 游戏中最 困难的任务之一[10]。此外,在很多实际任务中,不 存在现成的奖励值,人为设计的奖励函数又常常 陷入局部最优[11] ,这些问题限制了强化学习的实 际应用。稀疏奖励问题的研究能够降低奖励函数 的设计难度,提高学习算法的样本利用率,加速 策略学习的速度,为强化学习的广泛应用与落地 打下理论基础[12]。 本文总结了当前主流的稀疏奖励算法,围绕 是否引入外部引导信息,将当下主流的稀疏奖励 问题解决思路分为两类,分别介绍了奖励塑造[13] (reward shaping)、模仿学习[14] (imitation learning)、 课程学习[15] (curriculum learning) 和事后经验回放[11] (hindsight experience replay)、好奇心驱动[16] (curiosity-driven algorithms)、分层强化学习[17] (hierarchical reinforcement learning) 等 6 类算法,并在 Mujoco 的 Fetch Reach 环境[18] 下进行了实验验证和 分析,实验代码开源在以下地址:https://github. com/YangRui2015/Sparse-Reward-Algorithms。 1 强化学习与稀疏奖励问题数学模型 (S,A,P,R, γ) S A P R γ ∈ (0,1] st ∈ S at ∈ A st+1 rt 当强化学习问题满足马尔可夫性时,就能将 其描述为由五元组 定义的马尔可夫决 策过程 (MDP)[1-2] ,其中 为状态空间, 为动作空 间, 为状态转移概率矩阵, 为奖励值, 为折扣因子。智能体每个时刻观测到的状态 ,根据状态执行动作 ,环境接收到动作 后转移到新的状态 并反馈一个数值的奖励 , 如图 1 所示。 强化学习的目标就是最大化累计折扣奖 励值[1-2] : R = ∑∞ k=0 ( γ k rt+k ) . (1) 环境 Environment 智能体 Agent 动作at 状态St+1 奖励rt 状态St 图 1 智能体与环境交互示意图 Fig. 1 Schematic of interactions between agent and environment st at 为了完成最大化累计折扣奖励值的目标,需 要引入策略 (policy) 和值函数 (value function) 两个 重要概念。策略可以描述为当前状态 下选择 动作 的概率: π(at |st) = P(at |st). s (s,a) V (s) Q(s,a) 值函数是指从状态 或状态动作对 出 发能获得累积奖励值的期望,用于评价状态、状 态动作对的好坏。状态值函数 ,动作值函数 分别为 V (s) = E ∑∞ k=0 ( γ k rt+k ) |st = s (2) Q(s,a) = E ∑∞ k=0 ( γ k rt+k ) |st = s, at = a (3) 深度强化学习与传统强化学习的区别是使用 了深度神经网络来拟合值函数、策略或环境动态 模型[8]。神经网络的引入提高了强化学习解决大 规模复杂问题的能力,在众多领域取得了令人瞩 目的成绩[ 1 9 ]。目前的深度强化学习方法可以 分为以下 3 类:基于值函数的方法、基于策略梯 度 (policy gradient) 的方法以及 Actor-Critic 的方法[7]。 3 类方法的代表分别是 DQN[20-21] 、REINFORCE[22] 、 Actor-Critic[23] ,从 Actor-Critic 还衍生出 A3C[24] 、 PPO[25] 、DDPG[26] 等一系列当前主流的强化学习 算法。 基于值函数的方法,以 DQN w [ 20-21] 为例,用 代表神经网络的参数,其损失函数为[20] loss = E [( r +γmax a ′ Q(s ′ ,a ′ ,w)− Q(s,a,w) )2 ] (4) Q(s,a) 根据式 (1)、(3)、(4),在奖励值几乎为零的稀 疏奖励情况下,值函数的估计 接近零,值 函数网络更新缓慢。 θ 基于策略梯度的方法,以 REINFORCE[22] 为 例, 代表神经网络的参数,其更新梯度为 第 5 期 杨瑞,等:强化学习稀疏奖励算法研究——理论与实验 ·889·