正在加载图片...

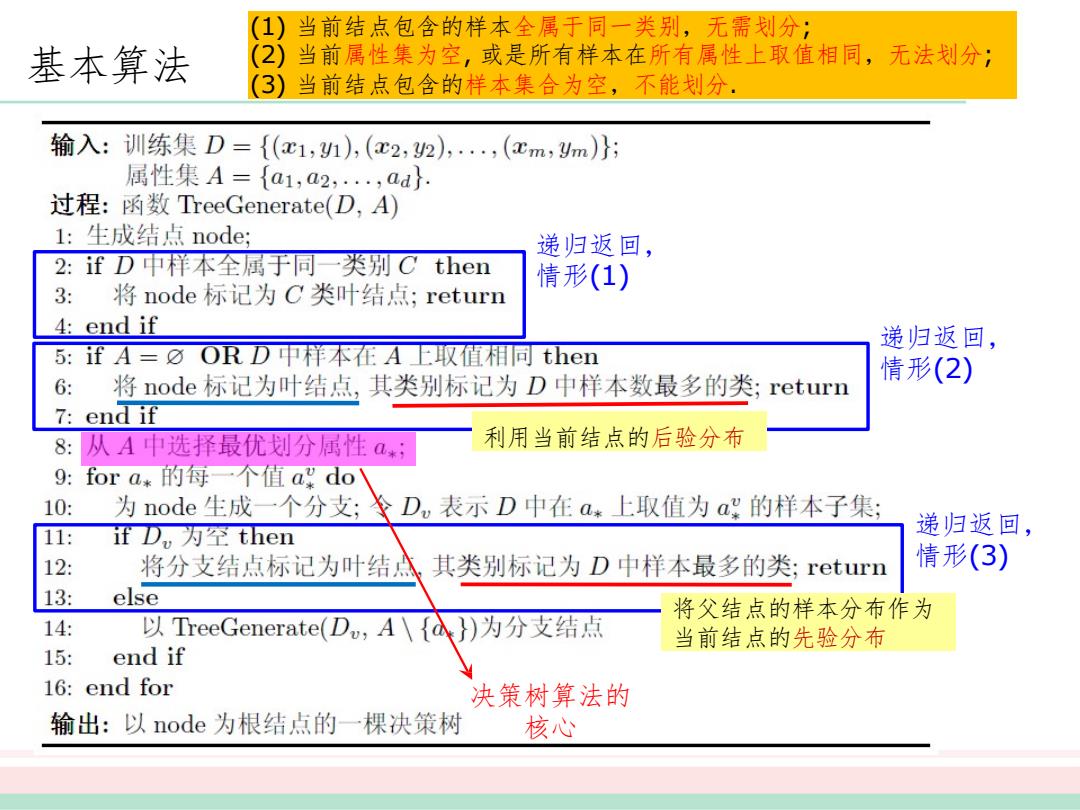

(1) 当前结点包含的样本全属于同一类别,无需划分; 基本算法 (2) 当前属性集为空,或是所有样本在所有属性上取值相同,无法划分; (3)当前结点包含的样本集合为空,不能划分. 输入:训练集D= {(c1,1),(x2,2),,(cm,ym)}; 属性集A={a1,a2,,ad 过程:函数TreeGenerate(D,A) 1:生成结点node 递归返回, 2: ifD中样本全属于同一类别C then 情形(1) 3: 将node标记为C类叶结点;return 4:end if 递归返回, 5:fA=⑦ORD中样本在A上取值相同then 将node标记为叶结点,其类别标记为D中样本数最多的类; 情形(2) 6: return 7:end if 8:从A中选择最优划分属性a*; 利用当前结点的后验分布 9: fora*的每一个值agdo 10: 为node生成一个分支;士D,表示D中在a*上取值为a的样本子集; ifD,为空then 递归返回, 11: 12: 将分支结点标记为叶结 其类别标记为D中样本最多的类;return 情形(3) 13: else 将父结点的样本分布作为 14: 以TreeGenerate(Du,A\)为分支结点 当前结点的先验分布 15: end if 16: end for 决策树算法的 输出:以node为根结点的一棵决策树 核心(4, 9

8 " (1) 9

8 " (2) /

6-0<

9

8 " (3) .6-0*(

6-0 <

3)4,0 + (1)

6-0*( 5%;

; (2)

!:2, #&$'*($'!1%,

; (3)

6-0*(:27

.��