正在加载图片...

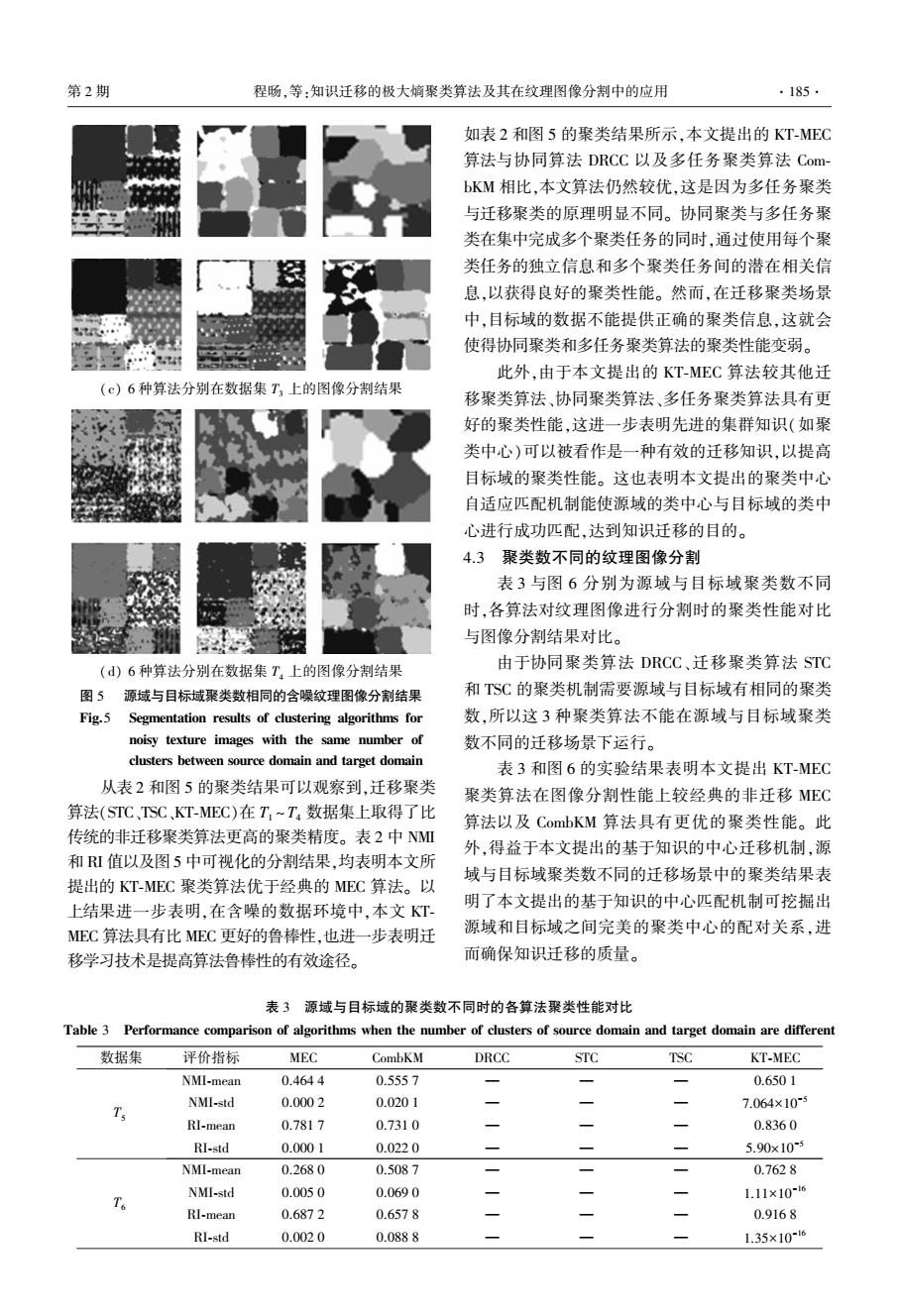

第2期 程肠,等:知识迁移的极大嫡聚类算法及其在纹理图像分割中的应用 ·185. 如表2和图5的聚类结果所示,本文提出的KT-MEC 算法与协同算法DRCC以及多任务聚类算法Com bKM相比,本文算法仍然较优,这是因为多任务聚类 与迁移聚类的原理明显不同。协同聚类与多任务聚 类在集中完成多个聚类任务的同时,通过使用每个聚 类任务的独立信息和多个聚类任务间的潜在相关信 息,以获得良好的聚类性能。然而,在迁移聚类场景 中,目标域的数据不能提供正确的聚类信息,这就会 使得协同聚类和多任务聚类算法的聚类性能变弱。 中” 此外,由于本文提出的KT-MEC算法较其他迁 (c)6种算法分别在数据集T,上的图像分割结果 移聚类算法、协同聚类算法、多任务聚类算法具有更 好的聚类性能,这进一步表明先进的集群知识(如聚 类中心)可以被看作是一种有效的迁移知识,以提高 目标域的聚类性能。这也表明本文提出的聚类中心 自适应匹配机制能使源域的类中心与目标域的类中 心进行成功匹配,达到知识迁移的目的。 4.3聚类数不同的纹理图像分割 表3与图6分别为源域与目标域聚类数不同 时,各算法对纹理图像进行分割时的聚类性能对比 与图像分割结果对比。 (d)6种算法分别在数据集T:上的图像分割结果 由于协同聚类算法DRCC、迁移聚类算法STC 图5源域与目标域聚类数相同的含噪纹理图像分割结果 和T$C的聚类机制需要源域与目标域有相同的聚类 Fig.5 Segmentation results of clustering algorithms for 数,所以这3种聚类算法不能在源域与目标域聚类 noisy texture images with the same number of 数不同的迁移场景下运行。 clusters between source domain and target domain 表3和图6的实验结果表明本文提出KT-MEC 从表2和图5的聚类结果可以观察到,迁移聚类 聚类算法在图像分割性能上较经典的非迁移MEC 算法(STC、TSC、KT-MEC)在T,~T,数据集上取得了比 算法以及CombKM算法具有更优的聚类性能。此 传统的非迁移聚类算法更高的聚类精度。表2中NM 外,得益于本文提出的基于知识的中心迁移机制,源 和值以及图5中可视化的分割结果,均表明本文所 域与目标域聚类数不同的迁移场景中的聚类结果表 提出的KT-MEC聚类算法优于经典的MEC算法。以 上结果进一步表明,在含噪的数据环境中,本文KT 明了本文提出的基于知识的中心匹配机制可挖掘出 EC算法具有比MEC更好的鲁棒性,也进一步表明迁 源域和目标域之间完美的聚类中心的配对关系,进 移学习技术是提高算法鲁棒性的有效途径。 而确保知识迁移的质量。 表3源域与目标域的聚类数不同时的各算法聚类性能对比 Table 3 Performance comparison of algorithms when the number of clusters of source domain and target domain are different 数据集 评价指标 MEC CombKM DRCC STC TSC KT-MEC NMI-mean 0.4644 0.5557 一 0.6501 NMI-std 0.0002 0.0201 T 一 一 7.064×105 RI-mean 0.7817 0.7310 一 一 0.8360 RI-std 0.0001 0.0220 5.90x105 NMI-mean 0.2680 0.5087 一 0.7628 NMI-std 0.0050 0.0690 - 1.11×10-16 RI-mean 0.6872 0.6578 0.9168 RI-std 0.0020 0.0888 1.35×10-6(c) 6 种算法分别在数据集 T3 上的图像分割结果 (d) 6 种算法分别在数据集 T4 上的图像分割结果 图 5 源域与目标域聚类数相同的含噪纹理图像分割结果 Fig.5 Segmentation results of clustering algorithms for noisy texture images with the same number of clusters between source domain and target domain 从表 2 和图 5 的聚类结果可以观察到,迁移聚类 算法(STC、TSC、KT⁃MEC)在 T1 ~T4 数据集上取得了比 传统的非迁移聚类算法更高的聚类精度。 表 2 中 NMI 和 RI 值以及图 5 中可视化的分割结果,均表明本文所 提出的 KT⁃MEC 聚类算法优于经典的 MEC 算法。 以 上结果进一步表明,在含噪的数据环境中,本文 KT⁃ MEC 算法具有比 MEC 更好的鲁棒性,也进一步表明迁 移学习技术是提高算法鲁棒性的有效途径。 如表 2 和图 5 的聚类结果所示,本文提出的 KT⁃MEC 算法与协同算法 DRCC 以及多任务聚类算法 Com⁃ bKM 相比,本文算法仍然较优,这是因为多任务聚类 与迁移聚类的原理明显不同。 协同聚类与多任务聚 类在集中完成多个聚类任务的同时,通过使用每个聚 类任务的独立信息和多个聚类任务间的潜在相关信 息,以获得良好的聚类性能。 然而,在迁移聚类场景 中,目标域的数据不能提供正确的聚类信息,这就会 使得协同聚类和多任务聚类算法的聚类性能变弱。 此外,由于本文提出的 KT⁃MEC 算法较其他迁 移聚类算法、协同聚类算法、多任务聚类算法具有更 好的聚类性能,这进一步表明先进的集群知识(如聚 类中心)可以被看作是一种有效的迁移知识,以提高 目标域的聚类性能。 这也表明本文提出的聚类中心 自适应匹配机制能使源域的类中心与目标域的类中 心进行成功匹配,达到知识迁移的目的。 4.3 聚类数不同的纹理图像分割 表 3 与图 6 分别为源域与目标域聚类数不同 时,各算法对纹理图像进行分割时的聚类性能对比 与图像分割结果对比。 由于协同聚类算法 DRCC、迁移聚类算法 STC 和 TSC 的聚类机制需要源域与目标域有相同的聚类 数,所以这 3 种聚类算法不能在源域与目标域聚类 数不同的迁移场景下运行。 表 3 和图 6 的实验结果表明本文提出 KT⁃MEC 聚类算法在图像分割性能上较经典的非迁移 MEC 算法以及 CombKM 算法具有更优的聚类性能。 此 外,得益于本文提出的基于知识的中心迁移机制,源 域与目标域聚类数不同的迁移场景中的聚类结果表 明了本文提出的基于知识的中心匹配机制可挖掘出 源域和目标域之间完美的聚类中心的配对关系,进 而确保知识迁移的质量。 表 3 源域与目标域的聚类数不同时的各算法聚类性能对比 Table 3 Performance comparison of algorithms when the number of clusters of source domain and target domain are different 数据集 评价指标 MEC CombKM DRCC STC TSC KT⁃MEC T5 NMI⁃mean 0.464 4 0.555 7 — — — 0.650 1 NMI⁃std 0.000 2 0.020 1 — — — 7.064×10 -5 RI⁃mean 0.781 7 0.731 0 — — — 0.836 0 RI⁃std 0.000 1 0.022 0 — — — 5.90×10 -5 T6 NMI⁃mean 0.268 0 0.508 7 — — — 0.762 8 NMI⁃std 0.005 0 0.069 0 — — — 1.11×10 -16 RI⁃mean 0.687 2 0.657 8 — — — 0.916 8 RI⁃std 0.002 0 0.088 8 — — — 1.35×10 -16 第 2 期 程旸,等:知识迁移的极大熵聚类算法及其在纹理图像分割中的应用 ·185·