正在加载图片...

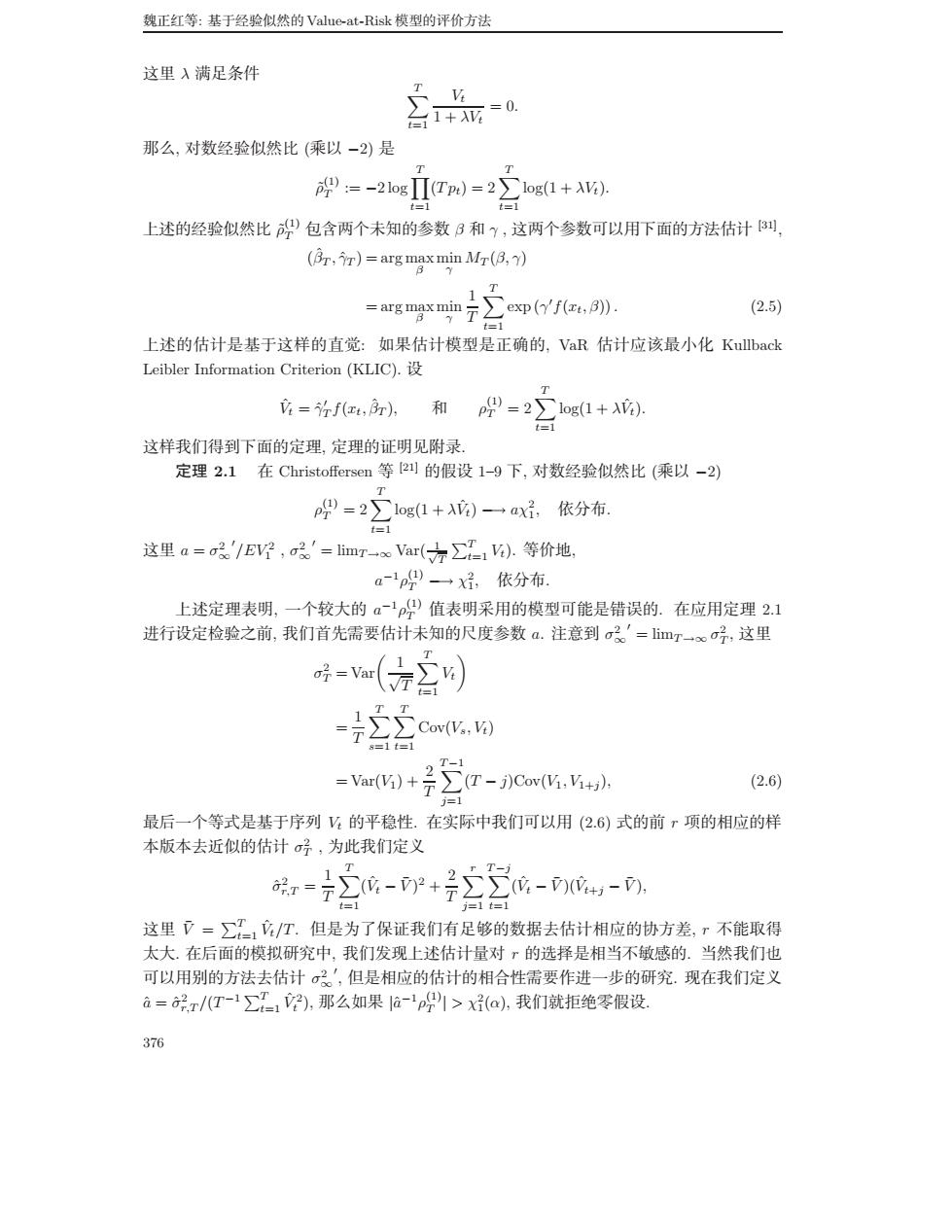

魏正红等:基于经验似然的Value-at-Risk模型的评价方法 这里入满足条件 品0 那么,对数经验似然比(乘以一2)是 9:=-2ogΠTpm)=2∑og(1+A). 上述的经验似然比9包含两个未知的参数日和?,这两个参数可以用下面的方法估计倒 (房,m)=arg,) gmiu7∑epf,. (2.5 上述的估计是基于这样的直觉:如果估计模型是正确的,VaR估计应该最小化Kullback Leibler Information Criterion (KLIC). =f红,r,和p9=2∑1og(1+A). 这样我们得到下面的定理,定理的证明见附录 定理2.1在Christoffersen等的假设1-9下,对数经验似然比(乘以-2) p9=2∑1og1+A的一axi,依分布 这里a-a'/EV,a2。'-limT-eVar(∑1).等价地 ap9一x好,依分布, 上述定理表明,一个较大的a~19值表明采用的模型可能是错误的.在应用定理2.1 进行设定检验之前,我们首先需要估计未知的尺度参数a.注意到o。'=imr一,这里 =(2 1 =∑c, 台台 -Ya()+(T-jCw(V.V.) (2.6) 最后一个等式是基于序列的平稳性.在实际中我们可以用(2.6)式的前r项的相应的样 本版本去近似的估计宁,为此我们定义 =7-+--, 这里了=∑T,T.但是为了保证我们有足够的数据去估计相应的协方差,r不能取得 太大.在后面的模拟研究中,我们发现上述估计量对r的选择是相当不敏感的.当然我们也 可以用别的方法去估计',但是相应的估计的相合性需要作进一步的研究。现在我们定义 a=说x/(T-1∑-?),那么如果ap1>x(a),我们就拒绝零假设。 37 魏正红等: 基于经验似然的 Value-at-Risk 模型的评价方法 这里 λ 满足条件 T t=1 Vt 1 + λVt = 0. 那么, 对数经验似然比 (乘以 −2) 是 ρ˜ (1) T := −2 log T t=1 (T pt)=2 T t=1 log(1 + λVt). 上述的经验似然比 ρ˜ (1) T 包含两个未知的参数 β 和 γ , 这两个参数可以用下面的方法估计 [31], (βˆT , γˆT ) = arg max β min γ MT (β, γ) = arg max β min γ 1 T T t=1 exp (γ f(xt, β)). (2.5) 上述的估计是基于这样的直觉: 如果估计模型是正确的, VaR 估计应该最小化 Kullback Leibler Information Criterion (KLIC). 设 Vˆt = ˆγ T f(xt, βˆT ), 和 ρ (1) T = 2 T t=1 log(1 + λVˆt). 这样我们得到下面的定理, 定理的证明见附录. 定理 2.1 在 Christoffersen 等 [21] 的假设 1–9 下, 对数经验似然比 (乘以 −2) ρ (1) T = 2 T t=1 log(1 + λVˆt) −→ aχ2 1, 依分布. 这里 a = σ2 ∞ /EV 2 1 , σ2 ∞ = limT→∞ Var( √ 1 T T t=1 Vt). 等价地, a−1ρ (1) T −→ χ2 1, 依分布. 上述定理表明, 一个较大的 a−1ρ(1) T 值表明采用的模型可能是错误的. 在应用定理 2.1 进行设定检验之前, 我们首先需要估计未知的尺度参数 a. 注意到 σ2 ∞ = limT→∞ σ2 T , 这里 σ2 T = Var 1 √ T T t=1 Vt = 1 T T s=1 T t=1 Cov(Vs, Vt) = Var(V1) + 2 T T −1 j=1 (T − j)Cov(V1, V1+j ), (2.6) 最后一个等式是基于序列 Vt 的平稳性. 在实际中我们可以用 (2.6) 式的前 r 项的相应的样 本版本去近似的估计 σ2 T , 为此我们定义 σˆ2 r,T = 1 T T t=1 (Vˆt − V¯ ) 2 + 2 T r j=1 T −j t=1 (Vˆt − V¯ )(Vˆt+j − V¯ ), 这里 V¯ = T t=1 Vˆt/T . 但是为了保证我们有足够的数据去估计相应的协方差, r 不能取得 太大. 在后面的模拟研究中, 我们发现上述估计量对 r 的选择是相当不敏感的. 当然我们也 可以用别的方法去估计 σ2 ∞ , 但是相应的估计的相合性需要作进一步的研究. 现在我们定义 aˆ = ˆσ2 r,T /(T −1 T t=1 Vˆ 2 t ), 那么如果 |aˆ−1ρ (1) T | > χ2 1(α), 我们就拒绝零假设. 376�������������������