正在加载图片...

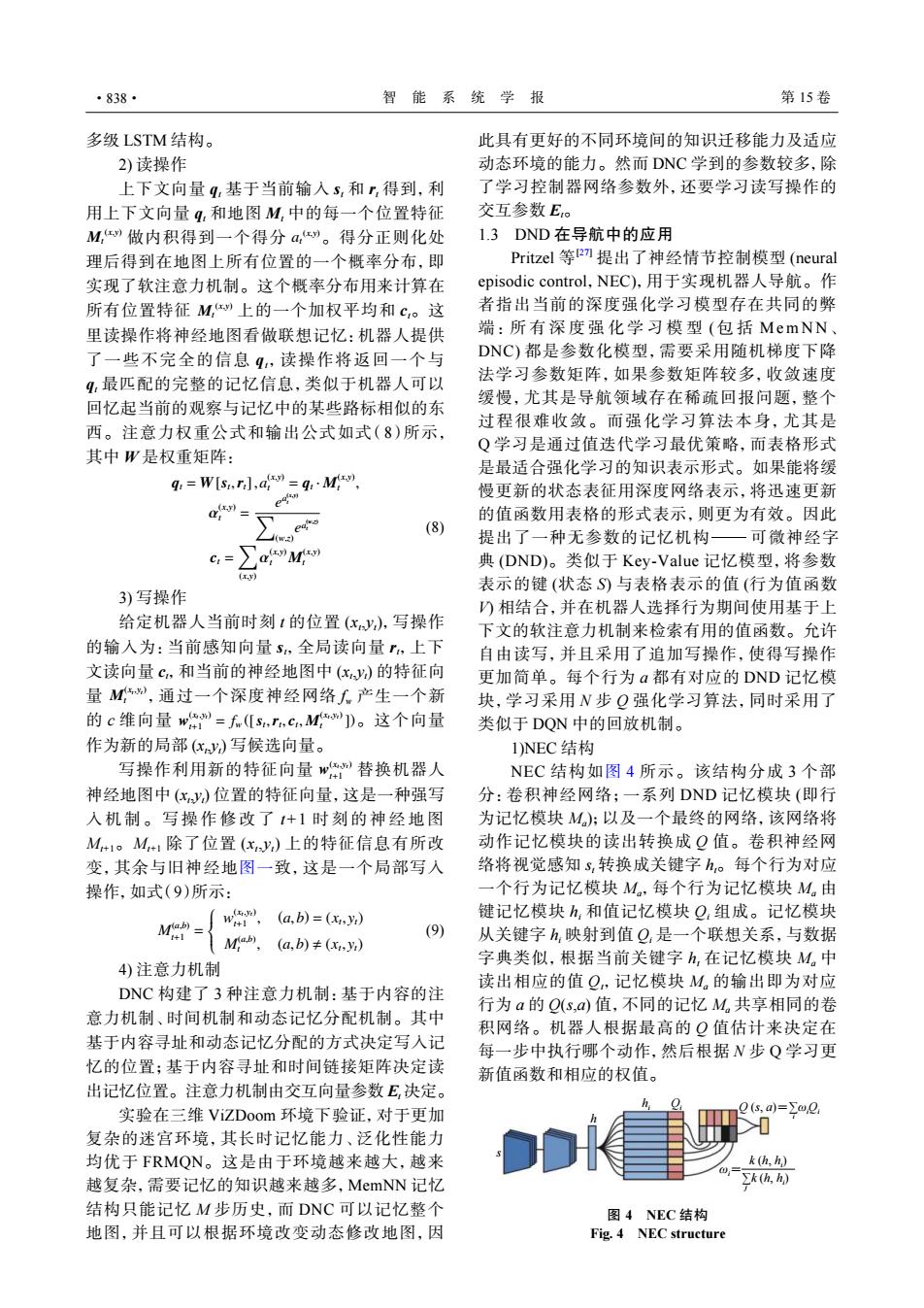

·838· 智能系统学报 第15卷 多级LSTM结构。 此具有更好的不同环境间的知识迁移能力及适应 2)读操作 动态环境的能力。然而DNC学到的参数较多,除 上下文向量q,基于当前输入3,和,得到,利 了学习控制器网络参数外,还要学习读写操作的 用上下文向量q,和地图M,中的每一个位置特征 交互参数E。 M,”做内积得到一个得分a,9。得分正则化处 1.3DND在导航中的应用 理后得到在地图上所有位置的一个概率分布,即 Pritzel等P)提出了神经情节控制模型(neural 实现了软注意力机制。这个概率分布用来计算在 episodic control,.NEC),用于实现机器人导航。作 所有位置特征M,”上的一个加权平均和c,。这 者指出当前的深度强化学习模型存在共同的弊 里读操作将神经地图看做联想记忆:机器人提供 端:所有深度强化学习模型(包括MemNN、 了一些不完全的信息q,读操作将返回一个与 DNC)都是参数化模型,需要采用随机梯度下降 4,最匹配的完整的记忆信息,类似于机器人可以 法学习参数矩阵,如果参数矩阵较多,收敛速度 回忆起当前的观察与记忆中的某些路标相似的东 缓慢,尤其是导航领域存在稀疏回报问题,整个 过程很难收敛。而强化学习算法本身,尤其是 西。注意力权重公式和输出公式如式(8)所示, Q学习是通过值迭代学习最优策略,而表格形式 其中W是权重矩阵: 是最适合强化学习的知识表示形式。如果能将缓 q=W[sr,d=qM 慢更新的状态表征用深度网络表示,将迅速更新 的值函数用表格的形式表示,则更为有效。因此 (8) 提出了一种无参数的记忆机构一可微神经字 G= aM 典(DND)。类似于Key-Value记忆模型,将参数 表示的键(状态S)与表格表示的值(行为值函数 3)写操作 )相结合,并在机器人选择行为期间使用基于上 给定机器人当前时刻1的位置(xy,写操作 下文的软注意力机制来检索有用的值函数。允许 的输入为:当前感知向量s,全局读向量,上下 自由读写,并且采用了追加写操作,使得写操作 文读向量c,和当前的神经地图中(xy)的特征向 更加简单。每个行为a都有对应的DND记忆模 量M,通过一个深度神经网络人产生一个新 块,学习采用N步Q强化学习算法,同时采用了 的c维向量w=f(s,r,c,M])。这个向量 类似于DQN中的回放机制。 作为新的局部(x)写候选向量。 1)NEC结构 写操作利用新的特征向量”:替换机器人 NEC结构如图4所示。该结构分成3个部 神经地图中(x)位置的特征向量,这是一种强写 分:卷积神经网络;一系列DND记忆模块(即行 入机制。写操作修改了1+1时刻的神经地图 为记忆模块M):以及一个最终的网络,该网络将 M#1。M+1除了位置(xy,)上的特征信息有所改 动作记忆模块的读出转换成Q值。卷积神经网 变,其余与旧神经地图一致,这是一个局部写入 络将视觉感知s,转换成关键字h,。每个行为对应 操作,如式(9)所示: 一个行为记忆模块M。,每个行为记忆模块M。由 M= w(a,b)=() 键记忆模块h,和值记忆模块Q,组成。记忆模块 M,(a,b)≠(,) (9) 从关键字h映射到值Q,是一个联想关系,与数据 4)注意力机制 字典类似,根据当前关键字h,在记忆模块M,中 读出相应的值Q,记忆模块M。的输出即为对应 DNC构建了3种注意力机制:基于内容的注 行为a的Q(s,ad)值,不同的记忆M,共享相同的卷 意力机制、时间机制和动态记忆分配机制。其中 积网络。机器人根据最高的Q值估计来决定在 基于内容寻址和动态记忆分配的方式决定写入记 每一步中执行哪个动作,然后根据N步Q学习更 忆的位置;基于内容寻址和时间链接矩阵决定读 新值函数和相应的权值。 出记忆位置。注意力机制由交互向量参数E,决定。 实验在三维ViZDoom环境下验证,对于更加 Q(s,a)=∑Q 复杂的迷宫环境,其长时记忆能力、泛化性能力 均优于FRMON。这是由于环境越来越大,越来 k(h,h) 越复杂,需要记忆的知识越来越多,MemNN记忆 ∑k(h,h) 结构只能记忆M步历史,而DNC可以记忆整个 图4NEC结构 地图,并且可以根据环境改变动态修改地图,因 Fig.4 NEC structure多级 LSTM 结构。 2) 读操作 Mt (x,y) at (x,y) Mt (x,y) 上下文向量 qt 基于当前输入 st 和 rt 得到,利 用上下文向量 qt 和地图 Mt 中的每一个位置特征 做内积得到一个得分 。得分正则化处 理后得到在地图上所有位置的一个概率分布,即 实现了软注意力机制。这个概率分布用来计算在 所有位置特征 上的一个加权平均和 ct。这 里读操作将神经地图看做联想记忆:机器人提供 了一些不完全的信息 qt,读操作将返回一个与 qt 最匹配的完整的记忆信息,类似于机器人可以 回忆起当前的观察与记忆中的某些路标相似的东 西。注意力权重公式和输出公式如式(8)所示, 其中 W 是权重矩阵: qt = W [st ,rt],a (x,y) t = qt · M (x,y) t , α (x,y) t = e a (x,y) t ∑ (w,z) e a (w,z) t ct = ∑ (x,y) α (x,y) t M (x,y) t (8) 3) 写操作 M (xt ,yt) t w (xt ,yt) t+1 = fw ([st ,rt , ct , M (xt ,yt) t ]) 给定机器人当前时刻 t 的位置 (xt ,yt ),写操作 的输入为:当前感知向量 st,全局读向量 rt,上下 文读向量 ct,和当前的神经地图中 (xt ,yt ) 的特征向 量 ,通过一个深度神经网络 fw 产生一个新 的 c 维向量 。这个向量 作为新的局部 (xt ,yt ) 写候选向量。 w (xt ,yt) 写操作利用新的特征向量 t+1 替换机器人 神经地图中 (xt ,yt ) 位置的特征向量,这是一种强写 入机制。写操作修改 了 t+1 时刻的神经地 图 Mt+1。Mt+1 除了位置 (xt ,yt ) 上的特征信息有所改 变,其余与旧神经地图一致,这是一个局部写入 操作,如式(9)所示: M (a,b) t+1 = w (xt ,yt) t+1 , (a,b) = (xt , yt) M (a,b) t , (a,b) , (xt , yt) (9) 4) 注意力机制 DNC 构建了 3 种注意力机制:基于内容的注 意力机制、时间机制和动态记忆分配机制。其中 基于内容寻址和动态记忆分配的方式决定写入记 忆的位置;基于内容寻址和时间链接矩阵决定读 出记忆位置。注意力机制由交互向量参数 Et 决定。 实验在三维 ViZDoom 环境下验证,对于更加 复杂的迷宫环境,其长时记忆能力、泛化性能力 均优于 FRMQN。这是由于环境越来越大,越来 越复杂,需要记忆的知识越来越多,MemNN 记忆 结构只能记忆 M 步历史,而 DNC 可以记忆整个 地图,并且可以根据环境改变动态修改地图,因 此具有更好的不同环境间的知识迁移能力及适应 动态环境的能力。然而 DNC 学到的参数较多,除 了学习控制器网络参数外,还要学习读写操作的 交互参数 Et。 1.3 DND 在导航中的应用 Pritzel 等 [27] 提出了神经情节控制模型 (neural episodic control,NEC),用于实现机器人导航。作 者指出当前的深度强化学习模型存在共同的弊 端:所有深度强化学习模 型 (包 括 MemNN 、 DNC) 都是参数化模型,需要采用随机梯度下降 法学习参数矩阵,如果参数矩阵较多,收敛速度 缓慢,尤其是导航领域存在稀疏回报问题,整个 过程很难收敛。而强化学习算法本身,尤其是 Q 学习是通过值迭代学习最优策略,而表格形式 是最适合强化学习的知识表示形式。如果能将缓 慢更新的状态表征用深度网络表示,将迅速更新 的值函数用表格的形式表示,则更为有效。因此 提出了一种无参数的记忆机构−可微神经字 典 (DND)。类似于 Key-Value 记忆模型,将参数 表示的键 (状态 S) 与表格表示的值 (行为值函数 V) 相结合,并在机器人选择行为期间使用基于上 下文的软注意力机制来检索有用的值函数。允许 自由读写,并且采用了追加写操作,使得写操作 更加简单。每个行为 a 都有对应的 DND 记忆模 块,学习采用 N 步 Q 强化学习算法,同时采用了 类似于 DQN 中的回放机制。 1)NEC 结构 NEC 结构如图 4 所示。该结构分成 3 个部 分:卷积神经网络;一系列 DND 记忆模块 (即行 为记忆模块 Ma );以及一个最终的网络,该网络将 动作记忆模块的读出转换成 Q 值。卷积神经网 络将视觉感知 st 转换成关键字 ht。每个行为对应 一个行为记忆模块 Ma,每个行为记忆模块 Ma 由 键记忆模块 hi 和值记忆模块 Qi 组成。记忆模块 从关键字 hi 映射到值 Qi 是一个联想关系,与数据 字典类似,根据当前关键字 ht 在记忆模块 Ma 中 读出相应的值 Qt,记忆模块 Ma 的输出即为对应 行为 a 的 Q(s,a) 值,不同的记忆 Ma 共享相同的卷 积网络。机器人根据最高的 Q 值估计来决定在 每一步中执行哪个动作,然后根据 N 步 Q 学习更 新值函数和相应的权值。 s h hi Qi Q (s, a)=∑ωiQi i ∑k (h, hi ) ωi= k (h, hi ) j 图 4 NEC 结构 Fig. 4 NEC structure ·838· 智 能 系 统 学 报 第 15 卷