正在加载图片...

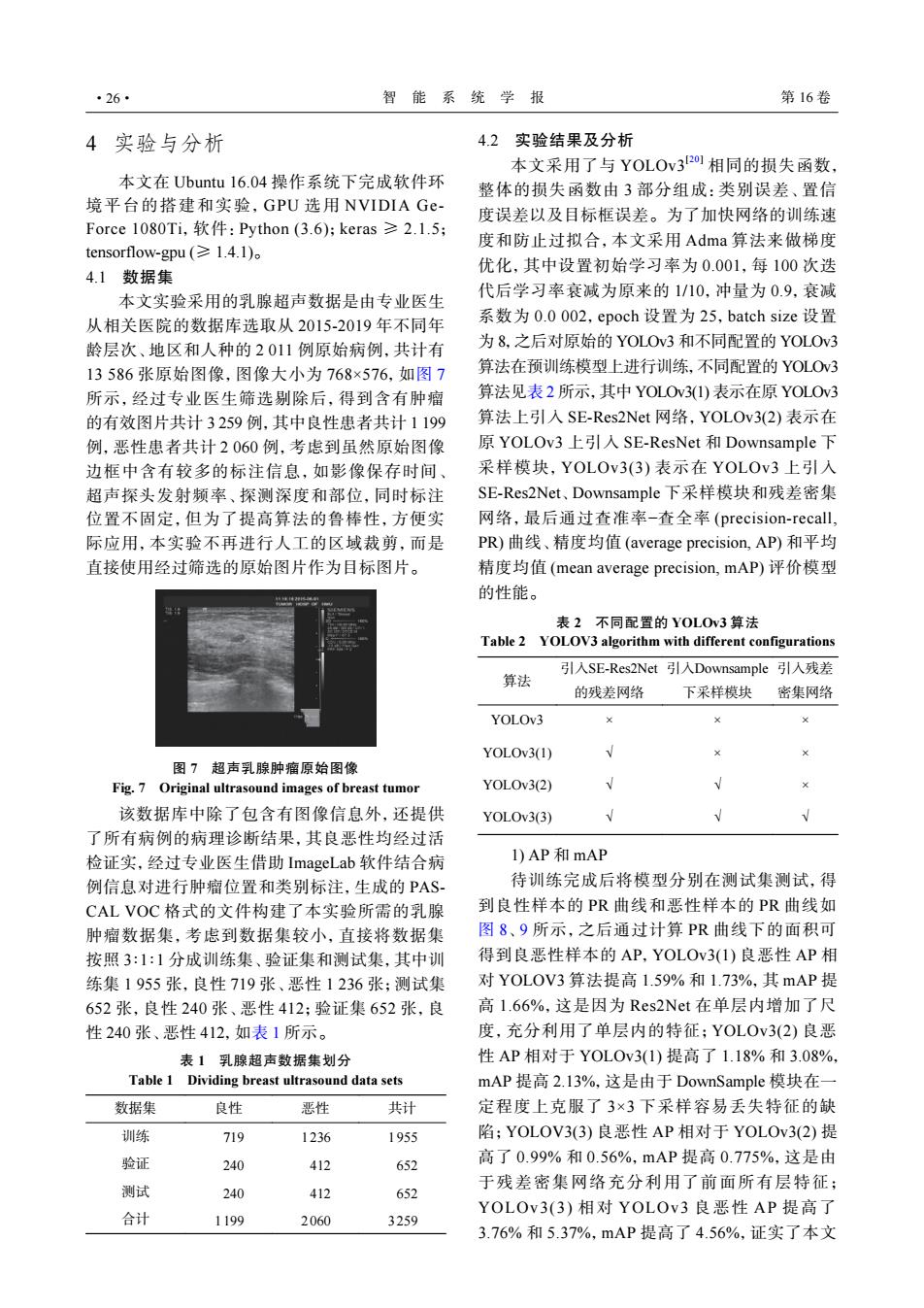

·26 智能系统学报 第16卷 4实验与分析 4.2实验结果及分析 本文采用了与YOLOv:32o1相同的损失函数, 本文在Ubuntu16.04操作系统下完成软件环 整体的损失函数由3部分组成:类别误差、置信 境平台的搭建和实验,GPU选用NVIDIA Ge- 度误差以及目标框误差。为了加快网络的训练速 Force1080Ti,软件:Python(3.6);keras≥2.1.5; 度和防止过拟合,本文采用Adma算法来做梯度 tensorflow-gpu(1.4.1). 优化,其中设置初始学习率为0.001,每100次迭 4.1数据集 本文实验采用的乳腺超声数据是由专业医生 代后学习率衰减为原来的1/10,冲量为0.9,衰减 从相关医院的数据库选取从2015-2019年不同年 系数为0.0002,epoch设置为25,batch size设置 龄层次、地区和人种的2011例原始病例,共计有 为8,之后对原始的YOLOv3和不同配置的YOLOv3 13586张原始图像,图像大小为768×576,如图7 算法在预训练模型上进行训练,不同配置的YOLO3 所示,经过专业医生筛选剔除后,得到含有肿瘤 算法见表2所示,其中YOLOV31)表示在原YOLOv3 的有效图片共计3259例,其中良性患者共计1199 算法上引入SE-Res2Net网络,YOLOv3(2)表示在 例,恶性患者共计2060例,考虑到虽然原始图像 原YOLOv3上引入SE-ResNet和Downsample下 边框中含有较多的标注信息,如影像保存时间、 采样模块,YOLOv3(3)表示在YOLOv3上引入 超声探头发射频率、探测深度和部位,同时标注 SE-Res2Net、Downsample下采样模块和残差密集 位置不固定,但为了提高算法的鲁棒性,方便实 网络,最后通过查准率-查全率(precision-recall,. 际应用,本实验不再进行人工的区域裁剪,而是 PR)曲线、精度均值(average precision,.AP)和平均 直接使用经过筛选的原始图片作为目标图片。 精度均值(mean average precision,mAP)评价模型 的性能。 表2不同配置的YOLOv3算法 Table 2 YOLOV3 algorithm with different configurations 引入SE-Res2Net引入Downsample引入残差 算法 的残差网络 下采样模块 密集网络 YOLOv3 YOLOv3(1) 图7超声乳腺肿瘤原始图像 Fig.7 Original ultrasound images of breast tumor YOLOv3(2) 该数据库中除了包含有图像信息外,还提供 YOLOv3(3) 了所有病例的病理诊断结果,其良恶性均经过活 检证实,经过专业医生借助ImageLab软件结合病 1)AP和mAP 例信息对进行肿瘤位置和类别标注,生成的PAS 待训练完成后将模型分别在测试集测试,得 CAL VOC格式的文件构建了本实验所需的乳腺 到良性样本的PR曲线和恶性样本的PR曲线如 肿瘤数据集,考虑到数据集较小,直接将数据集 图8、9所示,之后通过计算PR曲线下的面积可 按照3:1:1分成训练集、验证集和测试集,其中训 得到良恶性样本的AP,YOLOV31)良恶性AP相 练集1955张,良性719张、恶性1236张:测试集 对YOLOV3算法提高1.59%和1.73%,其mAP提 652张,良性240张、恶性412;验证集652张,良 高1.66%,这是因为Res2Net在单层内增加了尺 性240张、恶性412,如表1所示。 度,充分利用了单层内的特征;YOLOv3(2)良恶 表1乳腺超声数据集划分 性AP相对于YOLOv3(1)提高了1.18%和3.08%, Table 1 Dividing breast ultrasound data sets mAP提高2.13%,这是由于DownSample模块在 数据集 良性 恶性 共计 定程度上克服了3×3下采样容易丢失特征的缺 训练 719 1236 1955 陷;YOLOV3(3)良恶性AP相对于YOLOv3(2)提 验证 240 412 652 高了0.99%和0.56%,mAP提高0.775%,这是由 测试 于残差密集网络充分利用了前面所有层特征; 240 412 652 合计 YOLOv3(3)相对YOLOv3良恶性AP提高了 1199 2060 3259 3.76%和5.37%,mAP提高了4.56%,证实了本文4 实验与分析 本文在 Ubuntu 16.04 操作系统下完成软件环 境平台的搭建和实验,GPU 选用 NVIDIA GeForce 1080Ti,软件:Python (3.6);keras ≥ 2.1.5; tensorflow-gpu (≥ 1.4.1)。 4.1 数据集 本文实验采用的乳腺超声数据是由专业医生 从相关医院的数据库选取从 2015-2019 年不同年 龄层次、地区和人种的 2 011 例原始病例,共计有 13 586 张原始图像,图像大小为 768×576,如图 7 所示,经过专业医生筛选剔除后,得到含有肿瘤 的有效图片共计 3 259 例,其中良性患者共计 1 199 例,恶性患者共计 2 060 例,考虑到虽然原始图像 边框中含有较多的标注信息,如影像保存时间、 超声探头发射频率、探测深度和部位,同时标注 位置不固定,但为了提高算法的鲁棒性,方便实 际应用,本实验不再进行人工的区域裁剪,而是 直接使用经过筛选的原始图片作为目标图片。 图 7 超声乳腺肿瘤原始图像 Fig. 7 Original ultrasound images of breast tumor 该数据库中除了包含有图像信息外,还提供 了所有病例的病理诊断结果,其良恶性均经过活 检证实,经过专业医生借助 ImageLab 软件结合病 例信息对进行肿瘤位置和类别标注,生成的 PASCAL VOC 格式的文件构建了本实验所需的乳腺 肿瘤数据集,考虑到数据集较小,直接将数据集 按照 3∶1∶1 分成训练集、验证集和测试集,其中训 练集 1 955 张,良性 719 张、恶性 1 236 张;测试集 652 张,良性 240 张、恶性 412;验证集 652 张,良 性 240 张、恶性 412,如表 1 所示。 表 1 乳腺超声数据集划分 Table 1 Dividing breast ultrasound data sets 数据集 良性 恶性 共计 训练 719 1 236 1955 验证 240 412 652 测试 240 412 652 合计 1199 2 060 3259 4.2 实验结果及分析 本文采用了与 YOLOv3[20] 相同的损失函数, 整体的损失函数由 3 部分组成:类别误差、置信 度误差以及目标框误差。为了加快网络的训练速 度和防止过拟合,本文采用 Adma 算法来做梯度 优化,其中设置初始学习率为 0.001,每 100 次迭 代后学习率衰减为原来的 1/10,冲量为 0.9,衰减 系数为 0.0 002,epoch 设置为 25,batch size 设置 为 8,之后对原始的 YOLOv3 和不同配置的 YOLOv3 算法在预训练模型上进行训练,不同配置的 YOLOv3 算法见表 2 所示,其中 YOLOv3(1) 表示在原 YOLOv3 算法上引入 SE-Res2Net 网络,YOLOv3(2) 表示在 原 YOLOv3 上引入 SE-ResNet 和 Downsample 下 采样模块,YOLOv3(3) 表示在 YOLOv3 上引入 SE-Res2Net、Downsample 下采样模块和残差密集 网络,最后通过查准率−查全率 (precision-recall, PR) 曲线、精度均值 (average precision, AP) 和平均 精度均值 (mean average precision, mAP) 评价模型 的性能。 表 2 不同配置的 YOLOv3 算法 Table 2 YOLOV3 algorithm with different configurations 算法 引入SE-Res2Net 的残差网络 引入Downsample 下采样模块 引入残差 密集网络 YOLOv3 × × × YOLOv3(1) √ × × YOLOv3(2) √ √ × YOLOv3(3) √ √ √ 1) AP 和 mAP 待训练完成后将模型分别在测试集测试,得 到良性样本的 PR 曲线和恶性样本的 PR 曲线如 图 8、9 所示,之后通过计算 PR 曲线下的面积可 得到良恶性样本的 AP,YOLOv3(1) 良恶性 AP 相 对 YOLOV3 算法提高 1.59% 和 1.73%,其 mAP 提 高 1.66%,这是因为 Res2Net 在单层内增加了尺 度,充分利用了单层内的特征;YOLOv3(2) 良恶 性 AP 相对于 YOLOv3(1) 提高了 1.18% 和 3.08%, mAP 提高 2.13%,这是由于 DownSample 模块在一 定程度上克服了 3×3 下采样容易丢失特征的缺 陷;YOLOV3(3) 良恶性 AP 相对于 YOLOv3(2) 提 高了 0.99% 和 0.56%,mAP 提高 0.775%,这是由 于残差密集网络充分利用了前面所有层特征; YOLOv3(3) 相对 YOLOv3 良恶性 AP 提高了 3.76% 和 5.37%,mAP 提高了 4.56%,证实了本文 ·26· 智 能 系 统 学 报 第 16 卷