正在加载图片...

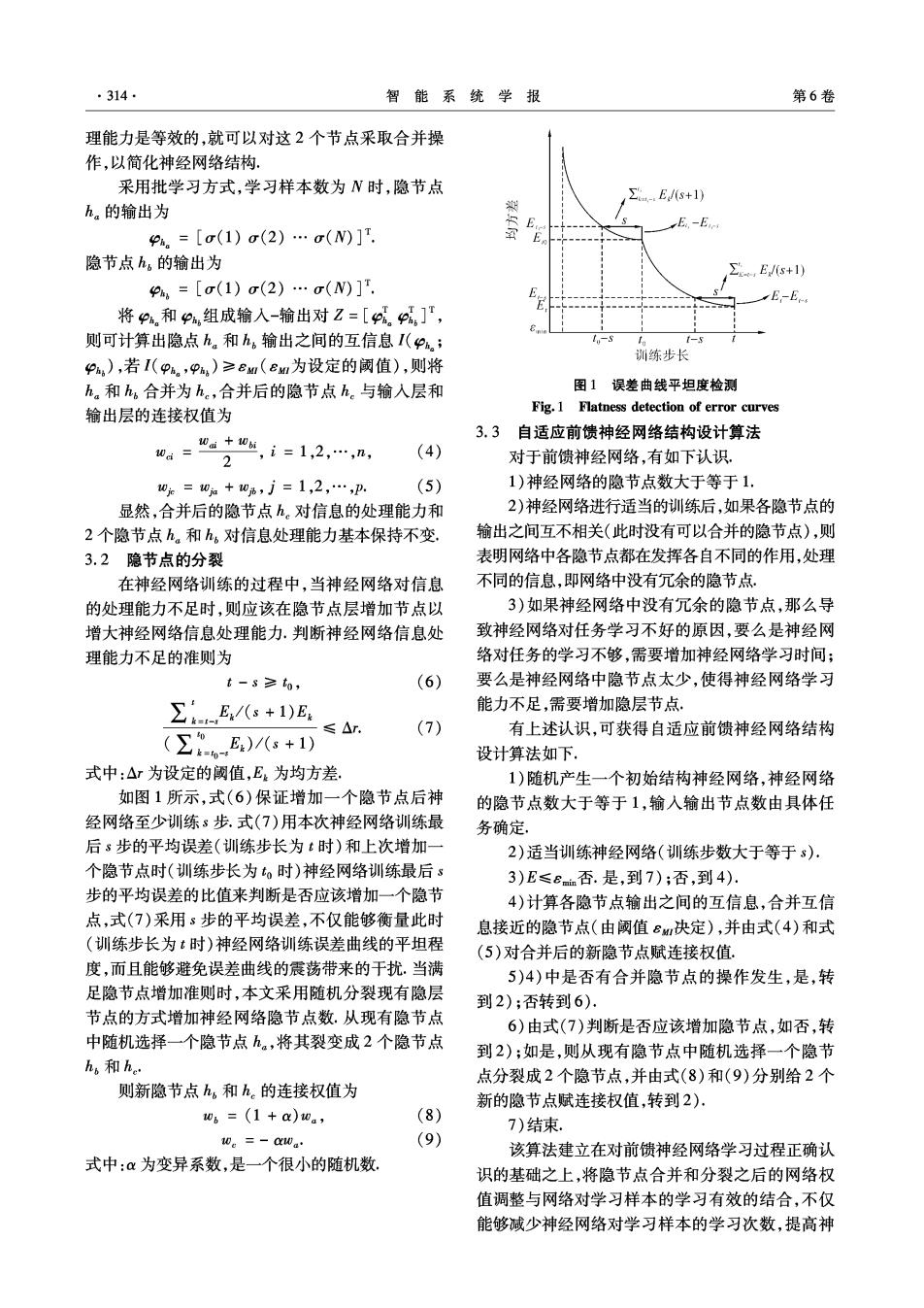

·314 智能系统学报 第6卷 理能力是等效的,就可以对这2个节点采取合并操 作,以简化神经网络结构. 采用批学习方式,学习样本数为N时,隐节点 -.E/+1) h。的输出为 救 E-Ec Pa。=[o(1)σ(2)…σ(N)]T. E 隐节点h,的输出为 E/s+1) P=[o(1)o(2)…σ(N)]T E-E 将P和Pa,组成输人-输出对Z=[。p]T, 则可计算出隐点h。和h,输出之间的互信息I(P,; t-s t-s 训练步长 Pa,),若I(P%。,P,)≥EM(eM如为设定的阈值),则将 ha和h,合并为hc,合并后的隐节点h。与输入层和 图1误差曲线平坦度检测 输出层的连接权值为 Fig.1 Flatness detection of error curves 0a= 0a+0,i=1,2,…,n, 3.3自适应前馈神经网络结构设计算法 (4) 2 对于前馈神经网络,有如下认识 0=0a+06,j=1,2,…,p, (5) 1)神经网络的隐节点数大于等于1. 显然,合并后的隐节点h。对信息的处理能力和 2)神经网络进行适当的训练后,如果各隐节点的 2个隐节点h。和h,对信息处理能力基本保持不变. 输出之间互不相关(此时没有可以合并的隐节点),则 3.2隐节点的分裂 表明网络中各隐节点都在发挥各自不同的作用,处理 在神经网络训练的过程中,当神经网络对信息 不同的信息,即网络中没有冗余的隐节点。 的处理能力不足时,则应该在隐节点层增加节点以 3)如果神经网络中没有冗余的隐节点,那么导 增大神经网络信息处理能力.判断神经网络信息处 致神经网络对任务学习不好的原因,要么是神经网 理能力不足的准则为 络对任务的学习不够,需要增加神经网络学习时间: t-s≥to, (6) 要么是神经网络中隐节点太少,使得神经网络学习 /(+1)E. 能力不足,需要增加隐层节点. ≤△r (7) (∑)(s+1 有上述认识,可获得自适应前馈神经网络结构 设计算法如下, 式中:△r为设定的阈值,E。为均方差, 1)随机产生一个初始结构神经网络,神经网络 如图1所示,式(6)保证增加一个隐节点后神 的隐节点数大于等于1,输入输出节点数由具体任 经网络至少训练s步.式(7)用本次神经网络训练最 务确定, 后s步的平均误差(训练步长为t时)和上次增加一 2)适当训练神经网络(训练步数大于等于s), 个隐节点时(训练步长为。时)神经网络训练最后s 3)E≤e否.是,到7);否,到4). 步的平均误差的比值来判断是否应该增加一个隐节 4)计算各隐节点输出之间的互信息,合并互信 点,式(7)采用s步的平均误差,不仅能够衡量此时 息接近的隐节点(由阈值B知决定),并由式(4)和式 (圳练步长为t时)神经网络训练误差曲线的平坦程 (5)对合并后的新隐节点赋连接权值. 度,而且能够避免误差曲线的震荡带来的干扰.当满 5)4)中是否有合并隐节点的操作发生,是,转 足隐节点增加准则时,本文采用随机分裂现有隐层 到2);否转到6), 节点的方式增加神经网络隐节点数,从现有隐节点 6)由式(7)判断是否应该增加隐节点,如否,转 中随机选择一个隐节点h,将其裂变成2个隐节点 到2):如是,则从现有隐节点中随机选择一个隐节 h。和h. 点分裂成2个隐节点,并由式(8)和(9)分别给2个 则新隐节点h,和h。的连接权值为 新的隐节点赋连接权值,转到2)· 06=(1+a)0., (8) 7)结束. 0。=-a0a (9) 该算法建立在对前馈神经网络学习过程正确认 式中:α为变异系数,是一个很小的随机数 识的基础之上,将隐节点合并和分裂之后的网络权 值调整与网络对学习样本的学习有效的结合,不仅 能够减少神经网络对学习样本的学习次数,提高神