正在加载图片...

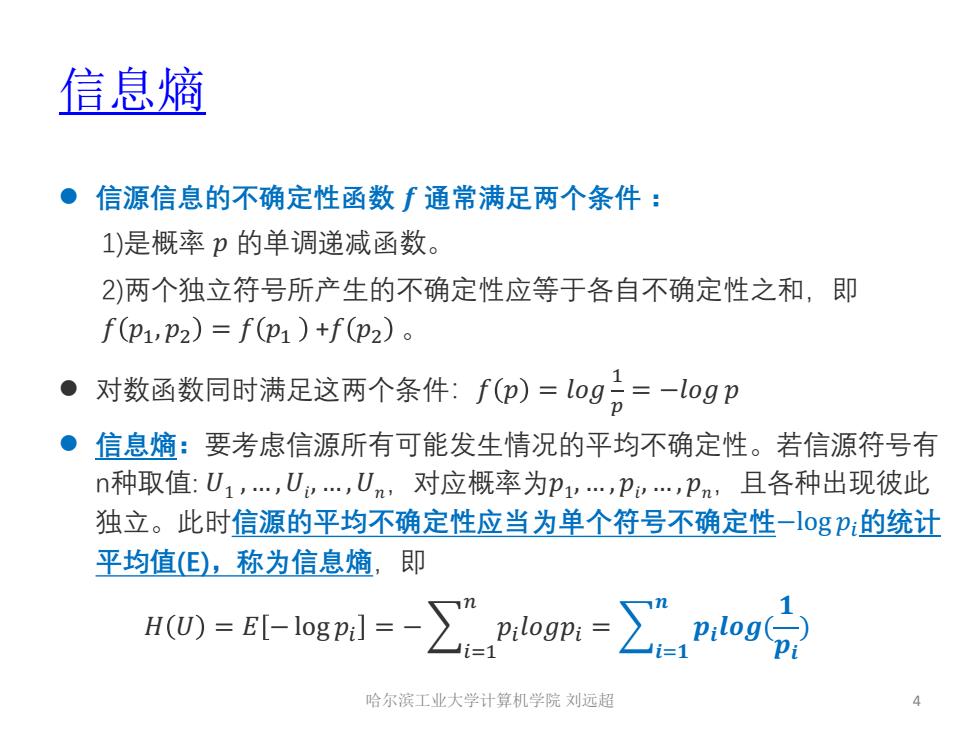

信息熵 ●信源信息的不确定性函数∫通常满足两个条件: 1)是概率p的单调递减函数。 2)两个独立符号所产生的不确定性应等于各自不确定性之和,即 f(p1,p2)=f(p1)+f(p2)。 ·对数函数同时满足这两个条件:fp)=log=-1ogp ●信息熵:要考虑信源所有可能发生情况的平均不确定性。若信源符号有 n种取值:U1,…,U,Un,对应概率为p1,…,p…,卫n,且各种出现彼此 独立。此时信源的平均不确定性应当为单个符号不确定性-1ogP:的统计 平均值(),称为信息熵,即 H0=E-logl=-∑nogm=∑,nlog合 哈尔滨工业大学计算机学院刘远超 4信息熵 l 信源信息的不确定性函数 � 通常满⾜两个条件 : 1)是概率 � 的单调递减函数。 2)两个独⽴符号所产⽣的不确定性应等于各⾃不确定性之和,即 � �!, �" = � �! +� �" 。 l 对数函数同时满⾜这两个条件:� � = ��� ! # = −��� � l 信息熵:要考虑信源所有可能发⽣情况的平均不确定性。若信源符号有 n种取值: �1 , … ,�� , … ,��,对应概率为�1, … , �� , … , ��,且各种出现彼此 独⽴。此时信源的平均不确定性应当为单个符号不确定性−log �$的统计 平均值(E),称为信息熵,即 � � = � − log �$ = −1$%! & �$����$ = 1�%� � �����( � �� ) 哈尔滨工业大学计算机学院 刘远超 4