正在加载图片...

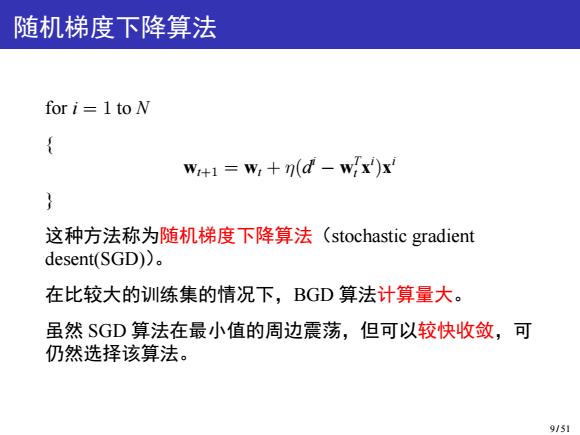

随机梯度下降算法 for i =1 to N W+1=W+n(d-wix')x 这种方法称为随机梯度下降算法(stochastic gradient desent(SGD)). 在比较大的训练集的情况下,BGD算法计算量大。 虽然SGD算法在最小值的周边震荡,但可以较快收敛,可 仍然选择该算法。 9/51随机梯度下降算法 for i = 1 to N { wt+1 = wt + η(d i − w T t x i )x i } 这种方法称为随机梯度下降算法(stochastic gradient desent(SGD))。 在比较大的训练集的情况下,BGD 算法计算量大。 虽然 SGD 算法在最小值的周边震荡,但可以较快收敛,可 仍然选择该算法。 9 / 51