正在加载图片...

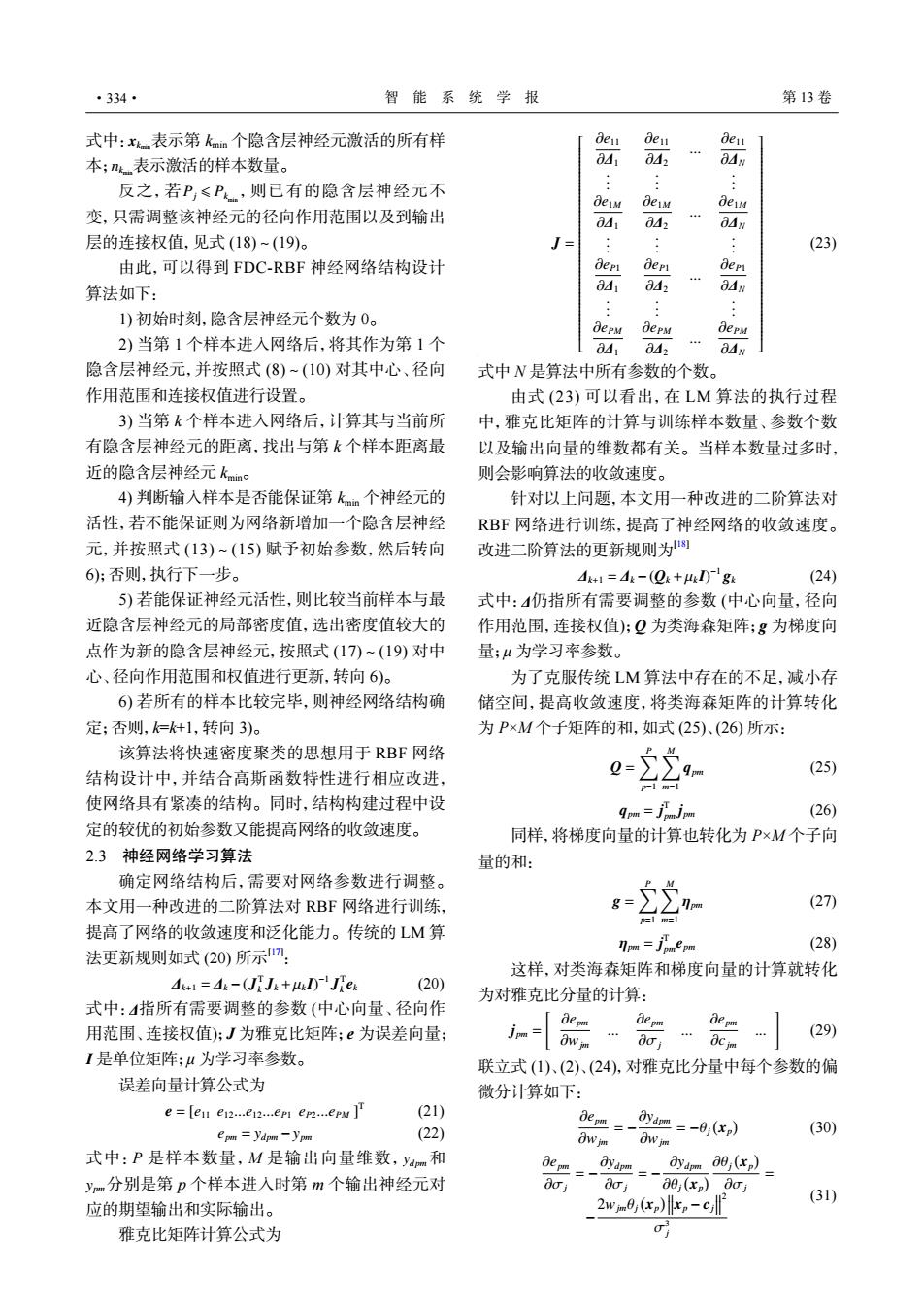

·334· 智能系统学报 第13卷 式中:x表示第kmm个隐含层神经元激活的所有样 den ben Ben 本;表示激活的样本数量。 OA 84 OAN 反之,若P,≤P,则已有的隐含层神经元不 deM deM deiM 变,只需调整该神经元的径向作用范围以及到输出 0d1 04 OAN 层的连接权值,见式(18)~(19)。 (23) 由此,可以得到FDC-RBF神经网络结构设计 depL dep dep 算法如下: OA 04 444 OAN 1)初始时刻,隐含层神经元个数为0。 depM bepM oepM 2)当第1个样本进入网络后,将其作为第1个 0d1 0d2 OAN 隐含层神经元,并按照式(8)~(10)对其中心、径向 式中N是算法中所有参数的个数。 作用范围和连接权值进行设置。 由式(23)可以看出,在LM算法的执行过程 3)当第k个样本进入网络后,计算其与当前所 中,雅克比矩阵的计算与训练样本数量、参数个数 有隐含层神经元的距离,找出与第k个样本距离最 以及输出向量的维数都有关。当样本数量过多时, 近的隐含层神经元kmno 则会影响算法的收敛速度。 4)判断输入样本是否能保证第kmm个神经元的 针对以上问题,本文用一种改进的二阶算法对 活性,若不能保证则为网络新增加一个隐含层神经 RBF网络进行训练,提高了神经网络的收敛速度。 元,并按照式(13)~(15)赋予初始参数,然后转向 改进二阶算法的更新规则为 6);否则,执行下一步。 4k+1=4-(Q+4IDg (24) 5)若能保证神经元活性,则比较当前样本与最 式中:仍指所有需要调整的参数(中心向量,径向 近隐含层神经元的局部密度值,选出密度值较大的 作用范围,连接权值):Q为类海森矩阵;g为梯度向 点作为新的隐含层神经元,按照式(17)~(19)对中 量;4为学习率参数。 心、径向作用范围和权值进行更新,转向6)。 为了克服传统LM算法中存在的不足,减小存 6)若所有的样本比较完毕,则神经网络结构确 储空间,提高收敛速度,将类海森矩阵的计算转化 定;否则,=+1,转向3)。 为P×M个子矩阵的和,如式(25)、(26)所示: 该算法将快速密度聚类的思想用于RBF网络 结构设计中,并结合高斯函数特性进行相应改进, (25) p1m= 使网络具有紧凑的结构。同时,结构构建过程中设 9pm-jajpm (26) 定的较优的初始参数又能提高网络的收敛速度。 同样,将梯度向量的计算也转化为P×M个子向 2.3神经网络学习算法 量的和: 确定网络结构后,需要对网络参数进行调整。 P M 本文用一种改进的二阶算法对RBF网络进行训练, 2 g= (27) 提高了网络的收敛速度和泛化能力。传统的LM算 法更新规则如式(20)所示7: fmm-jepm (28) 这样,对类海森矩阵和梯度向量的计算就转化 A=A:-(JJ:+l)Je (20) 为对雅克比分量的计算: 式中:4指所有需要调整的参数(中心向量、径向作 用范围、连接权值);J为雅克比矩阵;e为误差向量; jpm= de pm de pm ow im 0o… (29) OCim I是单位矩阵;4为学习率参数。 联立式(1)、(2)、(24),对雅克比分量中每个参数的偏 误差向量计算公式为 微分计算如下: e=ten en...en...er en...eru] (21) epn ydpm -ypm (22) _ydm=-0(xp) (30) Ow jm Owim 式中:P是样本数量,M是输出向量维数,yam和 4e=-4m0,c2 ym分别是第p个样本进入时第m个输出神经元对 doi 00;(xp)oi 2wmej(xp)xp-cjl (31) 应的期望输出和实际输出。 雅克比矩阵计算公式为 0xkmin nkmin 式中: 表示第 kmin 个隐含层神经元激活的所有样 本; 表示激活的样本数量。 Pj ⩽ Pk 反之,若 min ,则已有的隐含层神经元不 变,只需调整该神经元的径向作用范围以及到输出 层的连接权值,见式 (18)~(19)。 由此,可以得到 FDC-RBF 神经网络结构设计 算法如下: 1) 初始时刻,隐含层神经元个数为 0。 2) 当第 1 个样本进入网络后,将其作为第 1 个 隐含层神经元,并按照式 (8)~(10) 对其中心、径向 作用范围和连接权值进行设置。 3) 当第 k 个样本进入网络后,计算其与当前所 有隐含层神经元的距离,找出与第 k 个样本距离最 近的隐含层神经元 kmin。 4) 判断输入样本是否能保证第 kmin 个神经元的 活性,若不能保证则为网络新增加一个隐含层神经 元,并按照式 (13)~(15) 赋予初始参数,然后转向 6);否则,执行下一步。 5) 若能保证神经元活性,则比较当前样本与最 近隐含层神经元的局部密度值,选出密度值较大的 点作为新的隐含层神经元,按照式 (17)~(19) 对中 心、径向作用范围和权值进行更新,转向 6)。 6) 若所有的样本比较完毕,则神经网络结构确 定;否则,k=k+1,转向 3)。 该算法将快速密度聚类的思想用于 RBF 网络 结构设计中,并结合高斯函数特性进行相应改进, 使网络具有紧凑的结构。同时,结构构建过程中设 定的较优的初始参数又能提高网络的收敛速度。 2.3 神经网络学习算法 确定网络结构后,需要对网络参数进行调整。 本文用一种改进的二阶算法对 RBF 网络进行训练, 提高了网络的收敛速度和泛化能力。传统的 LM 算 法更新规则如式 (20) 所示[17] : ∆k+1 = ∆k −(J T k Jk +µk I) −1 J T k ek (20) 式中: ∆ 指所有需要调整的参数 (中心向量、径向作 用范围、连接权值);J 为雅克比矩阵;e 为误差向量; I 是单位矩阵;μ 为学习率参数。 误差向量计算公式为 e = [e11 e12...e12...eP1 eP2...ePM ] T (21) epm = yd pm −ypm (22) yd pm ypm 式中:P 是样本数量,M 是输出向量维数, 和 分别是第 p 个样本进入时第 m 个输出神经元对 应的期望输出和实际输出。 雅克比矩阵计算公式为 J = ∂e11 ∂∆1 ∂e11 ∂∆2 ... ∂e11 ∂∆N . . . . . . . . . ∂e1M ∂∆1 ∂e1M ∂∆2 ... ∂e1M ∂∆N . . . . . . . . . ∂eP1 ∂∆1 ∂eP1 ∂∆2 ... ∂eP1 ∂∆N . . . . . . . . . ∂ePM ∂∆1 ∂ePM ∂∆2 ... ∂ePM ∂∆N (23) 式中 N 是算法中所有参数的个数。 由式 (23) 可以看出,在 LM 算法的执行过程 中,雅克比矩阵的计算与训练样本数量、参数个数 以及输出向量的维数都有关。当样本数量过多时, 则会影响算法的收敛速度。 针对以上问题,本文用一种改进的二阶算法对 RBF 网络进行训练,提高了神经网络的收敛速度。 改进二阶算法的更新规则为[18] ∆k+1 = ∆k −(Qk +µk I) −1 gk (24) 式中: ∆ 仍指所有需要调整的参数 (中心向量,径向 作用范围,连接权值);Q 为类海森矩阵;g 为梯度向 量;μ 为学习率参数。 为了克服传统 LM 算法中存在的不足,减小存 储空间,提高收敛速度,将类海森矩阵的计算转化 为 P×M 个子矩阵的和,如式 (25)、(26) 所示: Q = ∑P p=1 ∑M m=1 qpm (25) qpm = j T pm jpm (26) 同样,将梯度向量的计算也转化为 P×M 个子向 量的和: g = ∑P p=1 ∑M m=1 ηpm (27) ηpm = j T pmepm (28) 这样,对类海森矩阵和梯度向量的计算就转化 为对雅克比分量的计算: jpm = [ ∂epm ∂wjm ... ∂epm ∂σj ... ∂epm ∂cjm ... ] (29) 联立式 (1)、(2)、(24),对雅克比分量中每个参数的偏 微分计算如下: ∂epm ∂wjm = − ∂yd pm ∂wjm = −θj ( xp ) (30) ∂epm ∂σj = − ∂yd pm ∂σj = − ∂yd pm ∂θj ( xp ) ∂θj ( xp ) ∂σj = − 2wjmθj ( xp ) xp − cj 2 σ 3 j (31) ·334· 智 能 系 统 学 报 第 13 卷