正在加载图片...

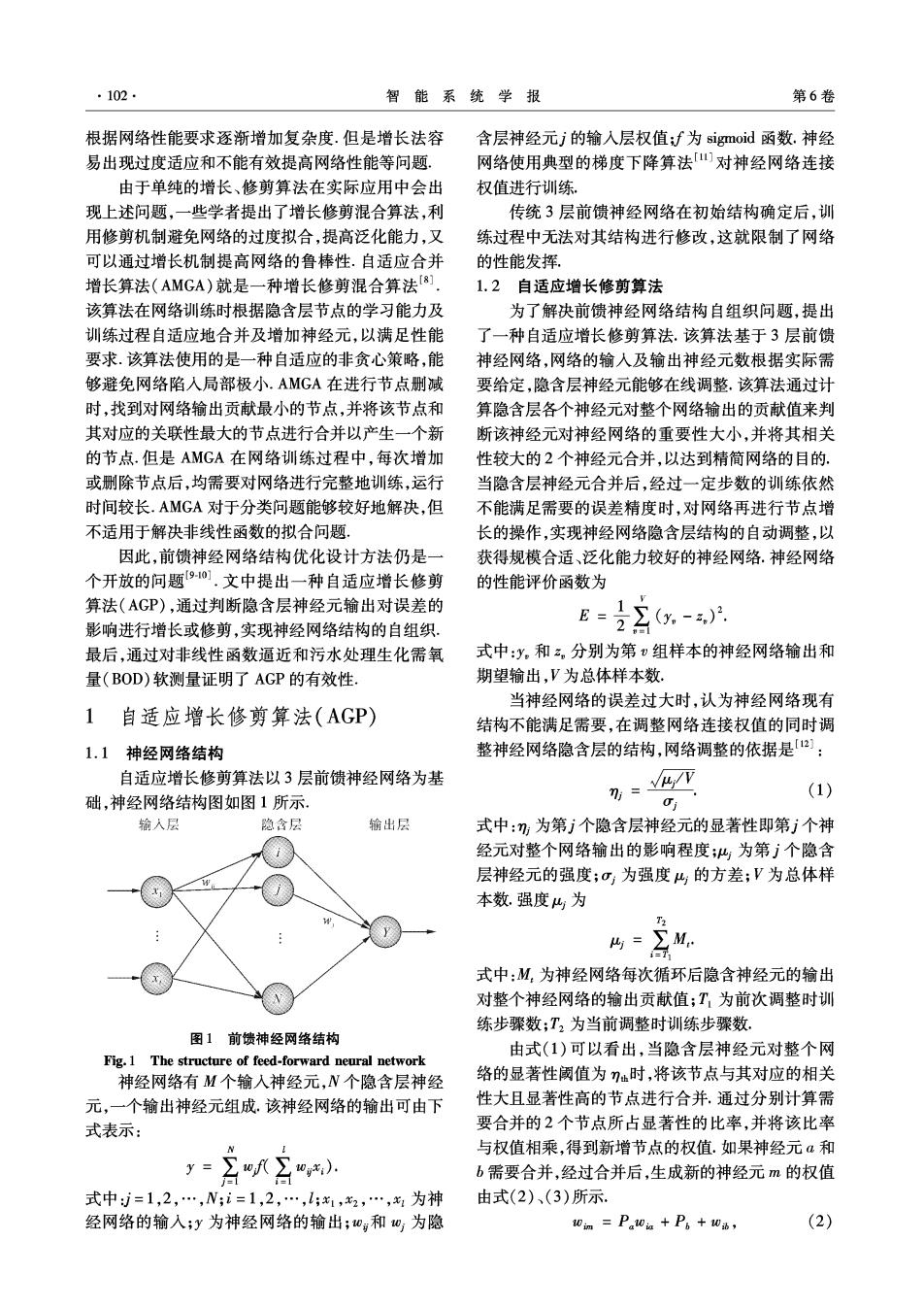

·102 智能系统学报 第6卷 根据网络性能要求逐渐增加复杂度.但是增长法容 含层神经元j的输入层权值:f为sigmoid函数.神经 易出现过度适应和不能有效提高网络性能等问题. 网络使用典型的梯度下降算法山对神经网络连接 由于单纯的增长、修剪算法在实际应用中会出 权值进行训练。 现上述问题,一些学者提出了增长修剪混合算法,利 传统3层前馈神经网络在初始结构确定后,训 用修剪机制避免网络的过度拟合,提高泛化能力,又 练过程中无法对其结构进行修改,这就限制了网络 可以通过增长机制提高网络的鲁棒性.自适应合并 的性能发挥。 增长算法(AMGA)就是一种增长修剪混合算法], 1.2自适应增长修剪算法 该算法在网络训练时根据隐含层节点的学习能力及 为了解决前馈神经网络结构自组织问题,提出 训练过程自适应地合并及增加神经元,以满足性能 了一种自适应增长修剪算法.该算法基于3层前馈 要求.该算法使用的是一种自适应的非贪心策略,能 神经网络,网络的输人及输出神经元数根据实际需 够避免网络陷入局部极小.AMGA在进行节点删减 要给定,隐含层神经元能够在线调整.该算法通过计 时,找到对网络输出贡献最小的节点,并将该节点和 算隐含层各个神经元对整个网络输出的贡献值来判 其对应的关联性最大的节点进行合并以产生一个新 断该神经元对神经网络的重要性大小,并将其相关 的节点.但是AMGA在网络训练过程中,每次增加 性较大的2个神经元合并,以达到精简网络的目的. 或删除节点后,均需要对网络进行完整地训练,运行 当隐含层神经元合并后,经过一定步数的训练依然 时间较长.AMGA对于分类问题能够较好地解决,但 不能满足需要的误差精度时,对网络再进行节点增 不适用于解决非线性函数的拟合问题, 长的操作,实现神经网络隐含层结构的自动调整,以 因此,前馈神经网络结构优化设计方法仍是一 获得规模合适、泛化能力较好的神经网络.神经网络 个开放的问题90.文中提出一种自适应增长修剪 的性能评价函数为 算法(AGP),通过判断隐含层神经元输出对误差的 E= 影响进行增长或修剪,实现神经网络结构的自组织, 2-月 最后,通过对非线性函数逼近和污水处理生化需氧 式中:y和2,分别为第v组样本的神经网络输出和 量(BOD)软测量证明了AGP的有效性 期望输出,V为总体样本数. 当神经网络的误差过大时,认为神经网络现有 1自适应增长修剪算法(AGP) 结构不能满足需要,在调整网络连接权值的同时调 1.1神经网络结构 整神经网络隐含层的结构,网络调整的依据是21: 自适应增长修剪算法以3层前馈神经网络为基 7-4/P (1) 础,神经网络结构图如图1所示 输入层 隐含层 输出层 式中:;为第j个隐含层神经元的显著性即第j个神 经元对整个网络输出的影响程度;4为第j个隐含 层神经元的强度;σ为强度的方差;V为总体样 本数.强度4为 T2 4=∑M 71 式中:M为神经网络每次循环后隐含神经元的输出 对整个神经网络的输出贡献值;T为前次调整时训 练步骤数;T,为当前调整时训练步骤数, 图1。前馈神经网络结构 由式(1)可以看出,当隐含层神经元对整个网 Fig.1 The structure of feed-forward neural network 神经网络有M个输入神经元,W个隐含层神经 络的显著性阈值为η仙时,将该节点与其对应的相关 元,一个输出神经元组成.该神经网络的输出可由下 性大且显著性高的节点进行合并,通过分别计算需 式表示: 要合并的2个节点所占显著性的比率,并将该比率 与权值相乘,得到新增节点的权值.如果神经元α和 y=∑of∑0gx) b需要合并,经过合并后,生成新的神经元m的权值 式中j=1,2,…,N;i=1,2,…,11,2,…,为神 由式(2)、(3)所示. 经网络的输人;y为神经网络的输出;0:和0为隐 0m=P.0a+P6+0h, (2)