正在加载图片...

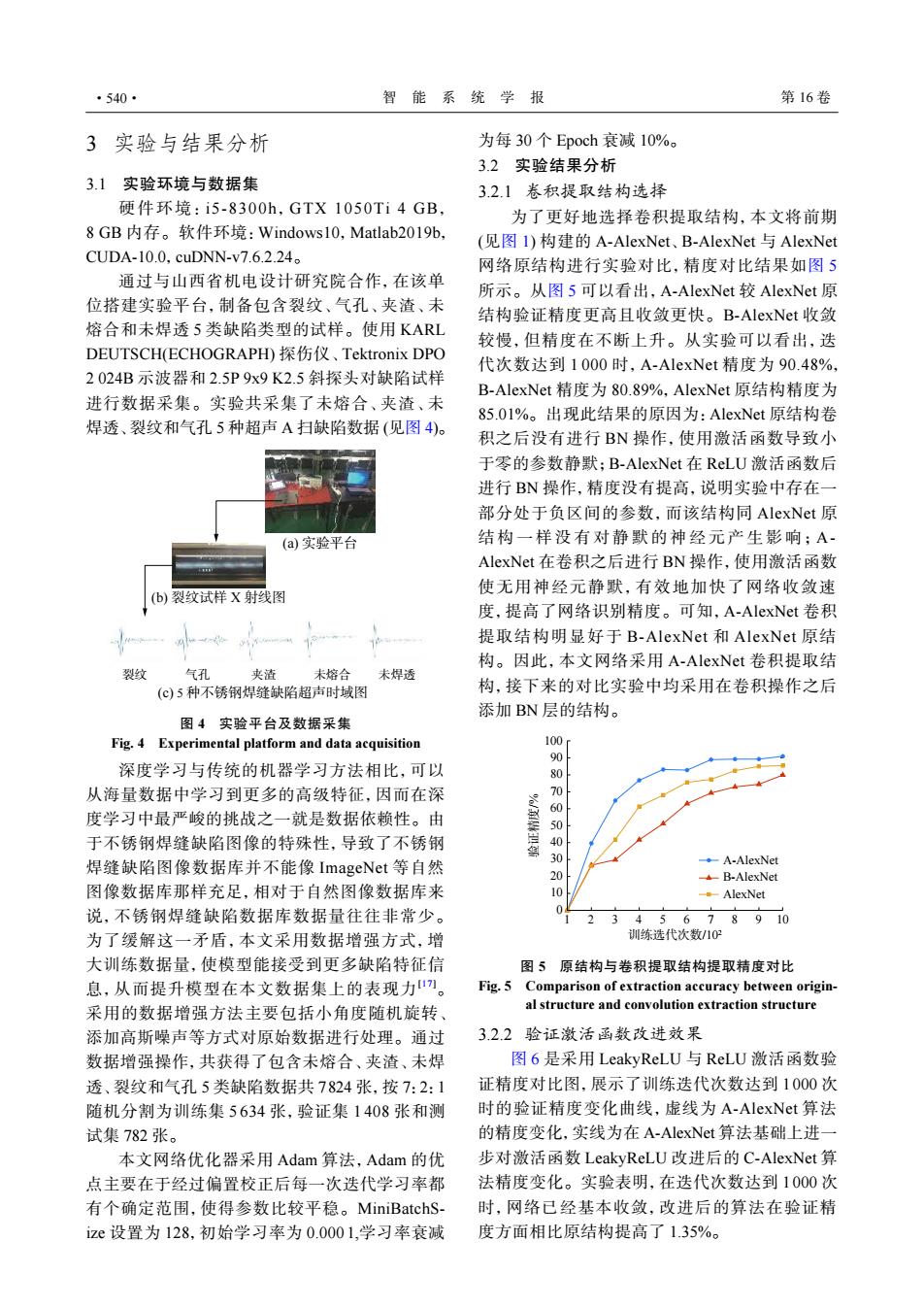

·540· 智能系统学报 第16卷 3实验与结果分析 为每30个Epoch衰减10%。 3.2实验结果分析 3.1实验环境与数据集 3.2.1卷积提取结构选择 硬件环境:i5-8300h,GTX1050Ti4GB, 为了更好地选择卷积提取结构,本文将前期 8GB内存。软件环境:Windows10,Matlab2019b, (见图lI)构建的A-AlexNet、.B-AlexNet与AlexNet CUDA-10.0.cuDNN-v7.6.2.24. 网络原结构进行实验对比,精度对比结果如图5 通过与山西省机电设计研究院合作,在该单 所示。从图5可以看出,A-AlexNet较AlexNet原 位搭建实验平台,制备包含裂纹、气孔、夹渣、未 结构验证精度更高且收敛更快。B-AlexNet收敛 熔合和未焊透5类缺陷类型的试样。使用KARL 较慢,但精度在不断上升。从实验可以看出,迭 DEUTSCH(ECHOGRAPH)探伤仪、Tektronix DPO 代次数达到1000时,A-AlexNet精度为90.48%, 2024B示波器和2.5P9x9K2.5斜探头对缺陷试样 B-AlexNet精度为80.89%,AlexNet原结构精度为 进行数据采集。实验共采集了未熔合、夹渣、未 85.01%。出现此结果的原因为:AlexNet原结构卷 焊透、裂纹和气孔5种超声A扫缺陷数据(见图4)。 积之后没有进行BN操作,使用激活函数导致小 于零的参数静默;B-AlexNet在ReLU激活函数后 进行BN操作,精度没有提高,说明实验中存在一 部分处于负区间的参数,而该结构同AlexNet原 (a)实验平台 结构一样没有对静默的神经元产生影响;A- AlexNet在卷积之后进行BN操作,使用激活函数 (b)裂纹试样X射线图 使无用神经元静默,有效地加快了网络收敛速 度,提高了网络识别精度。可知,A-AlexNet卷积 提取结构明显好于B-AlexNet和AlexNet原结 构。因此,本文网络采用A-AlexNet卷积提取结 裂纹 气孔 夹渣 未熔合 未焊透 (©)5种不锈钢焊缝缺陷超声时域图 构,接下来的对比实验中均采用在卷积操作之后 添加BN层的结构。 图4实验平台及数据采集 Fig.4 Experimental platform and data acquisition 100 深度学习与传统的机器学习方法相比,可以 从海量数据中学习到更多的高级特征,因而在深 70 60 度学习中最严峻的挑战之一就是数据依赖性。由 50 于不锈钢焊缝缺陷图像的特殊性,导致了不锈钢 40 焊缝缺陷图像数据库并不能像ImageNet等自然 30 ◆-A-AlexNet 20 B-AlexNet 图像数据库那样充足,相对于自然图像数据库来 10 。-AlexNet 说,不锈钢焊缝缺陷数据库数据量往往非常少。 345678910 为了缓解这一矛盾,本文采用数据增强方式,增 训练选代次数/10? 大训练数据量,使模型能接受到更多缺陷特征信 图5原结构与卷积提取结构提取精度对比 息,从而提升模型在本文数据集上的表现力”。 Fig.5 Comparison of extraction accuracy between origin- 采用的数据增强方法主要包括小角度随机旋转、 al structure and convolution extraction structure 添加高斯噪声等方式对原始数据进行处理。通过 32.2验证激活函数改进效果 数据增强操作,共获得了包含未熔合、夹渣、未焊 图6是采用LeakyReLU与ReLU激活函数验 透、裂纹和气孔5类缺陷数据共7824张,按7:2:1 证精度对比图,展示了训练迭代次数达到1000次 随机分割为训练集5634张,验证集1408张和测 时的验证精度变化曲线,虚线为A-AlexNet算法 试集782张。 的精度变化,实线为在A-AlexNet算法基础上进一 本文网络优化器采用Adam算法,Adam的优 步对激活函数LeakyReLU改进后的C-AlexNet算 点主要在于经过偏置校正后每一次迭代学习率都 法精度变化。实验表明.在迭代次数达到1000次 有个确定范围,使得参数比较平稳。MiniBatchS- 时,网络已经基本收敛,改进后的算法在验证精 ize设置为128,初始学习率为0.0001,学习率衰减 度方面相比原结构提高了135%。3 实验与结果分析 3.1 实验环境与数据集 硬件环境: i5-8300h, GTX 1050Ti 4 GB, 8 GB 内存。软件环境:Windows10,Matlab2019b, CUDA-10.0,cuDNN-v7.6.2.24。 通过与山西省机电设计研究院合作,在该单 位搭建实验平台,制备包含裂纹、气孔、夹渣、未 熔合和未焊透 5 类缺陷类型的试样。使用 KARL DEUTSCH(ECHOGRAPH) 探伤仪、Tektronix DPO 2 024B 示波器和 2.5P 9x9 K2.5 斜探头对缺陷试样 进行数据采集。实验共采集了未熔合、夹渣、未 焊透、裂纹和气孔 5 种超声 A 扫缺陷数据 (见图 4)。 裂纹 气孔 夹渣 未熔合 未焊透 (a) 实验平台 (b) 裂纹试样 X 射线图 (c) 5 种不锈钢焊缝缺陷超声时域图 图 4 实验平台及数据采集 Fig. 4 Experimental platform and data acquisition 深度学习与传统的机器学习方法相比,可以 从海量数据中学习到更多的高级特征,因而在深 度学习中最严峻的挑战之一就是数据依赖性。由 于不锈钢焊缝缺陷图像的特殊性,导致了不锈钢 焊缝缺陷图像数据库并不能像 ImageNet 等自然 图像数据库那样充足,相对于自然图像数据库来 说,不锈钢焊缝缺陷数据库数据量往往非常少。 为了缓解这一矛盾,本文采用数据增强方式,增 大训练数据量,使模型能接受到更多缺陷特征信 息,从而提升模型在本文数据集上的表现力[17]。 采用的数据增强方法主要包括小角度随机旋转、 添加高斯噪声等方式对原始数据进行处理。通过 数据增强操作,共获得了包含未熔合、夹渣、未焊 透、裂纹和气孔 5 类缺陷数据共 7824 张,按 7:2:1 随机分割为训练集 5 634 张,验证集 1 408 张和测 试集 782 张。 本文网络优化器采用 Adam 算法,Adam 的优 点主要在于经过偏置校正后每一次迭代学习率都 有个确定范围,使得参数比较平稳。MiniBatchSize 设置为 128,初始学习率为 0.000 1,学习率衰减 为每 30 个 Epoch 衰减 10%。 3.2 实验结果分析 3.2.1 卷积提取结构选择 为了更好地选择卷积提取结构,本文将前期 (见图 1) 构建的 A-AlexNet、B-AlexNet 与 AlexNet 网络原结构进行实验对比,精度对比结果如图 5 所示。从图 5 可以看出,A-AlexNet 较 AlexNet 原 结构验证精度更高且收敛更快。B-AlexNet 收敛 较慢,但精度在不断上升。从实验可以看出,迭 代次数达到 1 000 时,A-AlexNet 精度为 90.48%, B-AlexNet 精度为 80.89%,AlexNet 原结构精度为 85.01%。出现此结果的原因为:AlexNet 原结构卷 积之后没有进行 BN 操作,使用激活函数导致小 于零的参数静默;B-AlexNet 在 ReLU 激活函数后 进行 BN 操作,精度没有提高,说明实验中存在一 部分处于负区间的参数,而该结构同 AlexNet 原 结构一样没有对静默的神经元产生影响; A - AlexNet 在卷积之后进行 BN 操作,使用激活函数 使无用神经元静默,有效地加快了网络收敛速 度,提高了网络识别精度。可知,A-AlexNet 卷积 提取结构明显好于 B-AlexNet 和 AlexNet 原结 构。因此,本文网络采用 A-AlexNet 卷积提取结 构,接下来的对比实验中均采用在卷积操作之后 添加 BN 层的结构。 A-AlexNet B-AlexNet AlexNet 100 90 80 70 60 50 40 30 20 10 0 1 2 3 4 5 6 7 8 9 10 验证精度/% 训练选代次数/102 图 5 原结构与卷积提取结构提取精度对比 Fig. 5 Comparison of extraction accuracy between original structure and convolution extraction structure 3.2.2 验证激活函数改进效果 图 6 是采用 LeakyReLU 与 ReLU 激活函数验 证精度对比图,展示了训练迭代次数达到 1 000 次 时的验证精度变化曲线,虚线为 A-AlexNet 算法 的精度变化,实线为在 A-AlexNet 算法基础上进一 步对激活函数 LeakyReLU 改进后的 C-AlexNet 算 法精度变化。实验表明,在迭代次数达到 1 000 次 时,网络已经基本收敛,改进后的算法在验证精 度方面相比原结构提高了 1.35%。 ·540· 智 能 系 统 学 报 第 16 卷