正在加载图片...

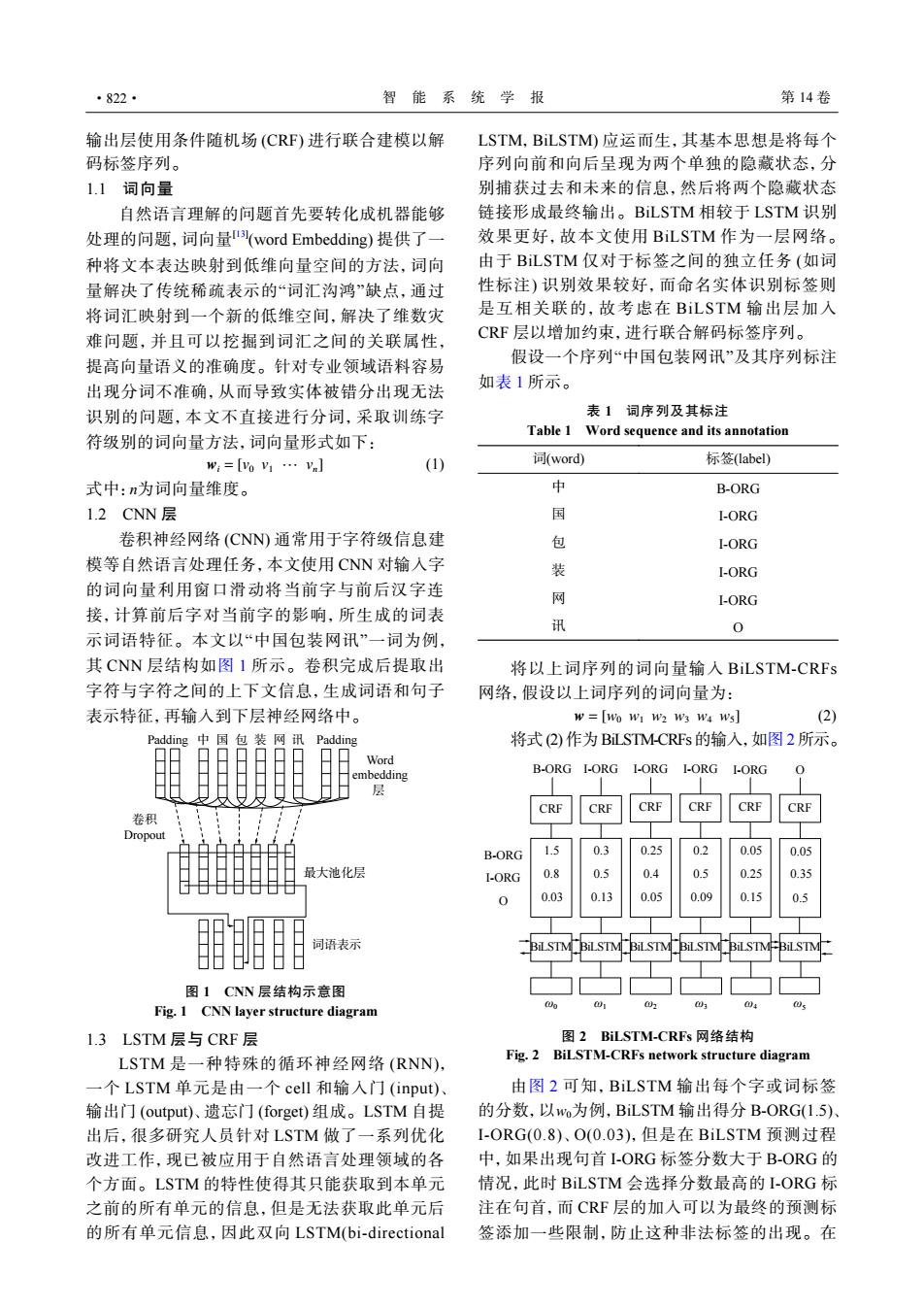

·822· 智能系统学报 第14卷 输出层使用条件随机场(CRF)进行联合建模以解 LSTM,BiLSTM)应运而生,其基本思想是将每个 码标签序列。 序列向前和向后呈现为两个单独的隐藏状态,分 1.1词向量 别捕获过去和未来的信息,然后将两个隐藏状态 自然语言理解的问题首先要转化成机器能够 链接形成最终输出。BiLSTM相较于LSTM识别 处理的问题,词向量(word Embedding)提供了一 效果更好,故本文使用BiLSTM作为一层网络。 种将文本表达映射到低维向量空间的方法,词向 由于BiLSTM仅对于标签之间的独立任务(如词 量解决了传统稀疏表示的“词汇沟鸿”缺点,通过 性标注)识别效果较好,而命名实体识别标签则 将词汇映射到一个新的低维空间,解决了维数灾 是互相关联的,故考虑在BiLSTM输出层加入 难问题,并且可以挖掘到词汇之间的关联属性, CRF层以增加约束,进行联合解码标签序列。 提高向量语义的准确度。针对专业领域语料容易 假设一个序列“中国包装网讯”及其序列标注 出现分词不准确,从而导致实体被错分出现无法 如表1所示。 识别的问题,本文不直接进行分词,采取训练字 表1词序列及其标注 Table 1 Word sequence and its annotation 符级别的词向量方法,词向量形式如下: w:=[yoV1…Vn] (1) 词(word 标签label) 式中:n为词向量维度。 中 B-ORG 1.2CNN层 国 1-ORG 卷积神经网络(CNN)通常用于字符级信息建 包 I-ORG 模等自然语言处理任务,本文使用CNN对输人字 装 I-ORG 的词向量利用窗口滑动将当前字与前后汉字连 网 I-ORG 接,计算前后字对当前字的影响,所生成的词表 讯 0 示词语特征。本文以“中国包装网讯”一词为例, 其CNN层结构如图1所示。卷积完成后提取出 将以上词序列的词向量输入BiLSTM-CRFs 字符与字符之间的上下文信息,生成词语和句子 网络,假设以上词序列的词向量为: 表示特征,再输入到下层神经网络中。 W=Wo WI W2 W3 W4 Ws (2) Padding 中 国 包 装 网 讯 Padding 将式(②)作为BiLSTM-CRFs的输入,如图2所示。 Word embedding B-ORG I-ORG L-ORG L-ORG LORG 】 层 CRF CRF CRE CRE CRF 卷积 Dropout B-ORG 15 03 025 02 005 0.05 最大池化层 I-■RG 0.8 0.s 0.4 0.5 0.25 0.35 0.03 0.13 0.05 0.09 0.15 0.5 词语表示 图1CNN层结构示意图 01 4 O. Fig.1 CNN layer structure diagram 1.3LSTM层与CRF层 图2 BiLSTM-CRFs网络结构 LSTM是一种特殊的循环神经网络(RNN), Fig.2 BiLSTM-CRFs network structure diagram 一个LSTM单元是由一个cell和输人门(input)、 由图2可知,BiLSTM输出每个字或词标签 输出门(output)、遗忘门(forget)组成。LSTM自提 的分数,以wo为例,BiLSTM输出得分B-ORG(1.5)、 出后,很多研究人员针对LSTM做了一系列优化 I-ORG(0.8)、O(0.03),但是在BiLSTM预测过程 改进工作,现已被应用于自然语言处理领域的各 中,如果出现句首I-ORG标签分数大于B-ORG的 个方面。LSTM的特性使得其只能获取到本单元 情况,此时BiLSTM会选择分数最高的I-ORG标 之前的所有单元的信息,但是无法获取此单元后 注在句首,而CRF层的加入可以为最终的预测标 的所有单元信息,因此双向LSTM(bi-directional 签添加一些限制,防止这种非法标签的出现。在输出层使用条件随机场 (CRF) 进行联合建模以解 码标签序列。 1.1 词向量 自然语言理解的问题首先要转化成机器能够 处理的问题,词向量[13] (word Embedding) 提供了一 种将文本表达映射到低维向量空间的方法,词向 量解决了传统稀疏表示的“词汇沟鸿”缺点,通过 将词汇映射到一个新的低维空间,解决了维数灾 难问题,并且可以挖掘到词汇之间的关联属性, 提高向量语义的准确度。针对专业领域语料容易 出现分词不准确,从而导致实体被错分出现无法 识别的问题,本文不直接进行分词,采取训练字 符级别的词向量方法,词向量形式如下: wi = [v0 v1 ··· vn] (1) 式中:n为词向量维度。 1.2 CNN 层 卷积神经网络 (CNN) 通常用于字符级信息建 模等自然语言处理任务,本文使用 CNN 对输入字 的词向量利用窗口滑动将当前字与前后汉字连 接,计算前后字对当前字的影响,所生成的词表 示词语特征。本文以“中国包装网讯”一词为例, 其 CNN 层结构如图 1 所示。卷积完成后提取出 字符与字符之间的上下文信息,生成词语和句子 表示特征,再输入到下层神经网络中。 中 国 包 装 网 Word embedding 层 Padding Padding 卷积 Dropout 最大池化层 词语表示 讯 图 1 CNN 层结构示意图 Fig. 1 CNN layer structure diagram 1.3 LSTM 层与 CRF 层 LSTM 是一种特殊的循环神经网络 (RNN), 一个 LSTM 单元是由一个 cell 和输入门 (input)、 输出门 (output)、遗忘门 (forget) 组成。LSTM 自提 出后,很多研究人员针对 LSTM 做了一系列优化 改进工作,现已被应用于自然语言处理领域的各 个方面。LSTM 的特性使得其只能获取到本单元 之前的所有单元的信息,但是无法获取此单元后 的所有单元信息,因此双向 LSTM(bi-directional LSTM,BiLSTM) 应运而生,其基本思想是将每个 序列向前和向后呈现为两个单独的隐藏状态,分 别捕获过去和未来的信息,然后将两个隐藏状态 链接形成最终输出。BiLSTM 相较于 LSTM 识别 效果更好,故本文使用 BiLSTM 作为一层网络。 由于 BiLSTM 仅对于标签之间的独立任务 (如词 性标注) 识别效果较好,而命名实体识别标签则 是互相关联的,故考虑在 BiLSTM 输出层加入 CRF 层以增加约束,进行联合解码标签序列。 假设一个序列“中国包装网讯”及其序列标注 如表 1 所示。 表 1 词序列及其标注 Table 1 Word sequence and its annotation 词(word) 标签(label) 中 B-ORG 国 I-ORG 包 I-ORG 装 I-ORG 网 I-ORG 讯 O 将以上词序列的词向量输入 BiLSTM-CRFs 网络,假设以上词序列的词向量为: w = [w0 w1 w2 w3 w4 w5] (2) 将式 (2) 作为 BiLSTM-CRFs 的输入,如图 2 所示。 ω0 ω1 ω2 ω3 ω4 ω5 BiLSTM BiLSTM BiLSTM BiLSTM BiLSTM B-ORG I-ORG O 0.3 0.5 0.13 1.5 0.8 0.03 0.25 0.4 0.05 0.2 0.5 0.09 0.05 0.25 0.15 CRF CRF CRF CRF CRF B-ORG I-ORG I-ORG I-ORG I-ORG BiLSTM 0.05 0.35 0.5 CRF O 图 2 BiLSTM-CRFs 网络结构 Fig. 2 BiLSTM-CRFs network structure diagram w0 由图 2 可知,BiLSTM 输出每个字或词标签 的分数,以 为例,BiLSTM 输出得分 B-ORG(1.5)、 I-ORG(0.8)、O(0.03),但是在 BiLSTM 预测过程 中,如果出现句首 I-ORG 标签分数大于 B-ORG 的 情况,此时 BiLSTM 会选择分数最高的 I-ORG 标 注在句首,而 CRF 层的加入可以为最终的预测标 签添加一些限制,防止这种非法标签的出现。在 ·822· 智 能 系 统 学 报 第 14 卷