正在加载图片...

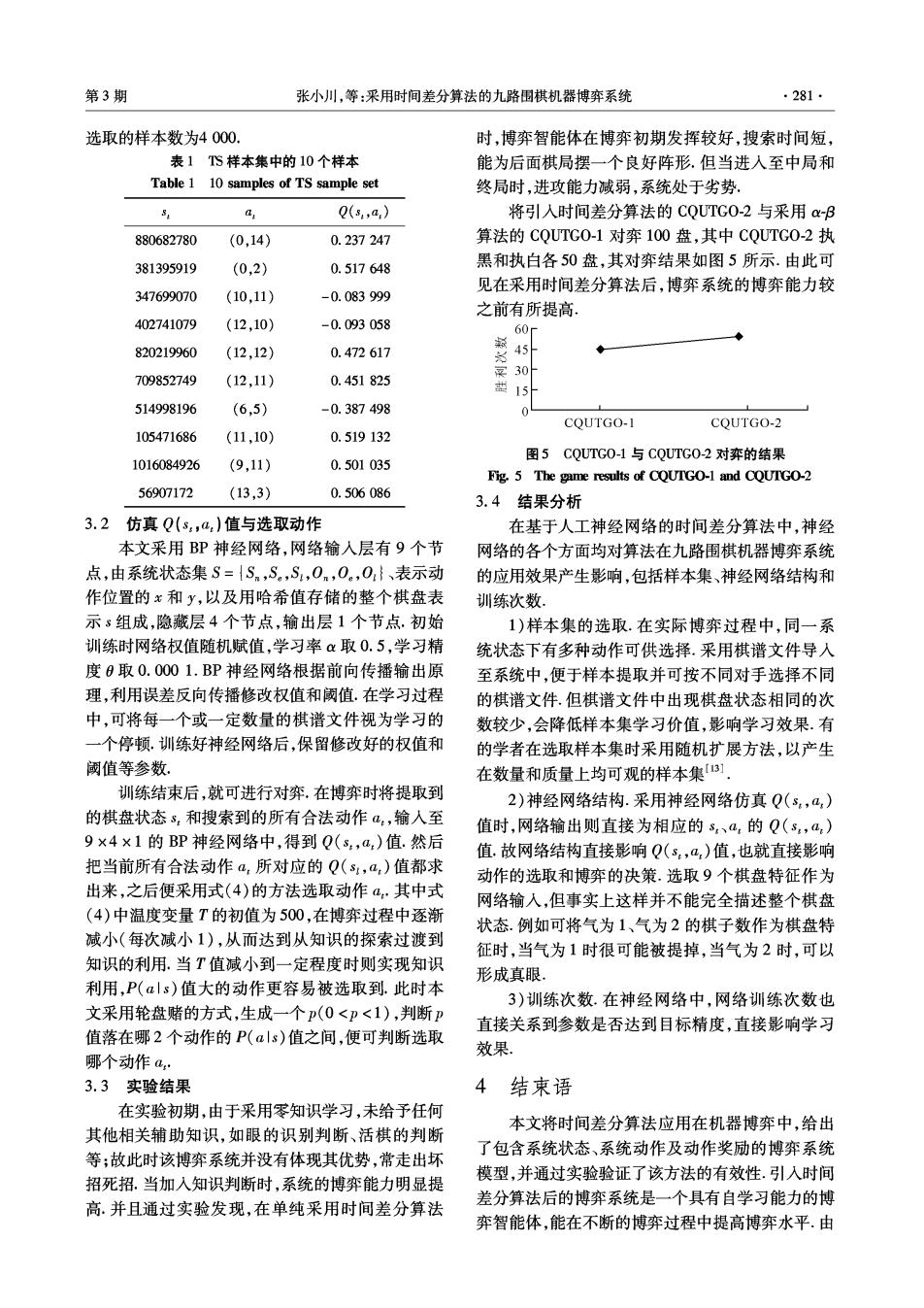

第3期 张小川,等:采用时间差分算法的九路围棋机器博弈系统 ·281· 选取的样本数为4000. 时,博弈智能体在博弈初期发挥较好,搜索时间短, 表1TS样本集中的10个样本 能为后面棋局摆一个良好阵形,但当进入至中局和 Table 1 10 samples of TS sample set 终局时,进攻能力减弱,系统处于劣势 Q(s,a) 将引入时间差分算法的CQUTG0-2与采用aB 880682780 (0,14) 0.237247 算法的CQUTG0-1对弈100盘,其中CQUTG0-2执 381395919 (0,2) 0.517648 黑和执白各50盘,其对弈结果如图5所示.由此可 见在采用时间差分算法后,博弈系统的博弈能力较 347699070 (10,11) -0.083999 之前有所提高。 402741079 (12,10) -0.093058 60 820219960 (12,12) 0.472617 709852749 (12,11) 0.451825 袋 0 15 514998196 (6,5) -0.387498 COUTGO-1 CQUTGO-2 105471686 (11,10) 0.519132 图5C0LUTG0-1与C0UTG0-2对弈的结果 1016084926 (9,11) 0.501035 Fig.5 The game results of CQUTGO-1 and CQUTGO-2 56907172 (13,3) 0.506086 3.4结果分析 3.2 仿真Q(s,a,)值与选取动作 在基于人工神经网络的时间差分算法中,神经 本文采用BP神经网络,网络输入层有9个节 网络的各个方面均对算法在九路围棋机器博弈系统 点,由系统状态集S={Sn,S。,S,0n,0.,0}、表示动 的应用效果产生影响,包括样本集、神经网络结构和 作位置的x和y,以及用哈希值存储的整个棋盘表 训练次数 示s组成,隐藏层4个节点,输出层1个节点.初始 1)样本集的选取.在实际博弈过程中,同一系 训练时网络权值随机赋值,学习率α取0.5,学习精 统状态下有多种动作可供选择.采用棋谱文件导人 度0取0.0001.BP神经网络根据前向传播输出原 至系统中,便于样本提取并可按不同对手选择不同 理,利用误差反向传播修改权值和阈值.在学习过程 的棋谱文件.但棋谱文件中出现棋盘状态相同的次 中,可将每一个或一定数量的棋谱文件视为学习的 数较少,会降低样本集学习价值,影响学习效果.有 一个停顿.训练好神经网络后,保留修改好的权值和 的学者在选取样本集时采用随机扩展方法,以产生 阈值等参数 在数量和质量上均可观的样本集3] 训练结束后,就可进行对弈,在博弈时将提取到 2)神经网络结构.采用神经网络仿真Q(s,a) 的棋盘状态s,和搜索到的所有合法动作a,输入至 值时,网络输出则直接为相应的s、a,的Q(s,a,) 9×4×1的BP神经网络中,得到Q(s,a)值.然后 值.故网络结构直接影响Q(s,a,)值,也就直接影响 把当前所有合法动作a,所对应的Q(s1,a:)值都求 动作的选取和博奔的决策.选取9个棋盘特征作为 出来,之后便采用式(4)的方法选取动作a,其中式 网络输人,但事实上这样并不能完全描述整个棋盘 (4)中温度变量T的初值为500,在博弈过程中逐渐 状态.例如可将气为1、气为2的棋子数作为棋盘特 减小(每次减小1),从而达到从知识的探索过渡到 征时,当气为1时很可能被提掉,当气为2时,可以 知识的利用.当T值减小到一定程度时则实现知识 形成真眼, 利用,P(als)值大的动作更容易被选取到.此时本 3)训练次数.在神经网络中,网络训练次数也 文采用轮盘赌的方式,生成一个p(0<p<1),判断P 直接关系到参数是否达到目标精度,直接影响学习 值落在哪2个动作的P(αls)值之间,便可判断选取 效果 哪个动作a· 3.3实验结果 4结束语 在实验初期,由于采用零知识学习,未给予任何 本文将时间差分算法应用在机器博弈中,给出 其他相关辅助知识,如眼的识别判断、活棋的判断 了包含系统状态、系统动作及动作奖励的博弈系统 等;故此时该博弈系统并没有体现其优势,常走出坏 招死招.当加入知识判断时,系统的博弈能力明显提 模型,并通过实验验证了该方法的有效性.引入时间 高.并且通过实验发现,在单纯采用时间差分算法 差分算法后的博弈系统是一个具有自学习能力的博 弈智能体,能在不断的博弈过程中提高博弈水平.由