正在加载图片...

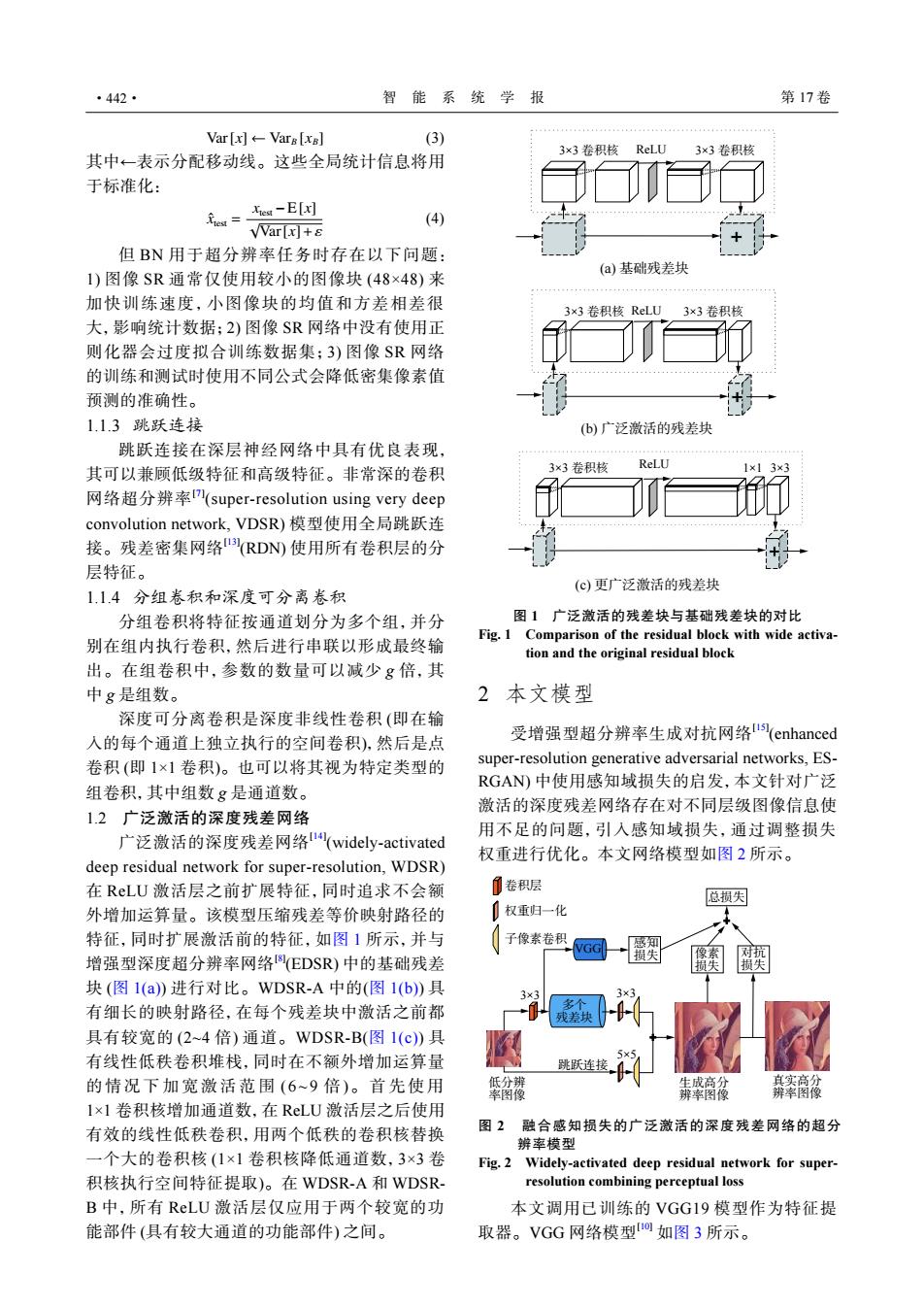

·442· 智能系统学报 第17卷 Var[x←-Vars[xsl (3) 3×3卷积核ReLU3×3卷积核 其中一表示分配移动线。这些全局统计信息将用 于标准化: 无wsa-E因 (4) VVar[x]+s 但BN用于超分辨率任务时存在以下问题: 1)图像SR通常仅使用较小的图像块(48×48)来 (a)基础残差块 加快训练速度,小图像块的均值和方差相差很 3×3卷积核ReLU 3×3卷积核 大,影响统计数据:2)图像SR网络中没有使用正 则化器会过度拟合训练数据集;3)图像SR网络 的训练和测试时使用不同公式会降低密集像素值 预测的准确性。 1.1.3跳跃连接 (b)广泛激活的残差块 跳跃连接在深层神经网络中具有优良表现, 3×3卷积核 ReLU 其可以兼顾低级特征和高级特征。非常深的卷积 网络超分辨率(super--resolution using very deep convolution network,VDSR)模型使用全局跳跃连 接。残差密集网络(RDN)使用所有卷积层的分 层特征。 (c)更广泛激活的残差块 1.1.4分组卷积和深度可分离卷积 分组卷积将特征按通道划分为多个组,并分 图1广泛激活的残差块与基础残差块的对比 别在组内执行卷积,然后进行串联以形成最终输 Fig.1 Comparison of the residual block with wide activa- tion and the original residual block 出。在组卷积中,参数的数量可以减少g倍,其 中g是组数。 2本文模型 深度可分离卷积是深度非线性卷积(即在输 入的每个通道上独立执行的空间卷积),然后是点 受增强型超分辨率生成对抗网络l(enhanced 卷积(即1×1卷积)。也可以将其视为特定类型的 super-resolution generative adversarial networks,ES- RGAN)中使用感知域损失的启发,本文针对广泛 组卷积,其中组数g是通道数。 激活的深度残差网络存在对不同层级图像信息使 1.2广泛激活的深度残差网络 广泛激活的深度残差网络"(widely-activated 用不足的问题,引入感知域损失,通过调整损失 权重进行优化。本文网络模型如图2所示。 deep residual network for super-resolution,WDSR) 在RLU激活层之前扩展特征,同时追求不会额 ①卷积层 总损失 外增加运算量。该模型压缩残差等价映射路径的 〔权重归一化 特征,同时扩展激活前的特征,如图1所示,并与 子像素卷积 感知 增强型深度超分辨率网络(EDSR)中的基础残差 损失 图 块(图1(a)进行对比。WDSR-A中的(图1(b)具 有细长的映射路径,在每个残差块中激活之前都 具有较宽的(2~4倍)通道。WDSR-B(图1(c)具 有线性低秩卷积堆栈,同时在不额外增加运算量 的情况下加宽激活范围(6~9倍)。首先使用 生成高分 辨率图像 1×1卷积核增加通道数,在RLU激活层之后使用 有效的线性低秩卷积,用两个低秩的卷积核替换 图2融合感知损失的广泛激活的深度残差网络的超分 辨率模型 一个大的卷积核(1×1卷积核降低通道数,3×3卷 Fig.2 Widely-activated deep residual network for super- 积核执行空间特征提取)。在WDSR-A和WDSR- resolution combining perceptual loss B中,所有RLU激活层仅应用于两个较宽的功 本文调用已训练的VGG19模型作为特征提 能部件(具有较大通道的功能部件)之间。 取器。VGG网络模型o如图3所示。Var[x] ← VarB [xB] (3) 其中←表示分配移动线。这些全局统计信息将用 于标准化: xˆtest = xtest −E[x] √ Var[x]+ε (4) 但 BN 用于超分辨率任务时存在以下问题: 1) 图像 SR 通常仅使用较小的图像块 (48×48) 来 加快训练速度,小图像块的均值和方差相差很 大,影响统计数据;2) 图像 SR 网络中没有使用正 则化器会过度拟合训练数据集;3) 图像 SR 网络 的训练和测试时使用不同公式会降低密集像素值 预测的准确性。 1.1.3 跳跃连接 跳跃连接在深层神经网络中具有优良表现, 其可以兼顾低级特征和高级特征。非常深的卷积 网络超分辨率[7] (super-resolution using very deep convolution network, VDSR) 模型使用全局跳跃连 接。残差密集网络[13] (RDN) 使用所有卷积层的分 层特征。 1.1.4 分组卷积和深度可分离卷积 分组卷积将特征按通道划分为多个组,并分 别在组内执行卷积,然后进行串联以形成最终输 出。在组卷积中,参数的数量可以减少 g 倍,其 中 g 是组数。 深度可分离卷积是深度非线性卷积 (即在输 入的每个通道上独立执行的空间卷积),然后是点 卷积 (即 1×1 卷积)。也可以将其视为特定类型的 组卷积,其中组数 g 是通道数。 1.2 广泛激活的深度残差网络 广泛激活的深度残差网络[14] (widely-activated deep residual network for super-resolution, WDSR) 在 ReLU 激活层之前扩展特征,同时追求不会额 外增加运算量。该模型压缩残差等价映射路径的 特征,同时扩展激活前的特征,如图 1 所示,并与 增强型深度超分辨率网络[8] (EDSR) 中的基础残差 块 (图 1(a)) 进行对比。WDSR-A 中的(图 1(b)) 具 有细长的映射路径,在每个残差块中激活之前都 具有较宽的 (2~4 倍) 通道。WDSR-B(图 1(c)) 具 有线性低秩卷积堆栈,同时在不额外增加运算量 的情况下加宽激活范 围 (6~9 倍 )。首先使 用 1×1 卷积核增加通道数,在 ReLU 激活层之后使用 有效的线性低秩卷积,用两个低秩的卷积核替换 一个大的卷积核 (1×1 卷积核降低通道数,3×3 卷 积核执行空间特征提取)。在 WDSR-A 和 WDSRB 中,所有 ReLU 激活层仅应用于两个较宽的功 能部件 (具有较大通道的功能部件) 之间。 3×3 卷积核 ReLU 3×3 卷积核 (a) 基础残差块 3×3 卷积核 ReLU 3×3 卷积核 (b) 广泛激活的残差块 3×3 卷积核 ReLU 1×1 3×3 (c) 更广泛激活的残差块 图 1 广泛激活的残差块与基础残差块的对比 Fig. 1 Comparison of the residual block with wide activation and the original residual block 2 本文模型 受增强型超分辨率生成对抗网络[15] (enhanced super-resolution generative adversarial networks, ESRGAN) 中使用感知域损失的启发,本文针对广泛 激活的深度残差网络存在对不同层级图像信息使 用不足的问题,引入感知域损失,通过调整损失 权重进行优化。本文网络模型如图 2 所示。 感知 损失 对抗 损失 像素 损失 总损失 VGG 卷积层 跳跃连接 多个 残差块 低分辨 率图像 生成高分 辨率图像 真实高分 辨率图像 权重归一化 子像素卷积 3×3 3×3 5×5 图 2 融合感知损失的广泛激活的深度残差网络的超分 辨率模型 Fig. 2 Widely-activated deep residual network for superresolution combining perceptual loss 本文调用已训练的 VGG19 模型作为特征提 取器。VGG 网络模型[10] 如图 3 所示。 ·442· 智 能 系 统 学 报 第 17 卷