正在加载图片...

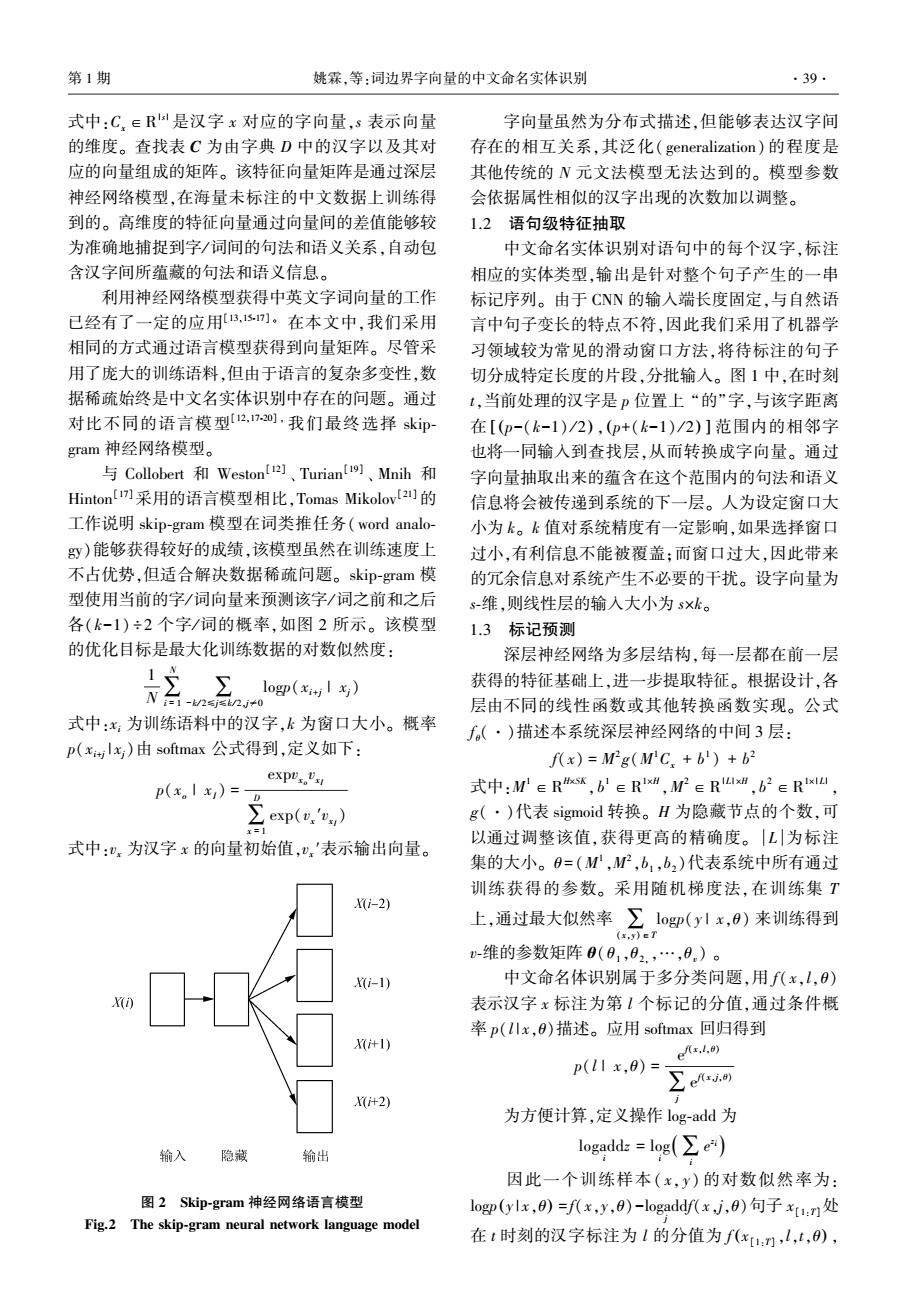

第1期 姚霖,等:词边界字向量的中文命名实体识别 ·39. 式中:C,∈R是汉字x对应的字向量,s表示向量 字向量虽然为分布式描述,但能够表达汉字间 的维度。查找表C为由字典D中的汉字以及其对 存在的相互关系,其泛化(generalization)的程度是 应的向量组成的矩阵。该特征向量矩阵是通过深层 其他传统的N元文法模型无法达到的。模型参数 神经网络模型,在海量未标注的中文数据上训练得 会依据属性相似的汉字出现的次数加以调整。 到的。高维度的特征向量通过向量间的差值能够较 1.2语句级特征抽取 为准确地捕捉到字/词间的句法和语义关系,自动包 中文命名实体识别对语句中的每个汉字,标注 含汉字间所蕴藏的句法和语义信息。 相应的实体类型,输出是针对整个句子产生的一串 利用神经网络模型获得中英文字词向量的工作 标记序列。由于CNN的输入端长度固定,与自然语 已经有了一定的应用,1s]。在本文中,我们采用 言中句子变长的特点不符,因此我们采用了机器学 相同的方式通过语言模型获得到向量矩阵。尽管采 习领域较为常见的滑动窗口方法,将待标注的句子 用了庞大的训练语料,但由于语言的复杂多变性,数 切分成特定长度的片段,分批输入。图1中,在时刻 据稀疏始终是中文名实体识别中存在的问题。通过 t,当前处理的汉字是p位置上“的”字,与该字距离 对比不同的语言模型2,720],我们最终选择skp 在[(p-(k-1)/2),(p+(k-1)/2)]范围内的相邻字 gram神经网络模型。 也将一同输入到查找层,从而转换成字向量。通过 与Collobert和Weston]、Turian]、Mnih和 字向量抽取出来的蕴含在这个范围内的句法和语义 Hinton)采用的语言模型相比,Tomas Mikolov[2)的 信息将会被传递到系统的下一层。人为设定窗口大 工作说明skip-gram模型在词类推任务(word analo-- 小为k。k值对系统精度有一定影响,如果选择窗口 y)能够获得较好的成绩,该模型虽然在训练速度上 过小,有利信息不能被覆盖:而窗口过大,因此带来 不占优势,但适合解决数据稀疏问题。skip-gram模 的冗余信息对系统产生不必要的干扰。设字向量为 型使用当前的字/词向量来预测该字/词之前和之后 s-维,则线性层的输入大小为s×k。 各(k-1)÷2个字/词的概率,如图2所示。该模型 1.3标记预测 的优化目标是最大化训练数据的对数似然度: 深层神经网络为多层结构,每一层都在前一层 hi-vsuro log即(x+Ix) 获得的特征基础上,进一步提取特征。根据设计,各 层由不同的线性函数或其他转换函数实现。公式 式中:x:为训练语料中的汉字,k为窗口大小。概率 f(·)描述本系统深层神经网络的中间3层: p(xlx;)由softmax公式得到,定义如下: f(x)=M'g(M'C +b')+b2 expts Vs p(x。1x,)= 式中:M∈Rks,b∈R,M∈R,b2∈Rk山 D ∑exp(,') g(·)代表sigmoid转换。H为隐藏节点的个数,可 x= 式中:心为汉字x的向量初始值,v'表示输出向量。 以通过调整该值,获得更高的精确度。L为标注 集的大小。9=(M,M2,b1,b2)代表系统中所有通过 训练获得的参数。采用随机梯度法,在训练集T X-2) 上,通过最大似然率∑1og即(y1x,8)来训练得到 (,y)ET -维的参数矩阵0(01,02.,…,8)。 Xi-1) 中文命名体识别属于多分类问题,用f(x,l,) 表示汉字x标注为第1个标记的分值,通过条件概 率p(l1x,0)描述。应用softmax回归得到 X计1) enz.1.0) p(l1x,8)= ∑en X+2) 为方便计算,定义操作log-add为 输入隐藏 输出 logaddz=log(∑e) 因此一个训练样本(x,y)的对数似然率为: 图2Skip-gram神经网络语言模型 log即(ylx,0)=fx,y,0)--logaddf(xj,)句子x:n处 Fig.2 The skip-gram neural network language model 在t时刻的汉字标注为l的分值为f(x1:,l,t,),式中:Cx∈R | s| 是汉字 x 对应的字向量,s 表示向量 的维度。 查找表 C 为由字典 D 中的汉字以及其对 应的向量组成的矩阵。 该特征向量矩阵是通过深层 神经网络模型,在海量未标注的中文数据上训练得 到的。 高维度的特征向量通过向量间的差值能够较 为准确地捕捉到字/ 词间的句法和语义关系,自动包 含汉字间所蕴藏的句法和语义信息。 利用神经网络模型获得中英文字词向量的工作 已经有了一定的应用[13,15⁃17] 。 在本文中,我们采用 相同的方式通过语言模型获得到向量矩阵。 尽管采 用了庞大的训练语料,但由于语言的复杂多变性,数 据稀疏始终是中文名实体识别中存在的问题。 通过 对比不同的语言模型[12,17⁃20] , 我们最终选择 skip⁃ gram 神经网络模型。 与 Collobert 和 Weston [12] 、 Turian [19] 、 Mnih 和 Hinton [17]采用的语言模型相比,Tomas Mikolov [21] 的 工作说明 skip⁃gram 模型在词类推任务(word analo⁃ gy)能够获得较好的成绩,该模型虽然在训练速度上 不占优势,但适合解决数据稀疏问题。 skip⁃gram 模 型使用当前的字/ 词向量来预测该字/ 词之前和之后 各(k-1) ÷2 个字/ 词的概率,如图 2 所示。 该模型 的优化目标是最大化训练数据的对数似然度: 1 N∑ N i = 1 -k / 2≤∑ j≤k / 2,j≠0 logp(xi+j | xj) 式中:xi 为训练语料中的汉字,k 为窗口大小。 概率 p(xi+j | xj)由 softmax 公式得到,定义如下: p(xo | xI) = expvxo vxI ∑ D x = 1 exp(vx ′vxI ) 式中:vx 为汉字 x 的向量初始值,vx ′表示输出向量。 图 2 Skip⁃gram 神经网络语言模型 Fig.2 The skip⁃gram neural network language model 字向量虽然为分布式描述,但能够表达汉字间 存在的相互关系,其泛化( generalization) 的程度是 其他传统的 N 元文法模型无法达到的。 模型参数 会依据属性相似的汉字出现的次数加以调整。 1.2 语句级特征抽取 中文命名实体识别对语句中的每个汉字,标注 相应的实体类型,输出是针对整个句子产生的一串 标记序列。 由于 CNN 的输入端长度固定,与自然语 言中句子变长的特点不符,因此我们采用了机器学 习领域较为常见的滑动窗口方法,将待标注的句子 切分成特定长度的片段,分批输入。 图 1 中,在时刻 t,当前处理的汉字是 p 位置上 “的”字,与该字距离 在 [ (p-(k-1) / 2) ,(p+(k-1) / 2) ] 范围内的相邻字 也将一同输入到查找层,从而转换成字向量。 通过 字向量抽取出来的蕴含在这个范围内的句法和语义 信息将会被传递到系统的下一层。 人为设定窗口大 小为 k。 k 值对系统精度有一定影响,如果选择窗口 过小,有利信息不能被覆盖;而窗口过大,因此带来 的冗余信息对系统产生不必要的干扰。 设字向量为 s⁃维,则线性层的输入大小为 s×k。 1.3 标记预测 深层神经网络为多层结构,每一层都在前一层 获得的特征基础上,进一步提取特征。 根据设计,各 层由不同的线性函数或其他转换函数实现。 公式 f θ(·)描述本系统深层神经网络的中间 3 层: f(x) = M 2 g(M 1Cx + b 1 ) + b 2 式中:M 1∈R H×SK ,b 1 ∈R 1×H ,M 2 ∈R | L| ×H ,b 2 ∈R 1× | L| , g(·)代表 sigmoid 转换。 H 为隐藏节点的个数,可 以通过调整该值,获得更高的精确度。 L 为标注 集的大小。 θ = (M 1 ,M 2 ,b1 ,b2 )代表系统中所有通过 训练获得的参数。 采用随机梯度法,在训练集 T 上,通过最大似然率 (x∑,y)∈T logp(y | x,θ) 来训练得到 v⁃维的参数矩阵 θ(θ 1 ,θ 2, ,…,θv) 。 中文命名体识别属于多分类问题,用 f( x,l,θ) 表示汉字 x 标注为第 l 个标记的分值,通过条件概 率 p(l | x,θ)描述。 应用 softmax 回归得到 p(l | x,θ) = e f(x,l,θ) ∑ j e f(x,j,θ) 为方便计算,定义操作 log⁃add 为 logaddz i = log i ∑i e z i ( ) 因此一个训练样本( x, y) 的对数似然率为: logp (y | x,θ) = f(x,y,θ)-logadd j f(x,j,θ)句子 x[1:T]处 在 t 时刻的汉字标注为 l 的分值为 f x( [1:T] ,l,t,θ) , 第 1 期 姚霖,等:词边界字向量的中文命名实体识别 ·39·