正在加载图片...

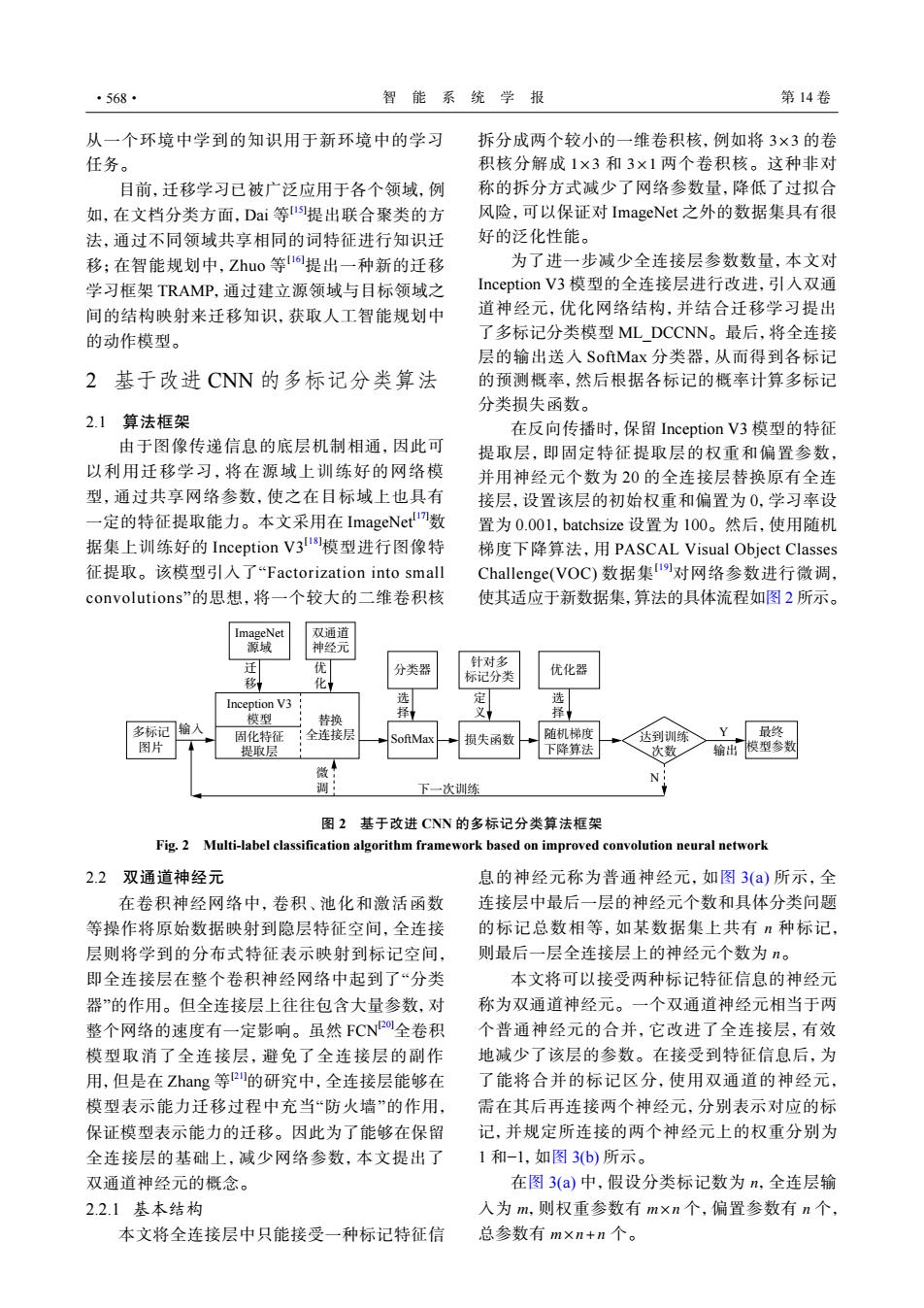

·568· 智能系统学报 第14卷 从一个环境中学到的知识用于新环境中的学习 拆分成两个较小的一维卷积核,例如将3×3的卷 任务。 积核分解成1×3和3×1两个卷积核。这种非对 目前,迁移学习已被广泛应用于各个领域,例 称的拆分方式减少了网络参数量,降低了过拟合 如,在文档分类方面,Dai等提出联合聚类的方 风险,可以保证对ImageNet之外的数据集具有很 法,通过不同领域共享相同的词特征进行知识迁 好的泛化性能。 移;在智能规划中,Zhuo等1o提出一种新的迁移 为了进一步减少全连接层参数数量,本文对 学习框架TRAMP,通过建立源领域与目标领域之 Inception V3模型的全连接层进行改进,引入双通 间的结构映射来迁移知识,获取人工智能规划中 道神经元,优化网络结构,并结合迁移学习提出 的动作模型。 了多标记分类模型ML DCCNN。最后,将全连接 层的输出送入SoftMax分类器,从而得到各标记 2基于改进CNN的多标记分类算法 的预测概率,然后根据各标记的概率计算多标记 分类损失函数。 2.1算法框架 在反向传播时,保留Inception V3模型的特征 由于图像传递信息的底层机制相通,因此可 提取层,即固定特征提取层的权重和偏置参数, 以利用迁移学习,将在源域上训练好的网络模 并用神经元个数为20的全连接层替换原有全连 型,通过共享网络参数,使之在目标域上也具有 接层,设置该层的初始权重和偏置为0,学习率设 一定的特征提取能力。本文采用在ImageNet数 置为0.001,batchsize设置为100。然后,使用随机 据集上训练好的Inception V3I8模型进行图像特 梯度下降算法,用PASCAL Visual Object Classes 征提取。该模型引入了“Factorization into small Challenge(VOC)数据集Iu对网络参数进行微调, convolutions'”的思想,将一个较大的二维卷积核 使其适应于新数据集,算法的具体流程如图2所示。 ImageNet 双通道 源域 神经元 迁 优 针对多 分类器 标记分类 优化器 移 化 选 Inception V3 定 选 模型 择 义 择 替换 多标记输入 固化特征 :全连接层 损失函数 随机梯度 达到训练 Y 最终 图片 提取层 下降算法 次数 输出模型参数 N 调 下一次训练 图2基于改进CNN的多标记分类算法框架 Fig.2 Multi-label classification algorithm framework based on improved convolution neural network 2.2双通道神经元 息的神经元称为普通神经元,如图3(a)所示,全 在卷积神经网络中,卷积、池化和激活函数 连接层中最后一层的神经元个数和具体分类问题 等操作将原始数据映射到隐层特征空间,全连接 的标记总数相等,如某数据集上共有n种标记, 层则将学到的分布式特征表示映射到标记空间, 则最后一层全连接层上的神经元个数为n。 即全连接层在整个卷积神经网络中起到了“分类 本文将可以接受两种标记特征信息的神经元 器”的作用。但全连接层上往往包含大量参数,对 称为双通道神经元。一个双通道神经元相当于两 整个网络的速度有一定影响。虽然FCN20全卷积 个普通神经元的合并,它改进了全连接层,有效 模型取消了全连接层,避免了全连接层的副作 地减少了该层的参数。在接受到特征信息后,为 用,但是在Zhang等2的研究中,全连接层能够在 了能将合并的标记区分,使用双通道的神经元, 模型表示能力迁移过程中充当“防火墙”的作用, 需在其后再连接两个神经元,分别表示对应的标 保证模型表示能力的迁移。因此为了能够在保留 记,并规定所连接的两个神经元上的权重分别为 全连接层的基础上,减少网络参数,本文提出了 1和-1,如图3b)所示。 双通道神经元的概念。 在图3(a)中,假设分类标记数为n,全连层输 2.2.1基本结构 入为m,则权重参数有m×n个,偏置参数有n个, 本文将全连接层中只能接受一种标记特征信 总参数有m×n+n个。从一个环境中学到的知识用于新环境中的学习 任务。 目前,迁移学习已被广泛应用于各个领域,例 如,在文档分类方面,Dai 等 [15]提出联合聚类的方 法,通过不同领域共享相同的词特征进行知识迁 移;在智能规划中,Zhuo 等 [16]提出一种新的迁移 学习框架 TRAMP,通过建立源领域与目标领域之 间的结构映射来迁移知识,获取人工智能规划中 的动作模型。 2 基于改进 CNN 的多标记分类算法 2.1 算法框架 由于图像传递信息的底层机制相通,因此可 以利用迁移学习,将在源域上训练好的网络模 型,通过共享网络参数,使之在目标域上也具有 一定的特征提取能力。本文采用在 ImageNet[17]数 据集上训练好的 Inception V3[18]模型进行图像特 征提取。该模型引入了“Factorization into small convolutions”的思想,将一个较大的二维卷积核 3×3 1×3 3×1 拆分成两个较小的一维卷积核,例如将 的卷 积核分解成 和 两个卷积核。这种非对 称的拆分方式减少了网络参数量,降低了过拟合 风险,可以保证对 ImageNet 之外的数据集具有很 好的泛化性能。 为了进一步减少全连接层参数数量,本文对 Inception V3 模型的全连接层进行改进,引入双通 道神经元,优化网络结构,并结合迁移学习提出 了多标记分类模型 ML_DCCNN。最后,将全连接 层的输出送入 SoftMax 分类器,从而得到各标记 的预测概率,然后根据各标记的概率计算多标记 分类损失函数。 在反向传播时,保留 Inception V3 模型的特征 提取层,即固定特征提取层的权重和偏置参数, 并用神经元个数为 20 的全连接层替换原有全连 接层,设置该层的初始权重和偏置为 0,学习率设 置为 0.001,batchsize 设置为 100。然后,使用随机 梯度下降算法,用 PASCAL Visual Object Classes Challenge(VOC) 数据集[19]对网络参数进行微调, 使其适应于新数据集,算法的具体流程如图 2 所示。 ImageNet 源域 双通道 神经元 迁 移 优 化 输入 微 调 选 择 选 择 定 义 下一次训练 多标记 图片 Inception V3 模型 固化特征 提取层 替换 全连接层 SoftMax 分类器 针对多 标记分类 损失函数 优化器 随机梯度 下降算法 达到训练 次数 最终 模型参数 Y 输出 N 图 2 基于改进 CNN 的多标记分类算法框架 Fig. 2 Multi-label classification algorithm framework based on improved convolution neural network 2.2 双通道神经元 在卷积神经网络中,卷积、池化和激活函数 等操作将原始数据映射到隐层特征空间,全连接 层则将学到的分布式特征表示映射到标记空间, 即全连接层在整个卷积神经网络中起到了“分类 器”的作用。但全连接层上往往包含大量参数,对 整个网络的速度有一定影响。虽然 FCN[20]全卷积 模型取消了全连接层,避免了全连接层的副作 用,但是在 Zhang 等 [21]的研究中,全连接层能够在 模型表示能力迁移过程中充当“防火墙”的作用, 保证模型表示能力的迁移。因此为了能够在保留 全连接层的基础上,减少网络参数,本文提出了 双通道神经元的概念。 2.2.1 基本结构 本文将全连接层中只能接受一种标记特征信 n n 息的神经元称为普通神经元,如图 3(a) 所示,全 连接层中最后一层的神经元个数和具体分类问题 的标记总数相等,如某数据集上共有 种标记, 则最后一层全连接层上的神经元个数为 。 本文将可以接受两种标记特征信息的神经元 称为双通道神经元。一个双通道神经元相当于两 个普通神经元的合并,它改进了全连接层,有效 地减少了该层的参数。在接受到特征信息后,为 了能将合并的标记区分,使用双通道的神经元, 需在其后再连接两个神经元,分别表示对应的标 记,并规定所连接的两个神经元上的权重分别为 1 和−1,如图 3(b) 所示。 n m m×n n m×n+n 在图 3(a) 中,假设分类标记数为 ,全连层输 入为 ,则权重参数有 个,偏置参数有 个, 总参数有 个。 ·568· 智 能 系 统 学 报 第 14 卷