正在加载图片...

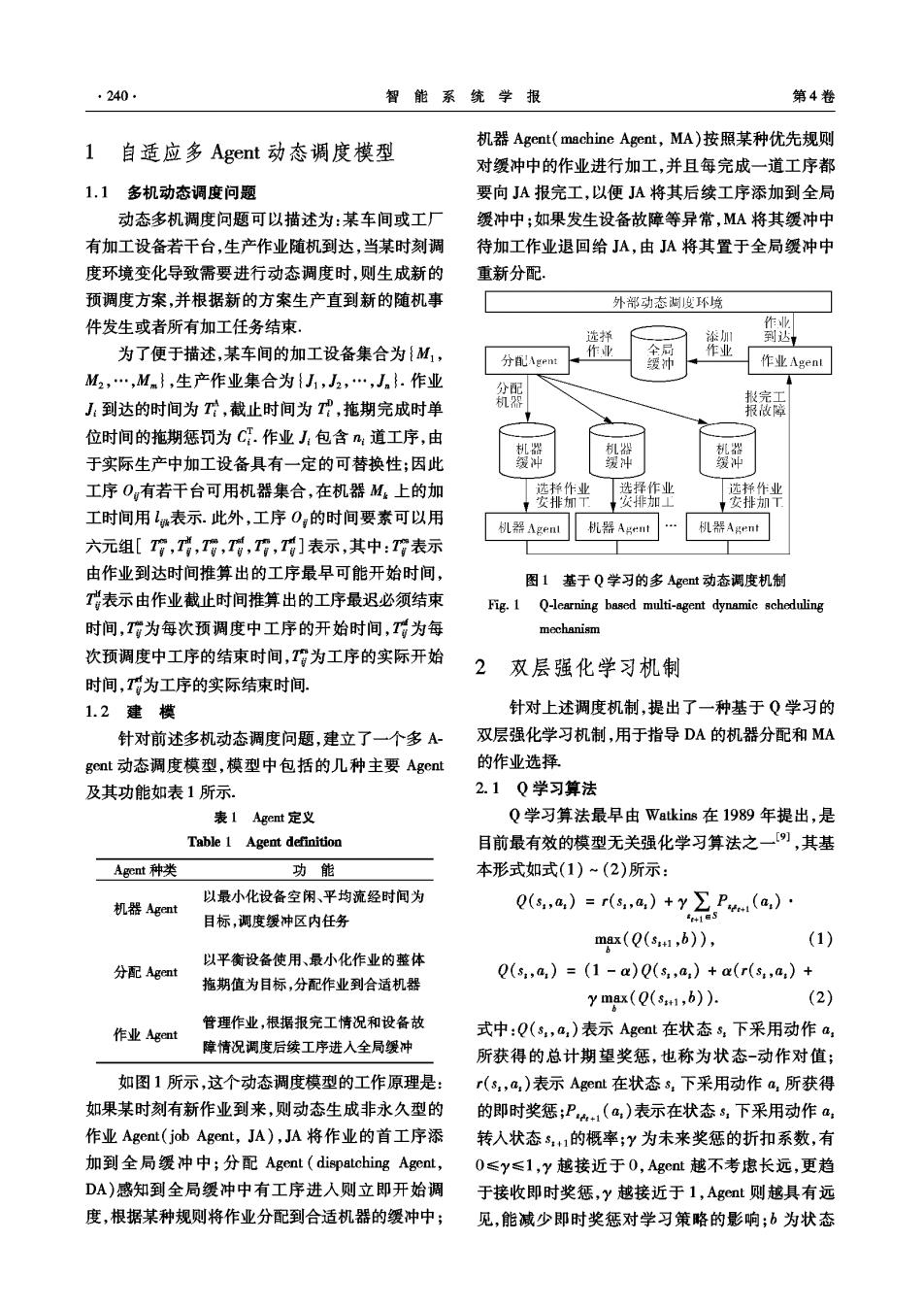

·240 智能系统学报 第4卷 机器Agent(machine Agent,MA)按照某种优先规则 1自适应多Agent动态调度模型 对缓冲中的作业进行加工,并且每完成一道工序都 1.1多机动态调度问题 要向JA报完工,以便JA将其后续工序添加到全局 动态多机调度问题可以描述为:某车间或工厂 缓冲中;如果发生设备故障等异常,MA将其缓冲中 有加工设备若干台,生产作业随机到达,当某时刻调 待加工作业退回给JA,由JA将其置于全局缓冲中 度环境变化导致需要进行动态调度时,则生成新的 重新分配. 预调度方案,并根据新的方案生产直到新的随机事 外部动态满度环境 件发生或者所有加工任务结束. 作业 选择 添加 到达 为了便于描述,某车间的加工设备集合为{M1, 作业 作业 分Agent 缓冲 作业Agent M2,…,Mm},生产作业集合为{J,J2,…,Jn}.作业 分配 完工 J:到达的时间为T,截止时间为T,拖期完成时单 机器 报微障 位时间的拖期惩罚为C.作业J:包含n:道工序,由 机器 机器 于实际生产中加工设备具有一定的可替换性;因此 缓冲 缓冲 工序Og有若干台可用机器集合,在机器M。上的加 选择作业 选择作业 选择作业 安排加T 安排加上 事安排加下 工时间用1表示.此外,工序O的时间要素可以用 机器Agent 机器Agt 机器Agent 六元组[會,,,,,]表示,其中:會表示 由作业到达时间推算出的工序最早可能开始时间, 图1基于Q学习的多Aget动态调度机制 T表示由作业截止时间推算出的工序最迟必须结束 Fig.1 Q-learning based multi-agent dynamic scheduling 时间,T为每次预调度中工序的开始时间,T为每 mechanism 次预调度中工序的结束时间,为工序的实际开始 2 双层强化学习机制 时间,T为工序的实际结束时间. 1.2建模 针对上述调度机制,提出了一种基于Q学习的 针对前述多机动态调度问题,建立了一个多A 双层强化学习机制,用于指导DA的机器分配和MA gent动态调度模型,模型中包括的几种主要Agent 的作业选择 及其功能如表1所示。 2.1Q学习算法 表1 Agent定义 Q学习算法最早由Watkins在1989年提出,是 Table 1 Agent definition 目前最有效的模型无关强化学习算法之一,其基 Agent种类 功能 本形式如式(1)~(2)所示: 以最小化设备空闲、平均流经时间为 机器Agent Q(s,a,)=r(s,a,)+y∑P(a)· 目标,调度缓冲区内任务 41后5 max(Q(s1,6)), (1) 以平衡设备使用、最小化作业的整体 分配Agent Q(s,a,)=(1-a)Q(s,a)+a(r(s,a)+ 拖期值为目标,分配作业到合适机器 y max((s1,6)). (2) 管理作业,根据报完工情况和设备故 作业Agent 式中:Q(s,a,)表示Agent在状态s,下采用动作a, 障情况调度后续工序进人全局缓冲 所获得的总计期望奖惩,也称为状态-动作对值; 如图1所示,这个动态调度模型的工作原理是: r(s,a,)表示Agent在状态s,下采用动作a,所获得 如果某时刻有新作业到来,则动态生成非永久型的 的即时奖惩;P41(a)表示在状态s,下采用动作a: 作业Agent(job Agent,JA),JA将作业的首工序添 转入状态s,+1的概率;y为未来奖惩的折扣系数,有 加到全局缓冲中;分配Agent(dispatching Agent, 0≤y≤1,y越接近于0,Agent越不考虑长远,更趋 DA)感知到全局缓冲中有工序进人则立即开始调 于接收即时奖惩,y越接近于1,Agent则越具有远 度,根据某种规则将作业分配到合适机器的缓冲中; 见,能减少即时奖惩对学习策略的影响;b为状态