正在加载图片...

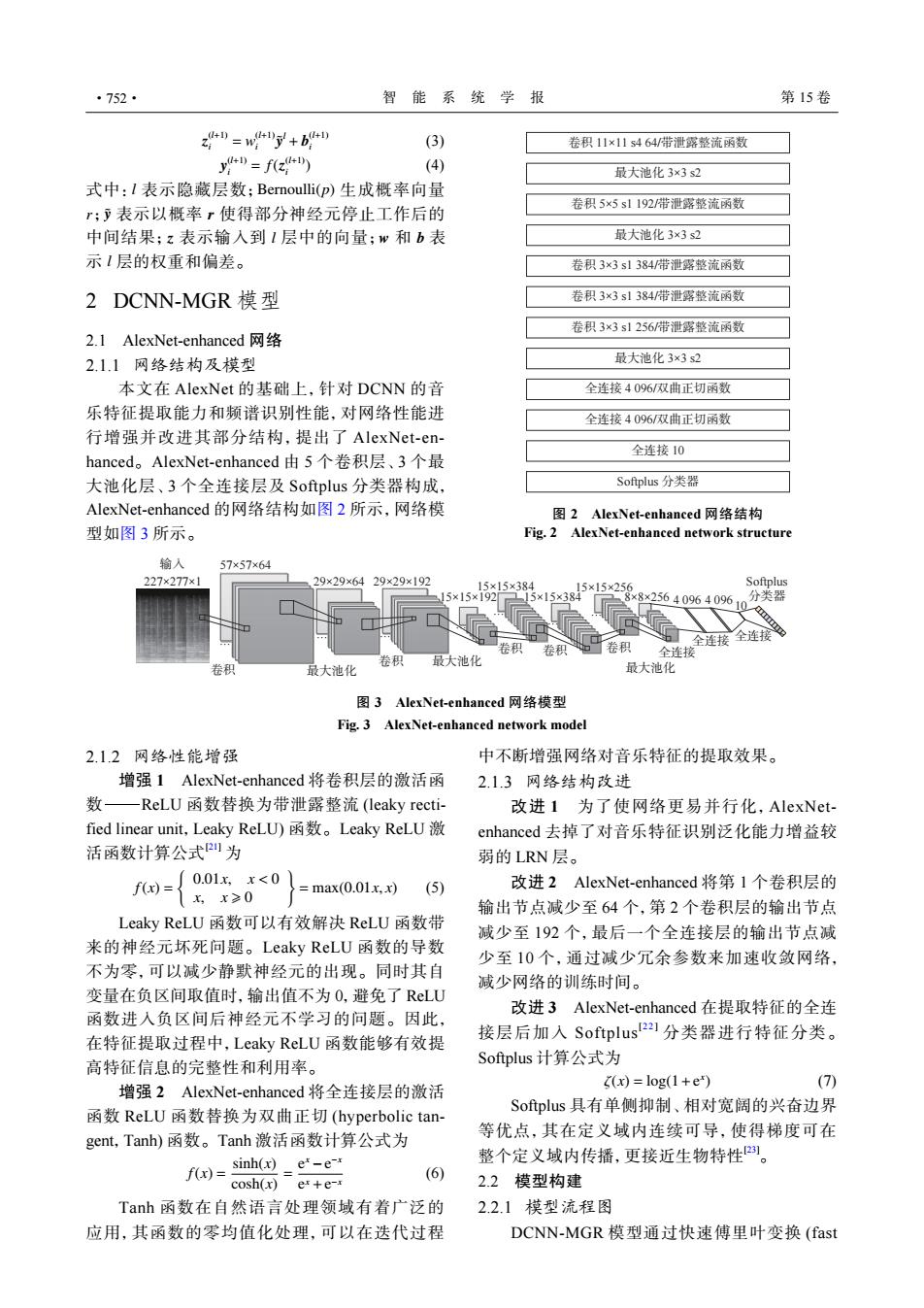

·752· 智能系统学报 第15卷 24=wy+4 (3) 卷积11×11s464/带泄露整流函数 y4=f2 (4) 最大池化3×3s2 式中:l表示隐藏层数;Bernoulli(p)生成概率向量 r;表示以概率r使得部分神经元停止工作后的 卷积5×5s1192带泄露整流函数 中间结果:z表示输入到1层中的向量;w和b表 最大池化3×3s2 示1层的权重和偏差。 卷积3×3s1384/带泄露整流函数 2DCNN-MGR模型 卷积3×3s1384带泄露整流函数 卷积3×3s1256带泄露整流函数 2.1 AlexNet-enhanced网络 2.1.1网络结构及模型 最大池化3×3s2 本文在AlexNet的基础上,针对DCNN的音 全连接4096/双曲正切函数 乐特征提取能力和频谱识别性能,对网络性能进 全连接4096/双曲正切函数 行增强并改进其部分结构,提出了AlexNet-en- 全连接10 hanced。AlexNet-enhanced由5个卷积层、3个最 大池化层、3个全连接层及Softplus分类器构成, Softplus分类器 AlexNet-enhanced的网络结构如图2所示,网络模 图2 AlexNet-enhanced网络结构 型如图3所示。 Fig.2 AlexNet-enhanced network structure 输入 57×57×64 227×277×1 29×29×6429×29×192 15×15×384 Softplus 15×15×192 x15x385x5x25 ×8×2564096409610 分类器 卷积 卷积 全连接全连接 全连接 卷积 最大池化 卷积 最大池化 最大池化 图3 AlexNet--enhanced网络模型 Fig.3 AlexNet-enhanced network model 2.1.2网络性能增强 中不断增强网络对音乐特征的提取效果。 增强1 AlexNet--enhanced将卷积层的激活函 2.1.3网络结构改进 数 一ReLU函数替换为带泄露整流(leaky recti- 改进1为了使网络更易并行化,AlexNet- fied linear unit,.Leaky ReLU)函数。Leaky ReLU激 enhanced去掉了对音乐特征识别泛化能力增益较 活函数计算公式四为 弱的LRN层。 ={20&0 =max(0.01x,x)(5) 改进2 AlexNet-enhanced将第1个卷积层的 输出节点减少至64个,第2个卷积层的输出节点 Leaky ReLU函数可以有效解决ReLU函数带 减少至192个,最后一个全连接层的输出节点减 来的神经元坏死问题。Leaky ReLU函数的导数 少至10个,通过减少冗余参数来加速收敛网络, 不为零,可以减少静默神经元的出现。同时其自 减少网络的训练时间。 变量在负区间取值时,输出值不为0,避免了ReLU 函数进入负区间后神经元不学习的问题。因此, 改进3 AlexNet-enhanced在提取特征的全连 在特征提取过程中,Leaky ReLU函数能够有效提 接层后加入Softplus21分类器进行特征分类。 高特征信息的完整性和利用率。 Softplus计算公式为 增强2 AlexNet-enhanced将全连接层的激活 (x)=log(1+e*) (7) 函数ReLU函数替换为双曲正切(hyperbolic tan- Softplus具有单侧抑制、相对宽阔的兴奋边界 gent,Tanh)函数。Tanh激活函数计算公式为 等优点,其在定义域内连续可导,使得梯度可在 f(r)=sinh()e-e 整个定义域内传播,更接近生物特性。 (6) cosh(x)e+e-r 2.2模型构建 Tanh函数在自然语言处理领域有着广泛的 2.2.1模型流程图 应用,其函数的零均值化处理,可以在迭代过程 DCNN-MGR模型通过快速傅里叶变换(fastz (l+1) i = w (l+1) i y˜ l + b (l+1) i (3) y (l+1) i = f(z (l+1) i ) (4) l Bernoulli(p) r y˜ r z l w b l 式中: 表示隐藏层数; 生成概率向量 ; 表示以概率 使得部分神经元停止工作后的 中间结果; 表示输入到 层中的向量; 和 表 示 层的权重和偏差。 2 DCNN-MGR 模型 2.1 AlexNet-enhanced 网络 2.1.1 网络结构及模型 本文在 AlexNet 的基础上,针对 DCNN 的音 乐特征提取能力和频谱识别性能,对网络性能进 行增强并改进其部分结构,提出了 AlexNet-enhanced。AlexNet-enhanced 由 5 个卷积层、3 个最 大池化层、3 个全连接层及 Softplus 分类器构成, AlexNet-enhanced 的网络结构如图 2 所示,网络模 型如图 3 所示。 全连接 10 Softplus 分类器 最大池化 3×3 s2 最大池化 3×3 s2 最大池化 3×3 s2 卷积 11×11 s4 64/带泄露整流函数 卷积 5×5 s1 192/带泄露整流函数 卷积 3×3 s1 384/带泄露整流函数 卷积 3×3 s1 384/带泄露整流函数 卷积 3×3 s1 256/带泄露整流函数 全连接 4 096/双曲正切函数 全连接 4 096/双曲正切函数 图 2 AlexNet-enhanced 网络结构 Fig. 2 AlexNet-enhanced network structure 输入 227×277×1 57×57×64 29×29×64 29×29×192 15×15×192 15×15×384 15×15×384 15×15×256 8×8×256 … 卷积 最大池化 卷积 最大池化 卷积 卷积 卷积 最大池化 全连接 全连接 全连接 4 096 4 096 10 Softplus 分类器 … … … … … … … 图 3 AlexNet-enhanced 网络模型 Fig. 3 AlexNet-enhanced network model 2.1.2 网络性能增强 增强 1 AlexNet-enhanced 将卷积层的激活函 数−ReLU 函数替换为带泄露整流 (leaky rectified linear unit,Leaky ReLU) 函数。Leaky ReLU 激 活函数计算公式[21] 为 f(x) = { 0.01x, x < 0 x, x ⩾ 0 } = max(0.01x, x) (5) Leaky ReLU 函数可以有效解决 ReLU 函数带 来的神经元坏死问题。Leaky ReLU 函数的导数 不为零,可以减少静默神经元的出现。同时其自 变量在负区间取值时,输出值不为 0,避免了 ReLU 函数进入负区间后神经元不学习的问题。因此, 在特征提取过程中,Leaky ReLU 函数能够有效提 高特征信息的完整性和利用率。 增强 2 AlexNet-enhanced 将全连接层的激活 函数 ReLU 函数替换为双曲正切 (hyperbolic tangent,Tanh) 函数。Tanh 激活函数计算公式为 f(x) = sinh(x) cosh(x) = e x −e −x e x +e −x (6) Tanh 函数在自然语言处理领域有着广泛的 应用,其函数的零均值化处理,可以在迭代过程 中不断增强网络对音乐特征的提取效果。 2.1.3 网络结构改进 改进 1 为了使网络更易并行化,AlexNetenhanced 去掉了对音乐特征识别泛化能力增益较 弱的 LRN 层。 改进 2 AlexNet-enhanced 将第 1 个卷积层的 输出节点减少至 64 个,第 2 个卷积层的输出节点 减少至 192 个,最后一个全连接层的输出节点减 少至 10 个,通过减少冗余参数来加速收敛网络, 减少网络的训练时间。 改进 3 AlexNet-enhanced 在提取特征的全连 接层后加入 Softplus[ 2 2 ] 分类器进行特征分类。 Softplus 计算公式为 ζ(x) = log(1+e x ) (7) Softplus 具有单侧抑制、相对宽阔的兴奋边界 等优点,其在定义域内连续可导,使得梯度可在 整个定义域内传播,更接近生物特性[23]。 2.2 模型构建 2.2.1 模型流程图 DCNN-MGR 模型通过快速傅里叶变换 (fast ·752· 智 能 系 统 学 报 第 15 卷