正在加载图片...

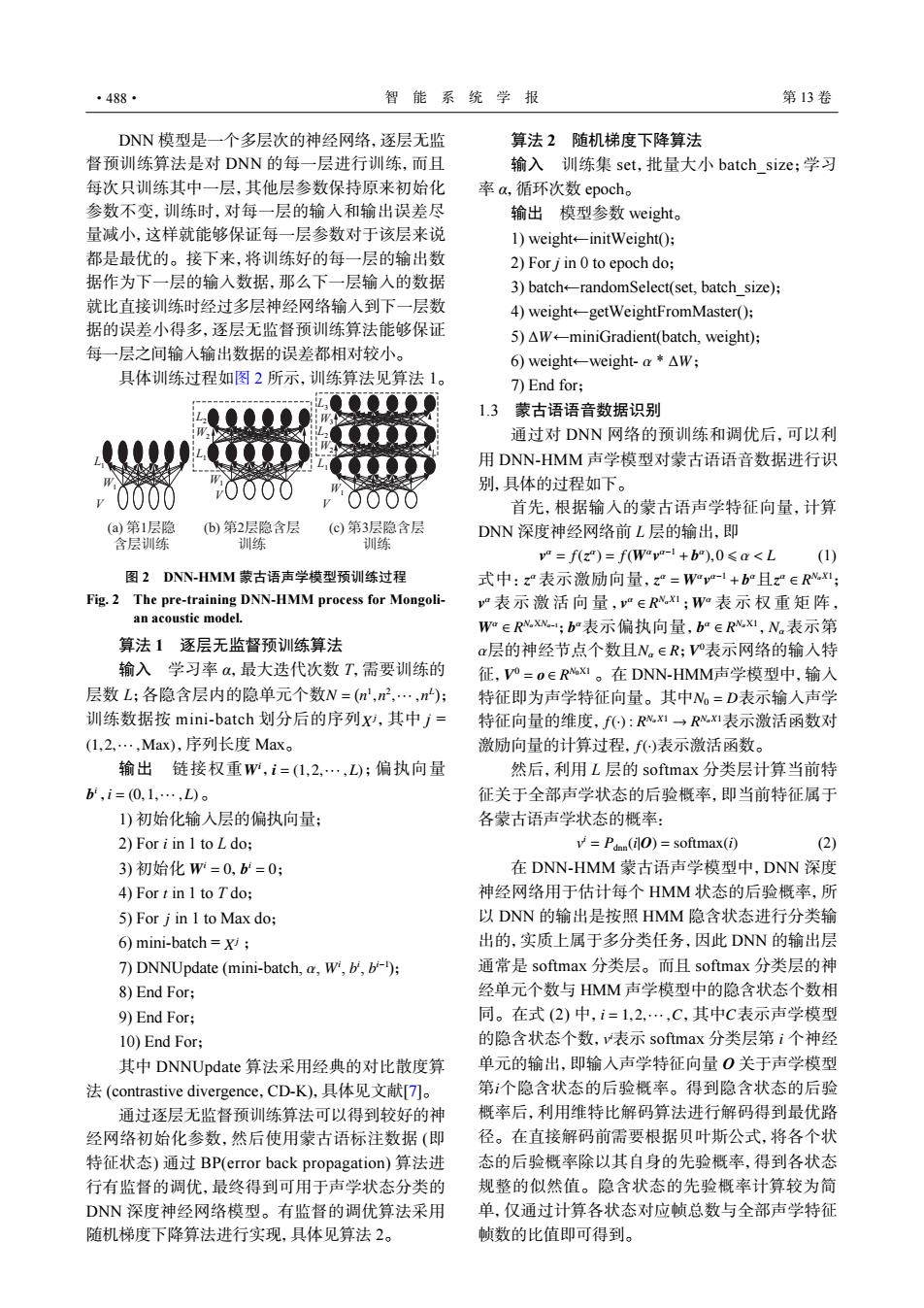

·488· 智能系统学报 第13卷 DNN模型是一个多层次的神经网络,逐层无监 算法2随机梯度下降算法 督预训练算法是对DNN的每一层进行训练,而且 输入训练集set,批量大小batch size;学习 每次只训练其中一层,其他层参数保持原来初始化 率a,循环次数epoch, 参数不变,训练时,对每一层的输人和输出误差尽 输出模型参数weight。 量减小,这样就能够保证每一层参数对于该层来说 1)weight-initWeight(); 都是最优的。接下来,将训练好的每一层的输出数 2)For j in 0 to epoch do; 据作为下一层的输人数据,那么下一层输入的数据 3)batch+randomSelect(set,batch size); 就比直接训练时经过多层神经网络输入到下一层数 4)weight-getWeightFromMaster(); 据的误差小得多,逐层无监督预训练算法能够保证 S)△W←-miniGradient(batch,weight): 每一层之间输入输出数据的误差都相对较小。 6)weight←-weight-a*△W; 具体训练过程如图2所示,训练算法见算法1。 7)End for; 1.3蒙古语语音数据识别 通过对DNN网络的预训练和调优后,可以利 用DNN-HMM声学模型对蒙古语语音数据进行识 别,具体的过程如下。 首先,根据输入的蒙古语声学特征向量,计算 (a)第1层隐 (b)第2层隐含层 (©)第3层隐含层 DNN深度神经网络前L层的输出,即 含层训练 训练 训练 va=f(z")=f(Wava-1+b),0sa<L (1) 图2DNN-HMM蒙古语声学模型预训练过程 式中:z表示激励向量,z”=Wy-1+b°且z∈Rx; Fig.2 The pre-training DNN-HMM process for Mongoli- v表示激活向量,“∈RI;W表示权重矩阵, an acoustic model. Wm∈R.Xw;b表示偏执向量,b°∈R1,N。表示第 算法1逐层无监督预训练算法 a层的神经节点个数且N。∈R;V表示网络的输入特 输入学习率α,最大迭代次数T,需要训练的 征,V°=OE RNXI。在DNN-HMM声学模型中,输入 层数L;各隐含层内的隐单元个数W=(n,n2,…,n): 特征即为声学特征向量。其中N。=D表示输入声学 训练数据按mini-batch划分后的序列x,其中j= 特征向量的维度,f):Rv.x1→R心x1表示激活函数对 (1,2,…,Max),序列长度Max。 激励向量的计算过程,f)表示激活函数。 输出链接权重W,i=(1,2,·,L);偏执向量 然后,利用L层的softmax分类层计算当前特 b,i=(0,1,…,L)。 征关于全部声学状态的后验概率,即当前特征属于 1)初始化输入层的偏执向量; 各蒙古语声学状态的概率: 2)For i in I to L do; =Pdnn(il0)=softmax(i) (2) 3)初始化W=0,b=0; 在DNN-HMM蒙古语声学模型中,DNN深度 4)For t in 1 to Tdo; 神经网络用于估计每个HMM状态的后验概率,所 5)For j in 1 to Max do; 以DNN的输出是按照HMM隐含状态进行分类输 6)mini-batch =i 出的,实质上属于多分类任务,因此DNN的输出层 7)DNNUpdate (mini-batch,a,Wi,b,b-); 通常是softmax分类层。而且softmax分类层的神 8)End For; 经单元个数与HMM声学模型中的隐含状态个数相 9)End For; 同。在式(2)中,i=1,2,…,C,其中C表示声学模型 10)End For: 的隐含状态个数,v表示softmax分类层第i个神经 其中DNNUpdate算法采用经典的对比散度算 单元的输出,即输入声学特征向量0关于声学模型 法(contrastive divergence,CD-K),具体见文献[T)。 第个隐含状态的后验概率。得到隐含状态的后验 通过逐层无监督预训练算法可以得到较好的神 概率后,利用维特比解码算法进行解码得到最优路 经网络初始化参数,然后使用蒙古语标注数据(即 径。在直接解码前需要根据贝叶斯公式,将各个状 特征状态)通过BP(error back propagation)算法进 态的后验概率除以其自身的先验概率,得到各状态 行有监督的调优,最终得到可用于声学状态分类的 规整的似然值。隐含状态的先验概率计算较为简 DNN深度神经网络模型。有监督的调优算法采用 单,仅通过计算各状态对应帧总数与全部声学特征 随机梯度下降算法进行实现,具体见算法2。 帧数的比值即可得到。DNN 模型是一个多层次的神经网络,逐层无监 督预训练算法是对 DNN 的每一层进行训练,而且 每次只训练其中一层,其他层参数保持原来初始化 参数不变,训练时,对每一层的输入和输出误差尽 量减小,这样就能够保证每一层参数对于该层来说 都是最优的。接下来,将训练好的每一层的输出数 据作为下一层的输入数据,那么下一层输入的数据 就比直接训练时经过多层神经网络输入到下一层数 据的误差小得多,逐层无监督预训练算法能够保证 每一层之间输入输出数据的误差都相对较小。 具体训练过程如图 2 所示,训练算法见算法 1。 算法 1 逐层无监督预训练算法 N = ( n 1 ,n 2 ,··· ,n L ) X j (1,2,··· ,Max) 输入 学习率 α,最大迭代次数 T,需要训练的 层数 L;各隐含层内的隐单元个数 ; 训练数据按 mini-batch 划分后的序列 ,其中 j = ,序列长度 Max。 Wi i = (1,2,··· ,L) b i i = (0,1,··· ,L) 输出 链接权重 , ;偏执向量 , 。 1) 初始化输入层的偏执向量; 2) For i in 1 to L do; Wi = 0 b i 3) 初始化 , = 0 ; 4) For t in 1 to T do; 5) For j in 1 to Max do; X 6) mini-batch = j ; α Wi b i b i−1 7) DNNUpdate (mini-batch, , , , ); 8) End For; 9) End For; 10) End For; 其中 DNNUpdate 算法采用经典的对比散度算 法 (contrastive divergence,CD-K),具体见文献[7]。 通过逐层无监督预训练算法可以得到较好的神 经网络初始化参数,然后使用蒙古语标注数据 (即 特征状态) 通过 BP(error back propagation) 算法进 行有监督的调优,最终得到可用于声学状态分类的 DNN 深度神经网络模型。有监督的调优算法采用 随机梯度下降算法进行实现,具体见算法 2。 算法 2 随机梯度下降算法 输入 训练集 set,批量大小 batch_size;学习 率 α,循环次数 epoch。 输出 模型参数 weight。 1) weight←initWeight(); 2) For j in 0 to epoch do; 3) batch←randomSelect(set, batch_size); 4) weight←getWeightFromMaster(); 5) ∆W ←miniGradient(batch, weight); 6) weight←weight- α * ∆W ; 7) End for; 1.3 蒙古语语音数据识别 通过对 DNN 网络的预训练和调优后,可以利 用 DNN-HMM 声学模型对蒙古语语音数据进行识 别,具体的过程如下。 首先,根据输入的蒙古语声学特征向量,计算 DNN 深度神经网络前 L 层的输出,即 v α = f(z α ) = f(Wα v α−1 + b α ),0 ⩽ α < L (1) z α z α = Wα v α−1 + b α z α ∈ R NαX1 v α v α ∈ R NαX1 Wα Wα ∈ R NαXNα−1 b α b α ∈ R NαX1 Nα α Nα ∈ R V 0 V 0 = o ∈ R N0X1 N0 = D f(·) : R NαX1 → R NαX1 f(·) 式中: 表示激励向量, 且 ; 表示激活向量, ; 表示权重矩阵, ; 表示偏执向量, , 表示第 层的神经节点个数且 ; 表示网络的输入特 征, 。在 DNN-HMM声学模型中,输入 特征即为声学特征向量。其中 表示输入声学 特征向量的维度, 表示激活函数对 激励向量的计算过程, 表示激活函数。 然后,利用 L 层的 softmax 分类层计算当前特 征关于全部声学状态的后验概率,即当前特征属于 各蒙古语声学状态的概率: v i = Pdnn(i|O) = softmax(i) (2) i = 1,2,··· ,C C v i i i 在 DNN-HMM 蒙古语声学模型中,DNN 深度 神经网络用于估计每个 HMM 状态的后验概率,所 以 DNN 的输出是按照 HMM 隐含状态进行分类输 出的,实质上属于多分类任务,因此 DNN 的输出层 通常是 softmax 分类层。而且 softmax 分类层的神 经单元个数与 HMM 声学模型中的隐含状态个数相 同。在式 (2) 中, ,其中 表示声学模型 的隐含状态个数, 表示 softmax 分类层第 个神经 单元的输出,即输入声学特征向量 O 关于声学模型 第 个隐含状态的后验概率。得到隐含状态的后验 概率后,利用维特比解码算法进行解码得到最优路 径。在直接解码前需要根据贝叶斯公式,将各个状 态的后验概率除以其自身的先验概率,得到各状态 规整的似然值。隐含状态的先验概率计算较为简 单,仅通过计算各状态对应帧总数与全部声学特征 帧数的比值即可得到。 L1 W1 V (a) じ1ᅮ䮼 ॗᅮ䃙㏯ L2 L1 W2 W1 V (b) じ2ᅮ䮼ॗᅮ 䃙㏯ L3 L2 L1 W3 W2 W1 V (c) じ3ᅮ䮼ॗᅮ 䃙㏯ 图 2 DNN-HMM 蒙古语声学模型预训练过程 Fig. 2 The pre-training DNN-HMM process for Mongolian acoustic model. ·488· 智 能 系 统 学 报 第 13 卷