正在加载图片...

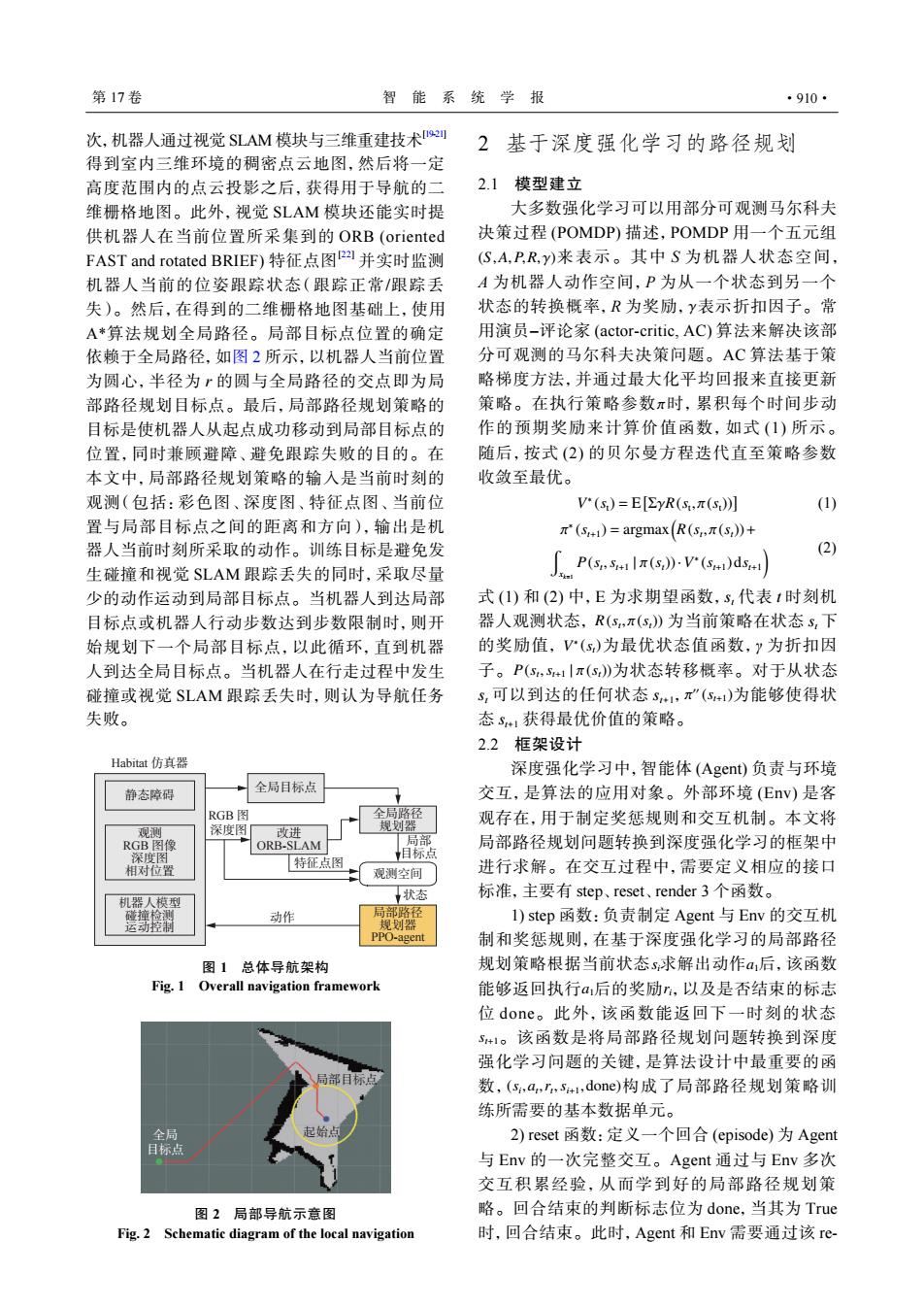

第17卷 智能系统学报 ·910· 次,机器人通过视觉SLAM模块与三维重建技术2刘 2基于深度强化学习的路径规划 得到室内三维环境的稠密点云地图,然后将一定 高度范围内的点云投影之后,获得用于导航的二 2.1模型建立 维栅格地图。此外,视觉SLAM模块还能实时提 大多数强化学习可以用部分可观测马尔科夫 供机器人在当前位置所采集到的ORB(oriented 决策过程(POMDP)描述,POMDP用一个五元组 FAST and rotated BRIEF)特征点图Pa并实时监测 (S,A,PR,y)来表示。其中S为机器人状态空间, 机器人当前的位姿跟踪状态(跟踪正常/跟踪丢 A为机器人动作空间,P为从一个状态到另一个 失)。然后,在得到的二维栅格地图基础上,使用 状态的转换概率,R为奖励,Y表示折扣因子。常 A*算法规划全局路径。局部目标点位置的确定 用演员-评论家(actor-.critic,AC)算法来解决该部 依赖于全局路径,如图2所示,以机器人当前位置 分可观测的马尔科夫决策问题。AC算法基于策 为圆心,半径为r的圆与全局路径的交点即为局 略梯度方法,并通过最大化平均回报来直接更新 部路径规划目标点。最后,局部路径规划策略的 策略。在执行策略参数π时,累积每个时间步动 目标是使机器人从起点成功移动到局部目标点的 作的预期奖励来计算价值函数,如式(1)所示。 位置,同时兼顾避障、避免跟踪失败的目的。在 随后,按式(2)的贝尔曼方程迭代直至策略参数 本文中,局部路径规划策略的输入是当前时刻的 收敛至最优。 观测(包括:彩色图、深度图、特征点图、当前位 V"(s)=EyR(s,π(s) (1) 置与局部目标点之间的距离和方向),输出是机 "(s1)=argmax(R(s,.(s,))+ 器人当前时刻所采取的动作。训练目标是避免发 (2) 生碰撞和视觉SLAM跟踪丢失的同时,采取尽量 Pnlr》-vid- 少的动作运动到局部目标点。当机器人到达局部 式(1)和(2)中,E为求期望函数,S,代表1时刻机 目标点或机器人行动步数达到步数限制时,则开 器人观测状态,R(s,π(s》为当前策略在状态S,下 始规划下一个局部目标点,以此循环,直到机器 的奖励值,V(s)为最优状态值函数,y为折扣因 人到达全局目标点。当机器人在行走过程中发生 子。P(s,S41|π(s》为状态转移概率。对于从状态 碰撞或视觉SLAM跟踪丢失时,则认为导航任务 s,可以到达的任何状态S1,π”(S)为能够使得状 失败。 态S1获得最优价值的策略。 2.2框架设计 Habitat仿真器 深度强化学习中,智能体(Agent)负责与环境 静态障碍 全局目标点 交互,是算法的应用对象。外部环境(Ev)是客 RGB图 全局路径 观测 深度图「 改进 规划器 观存在,用于制定奖惩规则和交互机制。本文将 RGB图像 ORB-SLAM 局部 局部路径规划问题转换到深度强化学习的框架中 深度图 相对位置 特征点图 相标点 观测空间 进行求解。在交互过程中,需要定义相应的接口 机器人模型 状态 标准,主要有step、reset、.render3个函数。 动作 局部路径 1)step函数:负责制定Agent与Env的交互机 规划器 PPO-agent 制和奖惩规则,在基于深度强化学习的局部路径 图1总体导航架构 规划策略根据当前状态s求解出动作后,该函数 Fig.1 Overall navigation framework 能够返回执行后的奖励,以及是否结束的标志 位done。此外,该函数能返回下一时刻的状态 S+1。该函数是将局部路径规划问题转换到深度 强化学习问题的关键,是算法设计中最重要的函 数,(s,a,,s+i,done)构成了局部路径规划策略训 练所需要的基本数据单元。 全局 起始点 2)reset函数:定义一个回合(episode)为Agent 目标点 与Env的一次完整交互。Agent通过与Env多次 交互积累经验,从而学到好的局部路径规划策 图2局部导航示意图 略。回合结束的判断标志位为done,当其为True Fig.2 Schematic diagram of the local navigation 时,回合结束。此时,Agent和Env需要通过该re次,机器人通过视觉 SLAM 模块与三维重建技术[19-21] 得到室内三维环境的稠密点云地图,然后将一定 高度范围内的点云投影之后,获得用于导航的二 维栅格地图。此外,视觉 SLAM 模块还能实时提 供机器人在当前位置所采集到的 ORB (oriented FAST and rotated BRIEF) 特征点图[22] 并实时监测 机器人当前的位姿跟踪状态(跟踪正常/跟踪丢 失)。然后,在得到的二维栅格地图基础上,使用 A*算法规划全局路径。局部目标点位置的确定 依赖于全局路径,如图 2 所示,以机器人当前位置 为圆心,半径为 r 的圆与全局路径的交点即为局 部路径规划目标点。最后,局部路径规划策略的 目标是使机器人从起点成功移动到局部目标点的 位置,同时兼顾避障、避免跟踪失败的目的。在 本文中,局部路径规划策略的输入是当前时刻的 观测(包括:彩色图、深度图、特征点图、当前位 置与局部目标点之间的距离和方向),输出是机 器人当前时刻所采取的动作。训练目标是避免发 生碰撞和视觉 SLAM 跟踪丢失的同时,采取尽量 少的动作运动到局部目标点。当机器人到达局部 目标点或机器人行动步数达到步数限制时,则开 始规划下一个局部目标点,以此循环,直到机器 人到达全局目标点。当机器人在行走过程中发生 碰撞或视觉 SLAM 跟踪丢失时,则认为导航任务 失败。 全局目标点 全局路径 规划器 状态 动作 观测空间 局部 目标点 静态障碍 特征点图 Habitat 仿真器 观测 RGB 图像 深度图 相对位置 机器人模型 碰撞检测 运动控制 RGB 图 深度图 改进 ORB-SLAM 局部路径 规划器 PPO-agent 图 1 总体导航架构 Fig. 1 Overall navigation framework 局部目标点 全局 起始点 目标点 图 2 局部导航示意图 Fig. 2 Schematic diagram of the local navigation 2 基于深度强化学习的路径规划 2.1 模型建立 (S,A,P,R, γ) γ π 大多数强化学习可以用部分可观测马尔科夫 决策过程 (POMDP) 描述,POMDP 用一个五元组 来表示。其中 S 为机器人状态空间, A 为机器人动作空间,P 为从一个状态到另一个 状态的转换概率,R 为奖励, 表示折扣因子。常 用演员–评论家 (actor-critic, AC) 算法来解决该部 分可观测的马尔科夫决策问题。AC 算法基于策 略梯度方法,并通过最大化平均回报来直接更新 策略。在执行策略参数 时,累积每个时间步动 作的预期奖励来计算价值函数,如式 (1) 所示。 随后,按式 (2) 的贝尔曼方程迭代直至策略参数 收敛至最优。 V ∗ (st) = E [ ΣγR(st , π(st))] (1) π ∗ (st+1) = argmax( R(st , π(st))+ w xk=1 P(st ,st+1 | π(st))·V ∗ (st+1)dst+1 ) (2) R(st , π(st)) V ∗ (st) P(st ,st+1 | π(st)) π ′′ (st+1) 式 (1) 和 (2) 中,E 为求期望函数,st 代表 t 时刻机 器人观测状态, 为当前策略在状态 st 下 的奖励值, 为最优状态值函数,γ 为折扣因 子。 为状态转移概率。对于从状态 st 可以到达的任何状态 st+1, 为能够使得状 态 st+1 获得最优价值的策略。 2.2 框架设计 深度强化学习中,智能体 (Agent) 负责与环境 交互,是算法的应用对象。外部环境 (Env) 是客 观存在,用于制定奖惩规则和交互机制。本文将 局部路径规划问题转换到深度强化学习的框架中 进行求解。在交互过程中,需要定义相应的接口 标准,主要有 step、reset、render 3 个函数。 si a1 a1 ri st+1 (si ,at ,rt ,si+1,done) 1) step 函数:负责制定 Agent 与 Env 的交互机 制和奖惩规则,在基于深度强化学习的局部路径 规划策略根据当前状态 求解出动作 后,该函数 能够返回执行 后的奖励 ,以及是否结束的标志 位 done。此外,该函数能返回下一时刻的状态 。该函数是将局部路径规划问题转换到深度 强化学习问题的关键,是算法设计中最重要的函 数, 构成了局部路径规划策略训 练所需要的基本数据单元。 2) reset 函数:定义一个回合 (episode) 为 Agent 与 Env 的一次完整交互。Agent 通过与 Env 多次 交互积累经验,从而学到好的局部路径规划策 略。回合结束的判断标志位为 done,当其为 True 时,回合结束。此时,Agent 和 Env 需要通过该 re- 第 17 卷 智 能 系 统 学 报 ·910·