正在加载图片...

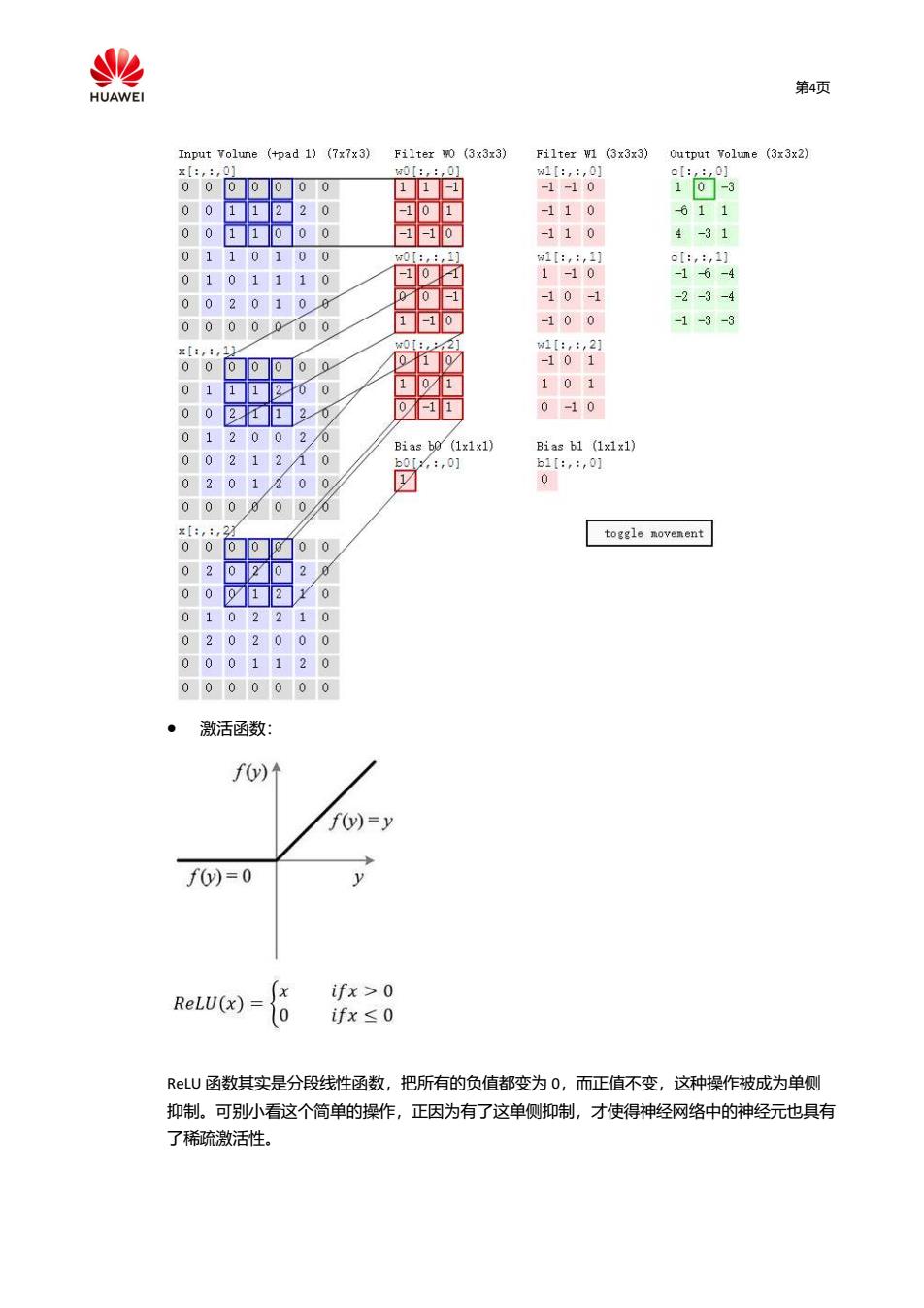

% HUAWEI 第4页 Input Volume (+pad 1)(7x7x3)Filter wo (3x3x3) Filter W1 (3x3x3)Output Volume (3x3x2) x【:,:,0] 0[:,:,0】 w1I:,:,0] el::,0] 0 1 -1-10 10-3 -110 611 -1-10 -110 4-31 00 w0[:,:,1的 1[:,:,1] o[:,:,1] 0 10 -10-1 1-10 -16-4 002 0 00 -1 -10-1 -2-3-4 0 0000 0 1-10 -100 -1-3-3 w0【:,,2] x[:,:,1 w1[:,:,2 00 0 0 -101 0 0 1 01 101 0 1 0-10 0 Bias bo(1x1x1) Bias b1 (1x1x1) 9 b0:,01 b1I:,:,0] 0 0 0 x[:, :2 toggle movement 0 0 0 00 0 112 0 0000000 激活函数: fy)↑ f(y)=y fy)=0 ifx>0 ReLU(x) ifx≤0 LU函数其实是分段线性函数,把所有的负值都变为0,而正值不变,这种操作被成为单侧 抑制。可别小看这个简单的操作,正因为有了这单侧抑制,才使得神经网络中的神经元也具有 了稀疏激活性。第4页 激活函数: ReLU 函数其实是分段线性函数,把所有的负值都变为 0,而正值不变,这种操作被成为单侧 抑制。可别小看这个简单的操作,正因为有了这单侧抑制,才使得神经网络中的神经元也具有 了稀疏激活性