正在加载图片...

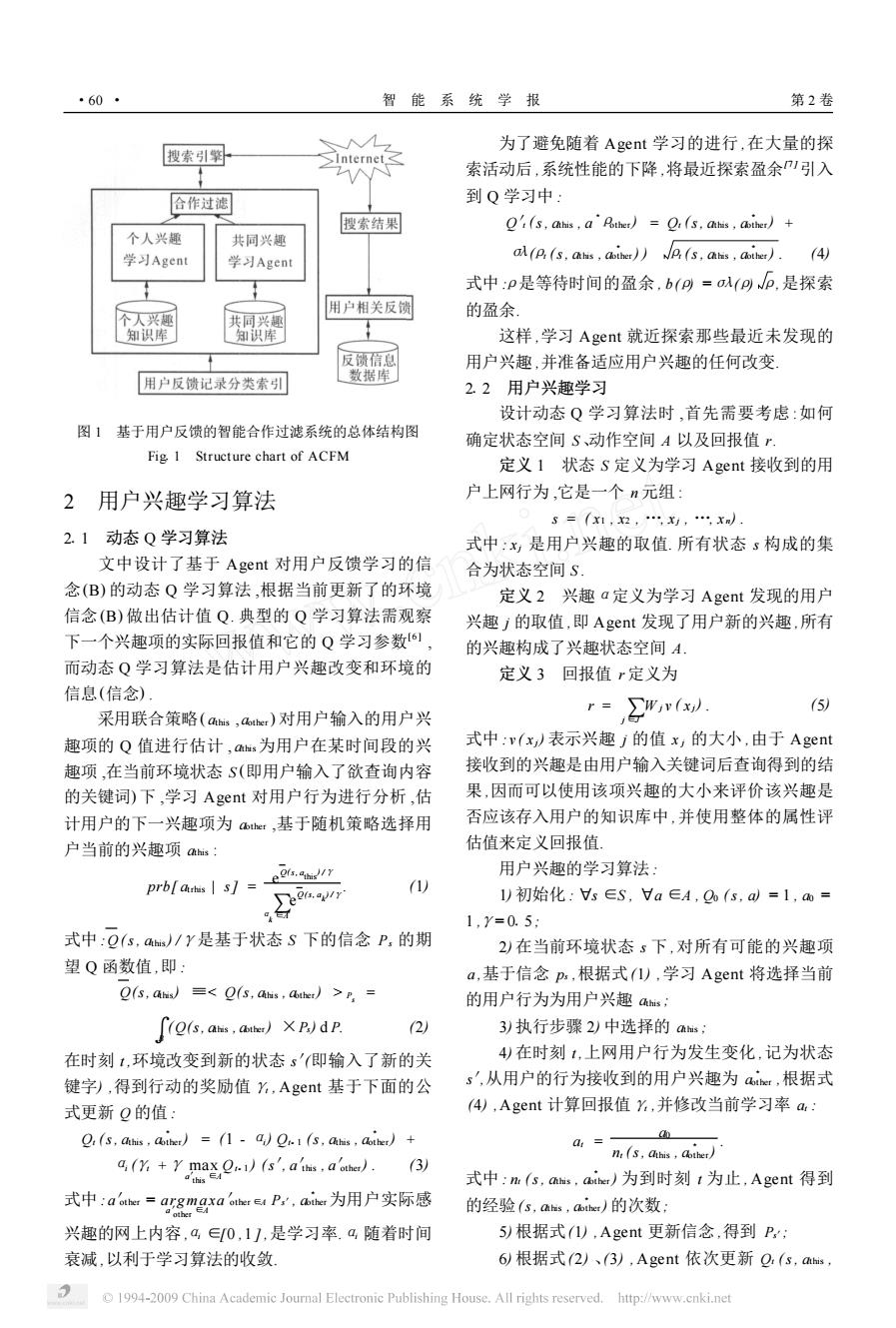

·60 智 能系统学报 第2卷 搜索引繁 为了避免随着Agent学习的进行,在大量的探 索活动后,系统性能的下降,将最近探索盈余引入 合作过滤 到Q学习中: 搜索结果 '(s,ahis,a'Aother)=.(s.ahis,aiher)+ 个人兴趣 共同兴趣 学习Agent 学习Agent a(p:(s,ahis aother))(s,ahis,aother).(4) 式中:p是等待时间的盈余,b(p=a以(pp,是探索 用户相关反馈 个人兴即 的盈余 共同兴趣 知识库 知识库 这样,学习Agent就近探索那些最近未发现的 反馈信息 用户兴趣,并准备适应用户兴趣的任何改变 用户反馈记录分类索引 数据库 2.2用户兴趣学习 设计动态Q学习算法时,首先需要考虑:如何 图1基于用户反馈的智能合作过滤系统的总体结构图 确定状态空间S、动作空间A以及回报值r Fig 1 Structure chart of ACFM 定义1状态S定义为学习Agent接收到的用 2用户兴趣学习算法 户上网行为,它是一个n元组: S=x1,x2,,x,,x) 2.1动态Q学习算法 式中:x是用户兴趣的取值.所有状态s构成的集 文中设计了基于Agent对用户反馈学习的信 合为状态空间S 念(B)的动态Q学习算法,根据当前更新了的环境 定义2兴趣a定义为学习Agent发现的用户 信念(B)做出估计值Q.典型的Q学习算法需观察 兴趣j的取值,即Agent发现了用户新的兴趣,所有 下一个兴趣项的实际回报值和它的Q学习参数6), 的兴趣构成了兴趣状态空间A. 而动态Q学习算法是估计用户兴趣改变和环境的 定义3回报值r定义为 信息(信念) r=( (5) 采用联合策略(ams,aer)对用户输入的用户兴 趣项的Q值进行估计,为用户在某时间段的兴 式中:v(x表示兴趣j的值x,的大小,由于Agent 趣项,在当前环境状态S(即用户输入了欲查询内容 接收到的兴趣是由用户输入关键词后查询得到的结 的关键词)下,学习Agent对用户行为进行分析,估 果,因而可以使用该项兴趣的大小来评价该兴趣是 计用户的下一兴趣项为aer,基于随机策略选择用 否应该存入用户的知识库中,并使用整体的属性评 户当前的兴趣项as: 估值来定义回报值 e2s.ah/ 用户兴趣的学习算法: prbl authis s= Jeet.oyin (1) 1)初始化:s∈S,a∈A,Q(s,ad=1,a= 1,Y=0.5: 式中:Q(s,as)/Y是基于状态S下的信念P,的期 2)在当前环境状态s下,对所有可能的兴趣项 望Q函数值,即: a,基于信念ps,根据式1),学习Agent将选择当前 O(s,ahs)<e(s,atis,ather)>r= 的用户行为为用户兴趣as; ∫es,as,ar)Xp)dp (2) 3)执行步骤2)中选择的as; 在时刻1,环境改变到新的状态s'(即输入了新的关 4)在时刻1,上网用户行为发生变化,记为状态 键字),得到行动的奖励值Y,Agent基于下面的公 s',从用户的行为接收到的用户兴趣为ar,根据式 式更新Q的值: (4),Agent计算回报值,并修改当前学习率a: 2:(s,ahis,ather)=(1-a)e.1(s,atis,ather)+ a= n(s,ais Cther) d(Y +r max 2.)(s aths a'other). (3 this 式中:n(s,ms,aier)为到时刻1为止,Agent得到 式中:a=argmxP.,ai为用户实际感 的经验(s,as,Cthet)的次数, 兴趣的网上内容,a∈0,11,是学习率.a随着时间 5根据式(1),Agent更新信念,得到P: 衰减,以利于学习算法的收敛 6)根据式(2)、(3),Agent依次更新Q,(s,amms, 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net图 1 基于用户反馈的智能合作过滤系统的总体结构图 Fig11 Structure chart of ACFM 2 用户兴趣学习算法 211 动态 Q 学习算法 文中设计了基于 Agent 对用户反馈学习的信 念(B) 的动态 Q 学习算法 ,根据当前更新了的环境 信念(B) 做出估计值 Q. 典型的 Q 学习算法需观察 下一个兴趣项的实际回报值和它的 Q 学习参数[6 ] , 而动态 Q 学习算法是估计用户兴趣改变和环境的 信息(信念) . 采用联合策略( athis , aother ) 对用户输入的用户兴 趣项的 Q 值进行估计 , athis为用户在某时间段的兴 趣项 ,在当前环境状态 S (即用户输入了欲查询内容 的关键词) 下 ,学习 Agent 对用户行为进行分析 ,估 计用户的下一兴趣项为 aother ,基于随机策略选择用 户当前的兴趣项 athis : prb[ atrhis | s] = e Q(s, a this ) /γ αk∑∈A e Q(s, a k ) /γ . (1) 式中 :Q (s, athis ) /γ是基于状态 S 下的信念 Ps 的期 望 Q 函数值 ,即 : Q(s, athis) ≡< Q(s, athis , aother ) > Ps = ∫B ( Q(s, athis , aother ) ×Ps) d P. (2) 在时刻 t ,环境改变到新的状态 s′(即输入了新的关 键字) ,得到行动的奖励值γt , Agent 基于下面的公 式更新 Q 的值 : Qt (s, athis , a 3 other ) = (1 - αi) Qt- 1 (s, athis , a 3 other ) + αi (γt +γ max a′this ∈A Qt- 1 ) (s′, a′this , a′other ) . (3) 式中 : a′other = argm ax a′other ∈A a′other ∈A Ps′, a 3 other为用户实际感 兴趣的网上内容 ,αi ∈[0 ,1 ] ,是学习率.αi 随着时间 衰减 ,以利于学习算法的收敛. 为了避免随着 Agent 学习的进行 ,在大量的探 索活动后 ,系统性能的下降 ,将最近探索盈余[7 ]引入 到 Q 学习中 : Q′t (s, athis , a 3ρother ) = Qt (s, athis , a 3 other ) + σλ(ρt (s, athis , a 3 other ) ) ρt (s, athis , a 3 other ) . (4) 式中 :ρ是等待时间的盈余 , b(ρ) =σλ(ρ) ρ,是探索 的盈余. 这样 ,学习 Agent 就近探索那些最近未发现的 用户兴趣 ,并准备适应用户兴趣的任何改变. 212 用户兴趣学习 设计动态 Q 学习算法时 ,首先需要考虑 :如何 确定状态空间 S 、动作空间 A 以及回报值 r. 定义 1 状态 S 定义为学习 Agent 接收到的用 户上网行为 ,它是一个 n 元组 : s = ( x1 , x2 , …, x j , …, x n ) . 式中 : x j 是用户兴趣的取值. 所有状态 s 构成的集 合为状态空间 S . 定义 2 兴趣α定义为学习 Agent 发现的用户 兴趣 j 的取值 ,即 Agent 发现了用户新的兴趣 ,所有 的兴趣构成了兴趣状态空间 A . 定义 3 回报值 r 定义为 r = j ∑∈J W j v ( x j) . (5) 式中 : v ( x j) 表示兴趣 j 的值 x j 的大小 ,由于 Agent 接收到的兴趣是由用户输入关键词后查询得到的结 果 ,因而可以使用该项兴趣的大小来评价该兴趣是 否应该存入用户的知识库中 ,并使用整体的属性评 估值来定义回报值. 用户兴趣的学习算法 : 1) 初始化 : Πs ∈S , Πa ∈A , Q0 (s, a) = 1 , a0 = 1 ,γ= 015 ; 2) 在当前环境状态 s 下 ,对所有可能的兴趣项 a ,基于信念 ps ,根据式(1) ,学习 Agent 将选择当前 的用户行为为用户兴趣 athis ; 3) 执行步骤 2) 中选择的 athis ; 4) 在时刻 t ,上网用户行为发生变化 ,记为状态 s′,从用户的行为接收到的用户兴趣为 a 3 other ,根据式 (4) ,Agent 计算回报值γt ,并修改当前学习率 at : at = a0 nt (s, athis , a 3 other ) . 式中 : nt (s, athis , a 3 other ) 为到时刻 t 为止 , Agent 得到 的经验(s, athis , a 3 other ) 的次数; 5) 根据式(1) ,Agent 更新信念 ,得到 Ps′; 6) 根据式(2) 、(3) , Agent 依次更新 Qt (s, athis , ·60 · 智 能 系 统 学 报 第 2 卷