正在加载图片...

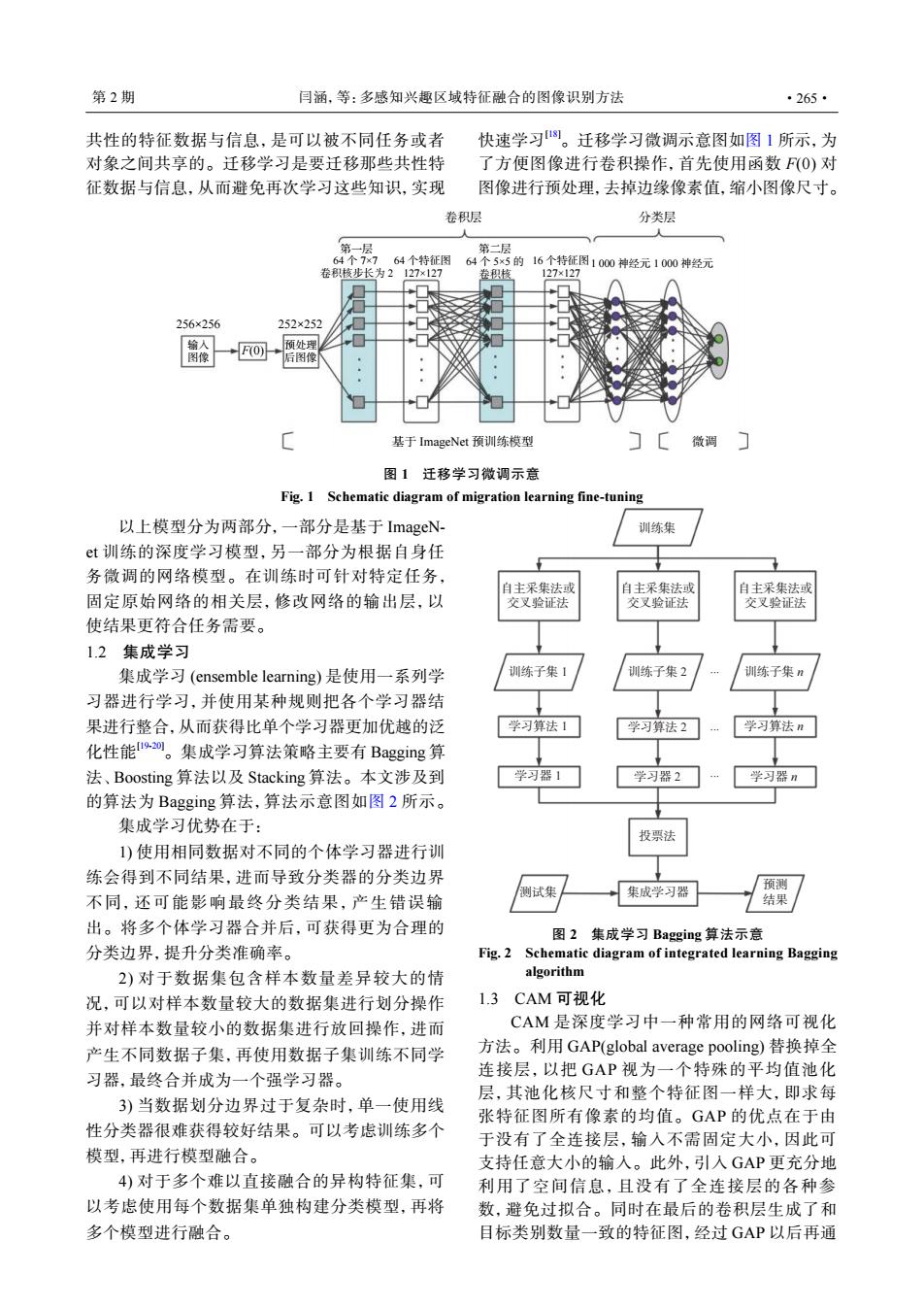

第2期 闫涵,等:多感知兴趣区域特征融合的图像识别方法 ·265· 共性的特征数据与信息,是可以被不同任务或者 快速学习。迁移学习微调示意图如图1所示,为 对象之间共享的。迁移学习是要迁移那些共性特 了方便图像进行卷积操作,首先使用函数F(O)对 征数据与信息,从而避免再次学习这些知识,实现 图像进行预处理,去掉边缘像素值,缩小图像尺寸。 卷积层 分类层 第一 第二层 64个7 7 64个特征图 64个5×5的16个特征图1000神经元1000神经元 卷1核步长为2127×127 卷积核 127×127 256×256 252×252 预处理 图像 FO) 后图 基于ImageNet预训练模型 微调门 图1迁移学习微调示意 Fig.1 Schematic diagram of migration learning fine-tuning 以上模型分为两部分,一部分是基于ImageN- 训练集 t训练的深度学习模型,另一部分为根据自身任 务微调的网络模型。在训练时可针对特定任务, 自主采集法或 自主采集法或 自主采集法或 固定原始网络的相关层,修改网络的输出层,以 交叉验证法 交叉验证法 交叉验证法 使结果更符合任务需要。 1.2集成学习 集成学习(ensemble learning)是使用一系列学 训练子集1 训练子集2 训练子集: 习器进行学习,并使用某种规则把各个学习器结 果进行整合,从而获得比单个学习器更加优越的泛 学习算法1 学习算法2 学习算法n 化性能刘。集成学习算法策略主要有Bagging算 法、Boosting算法以及Stacking算法。本文涉及到 学习器1 学习器2 学习器n 的算法为Bagging算法,算法示意图如图2所示。 集成学习优势在于: 投票法 1)使用相同数据对不同的个体学习器进行训 练会得到不同结果,进而导致分类器的分类边界 则试集 集成学习器 预测 不同,还可能影响最终分类结果,产生错误输 结果 出。将多个体学习器合并后,可获得更为合理的 图2集成学习Bagging算法示意 分类边界,提升分类准确率。 Fig.2 Schematic diagram of integrated learning Bagging 2)对于数据集包含样本数量差异较大的情 algorithm 况,可以对样本数量较大的数据集进行划分操作 1.3CAM可视化 并对样本数量较小的数据集进行放回操作,进而 CAM是深度学习中一种常用的网络可视化 产生不同数据子集,再使用数据子集训练不同学 方法。利用GAP(global average pooling)替换掉全 习器,最终合并成为一个强学习器。 连接层,以把GAP视为一个特殊的平均值池化 层,其池化核尺寸和整个特征图一样大,即求每 3)当数据划分边界过于复杂时,单一使用线 张特征图所有像素的均值。GAP的优点在于由 性分类器很难获得较好结果。可以考虑训练多个 于没有了全连接层,输入不需固定大小,因此可 模型,再进行模型融合。 支持任意大小的输入。此外,引入GAP更充分地 4)对于多个难以直接融合的异构特征集,可 利用了空间信息,且没有了全连接层的各种参 以考虑使用每个数据集单独构建分类模型,再将 数,避免过拟合。同时在最后的卷积层生成了和 多个模型进行融合。 目标类别数量一致的特征图,经过GAP以后再通共性的特征数据与信息,是可以被不同任务或者 对象之间共享的。迁移学习是要迁移那些共性特 征数据与信息,从而避免再次学习这些知识,实现 快速学习[18]。迁移学习微调示意图如图 1 所示,为 了方便图像进行卷积操作,首先使用函数 F(0) 对 图像进行预处理,去掉边缘像素值,缩小图像尺寸。 256×256 252×252 F(0) 输入 图像 预处理 后图像 卷积层 基于 ImageNet 预训练模型 微调 第一层 64 个 7×7 卷积核步长为 2 第二层 64 个 5×5 的 卷积核 64 个特征图 127×127 16 个特征图 127×127 1 000 神经元 1 000 神经元 分类层 图 1 迁移学习微调示意 Fig. 1 Schematic diagram of migration learning fine-tuning 以上模型分为两部分,一部分是基于 ImageNet 训练的深度学习模型,另一部分为根据自身任 务微调的网络模型。在训练时可针对特定任务, 固定原始网络的相关层,修改网络的输出层,以 使结果更符合任务需要。 1.2 集成学习 集成学习 (ensemble learning) 是使用一系列学 习器进行学习,并使用某种规则把各个学习器结 果进行整合,从而获得比单个学习器更加优越的泛 化性能[19-20]。集成学习算法策略主要有 Bagging 算 法、Boosting 算法以及 Stacking 算法。本文涉及到 的算法为 Bagging 算法,算法示意图如图 2 所示。 集成学习优势在于: 1) 使用相同数据对不同的个体学习器进行训 练会得到不同结果,进而导致分类器的分类边界 不同,还可能影响最终分类结果,产生错误输 出。将多个体学习器合并后,可获得更为合理的 分类边界,提升分类准确率。 2) 对于数据集包含样本数量差异较大的情 况,可以对样本数量较大的数据集进行划分操作 并对样本数量较小的数据集进行放回操作,进而 产生不同数据子集,再使用数据子集训练不同学 习器,最终合并成为一个强学习器。 3) 当数据划分边界过于复杂时,单一使用线 性分类器很难获得较好结果。可以考虑训练多个 模型,再进行模型融合。 4) 对于多个难以直接融合的异构特征集,可 以考虑使用每个数据集单独构建分类模型,再将 多个模型进行融合。 训练集 自主采集法或 交叉验证法 训练子集 1 训练子集 2 ... 训练子集 n ... ... 学习算法 1 学习算法 2 学习算法 n 学习器 1 学习器 2 投票法 测试集 集成学习器 预测 结果 学习器 n 自主采集法或 交叉验证法 自主采集法或 交叉验证法 图 2 集成学习 Bagging 算法示意 Fig. 2 Schematic diagram of integrated learning Bagging algorithm 1.3 CAM 可视化 CAM 是深度学习中一种常用的网络可视化 方法。利用 GAP(global average pooling) 替换掉全 连接层,以把 GAP 视为一个特殊的平均值池化 层,其池化核尺寸和整个特征图一样大,即求每 张特征图所有像素的均值。GAP 的优点在于由 于没有了全连接层,输入不需固定大小,因此可 支持任意大小的输入。此外,引入 GAP 更充分地 利用了空间信息,且没有了全连接层的各种参 数,避免过拟合。同时在最后的卷积层生成了和 目标类别数量一致的特征图,经过 GAP 以后再通 第 2 期 闫涵,等:多感知兴趣区域特征融合的图像识别方法 ·265·