正在加载图片...

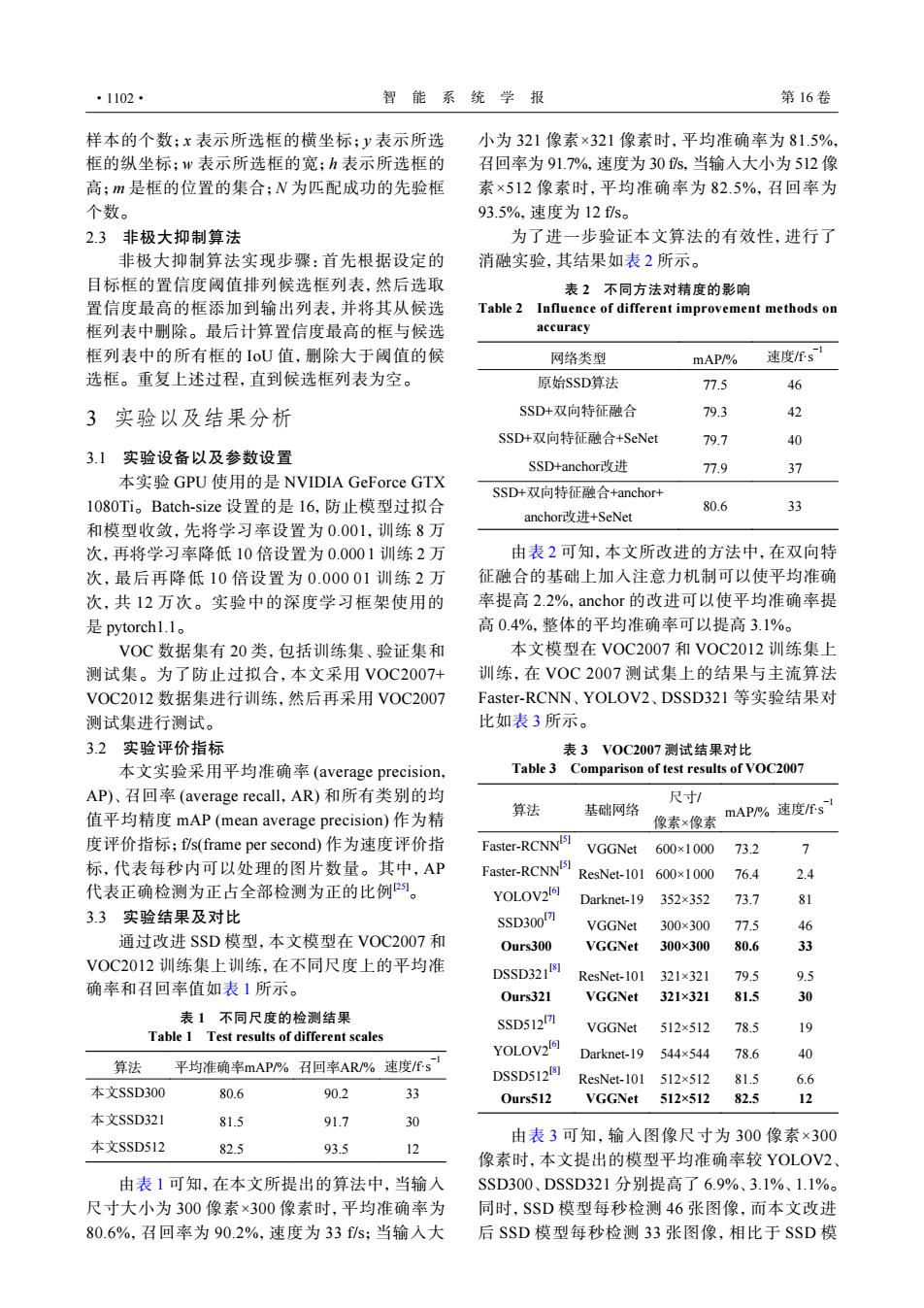

·1102· 智能系统学报 第16卷 样本的个数;x表示所选框的横坐标;y表示所选 小为321像素×321像素时,平均准确率为81.5%, 框的纵坐标;w表示所选框的宽;h表示所选框的 召回率为91.7%,速度为30s,当输人大小为512像 高;m是框的位置的集合;N为匹配成功的先验框 素×512像素时,平均准确率为82.5%,召回率为 个数。 93.5%.速度为12fs。 2.3非极大抑制算法 为了进一步验证本文算法的有效性,进行了 非极大抑制算法实现步骤:首先根据设定的 消融实验,其结果如表2所示。 目标框的置信度阈值排列候选框列表,然后选取 表2不同方法对精度的影响 置信度最高的框添加到输出列表,并将其从候选 Table 2 Influence of different improvement methods on 框列表中删除。最后计算置信度最高的框与候选 accuracy 框列表中的所有框的IoU值,删除大于阈值的候 网络类型 mAP/ 速度fs 选框。重复上述过程,直到候选框列表为空。 原始SSD算法 77.5 46 3实验以及结果分析 SSD+双向特征融合 79.3 42 SSD+双向特征融合+SeNet 79.7 40 3.1实验设备以及参数设置 SSD+anchori改进 77.9 37 本实验GPU使用的是NVIDIA GeForce GTX SSD+双向特征融合+anchor+- 1080Ti。Batch-size设置的是16,防止模型过拟合 80.6 33 anchori改进+SeNet 和模型收敛,先将学习率设置为0.001,训练8万 次,再将学习率降低10倍设置为0.0001训练2万 由表2可知,本文所改进的方法中,在双向特 次,最后再降低10倍设置为0.00001训练2万 征融合的基础上加入注意力机制可以使平均准确 次,共12万次。实验中的深度学习框架使用的 率提高2.2%,anchor的改进可以使平均准确率提 是pytorch1.1. 高0.4%,整体的平均准确率可以提高3.1%。 VOC数据集有20类,包括训练集、验证集和 本文模型在VOC2007和VOC2012训练集上 测试集。为了防止过拟合,本文采用VOC2007+ 训练,在VOC2007测试集上的结果与主流算法 VOC2012数据集进行训练,然后再采用VOC2007 Faster--RCNN、YOLOV2、DSSD321等实验结果对 测试集进行测试。 比如表3所示。 3.2实验评价指标 表3VOC2007测试结果对比 本文实验采用平均准确率(average precision, Table 3 Comparison of test results of VOC2007 AP)、召回率(average recall,,AR)和所有类别的均 尺寸/ 值平均精度mAP(mean average precision)作为精 算法 基础网络 像素×像素 mAP/%速度Es 度评价指标;fis(frame per second)作为速度评价指 Faster-RCNNIS1 VGGNet 600×1000 73.2 7 标,代表每秒内可以处理的图片数量。其中,AP Faster-RCNNI5] ResNet-101600×1000 76.4 2.4 代表正确检测为正占全部检测为正的比例。 YOLOV216 Darknet-19 352×352 73.7 81 3.3实验结果及对比 SSD300m7 VGGNet 300×300 77.5 46 通过改进SSD模型,本文模型在VOC2007和 Ours300 VGGNet 300×300 80.6 33 VOC2012训练集上训练,在不同尺度上的平均准 DSSD321剧 ResNet-101321×321 79.5 9.5 确率和召回率值如表1所示。 Ours321 VGGNet 321×321 81.5 30 表1不同尺度的检测结果 SSD512m VGGNet 512×512 78.5 19 Table 1 Test results of different scales YOLOV2161 Darknet-19 544×544 78.6 40 算法 平均准确率mAP/%召回率AR/%速度fs DSSD512181 ResNet--101512×512 81.5 6.6 本文SSD300 80.6 90.2 33 Ours512 VGGNet 512×512 82.5 12 本文SSD321 81.5 91.7 30 由表3可知,输人图像尺寸为300像素×300 本文SSD512 82.5 93.5 12 像素时,本文提出的模型平均准确率较YOLOV2、 由表1可知,在本文所提出的算法中,当输入 SSD300、DSSD321分别提高了6.9%、3.1%、1.1%。 尺寸大小为300像素×300像素时,平均准确率为 同时,SSD模型每秒检测46张图像,而本文改进 80.6%,召回率为90.2%,速度为33fs:当输入大 后SSD模型每秒检测33张图像,相比于SSD模样本的个数;x 表示所选框的横坐标;y 表示所选 框的纵坐标;w 表示所选框的宽;h 表示所选框的 高;m 是框的位置的集合;N 为匹配成功的先验框 个数。 2.3 非极大抑制算法 非极大抑制算法实现步骤:首先根据设定的 目标框的置信度阈值排列候选框列表,然后选取 置信度最高的框添加到输出列表,并将其从候选 框列表中删除。最后计算置信度最高的框与候选 框列表中的所有框的 IoU 值,删除大于阈值的候 选框。重复上述过程,直到候选框列表为空。 3 实验以及结果分析 3.1 实验设备以及参数设置 本实验 GPU 使用的是 NVIDIA GeForce GTX 1080Ti。Batch-size 设置的是 16,防止模型过拟合 和模型收敛,先将学习率设置为 0.001,训练 8 万 次,再将学习率降低 10 倍设置为 0.000 1 训练 2 万 次,最后再降低 10 倍设置为 0.000 01 训练 2 万 次,共 12 万次。实验中的深度学习框架使用的 是 pytorch1.1。 VOC 数据集有 20 类,包括训练集、验证集和 测试集。为了防止过拟合,本文采用 VOC2007+ VOC2012 数据集进行训练,然后再采用 VOC2007 测试集进行测试。 3.2 实验评价指标 本文实验采用平均准确率 (average precision, AP)、召回率 (average recall,AR) 和所有类别的均 值平均精度 mAP (mean average precision) 作为精 度评价指标;f/s(frame per second) 作为速度评价指 标,代表每秒内可以处理的图片数量。其中,AP 代表正确检测为正占全部检测为正的比例[25]。 3.3 实验结果及对比 通过改进 SSD 模型,本文模型在 VOC2007 和 VOC2012 训练集上训练,在不同尺度上的平均准 确率和召回率值如表 1 所示。 表 1 不同尺度的检测结果 Table 1 Test results of different scales 算法 平均准确率mAP/% 召回率AR/% 速度/f·s−1 本文SSD300 80.6 90.2 33 本文SSD321 81.5 91.7 30 本文SSD512 82.5 93.5 12 由表 1 可知,在本文所提出的算法中,当输入 尺寸大小为 300 像素×300 像素时,平均准确率为 80.6%,召回率为 90.2%,速度为 33 f/s;当输入大 小为 321 像素×321 像素时,平均准确率为 81.5%, 召回率为 91.7%,速度为 30 f/s,当输入大小为 512 像 素×512 像素时,平均准确率为 82.5%,召回率为 93.5%,速度为 12 f/s。 为了进一步验证本文算法的有效性,进行了 消融实验,其结果如表 2 所示。 表 2 不同方法对精度的影响 Table 2 Influence of different improvement methods on accuracy 网络类型 mAP/% 速度/f·s−1 原始SSD算法 77.5 46 SSD+双向特征融合 79.3 42 SSD+双向特征融合+SeNet 79.7 40 SSD+anchor改进 77.9 37 SSD+双向特征融合+anchor+ anchor改进+SeNet 80.6 33 由表 2 可知,本文所改进的方法中,在双向特 征融合的基础上加入注意力机制可以使平均准确 率提高 2.2%,anchor 的改进可以使平均准确率提 高 0.4%,整体的平均准确率可以提高 3.1%。 本文模型在 VOC2007 和 VOC2012 训练集上 训练,在 VOC 2007 测试集上的结果与主流算法 Faster-RCNN、YOLOV2、DSSD321 等实验结果对 比如表 3 所示。 表 3 VOC2007 测试结果对比 Table 3 Comparison of test results of VOC2007 算法 基础网络 尺寸/ 像素×像素 mAP/% 速度/f·s−1 Faster-RCNN[5] VGGNet 600×1 000 73.2 7 Faster-RCNN[5] ResNet-101 600×1 000 76.4 2.4 YOLOV2[6] Darknet-19 352×352 73.7 81 SSD300[7] VGGNet 300×300 77.5 46 Ours300 VGGNet 300×300 80.6 33 DSSD321[8] ResNet-101 321×321 79.5 9.5 Ours321 VGGNet 321×321 81.5 30 SSD512[7] VGGNet 512×512 78.5 19 YOLOV2[6] Darknet-19 544×544 78.6 40 DSSD512[8] ResNet-101 512×512 81.5 6.6 Ours512 VGGNet 512×512 82.5 12 由表 3 可知,输入图像尺寸为 300 像素×300 像素时,本文提出的模型平均准确率较 YOLOV2、 SSD300、DSSD321 分别提高了 6.9%、3.1%、1.1%。 同时,SSD 模型每秒检测 46 张图像,而本文改进 后 SSD 模型每秒检测 33 张图像,相比于 SSD 模 ·1102· 智 能 系 统 学 报 第 16 卷