正在加载图片...

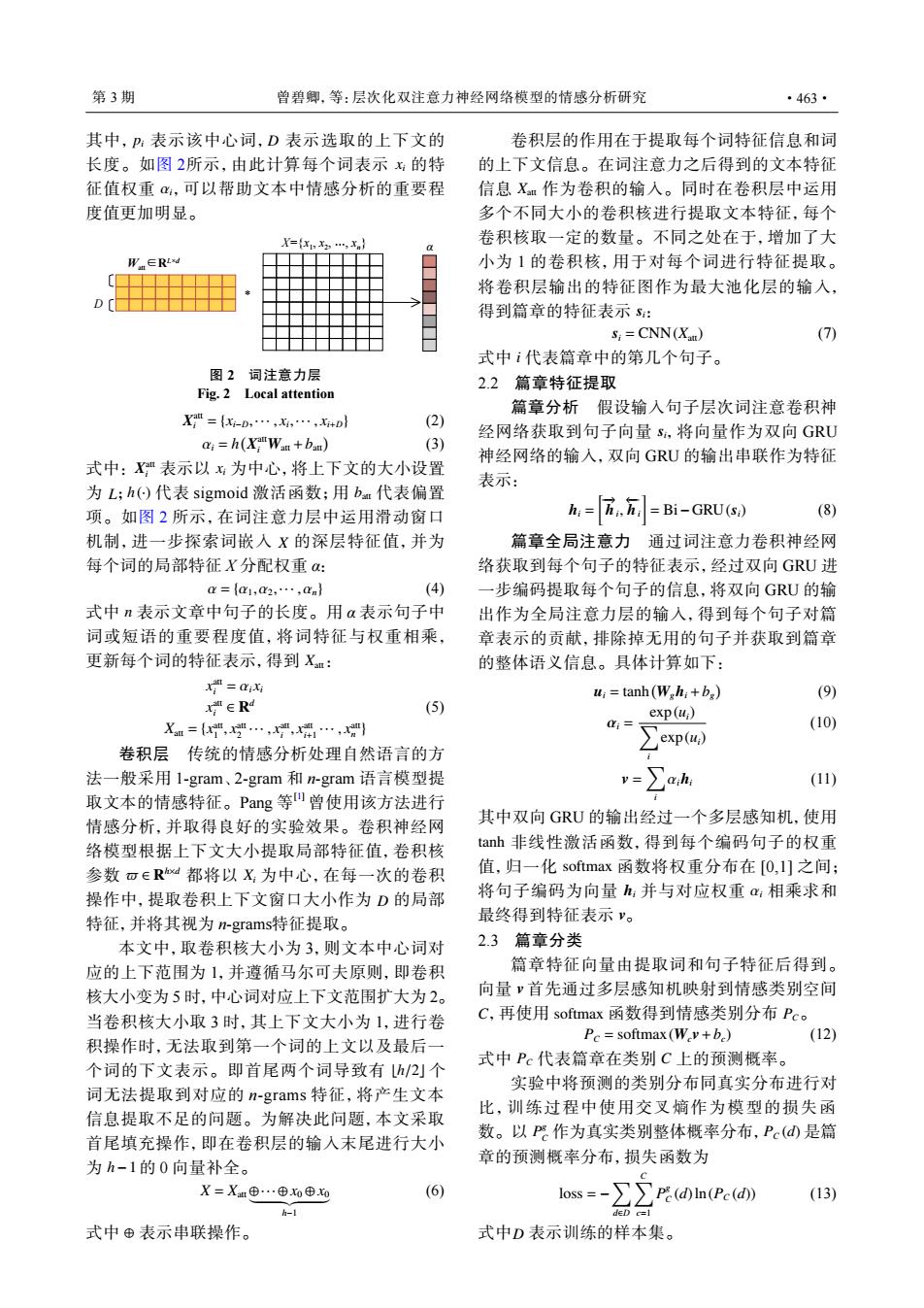

第3期 曾碧卿,等:层次化双注意力神经网络模型的情感分析研究 ·463· 其中,P:表示该中心词,D表示选取的上下文的 卷积层的作用在于提取每个词特征信息和词 长度。如图2所示,由此计算每个词表示:的特 的上下文信息。在词注意力之后得到的文本特征 征值权重,可以帮助文本中情感分析的重要程 信息X作为卷积的输人。同时在卷积层中运用 度值更加明显。 多个不同大小的卷积核进行提取文本特征,每个 X= 卷积核取一定的数量。不同之处在于,增加了大 W.∈RLd 小为1的卷积核,用于对每个词进行特征提取。 将卷积层输出的特征图作为最大池化层的输入, 得到篇章的特征表示s: s;CNN(X) (7) 式中i代表篇章中的第几个句子。 图2词注意力层 2.2篇章特征提取 Fig.2 Local attention 篇章分析假设输人句子层次词注意卷积神 X={-D,…,,…,+D} (2) 经网络获取到句子向量s,将向量作为双向GRU ai=h(X"Wan+bau) (3) 神经网络的输入,双向GU的输出串联作为特征 式中:X"表示以:为中心,将上下文的大小设置 表示: 为L;h()代表sigmoid激活函数;用bm代表偏置 项。如图2所示,在词注意力层中运用滑动窗口 h:=Z,方-Bi-GRU(s) (8) 机制,进一步探索词嵌入X的深层特征值,并为 篇章全局注意力通过词注意力卷积神经网 每个词的局部特征X分配权重: 络获取到每个句子的特征表示,经过双向GRU进 a={a1,a2,·,an} (4) 一步编码提取每个句子的信息,将双向GRU的输 式中n表示文章中句子的长度。用a表示句子中 出作为全局注意力层的输入,得到每个句子对篇 词或短语的重要程度值,将词特征与权重相乘, 章表示的贡献,排除掉无用的句子并获取到篇章 更新每个词的特征表示,得到X: 的整体语义信息。具体计算如下: x=aiXi u:tanh (W hi+ba) (9) xERd (5) exp(u;) Xm=,…,,…, 0:= (10) 卷积层传统的情感分析处理自然语言的方 ∑exp(u) 法一般采用1-gram、2-gram和n-gram语言模型提 v=∑ah (11) 取文本的情感特征。Pang等W曾使用该方法进行 情感分析,并取得良好的实验效果。卷积神经网 其中双向GRU的输出经过一个多层感知机,使用 络模型根据上下文大小提取局部特征值,卷积核 tanh非线性激活函数,得到每个编码句子的权重 参数可∈Rd都将以X为中心,在每一次的卷积 值,归一化softmax函数将权重分布在[0,1]之间; 操作中,提取卷积上下文窗口大小作为D的局部 将句子编码为向量h:并与对应权重a:相乘求和 特征,并将其视为n-grams特征提取。 最终得到特征表示v。 本文中,取卷积核大小为3,则文本中心词对 2.3篇章分类 应的上下范围为1,并遵循马尔可夫原则,即卷积 篇章特征向量由提取词和句子特征后得到。 核大小变为5时,中心词对应上下文范围扩大为2。 向量首先通过多层感知机映射到情感类别空间 当卷积核大小取3时,其上下文大小为1,进行卷 C,再使用softmax函数得到情感类别分布Pc。 Pc softmax(Wv+b) (12) 积操作时,无法取到第一个词的上文以及最后一 式中Pc代表篇章在类别C上的预测概率。 个词的下文表示。即首尾两个词导致有h/2创个 实验中将预测的类别分布同真实分布进行对 词无法提取到对应的n-grams特征,将产生文本 比,训练过程中使用交叉熵作为模型的损失函 信息提取不足的问题。为解决此问题,本文采取 数。以P作为真实类别整体概率分布,Pc(d是篇 首尾填充操作,即在卷积层的输入末尾进行大小 为h-1的0向量补全。 章的预测概率分布,损失函数为 X=X⊕…⊕o⊕0 (6) loss = ∑∑P(dn(Pc(d) (13) h-1 式中⊕表示串联操作。 式中D表示训练的样本集。pi D xi αi 其中, 表示该中心词, 表示选取的上下文的 长度。如图 2所示,由此计算每个词表示 的特 征值权重 ,可以帮助文本中情感分析的重要程 度值更加明显。 Watt∈RL×d X={x1 , x2 , …, xn} * D α 图 2 词注意力层 Fig. 2 Local attention X att i = {xi−D,··· , xi ,··· , xi+D} (2) αi = h ( X att i Watt +batt) (3) X att i xi L h(·) batt X 式中: 表示以 为中心,将上下文的大小设置 为 ; 代表 sigmoid 激活函数;用 代表偏置 项。如图 2 所示,在词注意力层中运用滑动窗口 机制,进一步探索词嵌入 的深层特征值,并为 每个词的局部特征 X 分配权重 α: α = {α1,α2,··· ,αn} (4) n Xatt 式中 表示文章中句子的长度。用 α 表示句子中 词或短语的重要程度值,将词特征与权重相乘, 更新每个词的特征表示,得到 : x att i = αixi x att i ∈ R d Xatt = {x att 1 , x att 2 ··· , x att i , x att i+1 ··· , x att n } (5) ϖ ∈ R h×d Xi D 卷积层 传统的情感分析处理自然语言的方 法一般采用 1-gram、2-gram 和 n-gram 语言模型提 取文本的情感特征。Pang 等 [1] 曾使用该方法进行 情感分析,并取得良好的实验效果。卷积神经网 络模型根据上下文大小提取局部特征值,卷积核 参数 都将以 为中心,在每一次的卷积 操作中,提取卷积上下文窗口大小作为 的局部 特征,并将其视为 n-grams特征提取。 ⌊h/2⌋ h−1 本文中,取卷积核大小为 3,则文本中心词对 应的上下范围为 1,并遵循马尔可夫原则,即卷积 核大小变为 5 时,中心词对应上下文范围扩大为 2。 当卷积核大小取 3 时,其上下文大小为 1,进行卷 积操作时,无法取到第一个词的上文以及最后一 个词的下文表示。即首尾两个词导致有 个 词无法提取到对应的 n-grams 特征,将产生文本 信息提取不足的问题。为解决此问题,本文采取 首尾填充操作,即在卷积层的输入末尾进行大小 为 的 0 向量补全。 X = Xatt ⊕··· ⊕ x0 ⊕ x0 | {z } h−1 (6) 式中 ⊕ 表示串联操作。 Xatt si 卷积层的作用在于提取每个词特征信息和词 的上下文信息。在词注意力之后得到的文本特征 信息 作为卷积的输入。同时在卷积层中运用 多个不同大小的卷积核进行提取文本特征,每个 卷积核取一定的数量。不同之处在于,增加了大 小为 1 的卷积核,用于对每个词进行特征提取。 将卷积层输出的特征图作为最大池化层的输入, 得到篇章的特征表示 : si = CNN(Xatt) (7) 式中 i 代表篇章中的第几个句子。 2.2 篇章特征提取 si 篇章分析 假设输入句子层次词注意卷积神 经网络获取到句子向量 ,将向量作为双向 GRU 神经网络的输入,双向 GRU 的输出串联作为特征 表示: hi = [ −→hi , ←−hi ] = Bi−GRU(si) (8) 篇章全局注意力 通过词注意力卷积神经网 络获取到每个句子的特征表示,经过双向 GRU 进 一步编码提取每个句子的信息,将双向 GRU 的输 出作为全局注意力层的输入,得到每个句子对篇 章表示的贡献,排除掉无用的句子并获取到篇章 的整体语义信息。具体计算如下: ui = tanh( Wghi +bg ) (9) αi = ∑ exp(ui) i exp(ui) (10) v = ∑ i αihi (11) tanh softmax hi αi v 其中双向 GRU 的输出经过一个多层感知机,使用 非线性激活函数,得到每个编码句子的权重 值,归一化 函数将权重分布在 [0,1] 之间; 将句子编码为向量 并与对应权重 相乘求和 最终得到特征表示 。 2.3 篇章分类 v C softmax PC 篇章特征向量由提取词和句子特征后得到。 向量 首先通过多层感知机映射到情感类别空间 ,再使用 函数得到情感类别分布 。 PC = softmax(Wcv+bc) (12) 式中 PC 代表篇章在类别 C 上的预测概率。 P g C PC (d) 实验中将预测的类别分布同真实分布进行对 比,训练过程中使用交叉熵作为模型的损失函 数。以 作为真实类别整体概率分布, 是篇 章的预测概率分布,损失函数为 loss = − ∑ d∈D ∑C c=1 P g C (d)ln(PC (d)) (13) 式中 D 表示训练的样本集。 第 3 期 曾碧卿,等:层次化双注意力神经网络模型的情感分析研究 ·463·