正在加载图片...

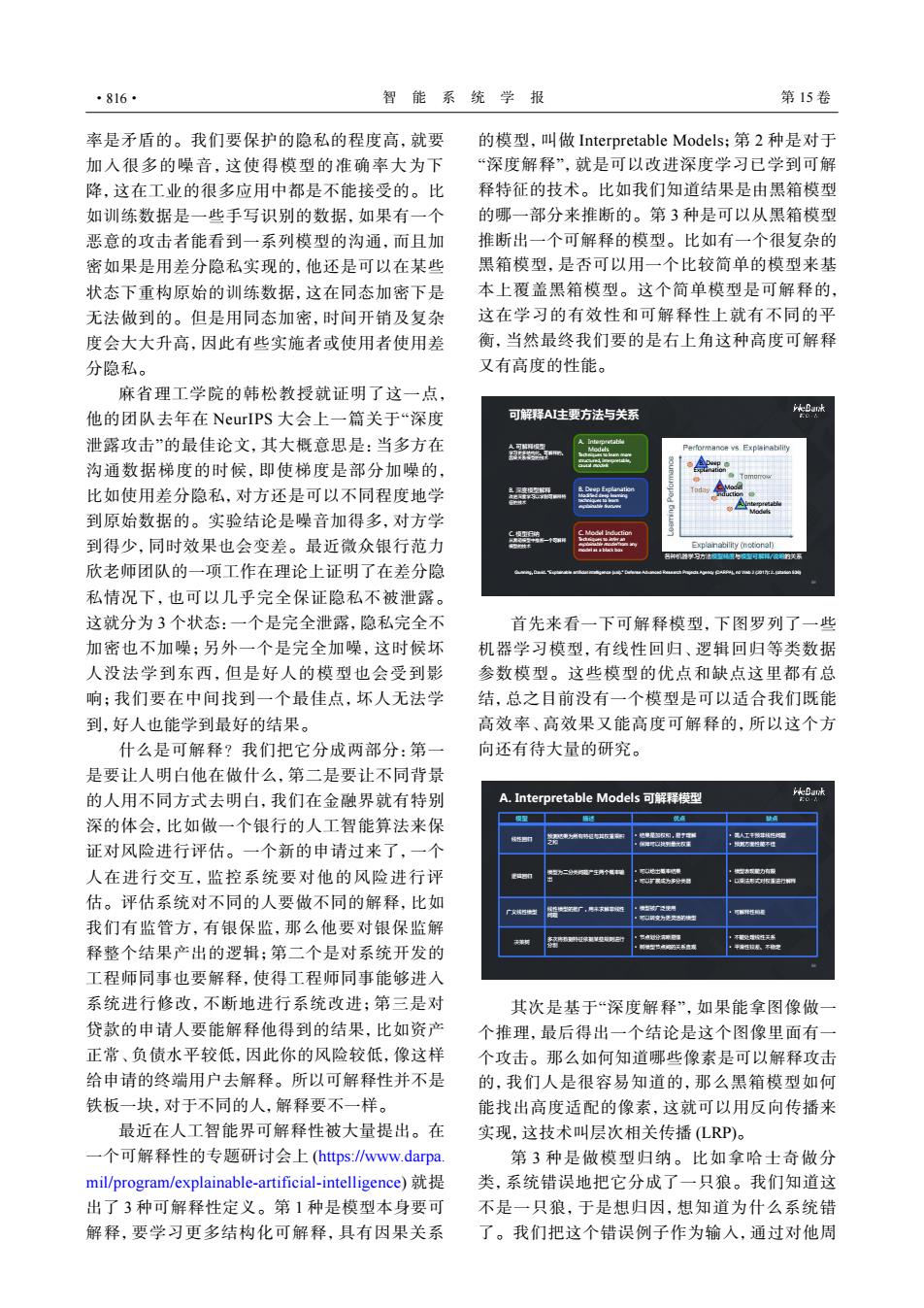

·816· 智能系统学报 第15卷 率是矛盾的。我们要保护的隐私的程度高,就要 的模型,叫做Interpretable Models;第2种是对于 加入很多的噪音,这使得模型的准确率大为下 “深度解释”,就是可以改进深度学习已学到可解 降,这在工业的很多应用中都是不能接受的。比 释特征的技术。比如我们知道结果是由黑箱模型 如训练数据是一些手写识别的数据,如果有一个 的哪一部分来推断的。第3种是可以从黑箱模型 恶意的攻击者能看到一系列模型的沟通,而且加 推断出一个可解释的模型。比如有一个很复杂的 密如果是用差分隐私实现的,他还是可以在某些 黑箱模型,是否可以用一个比较简单的模型来基 状态下重构原始的训练数据,这在同态加密下是 本上覆盖黑箱模型。这个简单模型是可解释的, 无法做到的。但是用同态加密,时间开销及复杂 这在学习的有效性和可解释性上就有不同的平 度会大大升高,因此有些实施者或使用者使用差 衡,当然最终我们要的是右上角这种高度可解释 分隐私。 又有高度的性能。 麻省理工学院的韩松教授就证明了这一点, 他的团队去年在NeurIPS大会上一篇关于“深度 可解释AI主要方法与关系 泄露攻击”的最佳论文,其大概意思是:当多方在 Performance vs Explainability 沟通数据梯度的时候,即使梯度是部分加噪的, 比如使用差分隐私,对方还是可以不同程度地学 到原始数据的。实验结论是噪音加得多,对方学 到得少,同时效果也会变差。最近微众银行范力 Explanability(notionaly 们盟学习方之型里与可厘/使方关界 欣老师团队的一项工作在理论上证明了在差分隐 私情况下,也可以几乎完全保证隐私不被泄露。 这就分为3个状态:一个是完全泄露,隐私完全不 首先来看一下可解释模型,下图罗列了一些 加密也不加噪;另外一个是完全加噪,这时候坏 机器学习模型,有线性回归、逻辑回归等类数据 人没法学到东西,但是好人的模型也会受到影 参数模型。这些模型的优点和缺点这里都有总 响;我们要在中间找到一个最佳点,坏人无法学 结,总之目前没有一个模型是可以适合我们既能 到,好人也能学到最好的结果。 高效率、高效果又能高度可解释的,所以这个方 什么是可解释?我们把它分成两部分:第一 向还有待大量的研究。 是要让人明白他在做什么,第二是要让不同背景 的人用不同方式去明白,我们在金融界就有特别 A.Interpretable Models可解释模型 HeBank 深的体会,比如做一个银行的人工智能算法来保 证对风险进行评估。一个新的申请过来了,一个 人在进行交互,监控系统要对他的风险进行评 个 估。评估系统对不同的人要做不同的解释,比如 我们有监管方,有银保监,那么他要对银保监解 释整个结果产出的逻辑;第二个是对系统开发的 工程师同事也要解释,使得工程师同事能够进人 系统进行修改,不断地进行系统改进;第三是对 其次是基于“深度解释”,如果能拿图像做一 贷款的申请人要能解释他得到的结果,比如资产 个推理,最后得出一个结论是这个图像里面有一 正常、负债水平较低,因此你的风险较低,像这样 个攻击。那么如何知道哪些像素是可以解释攻击 给申请的终端用户去解释。所以可解释性并不是 的,我们人是很容易知道的,那么黑箱模型如何 铁板一块,对于不同的人,解释要不一样。 能找出高度适配的像素,这就可以用反向传播来 最近在人工智能界可解释性被大量提出。在 实现,这技术叫层次相关传播(LRP)。 一个可解释性的专题研讨会上(htps:www.darpa. 第3种是做模型归纳。比如拿哈士奇做分 mil/program/explainable-artificial-intelligence) 类,系统错误地把它分成了一只狼。我们知道这 出了3种可解释性定义。第1种是模型本身要可 不是一只狼,于是想归因,想知道为什么系统错 解释,要学习更多结构化可解释,具有因果关系 了。我们把这个错误例子作为输入,通过对他周率是矛盾的。我们要保护的隐私的程度高,就要 加入很多的噪音,这使得模型的准确率大为下 降,这在工业的很多应用中都是不能接受的。比 如训练数据是一些手写识别的数据,如果有一个 恶意的攻击者能看到一系列模型的沟通,而且加 密如果是用差分隐私实现的,他还是可以在某些 状态下重构原始的训练数据,这在同态加密下是 无法做到的。但是用同态加密,时间开销及复杂 度会大大升高,因此有些实施者或使用者使用差 分隐私。 麻省理工学院的韩松教授就证明了这一点, 他的团队去年在 NeurIPS 大会上一篇关于“深度 泄露攻击”的最佳论文,其大概意思是:当多方在 沟通数据梯度的时候,即使梯度是部分加噪的, 比如使用差分隐私,对方还是可以不同程度地学 到原始数据的。实验结论是噪音加得多,对方学 到得少,同时效果也会变差。最近微众银行范力 欣老师团队的一项工作在理论上证明了在差分隐 私情况下,也可以几乎完全保证隐私不被泄露。 这就分为 3 个状态:一个是完全泄露,隐私完全不 加密也不加噪;另外一个是完全加噪,这时候坏 人没法学到东西,但是好人的模型也会受到影 响;我们要在中间找到一个最佳点,坏人无法学 到,好人也能学到最好的结果。 什么是可解释?我们把它分成两部分:第一 是要让人明白他在做什么,第二是要让不同背景 的人用不同方式去明白,我们在金融界就有特别 深的体会,比如做一个银行的人工智能算法来保 证对风险进行评估。一个新的申请过来了,一个 人在进行交互,监控系统要对他的风险进行评 估。评估系统对不同的人要做不同的解释,比如 我们有监管方,有银保监,那么他要对银保监解 释整个结果产出的逻辑;第二个是对系统开发的 工程师同事也要解释,使得工程师同事能够进入 系统进行修改,不断地进行系统改进;第三是对 贷款的申请人要能解释他得到的结果,比如资产 正常、负债水平较低,因此你的风险较低,像这样 给申请的终端用户去解释。所以可解释性并不是 铁板一块,对于不同的人,解释要不一样。 最近在人工智能界可解释性被大量提出。在 一个可解释性的专题研讨会上 (https://www.darpa. mil/program/explainable-artificial-intelligence) 就提 出了 3 种可解释性定义。第 1 种是模型本身要可 解释,要学习更多结构化可解释,具有因果关系 的模型,叫做 Interpretable Models;第 2 种是对于 “深度解释”,就是可以改进深度学习已学到可解 释特征的技术。比如我们知道结果是由黑箱模型 的哪一部分来推断的。第 3 种是可以从黑箱模型 推断出一个可解释的模型。比如有一个很复杂的 黑箱模型,是否可以用一个比较简单的模型来基 本上覆盖黑箱模型。这个简单模型是可解释的, 这在学习的有效性和可解释性上就有不同的平 衡,当然最终我们要的是右上角这种高度可解释 又有高度的性能。 56 可解释AI主要方法与关系 C. Model Induction Techniques to infer an explainable model from any model as a black box B. Deep Explanation Modified deep learning techniques to learn explainable features A. Interpretable Models Techniques to learn more structured, interpretable, causal models Gunning, David. "Explainable artificial intelligence (xai)." Defense Advanced Research Projects Agency (DARPA), nd Web 2 (2017): 2. (citation 536) 各种机器学习方法模型精度与模型可解释/说明的关系 B. Deep Explanation C. Model Induction A. Interpretable Models A. 可解释模型 学习更多结构化、可解释的、 因果关系模型的技术 B. 深度模型解释 改进深度学习以学到可解释特 征的技术 C. 模型归纳 从黑箱模型中推断一个可解释 模型的技术 首先来看一下可解释模型,下图罗列了一些 机器学习模型,有线性回归、逻辑回归等类数据 参数模型。这些模型的优点和缺点这里都有总 结,总之目前没有一个模型是可以适合我们既能 高效率、高效果又能高度可解释的,所以这个方 向还有待大量的研究。 58 A. Interpretable Models 可解释模型 模型 描述 优点 缺点 线性回归 预测结果为所有特征与其权重乘积 之和 • 结果是加权和,易于理解 • 保障可以找到最优权重 • 需人工干预非线性问题 • 预测方面性能不佳 逻辑回归 模型为二分类问题产生两个概率输 出 • 可以给出概率结果 • 可以扩展成为多分类器 • 模型表现能力有限 • 以乘法形式对权重进行解释 广义线性模型 线性模型的推广,用来求解非线性 问题 • 模型被广泛使用 • 可以转变为更灵活的模型 • 可解释性稍差 决策树 多次将数据特征依据某些规则进行 分割 • 节点划分清晰易懂 • 树模型节点间的关系直观 • 不能处理线性关系 • 平滑性较差、不稳定 其次是基于“深度解释”,如果能拿图像做一 个推理,最后得出一个结论是这个图像里面有一 个攻击。那么如何知道哪些像素是可以解释攻击 的,我们人是很容易知道的,那么黑箱模型如何 能找出高度适配的像素,这就可以用反向传播来 实现,这技术叫层次相关传播 (LRP)。 第 3 种是做模型归纳。比如拿哈士奇做分 类,系统错误地把它分成了一只狼。我们知道这 不是一只狼,于是想归因,想知道为什么系统错 了。我们把这个错误例子作为输入,通过对他周 ·816· 智 能 系 统 学 报 第 15 卷