正在加载图片...

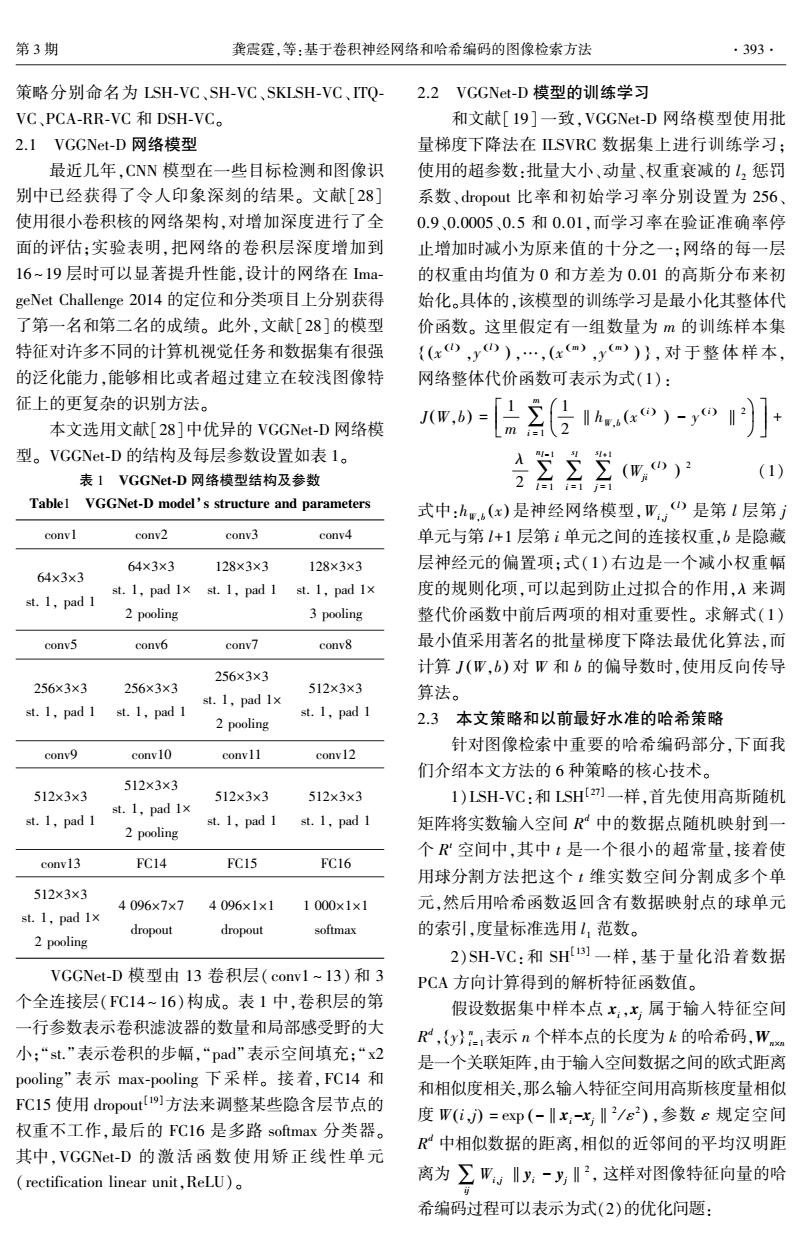

第3期 龚震霆,等:基于卷积神经网络和哈希编码的图像检索方法 ·393. 策略分别命名为LSH-VC、SH-VC、SKLSH-VC、TQ- 2.2 VGGNet-D模型的训练学习 VC、PCA-RR-VC和DSH-VC。 和文献[I9]一致,VGGNet-D网络模型使用批 2.1 VGGNet-D网络模型 量梯度下降法在ILSVRC数据集上进行训练学习: 最近几年,CNN模型在一些目标检测和图像识 使用的超参数:批量大小、动量、权重衰减的L,惩罚 别中已经获得了令人印象深刻的结果。文献[28] 系数、dropout比率和初始学习率分别设置为256 使用很小卷积核的网络架构,对增加深度进行了全 0.9、0.0005、0.5和0.01,而学习率在验证准确率停 面的评估:实验表明,把网络的卷积层深度增加到 止增加时减小为原来值的十分之一:网络的每一层 16~19层时可以显著提升性能,设计的网络在ma- 的权重由均值为0和方差为0.01的高斯分布来初 geNet Challenge2014的定位和分类项目上分别获得 始化。具体的,该模型的训练学习是最小化其整体代 了第一名和第二名的成绩。此外,文献[28]的模型 价函数。这里假定有一组数量为m的训练样本集 特征对许多不同的计算机视觉任务和数据集有很强 {(x0,y0),…,(x),y))},对于整体样本, 的泛化能力,能够相比或者超过建立在较浅图像特 网络整体代价函数可表示为式(1): 征上的更复杂的识别方法。 (W,b) 本文选用文献[28]中优异的VGGNet-D网络模 [2w)-o] 型。VGGNet-D的结构及每层参数设置如表l。 表1 VGGNet--D网络模型结构及参数 (1) Tablel VGGNet-D model's structure and parameters 式中:h6(x)是神经网络模型,WD是第1层第j conv1 conv2 conv3 conv4 单元与第l+1层第i单元之间的连接权重,b是隐藏 64×3×3 128×3×3 128×3×3 层神经元的偏置项:式(1)右边是一个减小权重幅 64×3×3 st.1,pad1×st.1,pad1 st.1,pad1× 度的规则化项,可以起到防止过拟合的作用,入来调 st.1,pad I 2 pooling 3 pooling 整代价函数中前后两项的相对重要性。求解式(1) conv5 conv6 conv7 conv8 最小值采用著名的批量梯度下降法最优化算法,而 计算J(W,b)对W和b的偏导数时,使用反向传导 256×3×3 256×3×3 256×3×3 512×3×3 算法。 st.1,pad 1 st.1,pad 1 st.1,padl× st.1,pad I 2 pooling 2.3本文策略和以前最好水准的哈希策略 针对图像检索中重要的哈希编码部分,下面我 conv9 conv10 convll conv12 们介绍本文方法的6种策略的核心技术。 512×3×3 512×3×3 512×3×3 512×3×3 1)LSH-VC:和LSH)一样,首先使用高斯随机 st.1,pad 1x st.1,pad 1 st.1,pad 1 st.1,pad 1 矩阵将实数输入空间R中的数据点随机映射到一 2 pooling 个R空间中,其中t是一个很小的超常量,接着使 conv13 FC14 FC15 FC16 用球分割方法把这个t维实数空间分割成多个单 512×3×3 4096×7×7 4096×1×1 1000×1×1 元,然后用哈希函数返回含有数据映射点的球单元 st.1,pad1× dropout dropout softmax 的索引,度量标准选用,范数。 2 pooling 2)SH-VC:和SH)一样,基于量化沿着数据 VGGNet-D模型由13卷积层(convI~13)和3 PCA方向计算得到的解析特征函数值。 个全连接层(FC14~16)构成。表1中,卷积层的第 假设数据集中样本点x:,x属于输人特征空间 一行参数表示卷积滤波器的数量和局部感受野的大 R,{y表示n个样本点的长度为k的哈希码,W 小;“st”表示卷积的步幅,“pad”表示空间填充:“x2 是一个关联矩阵,由于输入空间数据之间的欧式距离 pooling”表示max-pooling下采样。接着,FCl4和 和相似度相关,那么输入特征空间用高斯核度量相似 FCl5使用dropout!19]方法来调整某些隐含层节点的 度W(i)=exp(-lx,-x,2/e2),参数e规定空间 权重不工作,最后的FCl6是多路softmax分类器。 R中相似数据的距离,相似的近邻间的平均汉明距 其中,VGGNet--D的激活函数使用矫正线性单元 rectification linear unit,ReLU) 离为∑。y:-y己,这样对图像特征向量的哈 希编码过程可以表示为式(2)的优化问题:策略分别命名为 LSH⁃VC、SH⁃VC、SKLSH⁃VC、ITQ⁃ VC、PCA⁃RR⁃VC 和 DSH⁃VC。 2.1 VGGNet⁃D 网络模型 最近几年,CNN 模型在一些目标检测和图像识 别中已经获得了令人印象深刻的结果。 文献[28] 使用很小卷积核的网络架构,对增加深度进行了全 面的评估;实验表明,把网络的卷积层深度增加到 16~19 层时可以显著提升性能,设计的网络在 Ima⁃ geNet Challenge 2014 的定位和分类项目上分别获得 了第一名和第二名的成绩。 此外,文献[28]的模型 特征对许多不同的计算机视觉任务和数据集有很强 的泛化能力,能够相比或者超过建立在较浅图像特 征上的更复杂的识别方法。 本文选用文献[28]中优异的 VGGNet⁃D 网络模 型。 VGGNet⁃D 的结构及每层参数设置如表 1。 表 1 VGGNet⁃D 网络模型结构及参数 Table1 VGGNet⁃D model’s structure and parameters conv1 conv2 conv3 conv4 64×3×3 st. 1, pad 1 64×3×3 st. 1, pad 1× 2 pooling 128×3×3 st. 1, pad 1 128×3×3 st. 1, pad 1× 3 pooling conv5 conv6 conv7 conv8 256×3×3 st. 1, pad 1 256×3×3 st. 1, pad 1 256×3×3 st. 1, pad 1× 2 pooling 512×3×3 st. 1, pad 1 conv9 conv10 conv11 conv12 512×3×3 st. 1, pad 1 512×3×3 st. 1, pad 1× 2 pooling 512×3×3 st. 1, pad 1 512×3×3 st. 1, pad 1 conv13 FC14 FC15 FC16 512×3×3 st. 1, pad 1× 2 pooling 4 096×7×7 dropout 4 096×1×1 dropout 1 000×1×1 softmax VGGNet⁃D 模型由 13 卷积层( conv1 ~ 13) 和 3 个全连接层(FC14 ~ 16)构成。 表 1 中,卷积层的第 一行参数表示卷积滤波器的数量和局部感受野的大 小;“st.”表示卷积的步幅,“pad”表示空间填充;“x2 pooling” 表示 max⁃pooling 下采样。 接着, FC14 和 FC15 使用 dropout [19]方法来调整某些隐含层节点的 权重不工作,最后的 FC16 是多路 softmax 分类器。 其中,VGGNet⁃D 的激活函数使用矫正线性单元 (rectification linear unit,ReLU)。 2.2 VGGNet⁃D 模型的训练学习 和文献[19] 一致,VGGNet⁃D 网络模型使用批 量梯度下降法在 ILSVRC 数据集上进行训练学习; 使用的超参数:批量大小、动量、权重衰减的 l 2 惩罚 系数、dropout 比率和初始学习率分别设置为 256、 0.9、0.0005、0.5 和 0.01,而学习率在验证准确率停 止增加时减小为原来值的十分之一;网络的每一层 的权重由均值为 0 和方差为 0.01 的高斯分布来初 始化。具体的,该模型的训练学习是最小化其整体代 价函数。 这里假定有一组数量为 m 的训练样本集 x (l) ,y (l) ( ) ,…, x (m ) ,y (m ) { ( ) } ,对 于 整 体 样 本, 网络整体代价函数可表示为式(1): J (W,b) = 1 m ∑ m i = 1 1 2 ‖hW,b x (i) ( ) - y æ (i) ‖2 è ç ö ø ÷ é ë ê ê ù û ú ú + λ 2 ∑ nl-1 l = 1 ∑ s l i = 1 ∑ s l+1 j = 1 Wji (l) ( ) 2 (1) 式中:hW,b (x) 是神经网络模型,Wi,j (l) 是第 l 层第 j 单元与第 l+1 层第 i 单元之间的连接权重,b 是隐藏 层神经元的偏置项;式(1)右边是一个减小权重幅 度的规则化项,可以起到防止过拟合的作用,λ 来调 整代价函数中前后两项的相对重要性。 求解式(1) 最小值采用著名的批量梯度下降法最优化算法,而 计算 J (W,b) 对 W 和 b 的偏导数时,使用反向传导 算法。 2.3 本文策略和以前最好水准的哈希策略 针对图像检索中重要的哈希编码部分,下面我 们介绍本文方法的 6 种策略的核心技术。 1)LSH⁃VC:和 LSH [27]一样,首先使用高斯随机 矩阵将实数输入空间 R d 中的数据点随机映射到一 个 R t 空间中,其中 t 是一个很小的超常量,接着使 用球分割方法把这个 t 维实数空间分割成多个单 元,然后用哈希函数返回含有数据映射点的球单元 的索引,度量标准选用 l 1 范数。 2)SH⁃VC:和 SH [13] 一样,基于量化沿着数据 PCA 方向计算得到的解析特征函数值。 假设数据集中样本点 xi,xj 属于输入特征空间 R d ,{y} n i = 1表示 n 个样本点的长度为 k 的哈希码,Wn×n 是一个关联矩阵,由于输入空间数据之间的欧式距离 和相似度相关,那么输入特征空间用高斯核度量相似 度 W(i,j) = exp -‖xi -xj‖2 / ε 2 ( ) ,参数 ε 规定空间 R d 中相似数据的距离,相似的近邻间的平均汉明距 离为 ∑ij Wi,j ‖yi - yj‖2 , 这样对图像特征向量的哈 希编码过程可以表示为式(2)的优化问题: 第 3 期 龚震霆,等:基于卷积神经网络和哈希编码的图像检索方法 ·393·