正在加载图片...

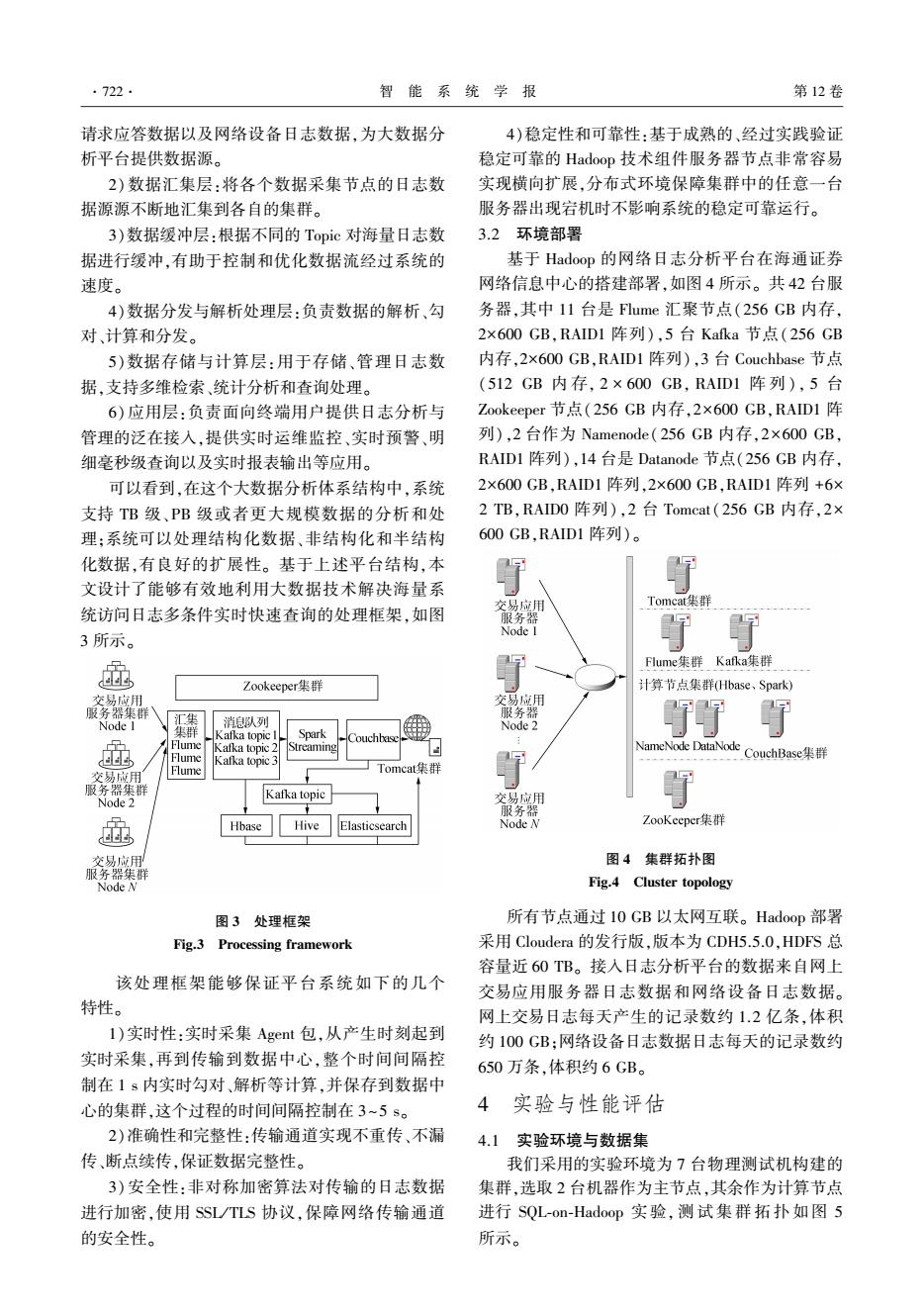

·722. 智能系统学报 第12卷 请求应答数据以及网络设备日志数据,为大数据分 4)稳定性和可靠性:基于成熟的、经过实践验证 析平台提供数据源。 稳定可靠的Hadoop技术组件服务器节点非常容易 2)数据汇集层:将各个数据采集节点的日志数 实现横向扩展,分布式环境保障集群中的任意一台 据源源不断地汇集到各自的集群。 服务器出现宕机时不影响系统的稳定可靠运行。 3)数据缓冲层:根据不同的Topic对海量日志数 3.2环境部署 据进行缓冲,有助于控制和优化数据流经过系统的 基于Hadoop的网络日志分析平台在海通证券 速度。 网络信息中心的搭建部署,如图4所示。共42台服 4)数据分发与解析处理层:负责数据的解析、勾 务器,其中11台是Flume汇聚节点(256GB内存, 对、计算和分发。 2×600GB,RAID1阵列),5台Kafka节点(256GB 5)数据存储与计算层:用于存储、管理日志数 内存,2×6O0GB,RAID1阵列),3台Couchbase节点 据,支持多维检索、统计分析和查询处理。 (512GB内存,2×600GB,RAID1阵列),5台 6)应用层:负责面向终端用户提供日志分析与 Zookeeper节点(256GB内存,2×600GB,RAD1阵 管理的泛在接入,提供实时运维监控、实时预警、明 列),2台作为Namenode(256GB内存,2×600GB, 细毫秒级查询以及实时报表输出等应用。 RAID1阵列),14台是Datanode节点(256GB内存, 可以看到,在这个大数据分析体系结构中,系统 2×600GB,RAID1阵列,2×600GB,RAID1阵列+6× 支持TB级、PB级或者更大规模数据的分析和处 2TB,RAID0阵列),2台Tomeat(256GB内存,2× 理:系统可以处理结构化数据、非结构化和半结构 600GB,RAID1阵列)。 化数据,有良好的扩展性。基于上述平台结构,本 文设计了能够有效地利用大数据技术解决海量系 统访问日志多条件实时快速查询的处理框架,如图 交易应用 Tomeat集群 服务器 3所示。 Node I 了 通 Fume集群Kafka集群 Zookeeper集群 计算节点集群Hbase、Spark) 交易应用 交易应用 服务器集群 服务器 Node I 汇 消息队列 集群 Node 2 Kafka topic Spark Flume Kafka topic 2 Streaming NameNode DataNode Flume CouchBase集群 Kafka topic 3 交易应用 Flume 丁Tomcat集群 服务器集群 Kafka topic Node 2 交易应用 服务器 Hbase Hive Elasticsearch Node n ZooKeeper集群 交易应用 图4集群拓扑图 服务器集群 Node N Fig.4 Cluster topology 图3处理框架 所有节点通过I0GB以太网互联。Hadoop部署 Fig.3 Processing framework 采用Cloudera的发行版,版本为CDH5.5.0,HDFS总 容量近60TB。接入日志分析平台的数据来自网上 该处理框架能够保证平台系统如下的几个 交易应用服务器日志数据和网络设备日志数据。 特性。 网上交易日志每天产生的记录数约1.2亿条,体积 1)实时性:实时采集Agent包,从产生时刻起到 约100GB:网络设备日志数据日志每天的记录数约 实时采集,再到传输到数据中心,整个时间间隔控 650万条,体积约6GB。 制在1s内实时勾对、解析等计算,并保存到数据中 心的集群,这个过程的时间间隔控制在3~5s。 4实验与性能评估 2)准确性和完整性:传输通道实现不重传、不漏 4.1实验环境与数据集 传、断点续传,保证数据完整性。 我们采用的实验环境为7台物理测试机构建的 3)安全性:非对称加密算法对传输的日志数据 集群,选取2台机器作为主节点,其余作为计算节点 进行加密,使用SSL/TLS协议,保障网络传输通道 进行SQL-on-Hadoop实验,测试集群拓扑如图5 的安全性。 所示。请求应答数据以及网络设备日志数据,为大数据分 析平台提供数据源。 2)数据汇集层:将各个数据采集节点的日志数 据源源不断地汇集到各自的集群。 3)数据缓冲层:根据不同的 Topic 对海量日志数 据进行缓冲,有助于控制和优化数据流经过系统的 速度。 4)数据分发与解析处理层:负责数据的解析、勾 对、计算和分发。 5)数据存储与计算层:用于存储、管理日志数 据,支持多维检索、统计分析和查询处理。 6)应用层:负责面向终端用户提供日志分析与 管理的泛在接入,提供实时运维监控、实时预警、明 细毫秒级查询以及实时报表输出等应用。 可以看到,在这个大数据分析体系结构中,系统 支持 TB 级、PB 级或者更大规模数据的分析和处 理;系统可以处理结构化数据、非结构化和半结构 化数据,有良好的扩展性。 基于上述平台结构,本 文设计了能够有效地利用大数据技术解决海量系 统访问日志多条件实时快速查询的处理框架,如图 3 所示。 图 3 处理框架 Fig.3 Processing framework 该处理框架能够保证平台系统如下的几个 特性。 1)实时性:实时采集 Agent 包,从产生时刻起到 实时采集,再到传输到数据中心,整个时间间隔控 制在 1 s 内实时勾对、解析等计算,并保存到数据中 心的集群,这个过程的时间间隔控制在 3~5 s。 2)准确性和完整性:传输通道实现不重传、不漏 传、断点续传,保证数据完整性。 3)安全性:非对称加密算法对传输的日志数据 进行加密,使用 SSL / TLS 协议,保障网络传输通道 的安全性。 4)稳定性和可靠性:基于成熟的、经过实践验证 稳定可靠的 Hadoop 技术组件服务器节点非常容易 实现横向扩展,分布式环境保障集群中的任意一台 服务器出现宕机时不影响系统的稳定可靠运行。 3.2 环境部署 基于 Hadoop 的网络日志分析平台在海通证券 网络信息中心的搭建部署,如图 4 所示。 共 42 台服 务器,其中 11 台是 Flume 汇聚节点(256 GB 内存, 2×600 GB,RAID1 阵列),5 台 Kafka 节点(256 GB 内存,2×600 GB,RAID1 阵列),3 台 Couchbase 节点 (512 GB 内 存, 2 × 600 GB, RAID1 阵 列), 5 台 Zookeeper 节点(256 GB 内存,2×600 GB,RAID1 阵 列),2 台作为 Namenode(256 GB 内存,2×600 GB, RAID1 阵列),14 台是 Datanode 节点(256 GB 内存, 2×600 GB,RAID1 阵列,2×600 GB,RAID1 阵列 +6× 2 TB,RAID0 阵列),2 台 Tomcat(256 GB 内存,2× 600 GB,RAID1 阵列)。 图 4 集群拓扑图 Fig.4 Cluster topology 所有节点通过 10 GB 以太网互联。 Hadoop 部署 采用 Cloudera 的发行版,版本为 CDH5.5.0,HDFS 总 容量近 60 TB。 接入日志分析平台的数据来自网上 交易应用服务器日志数据和网络设备日志数据。 网上交易日志每天产生的记录数约 1.2 亿条,体积 约 100 GB;网络设备日志数据日志每天的记录数约 650 万条,体积约 6 GB。 4 实验与性能评估 4.1 实验环境与数据集 我们采用的实验环境为 7 台物理测试机构建的 集群,选取 2 台机器作为主节点,其余作为计算节点 进行 SQL⁃on⁃Hadoop 实 验, 测 试 集 群 拓 扑 如 图 5 所示。 ·722· 智 能 系 统 学 报 第 12 卷