正在加载图片...

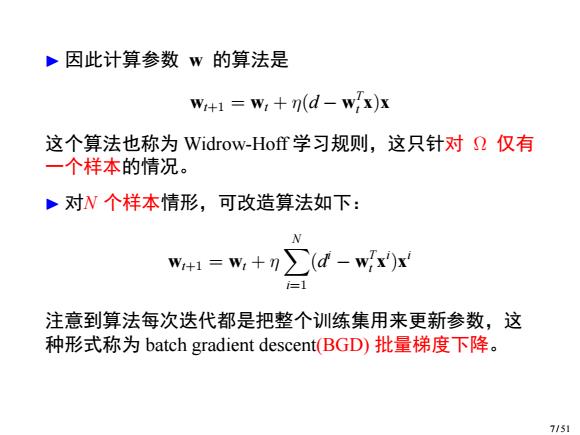

·因此计算参数w的算法是 W+1=W:+n(d-w.x)x 这个算法也称为Widrow-Hoff学习规则,这只针对仅有 一个样本的情况。 ·对N个样本情形,可改造算法如下: w+1=w+n∑d-wx)x =1 注意到算法每次迭代都是把整个训练集用来更新参数,这 种形式称为batch gradient descent(BGD)批量梯度下降。 7/51▶ 因此计算参数 w 的算法是 wt+1 = wt + η(d − w T t x)x 这个算法也称为 Widrow-Hoff 学习规则,这只针对 Ω 仅有 一个样本的情况。 ▶ 对N 个样本情形,可改造算法如下: wt+1 = wt + η X N i=1 (d i − w T t x i )x i 注意到算法每次迭代都是把整个训练集用来更新参数,这 种形式称为 batch gradient descent(BGD) 批量梯度下降。 7 / 51