正在加载图片...

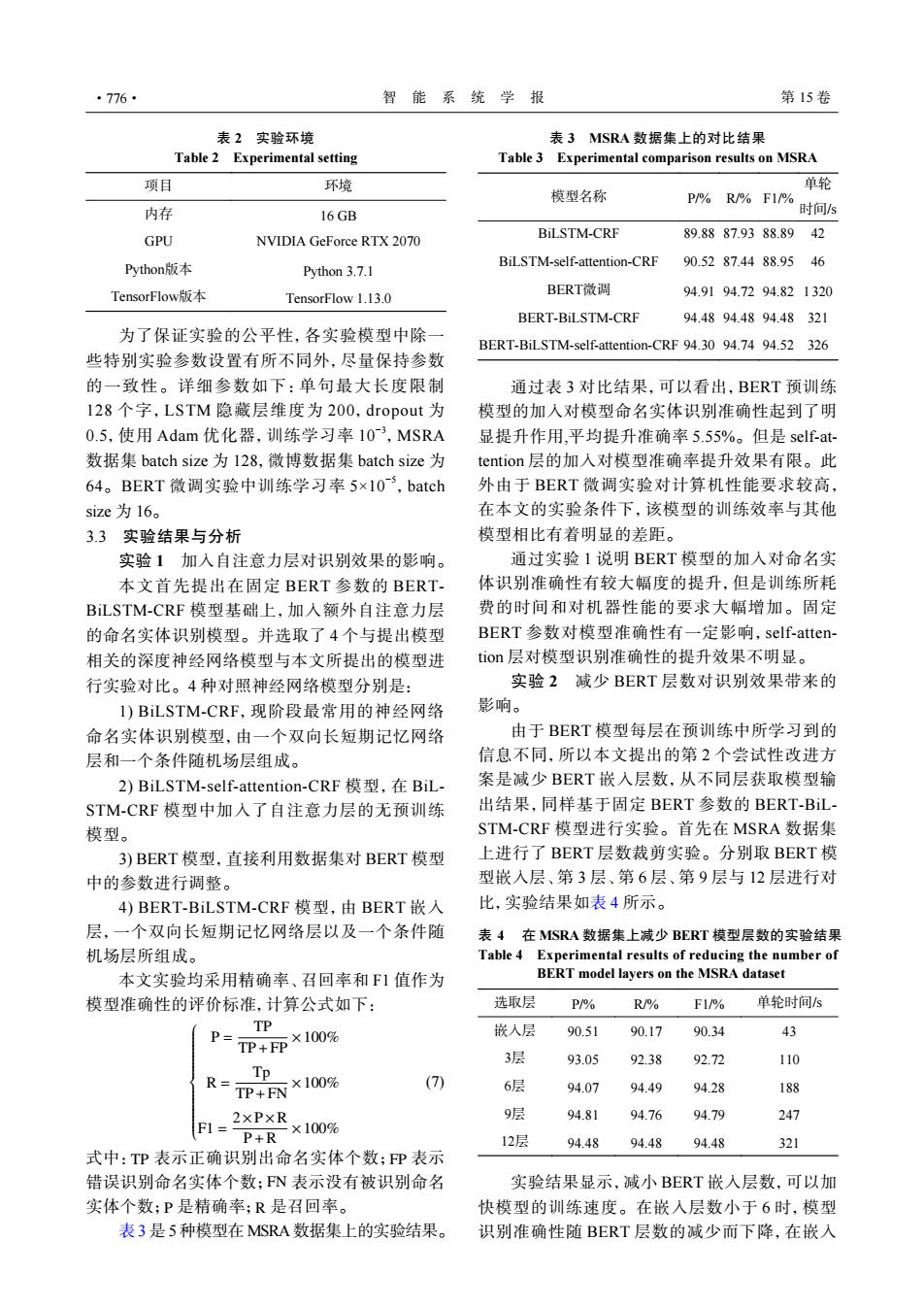

·776· 智能系统学报 第15卷 表2实验环境 表3MSRA数据集上的对比结果 Table 2 Experimental setting Table 3 Experimental comparison results on MSRA 项目 环境 单轮 模型名称 P/%R%F1% 内存 16GB 时间/s GPU BiLSTM-CRF 89.8887.9388.89 NVIDIA GeForce RTX 2070 42 Python版本 BiLSTM-self-attention-CRF 90.5287.4488.95 46 Python 3.7.1 TensorFlow版本 TensorFlow 1.13.0 BERT微调 94.9194.7294.821320 BERT-BiLSTM-CRF 94.4894.4894.48321 为了保证实验的公平性,各实验模型中除一 BERT-BiLSTM-self-attention-CRF 94.30 94.74 94.52 326 些特别实验参数设置有所不同外,尽量保持参数 的一致性。详细参数如下:单句最大长度限制 通过表3对比结果,可以看出,BERT预训练 128个字,LSTM隐藏层维度为200,dropout为 模型的加入对模型命名实体识别准确性起到了明 0.5,使用Adam优化器,训练学习率10-3,MSRA 显提升作用,平均提升准确率5.55%。但是self-at- 数据集batch size为l28,微博数据集batch size为 tention层的加入对模型准确率提升效果有限。此 64。BERT微调实验中训练学习率5×103,batch 外由于BERT微调实验对计算机性能要求较高, size为16。 在本文的实验条件下,该模型的训练效率与其他 3.3实验结果与分析 模型相比有着明显的差距。 实验1加入自注意力层对识别效果的影响。 通过实验1说明BERT模型的加人对命名实 本文首先提出在固定BERT参数的BERT- 体识别准确性有较大幅度的提升,但是训练所耗 BiLSTM-CRF模型基础上,加入额外自注意力层 费的时间和对机器性能的要求大幅增加。固定 的命名实体识别模型。并选取了4个与提出模型 BERT参数对模型准确性有一定影响,self-atten- 相关的深度神经网络模型与本文所提出的模型进 tion层对模型识别准确性的提升效果不明显。 行实验对比。4种对照神经网络模型分别是: 实验2减少BERT层数对识别效果带来的 I)BiLSTM-CRF,现阶段最常用的神经网络 影响。 命名实体识别模型,由一个双向长短期记忆网络 由于BERT模型每层在预训练中所学习到的 层和一个条件随机场层组成。 信息不同,所以本文提出的第2个尝试性改进方 2)BiLSTM-self-attention-CRF模型,在BiL- 案是减少BERT嵌人层数,从不同层获取模型输 STM-CRF模型中加入了自注意力层的无预训练 出结果,同样基于固定BERT参数的BERT-BiL 模型。 STM-CRF模型进行实验。首先在MSRA数据集 3)BERT模型,直接利用数据集对BERT模型 上进行了BERT层数裁剪实验。分别取BERT模 中的参数进行调整。 型嵌入层、第3层、第6层、第9层与12层进行对 4)BERT-BiLSTM-CRF模型,由BERT嵌人 比,实验结果如表4所示。 层,一个双向长短期记忆网络层以及一个条件随 表4在MSRA数据集上减少BERT模型层数的实验结果 机场层所组成。 Table 4 Experimental results of reducing the number of 本文实验均采用精确率、召回率和F1值作为 BERT model layers on the MSRA dataset 模型准确性的评价标准,计算公式如下: 选取层 P/% R/% F1/% 单轮时间s TP P= TP+FPX 100% 嵌入层 90.51 90.17 90.34 43 3层 93.05 92.38 92.72 110 Tp R= TP+FN×100% (7) 6层 94.07 94.49 94.28 188 2xPXR 9层 94.81 94.76 94.79 247 F1= P+R ×100% 12层 94.48 94.48 94.48 321 式中:TP表示正确识别出命名实体个数;FP表示 错误识别命名实体个数;FN表示没有被识别命名 实验结果显示,减小BERT嵌入层数,可以加 实体个数;P是精确率;R是召回率。 快模型的训练速度。在嵌入层数小于6时,模型 表3是5种模型在MSRA数据集上的实验结果。 识别准确性随BERT层数的减少而下降,在嵌人表 2 实验环境 Table 2 Experimental setting 项目 环境 内存 16 GB GPU NVIDIA GeForce RTX 2070 Python版本 Python 3.7.1 TensorFlow版本 TensorFlow 1.13.0 为了保证实验的公平性,各实验模型中除一 些特别实验参数设置有所不同外,尽量保持参数 的一致性。详细参数如下:单句最大长度限制 128 个字,LSTM 隐藏层维度为 200,dropout 为 0.5,使用 Adam 优化器,训练学习率 10−3 ,MSRA 数据集 batch size 为 128,微博数据集 batch size 为 64。BERT 微调实验中训练学习率 5×10−5 ,batch size 为 16。 3.3 实验结果与分析 实验 1 加入自注意力层对识别效果的影响。 本文首先提出在固定 BERT 参数的 BERTBiLSTM-CRF 模型基础上,加入额外自注意力层 的命名实体识别模型。并选取了 4 个与提出模型 相关的深度神经网络模型与本文所提出的模型进 行实验对比。4 种对照神经网络模型分别是: 1) BiLSTM-CRF,现阶段最常用的神经网络 命名实体识别模型,由一个双向长短期记忆网络 层和一个条件随机场层组成。 2) BiLSTM-self-attention-CRF 模型,在 BiLSTM-CRF 模型中加入了自注意力层的无预训练 模型。 3) BERT 模型,直接利用数据集对 BERT 模型 中的参数进行调整。 4) BERT-BiLSTM-CRF 模型,由 BERT 嵌入 层,一个双向长短期记忆网络层以及一个条件随 机场层所组成。 本文实验均采用精确率、召回率和 F1 值作为 模型准确性的评价标准,计算公式如下: P = TP TP+FP ×100% R = Tp TP+FN ×100% F1 = 2×P×R P+R ×100% (7) TP FP FN P R 式中: 表示正确识别出命名实体个数; 表示 错误识别命名实体个数; 表示没有被识别命名 实体个数; 是精确率; 是召回率。 表 3 是 5 种模型在 MSRA 数据集上的实验结果。 表 3 MSRA 数据集上的对比结果 Table 3 Experimental comparison results on MSRA 模型名称 P/% R/% F1/% 单轮 时间/s BiLSTM-CRF 89.88 87.93 88.89 42 BiLSTM-self-attention-CRF 90.52 87.44 88.95 46 BERT微调 94.91 94.72 94.82 1320 BERT-BiLSTM-CRF 94.48 94.48 94.48 321 BERT-BiLSTM-self-attention-CRF 94.30 94.74 94.52 326 通过表 3 对比结果,可以看出,BERT 预训练 模型的加入对模型命名实体识别准确性起到了明 显提升作用,平均提升准确率 5.55%。但是 self-attention 层的加入对模型准确率提升效果有限。此 外由于 BERT 微调实验对计算机性能要求较高, 在本文的实验条件下,该模型的训练效率与其他 模型相比有着明显的差距。 通过实验 1 说明 BERT 模型的加入对命名实 体识别准确性有较大幅度的提升,但是训练所耗 费的时间和对机器性能的要求大幅增加。固定 BERT 参数对模型准确性有一定影响,self-attention 层对模型识别准确性的提升效果不明显。 实验 2 减少 BERT 层数对识别效果带来的 影响。 由于 BERT 模型每层在预训练中所学习到的 信息不同,所以本文提出的第 2 个尝试性改进方 案是减少 BERT 嵌入层数,从不同层获取模型输 出结果,同样基于固定 BERT 参数的 BERT-BiLSTM-CRF 模型进行实验。首先在 MSRA 数据集 上进行了 BERT 层数裁剪实验。分别取 BERT 模 型嵌入层、第 3 层、第 6 层、第 9 层与 12 层进行对 比,实验结果如表 4 所示。 表 4 在 MSRA 数据集上减少 BERT 模型层数的实验结果 Table 4 Experimental results of reducing the number of BERT model layers on the MSRA dataset 选取层 P/% R/% F1/% 单轮时间/s 嵌入层 90.51 90.17 90.34 43 3层 93.05 92.38 92.72 110 6层 94.07 94.49 94.28 188 9层 94.81 94.76 94.79 247 12层 94.48 94.48 94.48 321 实验结果显示,减小 BERT 嵌入层数,可以加 快模型的训练速度。在嵌入层数小于 6 时,模型 识别准确性随 BERT 层数的减少而下降,在嵌入 ·776· 智 能 系 统 学 报 第 15 卷