正在加载图片...

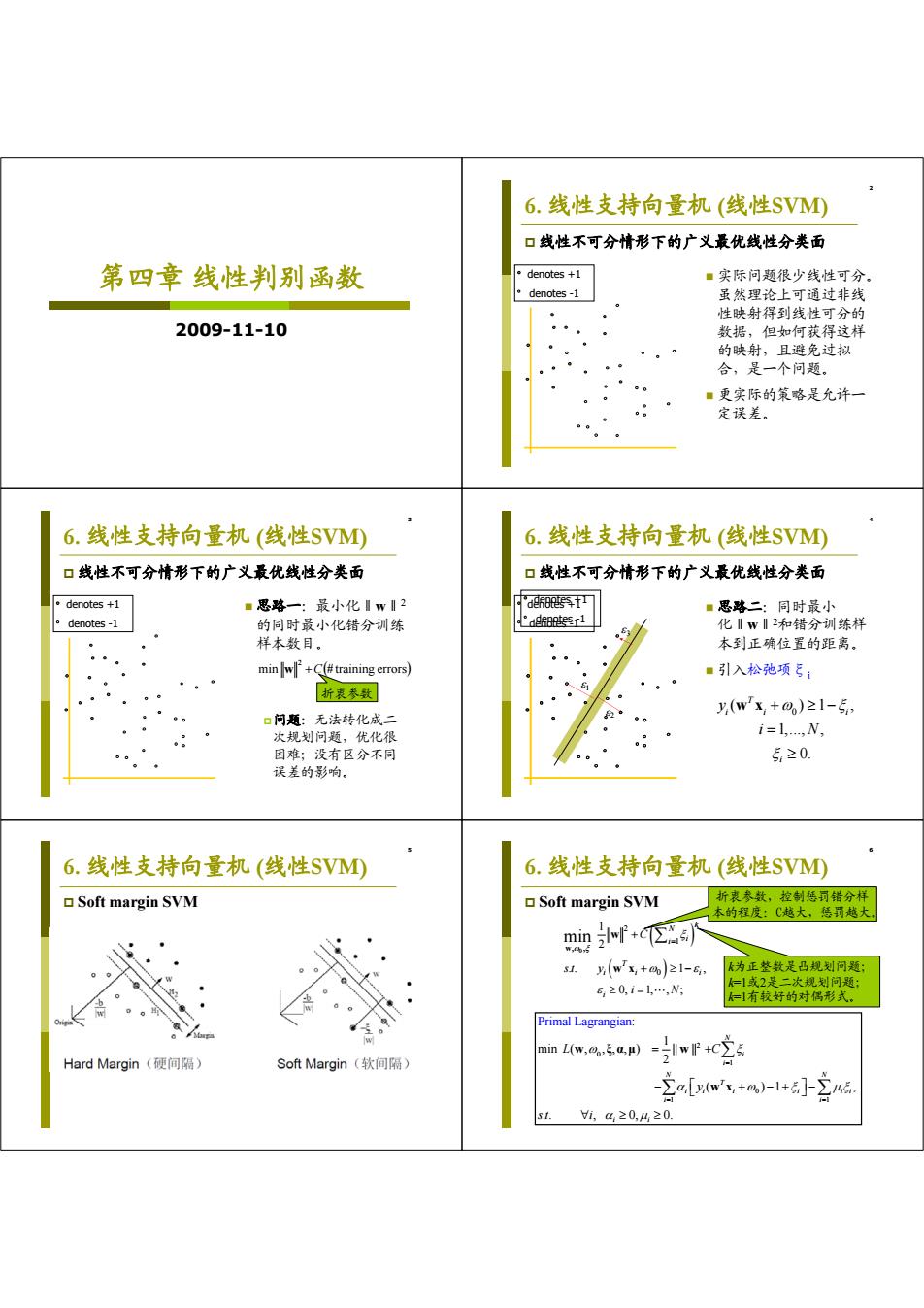

6.线性支持向量机(线性SVM 口线性不可分情形下的广义最优线性分类面 第四章线性判别函数 。denotes+1 ■实际问题很少线性可分 denotes-1 虽然理论上可通过非线 性映射得到线性可分的 2009-11-10 数据,但如何获得这样 的映射,且避免过拟 合,是一个问题。 ■更实际的策略是允许一 定误差。 6.线性支持向量机(线性SVM④ 6.线性支持向量机(线性SV) 口线性不可分情形下的广义最优线性分类面 口线性不可分情形下的广义最优线性分类面 denotes+1 ■思路一:最小化Iw2 defoees1 ■思路二:同时最小 °denotes-1 的同时最小化错分训练 °.potesr1 化1w12和错分训练样 样本数目。 本到正确位置的距离。 minw+(#training errors) ■引入松弛项ξ: 折表参数 y(wx,+0)≥1-5 口问题:无法转化成二 次规划问题,优化很 i=1,,N, 困难;没有区分不同 5≥0. 误差的影响。 6.线性支持向量机(线性SVM 6.线性支持向量机(线性SV0 Soft margin SVM Soft margin SVM 折表参数,控制惩司错分样 太的程度:C越大,得罚越大 minf+) w,6, 5. y(w'x+o%)21-6, k为正整数是凸规划问题: 620,1=1…,N =1或2是二次规划问题: 仁」有较好的对偶形式。 Primal Lagrangian minL(w,m。,5.a,μ) Hard Margin(硬间隔) Soft Margin(软间隔) wf+c空 s1. 1,a≥0,4,20.第四章 线性判别函数 2009-11-10 2 6. 线性支持向量机 (线性SVM) 线性不可分情形下的广义最优线性分类面 实际问题很少线性可分。 虽然理论上可通过非线 性映射得到线性可分的 数据,但如何获得这样 的映射,且避免过拟 合,是一个问题。 更实际的策略是允许一 定误差。 denotes +1 denotes -1 3 6. 线性支持向量机 (线性SVM) 线性不可分情形下的广义最优线性分类面 思路一:最小化‖w‖2 的同时最小化错分训练 样本数目。 问题:无法转化成二 次规划问题,优化很 困难;没有区分不同 误差的影响。 denotes +1 denotes -1 min # training errors 2 w C 折衷参数 4 denotes +1 denotes -1 1 2 3 6. 线性支持向量机 (线性SVM) 线性不可分情形下的广义最优线性分类面 思路二:同时最小 化‖w‖2和错分训练样 本到正确位置的距离。 引入松弛项ξi denotes +1 denotes -1 0 ( )1 , 1,..., , 0. T ii i i y i N w x 5 6. 线性支持向量机 (线性SVM) Soft margin SVM 6 6. 线性支持向量机 (线性SVM) Soft margin SVM 0 2 1 , , 0 1 2 . . 1 , 0, 1, , ; min k N i i T ii i i C st y i N w w w x 2 0 1 0 1 1 : 1 min ( , , , , ) || || 2 ( )1 , .. , 0 Primal Lagrangi , . an 0 N i i N N T i i i i ii i i i i L C y st i w ξαμ w w x k为正整数是凸规划问题; k=1或2是二次规划问题; k=1有较好的对偶形式。 折衷参数,控制惩罚错分样 本的程度:C越大,惩罚越大