正在加载图片...

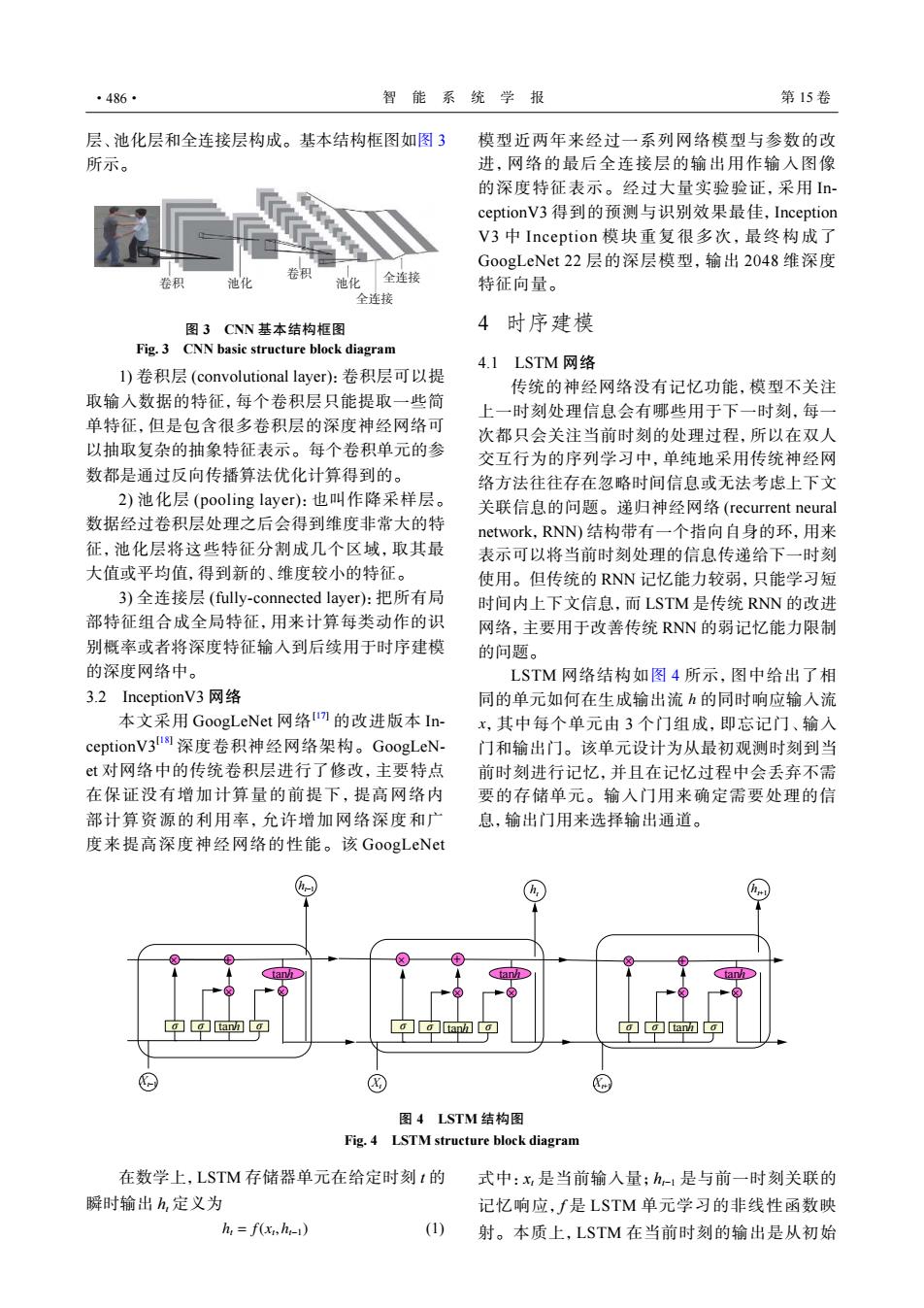

·486· 智能系统学报 第15卷 层、池化层和全连接层构成。基本结构框图如图3 模型近两年来经过一系列网络模型与参数的改 所示。 进,网络的最后全连接层的输出用作输入图像 的深度特征表示。经过大量实验验证,采用In ceptionV3得到的预测与识别效果最佳,Inception V3中Inception模块重复很多次,最终构成了 GoogLeNet22层的深层模型,输出2048维深度 池化 池化 全连接 特征向量。 全连接 图3CNN基本结构框图 4时序建模 Fig.3 CNN basic structure block diagram 4.1LSTM网络 1)卷积层(convolutional layer):卷积层可以提 传统的神经网络没有记忆功能,模型不关注 取输入数据的特征,每个卷积层只能提取一些简 上一时刻处理信息会有哪些用于下一时刻,每一 单特征,但是包含很多卷积层的深度神经网络可 次都只会关注当前时刻的处理过程,所以在双人 以抽取复杂的抽象特征表示。每个卷积单元的参 交互行为的序列学习中,单纯地采用传统神经网 数都是通过反向传播算法优化计算得到的。 络方法往往存在忽略时间信息或无法考虑上下文 2)池化层(pooling layer):也叫作降采样层。 关联信息的问题。递归神经网络(recurrent neural 数据经过卷积层处理之后会得到维度非常大的特 network,RNN)结构带有一个指向自身的环,用来 征,池化层将这些特征分割成几个区域,取其最 表示可以将当前时刻处理的信息传递给下一时刻 大值或平均值,得到新的、维度较小的特征。 使用。但传统的RNN记忆能力较弱,只能学习短 3)全连接层(fully-connected layer):把所有局 时间内上下文信息,而LSTM是传统RNN的改进 部特征组合成全局特征,用来计算每类动作的识 网络,主要用于改善传统RNN的弱记忆能力限制 别概率或者将深度特征输入到后续用于时序建模 的问题。 的深度网络中。 LSTM网络结构如图4所示,图中给出了相 3.2 nceptionV3网络 同的单元如何在生成输出流h的同时响应输入流 本文采用GoogLeNet网络m的改进版本In- x,其中每个单元由3个门组成,即忘记门、输入 ceptionV3us深度卷积神经网络架构。GoogLeN- 门和输出门。该单元设计为从最初观测时刻到当 t对网络中的传统卷积层进行了修改,主要特点 前时刻进行记忆,并且在记忆过程中会丢弃不需 在保证没有增加计算量的前提下,提高网络内 要的存储单元。输入门用来确定需要处理的信 部计算资源的利用率,允许增加网络深度和广 息,输出门用来选择输出通道。 度来提高深度神经网络的性能。该GoogLeNet C © ⊙ 图4LSTM结构图 Fig.4 LSTM structure block diagram 在数学上,LSTM存储器单元在给定时刻1的 式中:x是当前输入量;h-1是与前一时刻关联的 瞬时输出h,定义为 记忆响应,f是LSTM单元学习的非线性函数映 h:=f(,h1) (1) 射。本质上,LSTM在当前时刻的输出是从初始层、池化层和全连接层构成。基本结构框图如图 3 所示。 卷积 池化 卷积 池化 全连接 全连接 图 3 CNN 基本结构框图 Fig. 3 CNN basic structure block diagram 1) 卷积层 (convolutional layer):卷积层可以提 取输入数据的特征,每个卷积层只能提取一些简 单特征,但是包含很多卷积层的深度神经网络可 以抽取复杂的抽象特征表示。每个卷积单元的参 数都是通过反向传播算法优化计算得到的。 2) 池化层 (pooling layer):也叫作降采样层。 数据经过卷积层处理之后会得到维度非常大的特 征,池化层将这些特征分割成几个区域,取其最 大值或平均值,得到新的、维度较小的特征。 3) 全连接层 (fully-connected layer):把所有局 部特征组合成全局特征,用来计算每类动作的识 别概率或者将深度特征输入到后续用于时序建模 的深度网络中。 3.2 InceptionV3 网络 本文采用 GoogLeNet 网络[17] 的改进版本 InceptionV3[18] 深度卷积神经网络架构。GoogLeNet 对网络中的传统卷积层进行了修改,主要特点 在保证没有增加计算量的前提下,提高网络内 部计算资源的利用率,允许增加网络深度和广 度来提高深度神经网络的性能。该 GoogLeNet 模型近两年来经过一系列网络模型与参数的改 进,网络的最后全连接层的输出用作输入图像 的深度特征表示。经过大量实验验证,采用 InceptionV3 得到的预测与识别效果最佳,Inception V3 中 Inception 模块重复很多次,最终构成了 GoogLeNet 22 层的深层模型,输出 2048 维深度 特征向量。 4 时序建模 4.1 LSTM 网络 传统的神经网络没有记忆功能,模型不关注 上一时刻处理信息会有哪些用于下一时刻,每一 次都只会关注当前时刻的处理过程,所以在双人 交互行为的序列学习中,单纯地采用传统神经网 络方法往往存在忽略时间信息或无法考虑上下文 关联信息的问题。递归神经网络 (recurrent neural network,RNN) 结构带有一个指向自身的环,用来 表示可以将当前时刻处理的信息传递给下一时刻 使用。但传统的 RNN 记忆能力较弱,只能学习短 时间内上下文信息,而 LSTM 是传统 RNN 的改进 网络,主要用于改善传统 RNN 的弱记忆能力限制 的问题。 h x LSTM 网络结构如图 4 所示,图中给出了相 同的单元如何在生成输出流 的同时响应输入流 ,其中每个单元由 3 个门组成,即忘记门、输入 门和输出门。该单元设计为从最初观测时刻到当 前时刻进行记忆,并且在记忆过程中会丢弃不需 要的存储单元。输入门用来确定需要处理的信 息,输出门用来选择输出通道。 σ σ tanh σ × + × × σ σ tanh σ tanh tanh tanh × + × × σ σ tanh σ × + × × Xt−1 Xt Xt+1 ht−1 ht ht+1 图 4 LSTM 结构图 Fig. 4 LSTM structure block diagram 在数学上,LSTM 存储器单元在给定时刻 t 的 瞬时输出 ht 定义为 ht = f(xt ,ht−1) (1) 式中:xt 是当前输入量;ht−1 是与前一时刻关联的 记忆响应,f 是 LSTM 单元学习的非线性函数映 射。本质上,LSTM 在当前时刻的输出是从初始 ·486· 智 能 系 统 学 报 第 15 卷