正在加载图片...

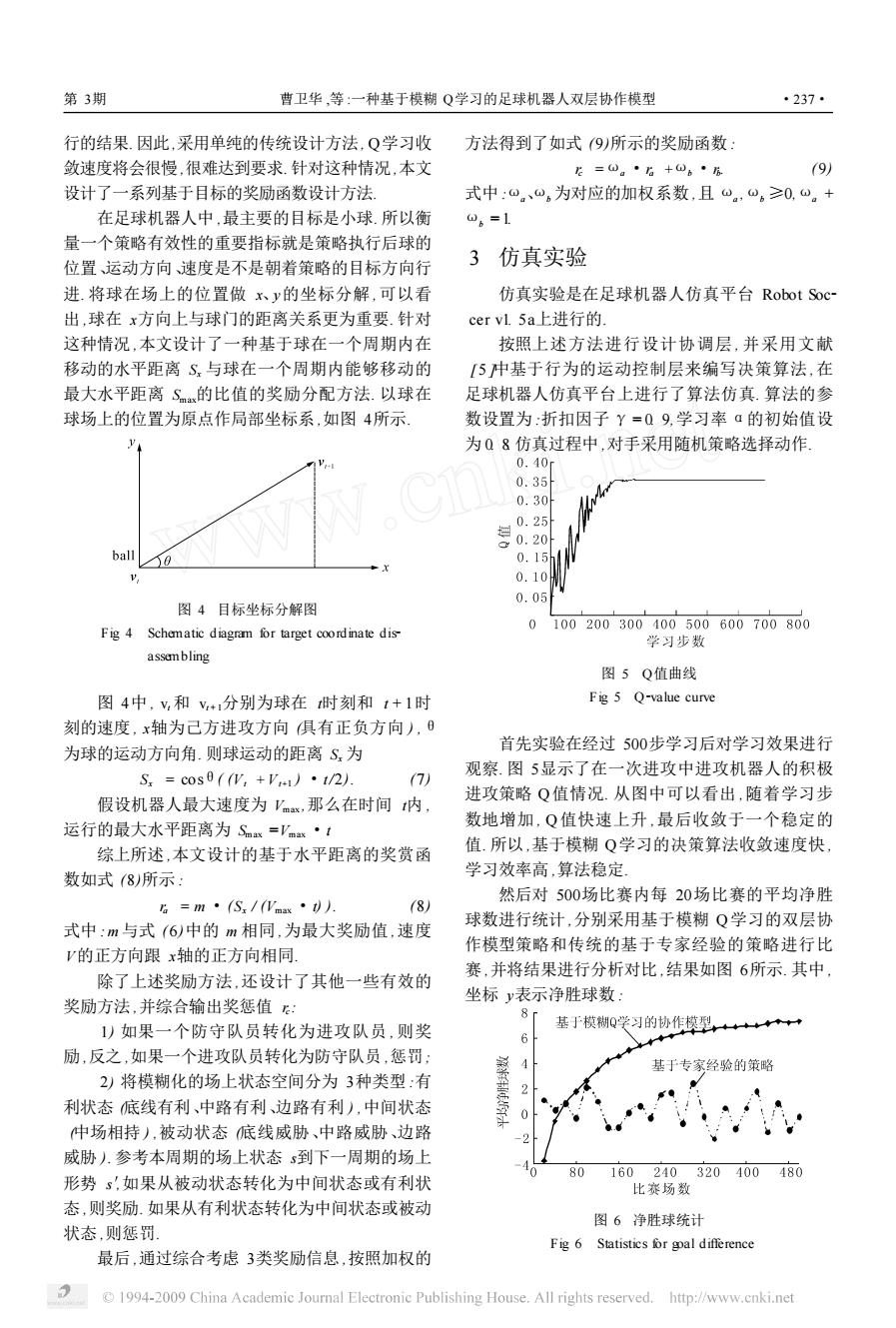

第3期 曹卫华,等:一种基于模糊Q学习的足球机器人双层协作模型 ·237 行的结果.因此,采用单纯的传统设计方法,Q学习收 方法得到了如式(9)所示的奖励函数: 敛速度将会很慢,很难达到要求.针对这种情况,本文 E=①。·6+①。·6 (9) 设计了一系列基于目标的奖励函数设计方法 式中:0。、⊙。为对应的加权系数,且0。,⊙。≥0,。+ 在足球机器人中,最主要的目标是小球.所以衡 0,=1 量一个策略有效性的重要指标就是策略执行后球的 3 位置、运动方向速度是不是朝着策略的目标方向行 仿真实验 进.将球在场上的位置做x、y的坐标分解,可以看 仿真实验是在足球机器人仿真平台Robot Soc~ 出,球在x方向上与球门的距离关系更为重要.针对 cer vl.5a上进行的. 这种情况,本文设计了一种基于球在一个周期内在 按照上述方法进行设计协调层,并采用文献 移动的水平距离S与球在一个周期内能够移动的 [5中基于行为的运动控制层来编写决策算法,在 最大水平距离S的比值的奖励分配方法.以球在 足球机器人仿真平台上进行了算法仿真.算法的参 球场上的位置为原点作局部坐标系,如图4所示 数设置为:折扣因子Y=Q9,学习率a的初始值设 为Q8仿真过程中,对手采用随机策略选择动作, 0.40 0.35 0.30 0.25 0.20 ball 50 0.15 0.10 0.05 图4目标坐标分解图 0100200300400500600700800 Fig 4 Schematic diagram for target coordinate dis 学习步数 assemnbling 图5Q值曲线 图4中,v,和v+1分别为球在时刻和1+1时 Fig 5 Q-value curve 刻的速度,x轴为己方进攻方向俱有正负方向),0 首先实验在经过500步学习后对学习效果进行 为球的运动方向角.则球运动的距离S为 S.=cos0((W,+V1)·1/2) 观察.图5显示了在一次进攻中进攻机器人的积极 7) 假设机器人最大速度为Vmax,那么在时间内, 进攻策略Q值情况.从图中可以看出,随着学习步 运行的最大水平距离为Sm=Vmx·t 数地增加,Q值快速上升,最后收敛于一个稳定的 综上所述,本文设计的基于水平距离的奖赏函 值.所以,基于模糊Q学习的决策算法收敛速度快 学习效率高,算法稳定 数如式(8所示: 然后对500场比赛内每20场比赛的平均净胜 6=m·(S5/max·功 8) 球数进行统计,分别采用基于模糊O学习的双层协 式中:m与式(6)中的m相同,为最大奖励值,速度 作模型策略和传统的基于专家经验的策略进行比 V的正方向跟x轴的正方向相同. 赛,并将结果进行分析对比,结果如图6所示.其中 除了上述奖励方法,还设计了其他一些有效的 奖励方法,并综合输出奖惩值: 坐标y表示净胜球数: 1)如果一个防守队员转化为进攻队员,则奖 基于模糊Q学习的协作模型,→一 6 励,反之,如果一个进攻队员转化为防守队员,惩罚: ◆ 基于专家经验的策略 2)将模糊化的场上状态空间分为3种类型:有 2 利状态底线有利、中路有利、边路有利),中间状态 0 仲场相持),被动状态底线威胁、中路威胁、边路 威胁人.参考本周期的场上状态s到下一周期的场上 80 160240320400480 形势s,如果从被动状态转化为中间状态或有利状 比赛场数 态,则奖励.如果从有利状态转化为中间状态或被动 图6净胜球统计 状态,则惩罚 Fig 6 Statistics or gal difference 最后,通过综合考虑3类奖励信息,按照加权的 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net行的结果. 因此,采用单纯的传统设计方法, Q学习收 敛速度将会很慢 ,很难达到要求. 针对这种情况,本文 设计了一系列基于目标的奖励函数设计方法. 在足球机器人中 ,最主要的目标是小球. 所以衡 量一个策略有效性的重要指标就是策略执行后球的 位置、运动方向、速度是不是朝着策略的目标方向行 进. 将球在场上的位置做 x、y的坐标分解 ,可以看 出 ,球在 x方向上与球门的距离关系更为重要. 针对 这种情况 ,本文设计了一种基于球在一个周期内在 移动的水平距离 Sx 与球在一个周期内能够移动的 最大水平距离 Smax的比值的奖励分配方法. 以球在 球场上的位置为原点作局部坐标系 ,如图 4所示. 图 4 目标坐标分解图 Fig. 4 Schematic diagram for target coordinate dis2 assembling 图 4中 , vt 和 vt + 1分别为球在 t时刻和 t + 1时 刻的速度 , x轴为己方进攻方向 (具有正负方向 ) ,θ 为球的运动方向角. 则球运动的距离 Sx 为 Sx = cosθ( (Vt +Vt+1 ) ·t/2). (7) 假设机器人最大速度为 Vmax ,那么在时间 t内 , 运行的最大水平距离为 Smax =Vmax ·t. 综上所述 ,本文设计的基于水平距离的奖赏函 数如式 (8)所示 : ra = m ·(Sx / (Vmax ·t) ). (8) 式中 : m 与式 ( 6)中的 m 相同 ,为最大奖励值 ,速度 V的正方向跟 x轴的正方向相同. 除了上述奖励方法 ,还设计了其他一些有效的 奖励方法 ,并综合输出奖惩值 rc : 1) 如果一个防守队员转化为进攻队员 , 则奖 励 ,反之 ,如果一个进攻队员转化为防守队员 ,惩罚; 2) 将模糊化的场上状态空间分为 3种类型 :有 利状态 (底线有利、中路有利、边路有利 ) ,中间状态 (中场相持 ) ,被动状态 (底线威胁、中路威胁、边路 威胁 ). 参考本周期的场上状态 s到下一周期的场上 形势 s′,如果从被动状态转化为中间状态或有利状 态 ,则奖励. 如果从有利状态转化为中间状态或被动 状态 ,则惩罚. 最后 ,通过综合考虑 3类奖励信息 ,按照加权的 方法得到了如式 (9)所示的奖励函数 : rc =ωa ·ra +ωb ·rb . (9) 式中 :ωa、ωb 为对应的加权系数 ,且 ωa ,ωb ≥0,ωa + ωb = 1. 3 仿真实验 仿真实验是在足球机器人仿真平台 Robot Soc2 cer v1. 5a上进行的. 按照上述方法进行设计协调层 , 并采用文献 [ 5 ]中基于行为的运动控制层来编写决策算法 ,在 足球机器人仿真平台上进行了算法仿真. 算法的参 数设置为 :折扣因子 γ= 0. 9,学习率 α的初始值设 为 0. 8. 仿真过程中 ,对手采用随机策略选择动作. 图 5 Q值曲线 Fig. 5 Q2value curve 首先实验在经过 500步学习后对学习效果进行 观察. 图 5显示了在一次进攻中进攻机器人的积极 进攻策略 Q值情况. 从图中可以看出 ,随着学习步 数地增加 , Q 值快速上升 ,最后收敛于一个稳定的 值. 所以 ,基于模糊 Q学习的决策算法收敛速度快 , 学习效率高 ,算法稳定. 然后对 500场比赛内每 20场比赛的平均净胜 球数进行统计 ,分别采用基于模糊 Q学习的双层协 作模型策略和传统的基于专家经验的策略进行比 赛 ,并将结果进行分析对比 ,结果如图 6所示. 其中 , 坐标 y表示净胜球数 : 图 6 净胜球统计 Fig. 6 Statistics for goal difference 第 3期 曹卫华 ,等 :一种基于模糊 Q学习的足球机器人双层协作模型 ·237·